Du bist eben ein Genießer und erfreust dich auch am Idlestromverbrauch Jenseits von Gut und Böse

Deine Kommunikation fällt dir auf die Füße. Aber anscheinend erfreust du dich an der Selbstgeißelung.

wahrscheinlicher ist eher das du in Kombination mim 7950X3D für viel Geld den Stromverbrauchsrekord im Leerlauf aufstellst.

Wenn im Leerlauf die 7900XTX sich 17W nimmt und dies ein Rekord im Leerlauf ist in einer bestimmten Kombination, welche Rekorde werden dann gebrochen, wenn man im Leerlauf eine RTX 4090 im Rechner hat, die sich 20W nimmt?

Und 8W mehr im Leerlauf für den 7950X3D im Vergleich zum 13900K sind genau das, was du beschreibst.

hat selbst kein technischen Verständnis und sollte eher die Bibel lesen.

Pauschales Hassen sollte doch auch mal bei dir ein Ende finden. Oder willst du nicht mal erwachsen werden?

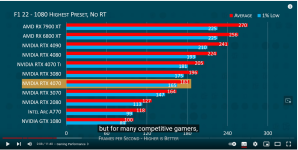

Und durchschnittlich zieht ein 7950X3D beim Zocken 72/78W und ein 1300K 141/148W

Mit einer RTX4090, die klar ein hartes Brett für AMD ist und unerreichbar scheint, hat man 438W beim Zocken. Das sind dann mit einem 13900K rund 580W

Da ist eine Kombination 7950X3D mit einer 7900XTX 150W genügsamer.

Wenn du den Anspruch hättest, dass man dir ein technisches Verständnis abnimmt, solltest du weniger pauschales Hassegeschwurbel ins Forum tröpfeln.

Man muss differenzieren können. Aber Komplexität ist zu kompliziert für Hassgelaber.

Klar ist aus meiner Sicht, RDNA3 macht keine gute Figur und in bestimmten Lastzuständen kann AMD nur hoffen, dass man diese per Treiber auf ein vernünftiges Niveau einbremsen kann.

Klar ist aber auch aus meiner Sicht, die technisch tollen Karten RTX 4070/Ti und RTX 4060Ti werden durch den Geiz an Speicher zu einer Schäbigkeit. Da erkennt man praktisch den Charakter dieser Firma. Solche Charaktere würde ich immer verurteilen.