Moin,

ich suche einen geeigneten Raid Controller (meinetwegen auch nur als HBA nutzbar), mit dem ich mindestens 4 (eventuell 8) Samsung 860 EVOs als Raid0 durchfeuern kann.

Aktuell habe ich einen Adaptec 6405E, der scheint hierbei allerdings das Bottleneck zu sein.

Redundanz ist mir erstmal nicht so wichtig, geht mir eher um den Datendurchsatz. Anstreben tue ich in erster Linie ein RAID0 oder RAID 10.

Die SSDs würden bei mir im Server an einer Backplane hängen, gehe ich auf 8 Disks, bräuchte ich einen Controller mit zwei Ports zum anschließen.

Kann mir da jemand was empfehlen was nicht total den Geldbeutel sprengt?

Thanks!

ich suche einen geeigneten Raid Controller (meinetwegen auch nur als HBA nutzbar), mit dem ich mindestens 4 (eventuell 8) Samsung 860 EVOs als Raid0 durchfeuern kann.

Aktuell habe ich einen Adaptec 6405E, der scheint hierbei allerdings das Bottleneck zu sein.

Redundanz ist mir erstmal nicht so wichtig, geht mir eher um den Datendurchsatz. Anstreben tue ich in erster Linie ein RAID0 oder RAID 10.

Die SSDs würden bei mir im Server an einer Backplane hängen, gehe ich auf 8 Disks, bräuchte ich einen Controller mit zwei Ports zum anschließen.

Kann mir da jemand was empfehlen was nicht total den Geldbeutel sprengt?

Thanks!

Zuletzt bearbeitet:

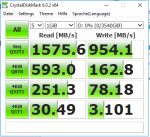

hast, dann gibt es doch nichts zu meckern. Oder meinst Du 1GB/s? Das wäre dann nur etwa halb so viel wie man von 4 SATA SSDs im RAID 0 erwarten sollte, schau mal wie performant das Chipsatz RAID denn ist, damit Du sehen kannst ob es nur am SW RAID liegt oder ob da ein Flaschenhals vorhanden ist. An welchen Ports hängen die SSDs denn?

hast, dann gibt es doch nichts zu meckern. Oder meinst Du 1GB/s? Das wäre dann nur etwa halb so viel wie man von 4 SATA SSDs im RAID 0 erwarten sollte, schau mal wie performant das Chipsatz RAID denn ist, damit Du sehen kannst ob es nur am SW RAID liegt oder ob da ein Flaschenhals vorhanden ist. An welchen Ports hängen die SSDs denn?