Hallo,

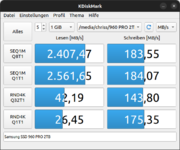

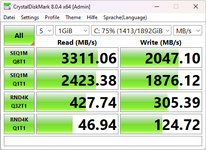

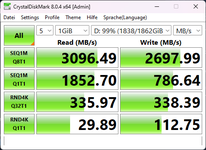

ich brauch mal eure Hilfe. Mir ist heute aufgefallen, dass eine meiner SSD viel zu langsam ist und ich kann mir nicht erklären warum.

Ich habe sowohl mit aktuellem Windows 11, als auch mit aktuellem Ubuntu getestet. Da sich die andere SSD normal verhält und es unter Ubuntu auch so ist, denk ich, dass es nicht am Windows liegt.

Das Board ist ein Asus Maximus Hero XI (Wifi) und die CPU ein 9900KS.

Die Firmware ist laut Magician aktuell und ich nutze unter Windows den MS Treiber.

Hat jemand 'ne Idee, was das sein kann und was ich dagegen tun kann?

ich brauch mal eure Hilfe. Mir ist heute aufgefallen, dass eine meiner SSD viel zu langsam ist und ich kann mir nicht erklären warum.

Ich habe sowohl mit aktuellem Windows 11, als auch mit aktuellem Ubuntu getestet. Da sich die andere SSD normal verhält und es unter Ubuntu auch so ist, denk ich, dass es nicht am Windows liegt.

Das Board ist ein Asus Maximus Hero XI (Wifi) und die CPU ein 9900KS.

Die Firmware ist laut Magician aktuell und ich nutze unter Windows den MS Treiber.

Hat jemand 'ne Idee, was das sein kann und was ich dagegen tun kann?