Dann sind auch alle Treiber da.

Treiber gibt es für USB oder eSATA Gehäuse nicht, da spielen nur die Host Controller Treiber eine Rolle. Die einzige Ausnahme sind Treiber für Zusatzfunktionen wie z.B. diese One-Buttom Backups Knöpfe.

bei MS bin ich grad nicht sicher, ob schon Win 8(.1) damit umgehen kann, oder ob das erst mit win10 kommt. Beim Server 2012-R2 müsste es schon funzen.

Das geht ab Win8, wie man

hier von Microsoft erfährt. Nachsehen ist immer besser als nur vermuten!

Das ist klar, außer Du hast eine der noch neuen 4kn Enterprise HDDs.

Ich habe aber im Prinzip alles da um es mal durchtesten zu können 10 externe Gehäuse der gleichen Art mit 2-4tb Bestückung

Bin schon aufs Ergebnis gespannt.

Das sollte jeder für jede seiner USB Platten testen, dann weiß er auch, ob er diese bei einem Problem mit dem Gehäuse intern einbaun kann oder in ggf. in welchem anderen Gehäuse er eine Chance hat an die Daten zu kommen.

Aber ist wirklich die 512/4K Emulation das Problem das die Partition nicht richtig erkannt wird?

Ja, 100%, bei WD Gehäuse könnte noch eine Datenverschlüsselung dazu kommen, denn da verschlüsseln auch Gehäuse die Daten auf der Platte bei denen man davon nicht merkt bis man die Platte mal ausbaut, weil es weder dick auf der Pakcung steht, noch mal jemals sowas aktiviert hat oder ein Passwort eingeben musste. Keine Ahnung was die sich dabei nur gedacht haben, aber es genügt mir um externe WD HDDs zu meiden, denn der Schlüssel wird auch noch mit jedem Fertigungslos geändert und man hat somit praktisch 0 Chancen bei einem Ausfall des USB-SATA Bridgechip auf dem Gehäuse jemals wieder an die Daten zu kommen.

Damals als ich die Gehäuse gebraucht und gekauft habe hieß es noch das es einzig an den USB/SATA Bridge Chip liegt ob er die GPT sauber durch gibt.

Der Chip hat mir MBR oder GPT nichts zu tun, davon weiß der auch gar nichts. Das ist ja alleine eine Interpretation bestimmte Daten die an bestimmten Stellen auf der Platte liegen, das sind für die Platte und auch die USB-SATA Bridgechip Daten wie alle anderen Daten auch.

Damals als die ersten 4k Platten kamen, waren glaube ich 2tb Version gabs nen Bericht auf einer großen Hardware Seite. Was da nun passiert wieso man aus 512kb Sektoren nun 4096kb Sektoren macht. Und da ja die Standardgröße von NTFS Sektoren 4096kb sind war es für mich ziemlig perfekt und hatt keinerlei Nachteile.

Keine Ahnung welche HW Seite was berichtet hat, aber außer einem Performanceverlust bei falschem Alignment ist es egal ob eine Platte nun native 512 Byte Sektoren hat (512n) oder emulierte (512e) und intern mit 4k Sektoren arbeitet. Das ganze ist nach außen total transpartent, man kann es allenfalls auslesen aus den Daten die die Platte über sich selbst meldet.

4kn wird nun gemacht um diese Emulation los zu werden, was auch die Probleme mir dem Alignment beseitigt und auch Dauer auch keinen Sinn macht, außer eben um Kompatibilitätsprobleme zu vermeiden.

Ich hatte mir nur Sorgen gemacht um die ganzen Geräte wie TV, Mediaplayer und Konsolen ob die mit 4k umgehen können.

Da gibt es welche die das nicht können, das muss man im Zweifel ausprobieren, aber die Gehäuse emulieren ja i.d.R. nur, wenn Platte über 2TB Kapazität eingebaut sind, bei kleineren Platten dann eben nicht. Da muss man dann eben mit 2TB zufrieden sein, ältere Geräte kömmen meist sowieso nicht mehr verwalten.

Das die aber alle 512kb emulieren war mir neu und ist auch völlig unverständlich für mich. Die Option fürs emulieren ist perfekt für alte Geräte, aber jedes welches NTFS kann sollte doch mit reellen 4k Sektoren klar kommen.

Das mit der 512Byte Emulation müsste doch eigentlich damals auf der HW Seite gestanden haben, also die ersten Platte mit physikalischen 4k Sektoren (Advanced Format) erschienen sind. Das mit dem 4k bei NTFS ist die Clustergröße, das Filesystem fasst die Sektoren der Platten eben zu Clustern zusammen, das ist was ganz anderes und passiert auf eine logisch höheren Ebene.

Es gibt eben mehrere Dinge die auch als Sektoren bezeichnet werden, anfangs war das alles das gleiche, dann kamen die Filesystem mit den größeren Clusters die mehrere Sektoren der Platten umfassen, dann eben mit dem Advanced Format die physikalischen Sektoren und die logischen, also wie viele Bytes pro LBA adressiert werden, weshalb ich auch lieber von Bytes pro LBA als von Sektoren rede.

Noch mehr verwundert mich dieses 4k USB rumgemache...

Das musste sein, damit eben XP die Platten auch voll nutzen kann, denn XP unterstützt kein MBR (nur mit Tools oder in den exotischen 64 Bit Versionen) und bei MBR kann eine Partition nur bis zu 2^32 LBAs umfassen und auch nur bis zu der Adresse ihren Anfang haben, was eben bei 512 Byte pro LBA 2TiB (=2.2TB) sind und mehr kann man damit praktisch nicht nutzen.

Die Lösung war also, diese 512 Byte pro LBA auf 4k zu erhöhen und damit sind 16TiB möglich, zumal eben USB diese Problem mit 4k logischen Sektorgrößen (also pro LBA) anders als SATA nicht hat, USB ist eben viel, viel neuer als interne HDDs.

Erstmal wunderts mich das erst so spät ein Thread in solch einer Sache kommt. Ich habe den Umstieg schon 2013 oder so gemacht.

Das Thema ist im Forum ja nicht neu, bei CB haben wir das schon lange, der Thread mit der Liste ist nur neu.

Dann habe ich die LC-Power Gehäuse von der Whitelist!

Wie Du dort sieht und wie ich schon geschrieben habe, ist die Liste nicht perfekt, da gibt es Fehler was schon passieren kann, wenn der Hersteller von Controller oder dessen FW ändert.

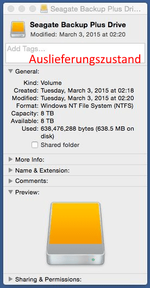

2-4TB liefen ja, nur die 8TB nicht.

2TB sagt nichts aus, aber wenn 4TB HDDs laufen aber die 8TB nicht, würde es mich wundern. Wenn die zwar läuft aber Probleme macht, könnte es eben an der Eigenart der Archive v2 (SMR) liegen, die ja zuweilen extrem lange Anwortzeiten bewirkt und vielleicht kommt der USB-SATA Bridge-Chip damit nicht klar.

Wie es aussieht komme ich wohl erst morgen zum großen USB Gehäuse Test und wie die sich verhalten.

Da freue ich mich drauf, lass uns wissen wie es ausgegangen ist.

)

)

Auf das eigendlich Partitionsproblem wurde gar nicht eingegangen.

Auf das eigendlich Partitionsproblem wurde gar nicht eingegangen.

Ehrlich jetzt?

Ehrlich jetzt?