Leider unterstützten die Skylake Prozessoren nur HDMI 1.4 (also UHD/4K mit 30 Hz, nicht mit 60 Hz).

Für HDMI 2.0 muss ein Zusatzchip auf dem Motherboard sein (vom DisplayPort).

Bezüglich HDCP 2.2 hab ich noch nichts gefunden. (Edit: gerade entdeckt, via HDMI Zusatzchip ist HDCP 2.2 möglich)

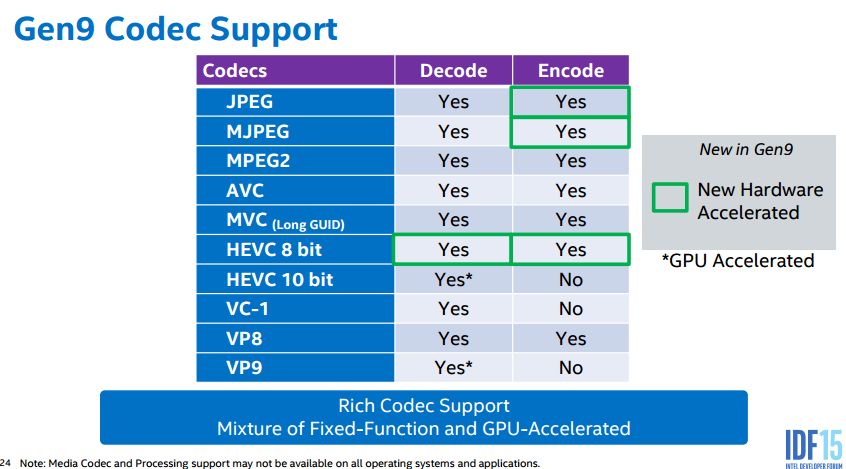

Ausserdem dekodieren sie in Hardware HEVC/h.265 nur mit 8 bit Auflösung.

Der Astra UHD Testkanal ist jetzt bereits HEVC 10 bit. UHD BluRays werden auch in 10 bit sein.

Quelle: Intel Datasheet

Schade. Da wurde ein Chance für zukunftsorientierte HTPCs vertan.

Für HDMI 2.0 muss ein Zusatzchip auf dem Motherboard sein (vom DisplayPort).

Bezüglich HDCP 2.2 hab ich noch nichts gefunden. (Edit: gerade entdeckt, via HDMI Zusatzchip ist HDCP 2.2 möglich)

Ausserdem dekodieren sie in Hardware HEVC/h.265 nur mit 8 bit Auflösung.

Der Astra UHD Testkanal ist jetzt bereits HEVC 10 bit. UHD BluRays werden auch in 10 bit sein.

Quelle: Intel Datasheet

Schade. Da wurde ein Chance für zukunftsorientierte HTPCs vertan.

Zuletzt bearbeitet:

) ist das Ergebnis:

) ist das Ergebnis: