Holt

Legende

- Mitglied seit

- 05.07.2010

- Beiträge

- 30.123

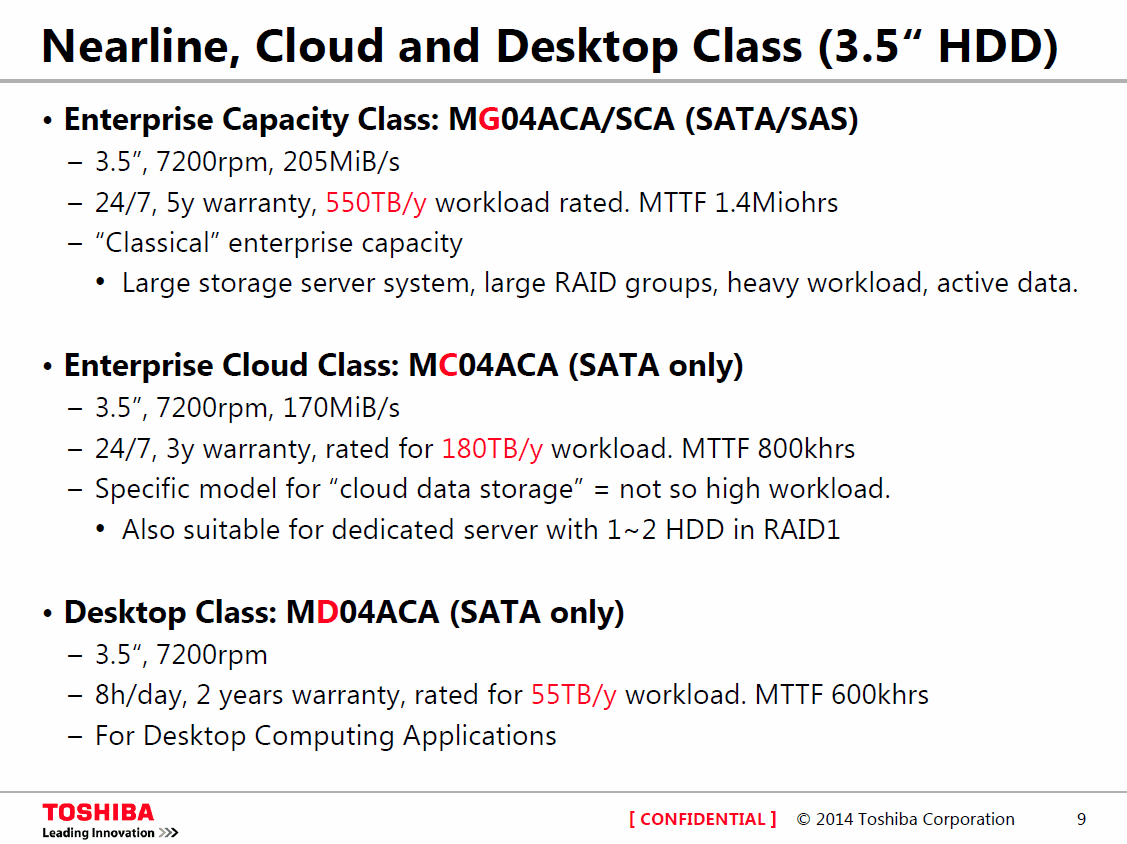

Belastbare Daten zu finden ist schwer, aber es dürfte im wesentlichen diese 3 Klassen von 55TB, 180TB und 550TB pro Jahr geben, wie sie auch bei Toshiba hier extra rot hervorgehoben sind:

Leider auch mit den Hinweis Confidential unten rechts, der ebenfalls rot hervorgehoben ist. Die selben Werte findet man bei Seagate und auch bei einigen WD HDDs, so gibt WD 180TB für die Se und 550TB für die Re an.

Einzig bei Seagate findet man auch den Hinweis auf die 55TB bei Desktopplatten und der Hinweis wie hier das mit dem Jahr interpretieren ist:

Obwohl auch WD anerkennt, dass der Workload sehr wichtig ist, sogar eine Mean Petabytes to

Failure (MPbF) gegenüber der Mean Time To Failure (MTTF) als bessere Maßeinheit für Aussagen zur Zuverlässigkeit von HDDs vorschlägt und schon im Juni 2013 versprochen hat auch das Workload Rating zu veröffentlichen, ist das bisher für Consumer HDDs leider ausgeblieben:

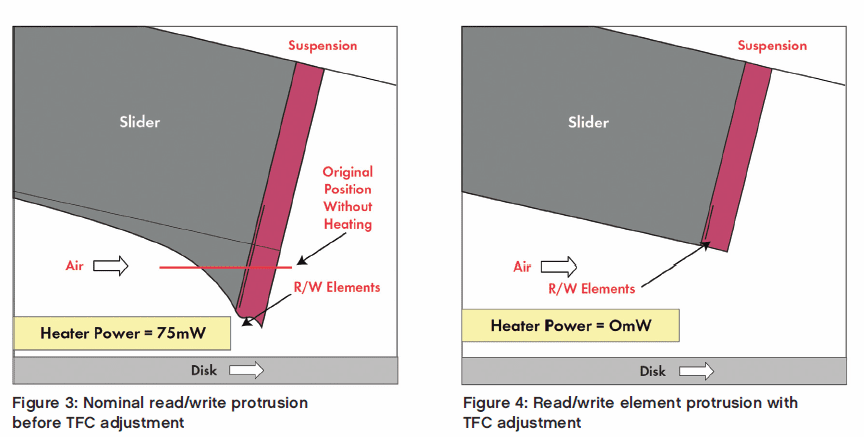

Das Thema Workload Rating ist noch relativ neu und das gab es früher gar nicht, da war es auch nicht nötig, da die Datendichte viel geringer war, damit war die Fläche auf der ein Bit gespeichert wurde auch viel größer und die Köpfe ebenso, die magnetischen Kräfte waren entsprechend höher und die Köpfe hatten mehr Abstand zum Plattern. Aber für die heutigen Datendichten braucht man Dynamic Fly Height (DFH) Technologie um die Abstände der Köpfe während der Zugriffe auf bis zu 1nm zu senken, was über Hitze für eine Ausdehnung sorgt die die Schreib- Leseelemente von z.B. 10nm bis auf 1nm an die Plattern bringt. So sieht das aus:

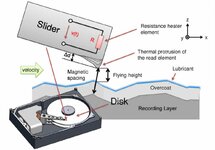

Bzw. so, wobei hier das Verhältnis von 1ns zu 10ns weniger krass dargestellt wird, dafür sieht man aber die Lubifizierung der Oberflächen, die gerade eine Moleküllage dick und was für eine Kraterlandschaft so eine Diskoberfläche im Verhältnis zu solchen Abständen ist, weshalb man auch die Oberflächen lubifiziert, dann es ist praktisch unvermeidbar dass es beim Lesen und Schreiben immer zu einem Kontakt der Köpfe mit der Oberfläche kommt und daher man muss also die Schäden dabei reduzieren statt zu versuchen diese komplett zu vermeiden.

Deshalb spielt eben der Workload heute eine große Rolle, die eben eine Platte sich nicht nur dreht und die Köpfe drüber fliegen, beim Lesen und Schreiben schmirgeln sie dann von der Oberfläche eben immer ein wenig ab, die Köpfe werden dadurch aber sicher auch nicht besser. Irgendwann ist halt ein Punkt erreicht, da funktioniert die Platte nicht mehr.

Ratet mal warum die HDDs für wirklich Mission Critical Anwendungen, also die 2.5" mit 10.000rpm und vor allem mit 15.000rpm in der Kapazität praktisch stagnieren und weit zurückliegen. Da kann man das nicht machen, denn die sind für Dauerlast ausgelegt, also darauf wirklich dauernd ohne Pause zu lesen und zu schreiben.

Leider auch mit den Hinweis Confidential unten rechts, der ebenfalls rot hervorgehoben ist. Die selben Werte findet man bei Seagate und auch bei einigen WD HDDs, so gibt WD 180TB für die Se und 550TB für die Re an.

Einzig bei Seagate findet man auch den Hinweis auf die 55TB bei Desktopplatten und der Hinweis wie hier das mit dem Jahr interpretieren ist:

Also 55TB Workload (Datenvolumen Lesend und Schreibend) pro Jahr, wobei ein Jahr sich auf 8760 Stunden bezieht, die HDD ist aber nur für 2400 Stunden im Jahr ausgelegt, was aber so direkt wieder nur im Datenblatt steht (Power-On Hours: 2400) und damit ergibt sich dann nur ein jährlicher Workload von maximal 15TB, wenn man als jährlich einen Zeitraum von 365 Tagen versteht.

Obwohl auch WD anerkennt, dass der Workload sehr wichtig ist, sogar eine Mean Petabytes to

Failure (MPbF) gegenüber der Mean Time To Failure (MTTF) als bessere Maßeinheit für Aussagen zur Zuverlässigkeit von HDDs vorschlägt und schon im Juni 2013 versprochen hat auch das Workload Rating zu veröffentlichen, ist das bisher für Consumer HDDs leider ausgeblieben:

Dabei wäre es ein wichtiger Wert um eine Green oder Red besser einschätzen zu können. Ich unterstelle aber mal, dass die WD HDDs sich von denen der anderen Hersteller nicht unterscheiden werden, das scheinen ja "genormte" Kategorien zu sein an die die Hersteller sich da halten.

Das Thema Workload Rating ist noch relativ neu und das gab es früher gar nicht, da war es auch nicht nötig, da die Datendichte viel geringer war, damit war die Fläche auf der ein Bit gespeichert wurde auch viel größer und die Köpfe ebenso, die magnetischen Kräfte waren entsprechend höher und die Köpfe hatten mehr Abstand zum Plattern. Aber für die heutigen Datendichten braucht man Dynamic Fly Height (DFH) Technologie um die Abstände der Köpfe während der Zugriffe auf bis zu 1nm zu senken, was über Hitze für eine Ausdehnung sorgt die die Schreib- Leseelemente von z.B. 10nm bis auf 1nm an die Plattern bringt. So sieht das aus:

Bzw. so, wobei hier das Verhältnis von 1ns zu 10ns weniger krass dargestellt wird, dafür sieht man aber die Lubifizierung der Oberflächen, die gerade eine Moleküllage dick und was für eine Kraterlandschaft so eine Diskoberfläche im Verhältnis zu solchen Abständen ist, weshalb man auch die Oberflächen lubifiziert, dann es ist praktisch unvermeidbar dass es beim Lesen und Schreiben immer zu einem Kontakt der Köpfe mit der Oberfläche kommt und daher man muss also die Schäden dabei reduzieren statt zu versuchen diese komplett zu vermeiden.

Deshalb spielt eben der Workload heute eine große Rolle, die eben eine Platte sich nicht nur dreht und die Köpfe drüber fliegen, beim Lesen und Schreiben schmirgeln sie dann von der Oberfläche eben immer ein wenig ab, die Köpfe werden dadurch aber sicher auch nicht besser. Irgendwann ist halt ein Punkt erreicht, da funktioniert die Platte nicht mehr.

Ratet mal warum die HDDs für wirklich Mission Critical Anwendungen, also die 2.5" mit 10.000rpm und vor allem mit 15.000rpm in der Kapazität praktisch stagnieren und weit zurückliegen. Da kann man das nicht machen, denn die sind für Dauerlast ausgelegt, also darauf wirklich dauernd ohne Pause zu lesen und zu schreiben.