Bzzz

Enthusiast

- Mitglied seit

- 13.06.2006

- Beiträge

- 3.939

- Ort

- Bei Würzburg

- Desktop System

- Karl

- Laptop

- Thinkpad Anniversary Edition 25

- Details zu meinem Desktop

- Prozessor

- Epyc 7282

- Mainboard

- H11SSL-i

- Kühler

- NH-U9 TR4-SP3

- Grafikprozessor

- RX570 Red Devil

- Display

- EX3501R / RDP

- Gehäuse

- RM41300

- Netzteil

- Focus Gold 450

- Keyboard

- MX Board 3.0 (Luxx-Adventskalender '17 🥰 )

- Mouse

- MX518 Legendary

- Sonstiges

- MCX311A-XCAT

- Internet

- ▼100 ▲40

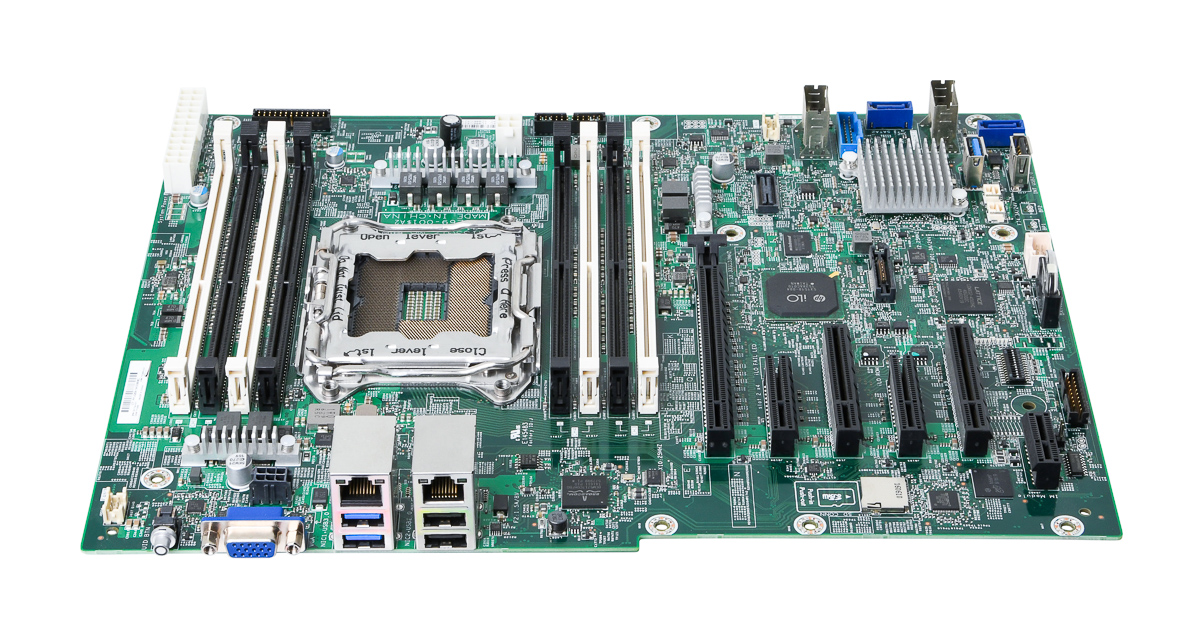

Ein wundervolles 2011-3 für Xeon E5 2600v3/v4, evtl. mit Glück sogar ATX-kompatibel, wenn man ohne I/O-Blende klarkommt.

HPE ML110 Gen9 Mainboard | Servershop24.de

HPE ProLiant ML110 Gen9 Mainboard / Motherboard / System Board - 791704-001www.servershop24.de

Hat der Servershop24 auch noch Epyc-auf-2011-Adapter im Lieferprogramm?

Das ist aber nur die Heimserver Sicht. Sonst trifft der Epyc4 voll ins Schwarze. Dafür ist die Palette breit genug und wird auch noch in die Tiefe gehen. Vorgestellt wurden ja nur die jeweiligen Speerspitzen

Das ist aber nur die Heimserver Sicht. Sonst trifft der Epyc4 voll ins Schwarze. Dafür ist die Palette breit genug und wird auch noch in die Tiefe gehen. Vorgestellt wurden ja nur die jeweiligen Speerspitzen