N

nebulus1

Guest

Also es fällt schon auf, dass der 7900X langsamer ist als der 5800X...

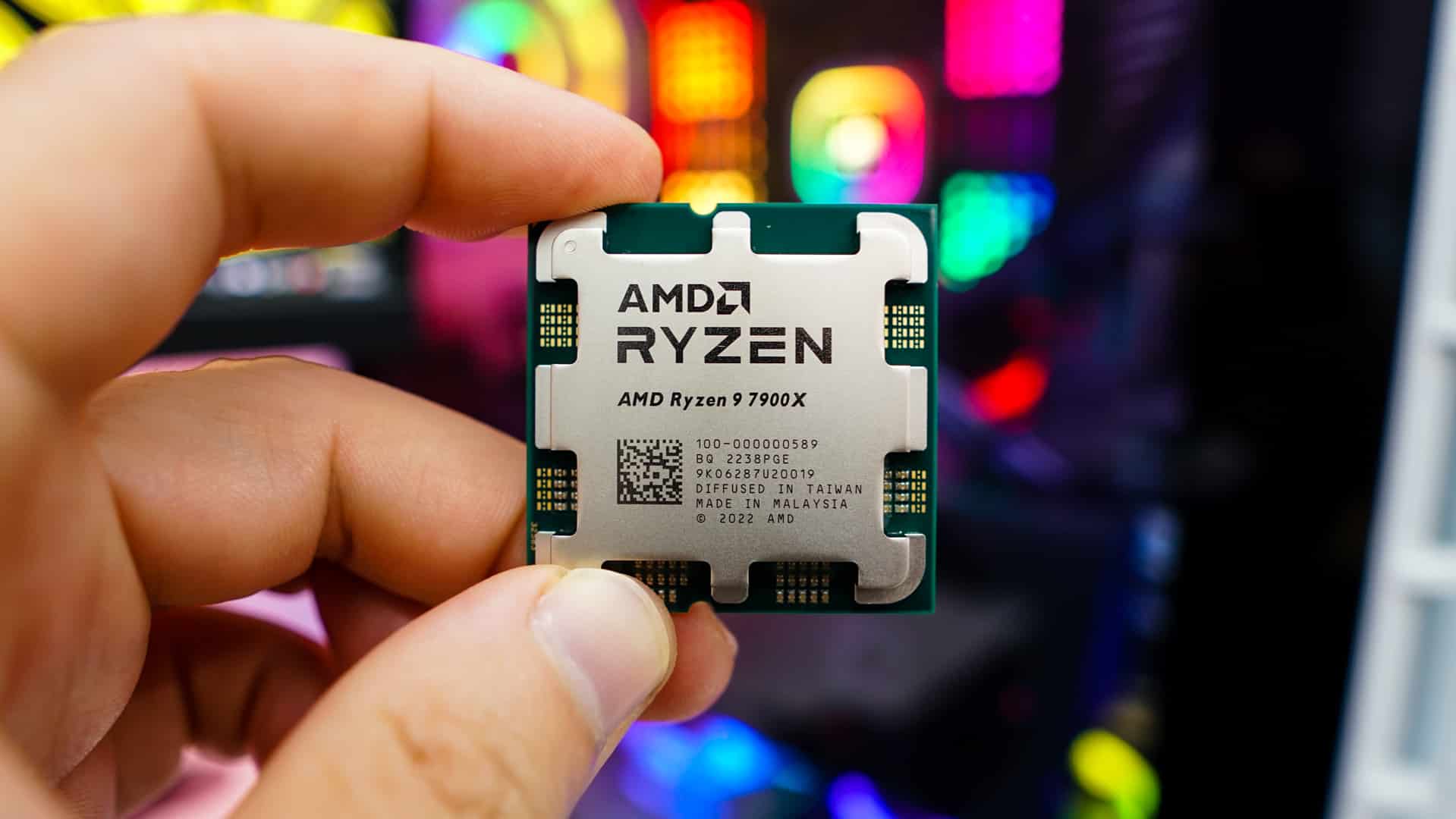

AMD Ryzen 9 7900X Processor Review

Today we are taking a look at the Ryzen 9 7900X which is a 12 core, 24 thread processor that has a base clock of 4.7 GHz and a boost clock of 5.6 GHz. This processor sits right below the flagship Ryzen 9 7950X and seems like it would be a perfect chip for gamers and creators. Come along as we...

thinkcomputers.org

thinkcomputers.org