Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

millenniumpilot

Enthusiast

Hallo gea,

dank für den Tip. Habe mich etwas in dladm einarbeiten müssen und jetzt auf die vmxnet3 umgestellt. Effekt ist nicht weg, scheint jetzt aber erst bei noch höherer Last aufzutreten. Ich mache bei nächster Gelegenheit aber nochmals einen Test mit der alten StorageVM mit Openindiana, um nicht grundlos den falschen zu beschuldigen ;-)

Auf ESXi5.1 habe ich noch nicht umgestellt, da ich von Problemen beim Durchreichen von Kontrollern gehört habe.

Gruß Millenniumpilot

dank für den Tip. Habe mich etwas in dladm einarbeiten müssen und jetzt auf die vmxnet3 umgestellt. Effekt ist nicht weg, scheint jetzt aber erst bei noch höherer Last aufzutreten. Ich mache bei nächster Gelegenheit aber nochmals einen Test mit der alten StorageVM mit Openindiana, um nicht grundlos den falschen zu beschuldigen ;-)

Auf ESXi5.1 habe ich noch nicht umgestellt, da ich von Problemen beim Durchreichen von Kontrollern gehört habe.

Gruß Millenniumpilot

Hallo zusammen,

wenn ich mal kurz dazwischen funken darf:

Ich habe ein FreeNAS System mit einem ZFS Plattenverbund aus 3 Platten quasi im Raid 0 Modus (zusammen 3TB).

Jetzt habe ich eine weitere Platte (4TB) eingebaut, auf die die bestehenden Daten gespiegelt werden sollen, also ein Raid 1 aus den vorhgandenen 3 Platten im raid0 zusammen mit der neuen 4TB Platte als Spiegel ist das Ziel.

Die 3 einzelnen Platten werden irgendwann durch eine andere große Platte ersetzt wobei das Raid 1 weiterhin bestehen soll. Das aber zu gegebener Zeit.

Ich weiss das die Lösung blöd ist, zunächst ging es aber nicht anders und nun will ich es besser machen. Daher bitte ich um konstruktive Vorschläge bzw Hilfe um das möglichst ohne Datenverlust umzusetzen.

Weiss also jemand wie man hier am besten mit dem Befehl zpool hantiert?

Vielen Dank schonmal.

Hallo,

naja, gea's Antwort "geht nicht" ist zwar prinzipell richtig, aber ich habe da noch eine etwas eigenwillige Lösung.

Man kann ein ZFS auch aus Imagedateien zusammenbauen.

Lege einen neuen Pool (sagen wir tank1) mit der neuen Platte an und kopiere alle Daten auf den neuen Pool (die neue Platte).

Mach die 3 alten Platten (den striped Pool) leer und lege eine GROOOOOOOOßE Imagedatei auf diesem ZFS an.

Danach erstelle einen neuen Pool (sagen wir tank2) mit der großen Imagedatei und kopiere deine Daten auf diesen Pool. Abschließend den Pool (tank1) mit der neuen Platte zerstören und die neue Platte danach als Spiegel dem Pool (tank2), bestehend aus der großen Imagedatei, hinzufügen.

Über Sicherheit möchte ich in diesem Zusammenhang garnicht reden, aber es wäre machbar.

Hallo,

naja, gea's Antwort "geht nicht" ist zwar prinzipell richtig, aber ich habe da noch eine etwas eigenwillige Lösung.

Man kann ein ZFS auch aus Imagedateien zusammenbauen.

Lege einen neuen Pool (sagen wir tank1) mit der neuen Platte an und kopiere alle Daten auf den neuen Pool (die neue Platte).

Mach die 3 alten Platten (den striped Pool) leer und lege eine GROOOOOOOOßE Imagedatei auf diesem ZFS an.

Danach erstelle einen neuen Pool (sagen wir tank2) mit der großen Imagedatei und kopiere deine Daten auf diesen Pool. Abschließend den Pool (tank1) mit der neuen Platte zerstören und die neue Platte danach als Spiegel dem Pool (tank2), bestehend aus der großen Imagedatei, hinzufügen.

Über Sicherheit möchte ich in diesem Zusammenhang garnicht reden, aber es wäre machbar.

Ein Raid nicht aus ganzen Platten sondern aus logischen devices (Dateien/Partitionen) aufzubauen geht technisch schon. Meist macht man das andersrum indem man aus einer großen Platte mehrere kleinere devices macht um unterschiedlich große Platten einzubinden, so wie Synology z.B. mit Hybrid Raid. Die Datensicherheit dabei entspricht dem schwächsten Glied der Konstruktion.

Das Problem dabei ist, dass man bei Problemen/ Reparaturen höllisch aufpassen muss was man macht. Der kleinste Fehler und alles geht hops.

Ich würde sowas als theoretisch möglich aber als praktische Katastrophe sehen. Ein Datenverlust ist da fast vorprogrammiert.

Ein Raid nicht aus ganzen Platten sondern aus logischen devices (Dateien/Partitionen) aufzubauen geht technisch schon. Meist macht man das andersrum indem man aus einer großen Platte mehrere kleinere devices macht um unterschiedlich große Platten einzubinden, so wie Synology z.B. mit Hybrid Raid. Die Datensicherheit dabei entspricht dem schwächsten Glied der Konstruktion.

Das Problem dabei ist, dass man bei Problemen/ Reparaturen höllisch aufpassen muss was man macht. Der kleinste Fehler und alles geht hops.

Ich würde sowas als theoretisch möglich aber als praktische Katastrophe sehen. Ein Datenverlust ist da fast vorprogrammiert.

Sehe ich, wie schon gesagt, genauso. Das ist eine rein akademische Betrachtung.

Hallo gea,

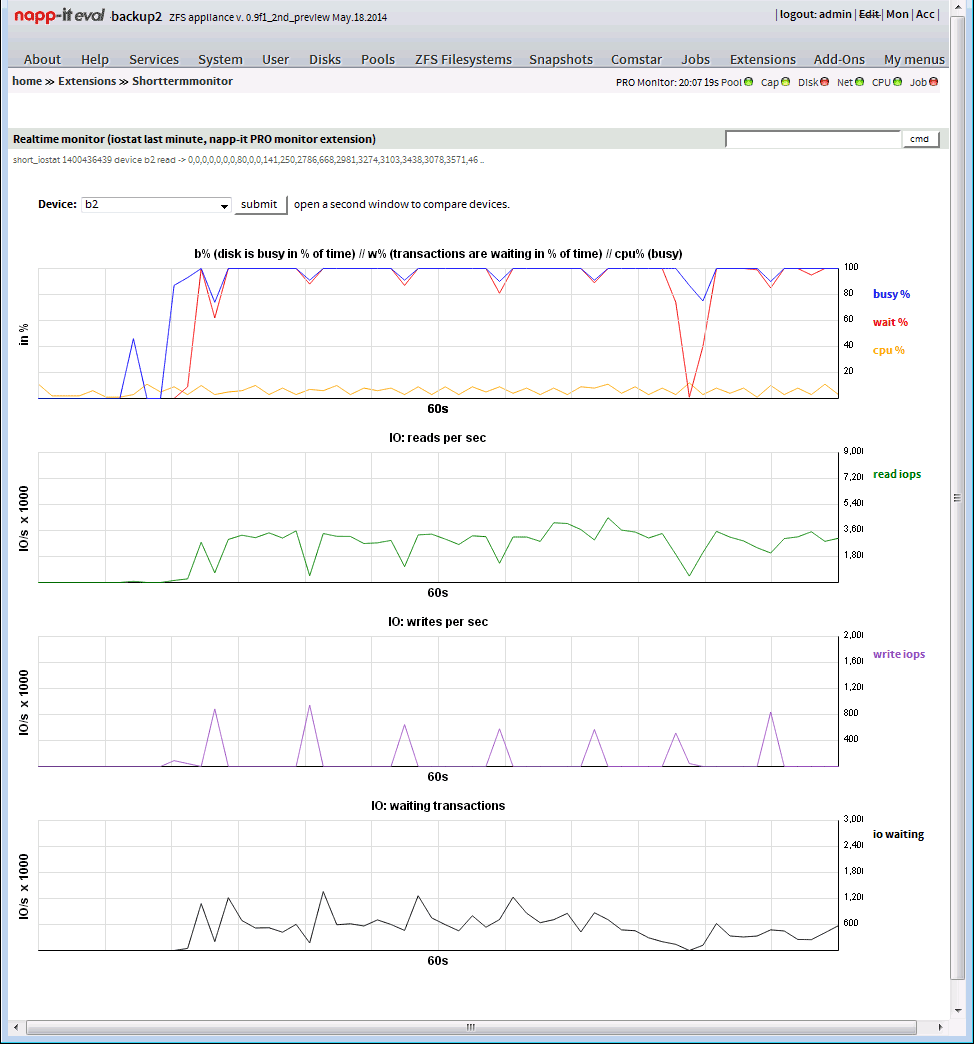

die neue Version mit Realtime Monitor ist ja wirklich eine coole Sache. Das gefällt mir schon richtig gut! TOP!!!

Hast du evtl. geplant das Monitoring noch etwas auszubauen, damit man auch auf längere Zeiträume zurückgreifen kann und sich dort informieren kann, wie sich das System über Tagen, Wochen, Monate, Jahre verhält?

Grüße

Bin gerade dabei.

Aktuell geht Realtime und Kurzzeit (letzte 60s für CPU, Pool und einzelne Platten, iops, busy, wait)

Langzeitlogs demnächst.

automatenraum

Enthusiast

- Mitglied seit

- 15.02.2013

- Beiträge

- 179

EDIT: Wenn ich mir noch was wünschen darf, vielleicht noch ein TAB, bei dem man mit verschiedenen Farben Read, Write etc. in einem Diagramm auf einen Blick hat...

Danke gea!!!

Danke gea!!!

Zuletzt bearbeitet:

EDIT: Wenn ich mir noch was wünschen darf, vielleicht noch ein TAB, bei dem man mit verschiedenen Farben Read, Write etc. in einem Diagramm auf einen Blick hat...

Danke gea!!!

Im Moment steht noch die Datenerfassung und Aufbereitung im Vordergrund.

Wenn das alles läuft, geht es an die grafische Aufarbeitung.

Ich werde dann alle Parameter (read,write,wait, busy) gleichzeitig anzeigen,

Edit,

hatte heute etwas Zeit dazu (so siehts aus, wenn man einen Scrub anstartet)

Zuletzt bearbeitet:

Digi-Quick

Urgestein

- Mitglied seit

- 02.09.2009

- Beiträge

- 7.082

mal eine generelle Frage.

Werden Raidz3 Tanks mit 19 Platten (16+3) eigentlich in der Praxis noch eingesetzt oder eher nicht - sprich bei 11 Platten (8+3) ist sozusagen Schluss?

Die zu speichernden Dateien sind zu mindestens 95 % grösser als 10 MB (Fotos in niedriger Kompression im JPG Format und im RAW Format, sowie Videodateien)

Hintergrund meiner Frage:

30 Platten liessen sich am besten auf 2 Raidz3 Tanks mit 11 und 19 Platten aufteilen, bei allen anderen aufteilungen würde ich bei mindestens einem Tank die "optimale" Anzahl der Datenplatten nicht erreichen.

D.h. die Netto Plattenanzahl lässt sich durch 8 teilen und hat als Ergebnis eine 2^x (0,25 02^-2; 0,5 = 2^-1; 1 =2^0; 2=2^1; 4=2^2 etc.), woraus resultiert, daß die optimale Plattenanzahl 2, 4, 8, 16, 32, 64 Plus die Anzahl der Paritätsplatten (hier 3) wäre.

Bei der Aufteilung 11, 11 & 8 Platten wäre das Raid aus 8 Platten ungünstig, bei einer Aufteilung 15 & 15 Platten wären beide Subsystem ungünstig.

Eine alternative wäre noch 3x10 Platten im Raidz2 (Raid6), was bei 4TB Platten eine erhebliche Verschlechterung in Bezug auf die MTTDL (Mean Time To Data Loss) bedeuten würde, nämlich fast 0,3% in 5 Jahren ggü. 0,0004%, was einem Faktor von ca. 1000 entspricht bei 11 Platten im Raidz3.

RAID Reliability Calculator - Simple MTTDL Model - ServeTheHomeSTH – Server and Workstation Reviews

(4 TB Platten/ 4K Sektoren / URE von 10^13 / 30 MB/s rebuild-/Resilverrate / Konservative Lebensdauer der Platten als Kalkulationsbasis gewählt)

Ein Raidz3 aus 19 Platten hat immerhin noch eine MTTDL von 0,01%, was immer noch um den Faktor 30 besser ist als bei einem Raidz2 aus 10 Platten.

Zugegeben, daß sind alles nur statistische Werte, auf die man sich im Realen Anwendungsfall nicht verlassen kann, aber zumindestens eine Riskobewertung erlauben, zumal ich mit Werten kalkuliert habe, die deutlich unter den Herstellerangaben liegen.

Werden Raidz3 Tanks mit 19 Platten (16+3) eigentlich in der Praxis noch eingesetzt oder eher nicht - sprich bei 11 Platten (8+3) ist sozusagen Schluss?

Die zu speichernden Dateien sind zu mindestens 95 % grösser als 10 MB (Fotos in niedriger Kompression im JPG Format und im RAW Format, sowie Videodateien)

Hintergrund meiner Frage:

30 Platten liessen sich am besten auf 2 Raidz3 Tanks mit 11 und 19 Platten aufteilen, bei allen anderen aufteilungen würde ich bei mindestens einem Tank die "optimale" Anzahl der Datenplatten nicht erreichen.

D.h. die Netto Plattenanzahl lässt sich durch 8 teilen und hat als Ergebnis eine 2^x (0,25 02^-2; 0,5 = 2^-1; 1 =2^0; 2=2^1; 4=2^2 etc.), woraus resultiert, daß die optimale Plattenanzahl 2, 4, 8, 16, 32, 64 Plus die Anzahl der Paritätsplatten (hier 3) wäre.

Bei der Aufteilung 11, 11 & 8 Platten wäre das Raid aus 8 Platten ungünstig, bei einer Aufteilung 15 & 15 Platten wären beide Subsystem ungünstig.

Eine alternative wäre noch 3x10 Platten im Raidz2 (Raid6), was bei 4TB Platten eine erhebliche Verschlechterung in Bezug auf die MTTDL (Mean Time To Data Loss) bedeuten würde, nämlich fast 0,3% in 5 Jahren ggü. 0,0004%, was einem Faktor von ca. 1000 entspricht bei 11 Platten im Raidz3.

RAID Reliability Calculator - Simple MTTDL Model - ServeTheHomeSTH – Server and Workstation Reviews

(4 TB Platten/ 4K Sektoren / URE von 10^13 / 30 MB/s rebuild-/Resilverrate / Konservative Lebensdauer der Platten als Kalkulationsbasis gewählt)

Ein Raidz3 aus 19 Platten hat immerhin noch eine MTTDL von 0,01%, was immer noch um den Faktor 30 besser ist als bei einem Raidz2 aus 10 Platten.

Zugegeben, daß sind alles nur statistische Werte, auf die man sich im Realen Anwendungsfall nicht verlassen kann, aber zumindestens eine Riskobewertung erlauben, zumal ich mit Werten kalkuliert habe, die deutlich unter den Herstellerangaben liegen.

Zuletzt bearbeitet:

wir hatten dazu gerade eine Diskussíon im hardforum http://hardforum.com/showthread.php?t=1818832

Fazit:

was nützen MTBF von 1,5 Mio Stunden oder MTTDL wenn normale Ausfallraten bei 2-15% pro Jahr liegen, bei alten Platten gerne mehr. Das ist wie wenn xx bei Neuwagen einen Verbrauch von 4,9l angibt der in der Praxis bei 7l liegt und nach 5 Jahren auf 9l steigt.

zur Frage

raid-z3 mit 19 Platten ist ok - nicht furchtbar schnell was IO angeht- aber ok

Fazit:

was nützen MTBF von 1,5 Mio Stunden oder MTTDL wenn normale Ausfallraten bei 2-15% pro Jahr liegen, bei alten Platten gerne mehr. Das ist wie wenn xx bei Neuwagen einen Verbrauch von 4,9l angibt der in der Praxis bei 7l liegt und nach 5 Jahren auf 9l steigt.

zur Frage

raid-z3 mit 19 Platten ist ok - nicht furchtbar schnell was IO angeht- aber ok

Zuletzt bearbeitet:

GrafikTreiber

Enthusiast

- Mitglied seit

- 25.12.2005

- Beiträge

- 1.531

Tank ist der Standardname in Beispielen für Pools, ist schon seit dem ersten ZFS-Release so in den Docs und so ziemlich jedem Tutorial.

@gea: Ich glaube du hast dich da mit der Copy Pasta vertan, Hardforum, nicht Fratzenbuch.

@gea: Ich glaube du hast dich da mit der Copy Pasta vertan, Hardforum, nicht Fratzenbuch.

Zuletzt bearbeitet:

@gea: Ich glaube du hast dich da mit der Copy Pasta vertan, Hardforum, nicht Fratzenbuch.

eiberbibsch..

danke, korrigiert

Digi-Quick

Urgestein

- Mitglied seit

- 02.09.2009

- Beiträge

- 7.082

Der Vergleich trifft den Nagel so ziemlich auf den Kopf, deswegen kann man die Herstellerangaben allenfalls für statistische Mittelwertsanalysen heranziehen. Ein Raid aus "Montagsplatten" wird mit hoher Wahrscheinlichkeit eine MTTDL von 50% oder mehr im ersten Jahr haben.was nützen MTBF von 1,5 Mio Stunden oder MTTDL wenn normale Ausfallraten bei 2-15% pro Jahr liegen, bei alten Platten gerne mehr. Das ist wie wenn xx bei Neuwagen einen Verbrauch von 4,9l angibt der in der Praxis bei 7l liegt und nach 5 Jahren auf 9l steigt.

deswegen hatte ich für meine persönliche Risikobewertung auch nur eine URE von 10^13 angenommen und eine MBTF von 145.000h

Das wollte ich wissen.zur Frage

raid-z3 mit 19 Platten ist ok - nicht furchtbar schnell was IO angeht- aber ok

I/O ist nicht gar so kritisch, da eh meist nur 1 Rechner zur Zeit zugreift - seltener mal 2.

Das ganze soll ein Datenarchiv mit adäquater Redundanz werden, welches nur bei Bedarf läuft. die wirklich wichtigen Daten werden dann nochmal gesondert auf ein 2. NAS gesichert.

- - - Updated - - -

Wenn schon "meckern", dann richtigWas ist ein "tank"? Du meinst "pool". Bleib doch bei den Standardbegriffen und denk dir nicht neues Zeug für die gleiche Sache aus. Das verwirrt nur.

Es geht hier - soweit ich ZFS verstanden habe - um VDs bzw. VDevs. Ein Pool kann immerhin aus mehreren VDs/VDevs bestehen, wobei die einzelne Disk ja auch als VDev bezeichnet wird, was ich persönlich ein wenig verwirrend empfinde.

P

phlowx

Guest

Was ist ein "tank"? Du meinst "pool". Bleib doch bei den Standardbegriffen und denk dir nicht neues Zeug für die gleiche Sache aus. Das verwirrt nur.

http://docs.oracle.com/cd/E19253-01/819-5461/gaypm/index.html

ymmd :-D

Dir ist schon der Unterschied zwischen dem Namen und der Sache klar? Das ist auch in deinem Link ein "pool", der nur "tank" heißt. Deswegen ist es nicht "ein tank".

"The following example shows how to create a basic mirrored storage pool named tank"

Also wenn sowas "deinen Tag macht", spricht das nicht gerade für dich.

Tank ist der Standardname in Beispielen für Pools, ist schon seit dem ersten ZFS-Release so in den Docs und so ziemlich jedem Tutorial.

s.o.

Wenn schon "meckern", dann richtig

Es geht hier - soweit ich ZFS verstanden habe - um VDs bzw. VDevs. Ein Pool kann immerhin aus mehreren VDs/VDevs bestehen, wobei die einzelne Disk ja auch als VDev bezeichnet wird, was ich persönlich ein wenig verwirrend empfinde.

Ach, merkste was? In den Beispielen wird meist der Pool "tank" genannt und nicht die vdevs (Edit: sofern man vdevs überhaupt benennen könnte). Du meinst vdevs und nennst sie "tanks". Das stützt mein Argument zu 100%, dass man Sachen nennen sollte, wie alle sie nennen.

Was 1-Disk-vdevs angeht, ist das eigtl. eine ganz natürliche Sache. Single-disk, RAID1, RAIDZ, ... sind halt die Möglichkeiten, wie ein vdev aufgebaut sein kann.

Zuletzt bearbeitet:

Hallo zusammen,

kurze Frage zum HD Start nachdem sie im Spindownmodus waren.

Die Platten starten danach, alle nacheinander (mir ist klar, dass dies fuer das Netzteil besser ist, gibt es noch andere Gründe dafür?), gibt es eine Möglichkeit dies zu beschleunigen, also das alle Platten aufeinmal starten?

Wie immer thx für die Antworten.

kurze Frage zum HD Start nachdem sie im Spindownmodus waren.

Die Platten starten danach, alle nacheinander (mir ist klar, dass dies fuer das Netzteil besser ist, gibt es noch andere Gründe dafür?), gibt es eine Möglichkeit dies zu beschleunigen, also das alle Platten aufeinmal starten?

Wie immer thx für die Antworten.

hominidae

Urgestein

- Mitglied seit

- 23.10.2011

- Beiträge

- 4.175

..das Feature nennt sich staggered spinup...schau mal im BIOS des Controllers nach "spinup-groups" ...da kann man einstellen wieviele Platten (oder Platten-Gruppen) gleichzeitiig anfahren.

Aber achte darauf, dass Dein NT es auch abkann..Du brauchst mind. 2A Leistung an 12V pro Platte dafür.

Aber achte darauf, dass Dein NT es auch abkann..Du brauchst mind. 2A Leistung an 12V pro Platte dafür.

P

phlowx

Guest

Also wenn sowas "deinen Tag macht", spricht das nicht gerade für dich.

In einer Diskussion persönlich zu werden, spricht auch nicht gerade für dich. Natürlich kenne ich den Unterschied und jeder, der geantwortet hat, wusste auch was damit gemeint war,

nur Du musstest dich über den verwendeten Begriff aufregen.

In einer Diskussion persönlich zu werden, spricht auch nicht gerade für dich. Natürlich kenne ich den Unterschied und jeder, der geantwortet hat, wusste auch was damit gemeint war,

nur Du musstest dich über den verwendeten Begriff aufregen.

Wo hab ich mich aufgeregt?

Aufregen kann ich mich nur über kleine Bengel, die mit "ymmd :-D" ankommen und dabei nicht mal den Einwand verstehen. Das war jetzt persönlich, das da oben nicht.

Huhu Leute, ich poste nochmal hier - vllt. gibt es ja noch andere Anfänger, die wie ich den Überblick etwas verlieren!

Huhu und danke!

Ich hab mich gerade mal durch dein AiO-Tut durchgearbeitet und versucht etwas näher mit zu beschäftigen. Super Paket hast du da entwickelt! Ideal für SMB und Zuhause!

So ein wenig mit Zentyal oder Sophos und ipfire würde ich ja aber trotzdem mal herumprobieren.

1. Der "pool" von dem du immer sprichst, ist quasi das, was man immer RAID bezeichnest? Nur das es halt ein wachsendes System ist, statt eine vordefinierte Größe!?

Ich lege also einen pool für alles an, oder mehere pools - quasi wie Partitionen?

- VM-pool | Arbeits-pool | Medien-pool | Backup-pool

oder

- pool auf 4*HDD mit Ordner für VM | Medien | Arbeit | Backup

2. Sollten die Programme oder vor allem die Datenbanken der einzelnen VMs eigentlich immer in der jeweiligen VM bleiben, oder sollte man diese dann wieder ausgliedern? Ich denk da an Exchange und solche Sachen

3. 32 GB als RAM ok? Sollten da 8 GB für das ZFS reichen?

4. Nochmal zum Thema Netzwerk/Netzwerkkarte. Also in einem anderen Büro war das immer ganz einfach: Wir haben da einen managed Switch von HP (~100 €), da hing ein dann bspw. ein QNAP dran und ein MacPro jeweil mit zwei Netzwerkkabeln. Ich habe dann einmal im QNAP "LinkAggregation" aktiviert, dann das selbe in OSX und im Switch musste man das nur auf "auto" setzen - und schon hatte er die - zugegeben 2* 1GB nutzen können - aber da ja alles in Paketen verschickt wird macht dass das System ja von allein.

Und dieses Link-Aggregation (port trunking) funktioniert nicht unter napp-it? Oder macht da das ESXi Probleme?

Ich könnte mir das wie folgt vorstellen: 2 NICs einer Intelkarte reiche ich passthrough an die napp-it VM weiter und stelle dort dann die Link-Aggregation ein - also eine IP im Home-LAN über 2 Kabel. Für interne Kommunikation würde ich dann einen der virtuellen NICs - so wie bei dir in den Beschreibungen steht nutzen.

Kleine Zusatzfrage: Welche wichtigen Funktionen fallen denn nach den 3 Monaten Test bei ESX weg? Vllt. kennst du ja auch ein Buch oder Tut für Vmware für Dummies; ich bekomme einfach keinen Überblick über die ganzen Funktionen und Bestandteile und Programme oder Verschiedene Verwaltungsgeschichten.

gea schrieb:xalur schrieb:Hallo gea,

ich versuche mir gerade auch für Büro (nur ich) und Zuhause einen VM-Server zusammen zu stellen.

Ich frag die jetzt einfach mal kurz ganz direkt, weil ich die Mac Frage nicht durcheinander bringen möchte.

Habe ich das so in etwa richtig verstanden (deine Tipps):

Bsp:

+ HP ProLiant ML310e Gen8 v2

+ IBM 1015

+ 1* SSD (Crucial M550 128GB, 2.5", SATA 6Gb/s hab ich mir da gedacht)

+ 4* HDD (HGST Deskstar 7K4000 4TB - wird ja hier immer empfohlen)

+ Ilo dedicated Karte (will ich gern haben - hat aber eigentlich nichts mit meiner Nachfrage zu tun)

- Dann Installiere ich Vmware auf einer SD-Kart, welche in den HP-internen-Slot gesteckt wird

- Der IBM Controller wird LSI IT geflasht

- Danach kommt napp-it von dir als VM auf die SSD

- Im Controller muss ich nichts machen - der reicht ja bei ZFS nur durch

- Im napp-it Konfiguriere ich ein ZFS RAID das ich für meinen Fileserver (dein napp-it) als Storage verwenden kann

- Dann gibt es halt ganz normale Freigaben und Netzlaufwerke usw. für MacPro im Büro und sonstiges im Haushault

- Wenn ich jetzt weitere VMs einsetze (Mailserver, Webserver oder was mir dann sonst noch so einfällt, dann kommt das ebenfalls auf die SSD - wenn die Datenplatz brauchen, könnten die auch über "Netzwerk" auf das Storage vom napp-it zugreifen (Also die Datenbank liegt dann in der Freigabe/Partition auf den ZFS-Store)

- napp-it kann Snapshots erzeugen und die an ein anderes NAS an einem anderen Standort kopieren?

Wenn das alles so klappen würde wäre ich mega happy! Wenn die Geschwindigkeit mit 2 Netzwerkadapter (Mac Pro hat auch 2) noch über die 200 Mb/s kommt, dann kann ich mir so noch ein Thunderbolt2 Storage im Büro sparen.

Oder sollte lieber jede weitere VM einen eigenen dezidierten NIC bekommen?

Viele Grüße!!!

es ist so gedacht:

Auf die SSD kommt nurdie OmniOS VM (man auch ESXi da drauf packen, bootet einfach schneller)

napp-it legt dann auf den 4 TB Platten einen Pool an und gibt den mit SMB, AFP oder NFS frei

ESXi nutzt die NFS Freigabe für weitere VMs. Die Storage VM muss dazu als erste VM gestartet werden.

Die anderen kommen mit einer Verzögerung

Man kann snapshots erzeugen und die mit napp-it replikation oder CLI + zfs send auf andere Maschinen kopieren

2 Netzwerkkarten machen nicht 2 Gb/s sondern 2 x 1 Gb/s

Zwei Prozesse nutzen damit je 1 Gb/s. 2 Gb/s ist mit round robin vermutlich möglich.

Ich sehe da aber jede Menge Probleme da alle Netzwerkkomponenten da mitmachen müssen.

Ich würde das lassen.

Der einzig sinnvolle Ausweg ist 10 Gbe.

Leider laufen die 300 Euro 10 Gb Intel Karten nicht direkt auf den Macs sondern nur solche mit angepasster Firmware zum doppelten Preis.

Huhu und danke!

Ich hab mich gerade mal durch dein AiO-Tut durchgearbeitet und versucht etwas näher mit zu beschäftigen. Super Paket hast du da entwickelt! Ideal für SMB und Zuhause!

So ein wenig mit Zentyal oder Sophos und ipfire würde ich ja aber trotzdem mal herumprobieren.

1. Der "pool" von dem du immer sprichst, ist quasi das, was man immer RAID bezeichnest? Nur das es halt ein wachsendes System ist, statt eine vordefinierte Größe!?

Ich lege also einen pool für alles an, oder mehere pools - quasi wie Partitionen?

- VM-pool | Arbeits-pool | Medien-pool | Backup-pool

oder

- pool auf 4*HDD mit Ordner für VM | Medien | Arbeit | Backup

2. Sollten die Programme oder vor allem die Datenbanken der einzelnen VMs eigentlich immer in der jeweiligen VM bleiben, oder sollte man diese dann wieder ausgliedern? Ich denk da an Exchange und solche Sachen

3. 32 GB als RAM ok? Sollten da 8 GB für das ZFS reichen?

4. Nochmal zum Thema Netzwerk/Netzwerkkarte. Also in einem anderen Büro war das immer ganz einfach: Wir haben da einen managed Switch von HP (~100 €), da hing ein dann bspw. ein QNAP dran und ein MacPro jeweil mit zwei Netzwerkkabeln. Ich habe dann einmal im QNAP "LinkAggregation" aktiviert, dann das selbe in OSX und im Switch musste man das nur auf "auto" setzen - und schon hatte er die - zugegeben 2* 1GB nutzen können - aber da ja alles in Paketen verschickt wird macht dass das System ja von allein.

Und dieses Link-Aggregation (port trunking) funktioniert nicht unter napp-it? Oder macht da das ESXi Probleme?

Ich könnte mir das wie folgt vorstellen: 2 NICs einer Intelkarte reiche ich passthrough an die napp-it VM weiter und stelle dort dann die Link-Aggregation ein - also eine IP im Home-LAN über 2 Kabel. Für interne Kommunikation würde ich dann einen der virtuellen NICs - so wie bei dir in den Beschreibungen steht nutzen.

Kleine Zusatzfrage: Welche wichtigen Funktionen fallen denn nach den 3 Monaten Test bei ESX weg? Vllt. kennst du ja auch ein Buch oder Tut für Vmware für Dummies; ich bekomme einfach keinen Überblick über die ganzen Funktionen und Bestandteile und Programme oder Verschiedene Verwaltungsgeschichten.

P

phlowx

Guest

Huhu Leute, ich poste nochmal hier - vllt. gibt es ja noch andere Anfänger, die wie ich den Überblick etwas verlieren!

1. Der "pool" von dem du immer sprichst, ist quasi das, was man immer RAID bezeichnest? Nur das es halt ein wachsendes System ist, statt eine vordefinierte Größe!?

Ich lege also einen pool für alles an, oder mehere pools - quasi wie Partitionen?

- VM-pool | Arbeits-pool | Medien-pool | Backup-pool

oder

- pool auf 4*HDD mit Ordner für VM | Medien | Arbeit | Backup

Am besten einen Pool über alle Platten (Bei 4 Platten würde sich ein Pool aus 2 RAID1 VDEVs anbieten) und dann die ZFS-Datasets anlegen (VM/Medien/Arbeit/Backup)

Kleine Zusatzfrage: Welche wichtigen Funktionen fallen denn nach den 3 Monaten Test bei ESX weg? Vllt. kennst du ja auch ein Buch oder Tut für Vmware für Dummies; ich bekomme einfach keinen Überblick über die ganzen Funktionen und Bestandteile und Programme oder Verschiedene Verwaltungsgeschichten.

Hier gibt's eine Übersicht:

VMware vSphere 5 Editionen Funktionsunterschiede

Bzzz

Enthusiast

- Mitglied seit

- 13.06.2006

- Beiträge

- 3.984

- Ort

- Bei Würzburg

- Desktop System

- Karl

- Laptop

- Thinkpad Anniversary Edition 25

- Details zu meinem Desktop

- Prozessor

- Epyc 7282

- Mainboard

- H11SSL-i

- Kühler

- NH-U9 TR4-SP3

- Grafikprozessor

- RX570 Red Devil

- Display

- EX3501R / RDP

- Gehäuse

- RM41300

- Netzteil

- Focus Gold 450

- Keyboard

- MX Board 3.0 (Luxx-Adventskalender '17 🥰 )

- Mouse

- MX518 Legendary

- Sonstiges

- MCX311A-XCAT

- Internet

- ▼100 ▲40

Bei der Aufteilung 11, 11 & 8 Platten wäre das Raid aus 8 Platten ungünstig, bei einer Aufteilung 15 & 15 Platten wären beide Subsystem ungünstig.

Eine alternative wäre noch 3x10 Platten im Raidz2 (Raid6), was bei 4TB Platten eine erhebliche Verschlechterung in Bezug auf die MTTDL (Mean Time To Data Loss) bedeuten würde, nämlich fast 0,3% in 5 Jahren ggü. 0,0004%, was einem Faktor von ca. 1000 entspricht bei 11 Platten im Raidz3.

Der Vergleich trifft den Nagel so ziemlich auf den Kopf, deswegen kann man die Herstellerangaben allenfalls für statistische Mittelwertsanalysen heranziehen. Ein Raid aus "Montagsplatten" wird mit hoher Wahrscheinlichkeit eine MTTDL von 50% oder mehr im ersten Jahr haben.

deswegen hatte ich für meine persönliche Risikobewertung auch nur eine URE von 10^13 angenommen und eine MBTF von 145.000h

Meinem simplen Physikverständnis nach hat eine Mean Time, also eine statistisch ermittelte durchschnittliche Zeit bis Event X, die Einheit [Zeit]. Also Sekunden, Stunden, Jahre, oder was halt grade praktisch ist. Bei der MTBF passt das ja, aber wie soll denn eine MTTDL die Einheit [% pro Jahr], also [1/Zeit] haben?

Habe folgendes Problem: Wenn ich einen neuen User hinzufüge bei nappit mit SMB Zugriff dann taucht er da nicht auf.

Wollte Zugriffsrechte setzen verbunden per SMB als root.

Als "Benutzer" tauchen dort aber nur 2 EInträge auf nämlich "root" und "everyone". Weder sonstige User sehe ich da noch andere Gruppen, jemand ne Ahnung wodran es liegt?

Wollte Zugriffsrechte setzen verbunden per SMB als root.

Als "Benutzer" tauchen dort aber nur 2 EInträge auf nämlich "root" und "everyone". Weder sonstige User sehe ich da noch andere Gruppen, jemand ne Ahnung wodran es liegt?

Am besten einen Pool über alle Platten (Bei 4 Platten würde sich ein Pool aus 2 RAID1 VDEVs anbieten) und dann die ZFS-Datasets anlegen (VM/Medien/Arbeit/Backup)

Hier gibt's eine Übersicht:

VMware vSphere 5 Editionen Funktionsunterschiede

Danke!

Noch jemand Erfahrung mit den Netzwerkkarten?

Wie geht man vor bei einem AD? Legt man einen AD-User an, gibt die Freigabe ans AD und mittels Login am Mac und den PCs werden die Freigaben dann erteilt? Irgendwie hab ich beim Schreiben gerade das Gefühl, gar kein AD zu benötigen, wenn eh die Medienfreigaben ohne Login funktionieren. Dachte irgendwie als Sicherheit, damit die Freigaben auf dem Mac nur bei einem authentifizierten Login bereitgestellt werden.

Danke!

Noch jemand Erfahrung mit den Netzwerkkarten?

Es gibt zwei problematische Wege, ein Netz etwas schneller zu machen:

- Link Aggregation

- Jumbo frames

und einen der wirklich was bringt ohne Probleme zu bereiten

- ein schnelleres Netz z.B. 10 GbE

Link Aggregation beschleunigt nicht alles | c't

Wie geht man vor bei einem AD? Legt man einen AD-User an, gibt die Freigabe ans AD und mittels Login am Mac und den PCs werden die Freigaben dann erteilt? Irgendwie hab ich beim Schreiben gerade das Gefühl, gar kein AD zu benötigen, wenn eh die Medienfreigaben ohne Login funktionieren. Dachte irgendwie als Sicherheit, damit die Freigaben auf dem Mac nur bei einem authentifizierten Login bereitgestellt werden.

AD (Active Directory) ist eine zentrale Benutzerdatenbank. Man kann also auf mehrere Server zugreifen ohne überall Benutzer lokal anlegen und pflegen zu müssen. Für einen einzelnen Server bringt das nichts. Da einfach die Benutzer lokal anlegen und gut ist.

Wenn man den Gastzugriff aktiviert, dann ist nicht mal ein lokaler User notwendig da der Zugriff ohne Anmeldung funktioniert.

- - - Updated - - -

Habe folgendes Problem: Wenn ich einen neuen User hinzufüge bei nappit mit SMB Zugriff dann taucht er da nicht auf.

Wollte Zugriffsrechte setzen verbunden per SMB als root.

Als "Benutzer" tauchen dort aber nur 2 EInträge auf nämlich "root" und "everyone". Weder sonstige User sehe ich da noch andere Gruppen, jemand ne Ahnung wodran es liegt?

Das liegt meist an der verwendeten Windows Version (Pro gehen meist, Home dagegen nicht).

Einfach mal die ACL für einen Benutzer auf dem Server setzen und schauen, ob der dann unter Windows angezeigt wird.

Also verwende W8.1 Update Pro

Mh okay aber die Rechte auf dem Server setzen kann ich nur mit der Extension glaube ich.

/usr/bin/chmod oder

napp-it // webbased ZFS NAS/SAN appliance for OmniOS, OpenIndiana, Solaris and Linux downloads

Ähnliche Themen

- Antworten

- 5

- Aufrufe

- 1K

[Kaufberatung]

Neuer ZFS Homeserver

- Antworten

- 20

- Aufrufe

- 2K

- Antworten

- 17

- Aufrufe

- 1K