Werbung

In Kooperation mit ASUS

Das Thema HDR bestimmt aktuell die Diskussion im Bereich der Monitore. Nach einer langen Durststrecke kommt die Technik 2018 auf dem Schreibtisch an. Doch welche Hardware wird benötigt und was sind die besten Einstellungen, um in den Genuss von Bildern mit einem maximalen Dynamik-Umfang zu kommen? In unserem Special gehen wir der HDR-Thematik auf den Grund.

Wirklich neu ist das Thema „High Dynamic Range“ oder in kurz „HDR“ nun wirklich nicht mehr. Gerade im Bereich der TV-Geräte gibt es schon über einen längeren Zeitraum Geräte, die mit der entsprechenden Thematik vermarktet werden. Noch länger dürften Fotografen mit dem Thema HDR etwas anfangen können, denn das Zusammenfügen von verschieden lang belichteten Aufnahmen zu einem einzigen Bild, gehört unter Fans schon seit vielen Jahren zum Standardrepertoire – anfänglich noch per Hand, später dann per Software.

Etwas länger hat es gedauert, bis HDR wirklich PC-Wiedergabe angekommen ist. Dies hängt zum einen damit zusammen, dass es keine echte Zertifizierung für den PC-Bereich gab, zum anderen damit, dass die Panels einfach nicht das geliefert haben, was den HDR-Effekt ausmacht. In diesem Jahr ändert sich das zusehends. Wir hatten bereits mehrere HDR-Geräte im Test, wobei der ASUS PA32UC eindeutig herausgestochen hat. Mit einer Peak-Helligkeit von 1.000 cd/m² und einem Local-Dimming-System, das 384 unterschiedliche Zonen bedient, kommt bei dem 32-Zöller echtes HDR-Feeling auf. Daher nutzen wir das Gerät, um uns näher mit HDR zu beschäftigen und zu evaluieren, welche Einstellungen eigentlich wirklich benötigt werden.

HDR? Was ist das eigentlich

Die grundlegende Prämisse für HDR ist zunächst einmal ziemlich einfach: Das menschliche Auge funktioniert aktuell noch deutlich besser, als es jede Display-Technik darstellen kann. Das Problem ist dabei der Kontrastumfang, den die aktuell Technik darstellen kann. Entweder ein gleißender Sonnenstrahl scheint wirklich aus dem Display heraus, dafür fallen dunkle Partien im Bild aber bestenfalls noch hellgrau aus – oder es ist genau anders herum. Sind dunkle Bereiche fein durchzeichnet, fehlt es sehr hellen Bildelementen an Leuchtkraft. Unser Auge wäre aber in der Lage, beides gleichzeitig wahrzunehmen.

Genau hier setzt HDR an. Bedingt durch moderne Technik und ein entsprechendes gemastertes bzw. programmiertes Quellmaterial, wird es möglich, näher an das heranzureichen, was unsere Augen wirklich wahrnehmen können. Das gilt aber nicht nur für das reine Kontrastverhältnis, sondern auch für die Farbwiedergabe. HDR arbeitet mit deutlich größeren Farbräumen, was zu einer lebendigeren und intensiveren Farbdarstellung führt.

Das Ergebnis von HDR kann überwältigend sein. Wer HDR nutzt, gewöhnt sich schnell an die Vorteile und vermisst den Vorteil schnell, wenn auf normales Material zurück gewechselt wird. Etwas vereinfacht könnte gesagt werden: Nachdem in der Vergangenheit stets in die Richtung von „mehr Pixeln“ gegangen wurde, stehen nun „bessere Pixel“ im Fokus.

Wie sich bereits erahnen lässt: Damit HDR in der Praxis funktioniert, muss die Hardware einiges bieten.

Was muss die Hardware für ein HDR-Setup können?

Wichtig zu verstehen ist, dass HDR nur dann wirklich funktionieren kann, wenn die gesamte Wiedergabekette entsprechend ausgelegt ist. Das bedeutet also, dass es nicht nur reicht, einen neuen Monitor anzuschaffen. Auch die Grafikkarte muss in der Lage sein, entsprechendes Material zu liefern.

Nutzer, die eine NVIDIA-Grafikkarte verwenden möchte, der sollte mindestens eine Karte der 900er-Serie sein Eigen nennen. Steckt also beispielsweise die ASUS GeForce GTX 1070 im Rechner kann schon einmal nichts mehr passieren. Natürlich schauen auch Nutzer einer AMD-Grafikkarte nicht in die Röhre. Hier startet der Support offiziell mit der RX400-Reihe. Noch gibt es aber Probleme, wenn mit einer AMD-Grafikkarte beispielsweise YouTube in HDR wiedergegeben werden soll.

Etwas anders sieht es unserer Erfahrung nach bei den Monitoren aus. Das Label HDR hört man aktuell häufiger. Wichtig ist die Tatsache, dass die schlichte Kombination der drei Buchstaben keine geschützte Bezeichnung ist, die im Bereich der PCs einen gewissen Qualitätsstandard garantiert. Da das HDR-Erlebnis maßgeblich von dem abhängt, was der Monitor liefern kann, lohnt es sich, einen Blick in das Datenblatt des Wunschkandidaten zu werfen und nicht einfach dem HDR-Versprechen zu trauen.

Angeschlossen werden muss der Monitor mittels einer Verbindung, die nach dem aktuellen Standard HDCP 2.2. kopiergeschützt ist. Entsprechend muss sowohl das Display, als auch der Monitor mit modernen Schnittstellen ausgerüstet sein.

Als Prozessor sollte mindestens eine Core-CPU der 7. Generation (Kaby Lake) genutzt werden, wenn die interne Grafik zur HDR-Wiedergabe genutzt werden soll. Natürlich muss dann auch das Mainboard dazu passen und einen Ausgang vom Typ DisplayPort 1.2a oder HDMI 2.0a besitzen.

Den größten Effekt auf das HDR-Gefühl hat der Kontrastumfang, den der Monitor darstellen kann. Es muss also ein möglichst tiefes Schwarz in Kombination mit einem möglichst hellen Weiß geboten werden.

Besonders interessant sind daher Monitore, die auf Local Dimming setzen, also einzelne Bereiche des Backlights ausschalten können. Auf diese Weise sind Segmente, die keine Bildinhalte darstellen auch wirklich schwarz – und damit Geräten mit einer kontinuierlichen Beleuchtung immer vorziehen, wenn es um die HDR-Darstellung geht. Aber auch wenn der Punkt Local Dimming im Datenblatt auftaucht, muss noch aufgepasst werden. Je feiner die Sektionen unterteilt sind, desto besser kommt der Effekt zum Tragen. Es gibt Monitore, die lediglich 8 Zonen besitzen und damit nur recht grob ihr Backlight regulieren können. Bewegt sich dann ein helles Licht über eine dunkle Oberfläche, fällt schnell auf, wie die verschiedenen Zonen geschaltet werden.

Besser machen es Geräte wie der ASUS PA32UC (zum Test), dessen Local Dimming mit 384 Zonen arbeitet. Auch hier fällt bei einem genauen Blick noch auf, wenn verschiedene Zonen umschalten, bei der normalen Betrachtung macht sich das aber weniger bemerkbar. Gleichzeitig setzt ASUS auf ein sehr leuchtstarkes Backlight, das kurzfristig bis zu 1.000 cd/m² bereitstellen kann und damit für eine extrem helle Darstellung sorgt. Auch hier gibt es große Unterschiede zwischen verschiedenen „HDR-Interpretationen“, denn manches Gerät möchte schon mit rund 300 cd/m² „echtes HDR“ bieten.

Welche HDR-Standards gibt es

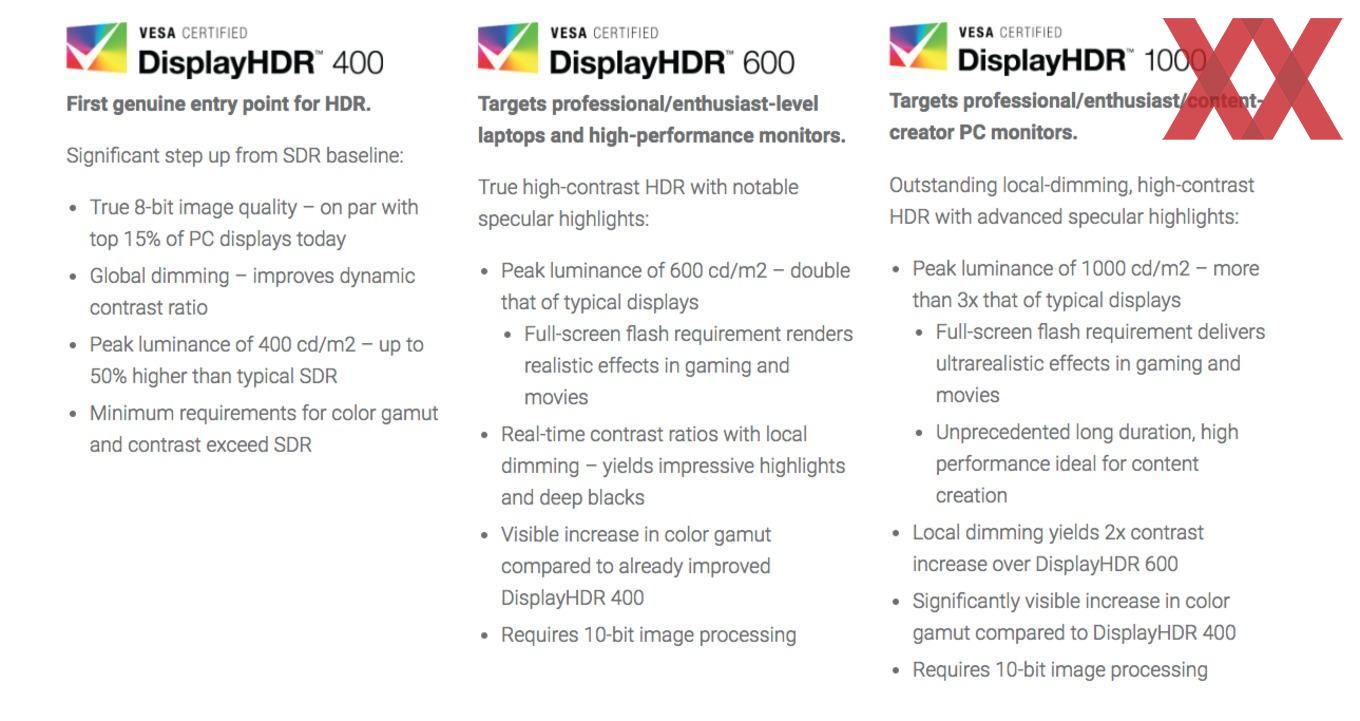

Wir haben es bereits angesprochen. Dass HDR-Content im PC-Bereich bislang einen recht schweren Stand hatte, lag nicht nur an den Geräten, sondern auch am Standard-Chaos. Im Bereich der Fernseher haben sich recht schnell HDR10 und DolbyVision als konkurrierende Standards etabliert. Doch Anfang 2018 konnte sich die VESA endlich auf entsprechende Standards einigen und unterteilt HDR-Geräte künftig in drei Klassen. Das erscheint sinnvoll, werden doch recht gut die verschiedenen Erfahrungs-Level von HDR klassifiziert.

Der Einstieg in die HDR-Welt erfolgt mit DisplayHDR 400. Um dieses Label zu erhalten, reicht es aus, wenn maximal 400 cd/m² geboten werden und die Farbverarbeitung mit 8 Bit erfolgt. Da zudem kein Local Dimming vorausgesetzt wird, kann hier noch nicht wirklich von einem HDR-Effekt gesprochen werden. Die zweite Stufe stellt DisplayHDR 600 dar, das schon eine ganze Stufe anspruchsvoller ist. Die Helligkeit muss mit 600 cd/m² schon ein gutes Stück höher ausfallen. Gleichzeitig muss ein 10-Bit-Farbmanagement genutzt werden und auch Local Dimming muss mit von der Partie sein. Das High-End-Level wird mit DisplayHDR 1000 erreicht. Nicht nur, dass die maximale Helligkeit im Peak bei 1.000 cd/m² liegen muss, auch das Local Dimming muss feingliedriger sein.

Es zeigt sich also recht schnell: Wer wirklich in den Genuss von HDR-Feeling kommen möchte, sollte mindestens ein Gerät mit DisplayHDR-600-Klasse auf seinen Wunschzettel schreiben. Der von uns genutzte ASUS PA32UC hingegen reiht sich mühelos in der High-End-Klasse ein.

HDR in der Praxis – was muss konfiguriert werden

Die passende Grafikkarte steckt im Rechner, der HDR-Monitor steht endlich auf dem Schreibtisch. Doch was muss alles konfiguriert werden, damit die Vorteile beim Nutzer ankommen?

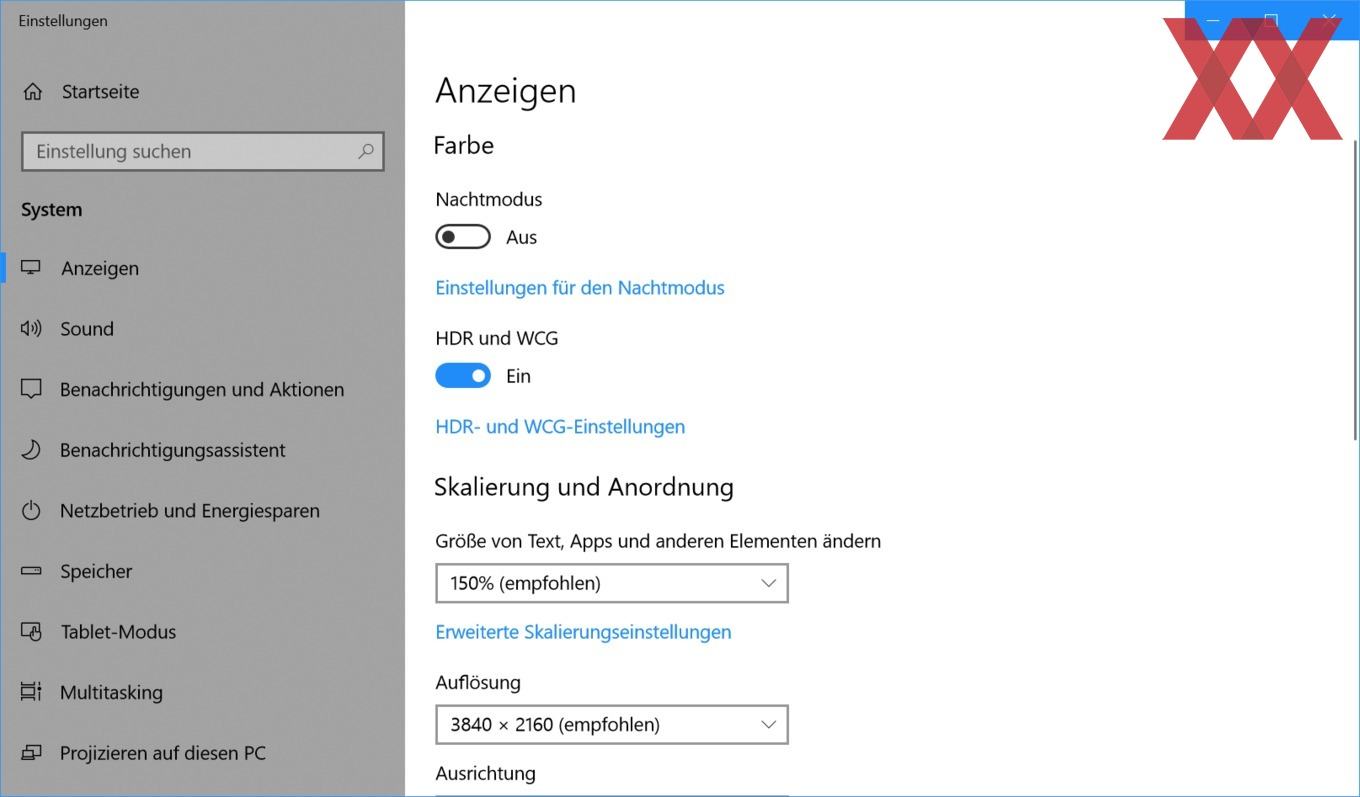

Die Basis stellt das Betriebssystem dar. Ohne Windows 10 RedStone 3 (oder neuer) geht nichts, denn die alten Versionen sind schlichtweg noch nicht für eine entsprechende Wiedergabe ausgelegt. Der erste Weg führt in das erweiterte Menü der Anzeige-Einstellungen. Dort kann in Windows das Feature „HDR und MPC“ aktiviert werden. Im Anschluss sollte man sich nicht wundern, denn das Bild erscheint zunächst dunkler. Ebenso kann es passieren, dass manche feinen Linien nicht mehr ganz perfekt dargestellt werden. Gleichzeitig kommt noch nicht jede Anwendung mit dem HDR-Modus zurecht. Chrome beispielsweise scheint noch immer nicht angepasst zu sein und stelle weiße Websites in unseren Tests lediglich grau dar – auch die oftmals empfohlene Aktivierung der Hardwarebeschleunigung bringt keine Abhilfe. In Edge hingegen sehen alle Websits vollkommen normal aus.

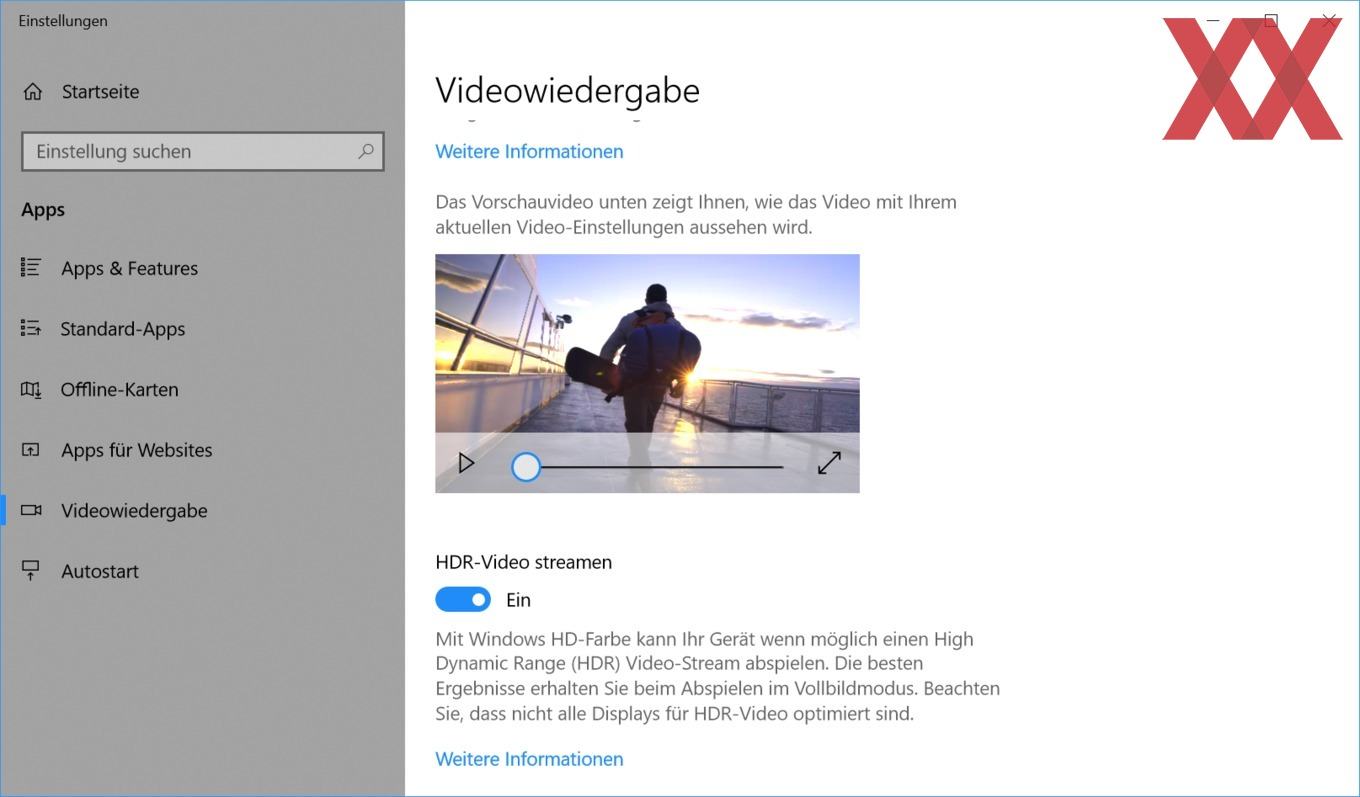

Deutlich interessanter ist allerdings die HDR-Darstellung bei Anwendungen. Wichtig ist es hierbei im Kopf zu haben, dass HDR nicht immer automatisch aktiv ist. Soll beispielsweise HDR-fähiges YouTube-Material wiedergegeben werden, muss zusätzlich im Windows-Menü „Videowiedergabe“ der Reiter „HDR-Video streamen“ aktiviert werden. Ob HDR im Anschluss funktioniert, sieht man im wahrsten Sinne des Wortes sehr schnell. Als Beispiel wird gerne „The HDR Channel“ genannt. Die Aufnahmen eines Strandes zeigen schnell, welche Vorteile HDR in der Praxis bieten kann.

Netflix läuft mit NVIDIA, Intel und AMD

Netflix gehört bei den meisten Haushalten heutzutage zur „Standardausstattung“ und unterstützt in seinem größten Abo-Paket nicht nur die 4K-Auflösung, sondern auch HDR. Seit dem Fall Creators Update klappt die Wiedergabe von entsprechendem Material auch unter Windows 10, wenn zusätzlich die HEVC-Videoerweiterungen installiert werden. Zumindest dann, wenn man sich an ein paar Einschränkungen hält. Chrome und Firefox werden noch nicht unterstützt. Microsofts Edge und die Netflix-eigene App funktionieren sehr wohl und liefern in Kombination mit dem ASUS PA32UC eine mehr als ansehnliche Bildqualität.

Es muss allerdings auch die Grafikkarte passen. Wer eine GeForce-GPU nutzt, muss mindestens ein Modell mit 4 GB einsetzen, ansonsten wird es nichts mit der HDR-Wiedergabe. Nach anfänglichen Schwierigkeiten laufen in der Zwischenzeit auch AMD-Grafikkarten ab der RX400-Generation.

Unsere bisherigen Tests haben gezeigt, dass HDR nicht nur bei Filmen einen erstklassigen Effekt haben kann, sondern auch bei Spielen fasziniert. Die Immersion, die ansonsten versucht wird, über große und geschwungene Panels zu erreichen, wird durch den großen Dynamikumfang weiter gesteigert. Wenn in einem dunklen Raum plötzlich eine Explosion stattfindet, kann das durchaus zu einem Erlebnis werden. Noch unterstützen aber nicht allzu viele Spiele explizit HDR. Es ist aber davon auszugehen, dass in der nahen Zukunft kein großer Titel mehr ohne entsprechenden Support kommen wird.

Alles in allem ist HDR ein großer Schritt in die richtige Richtung. Nachdem es in der Vergangenheit stets um die Pixelanzahl auf dem Panel ging, steht nun die Qualität der Darstellung im Mittelpunkt. Wer auf entsprechendes Equipment setzt, das die nötigen Helligkeitsreserven mit einem ein Local Dimming kombiniert, die richtige Hardware im Rechner stecken hat und am Ende die richtigen Haken in der Software setzt, wird mächtig Spaß bei Serien, Filmen oder Games haben. Für letztere werden die kommenden Monate besonders interessant, denn dann starten die G-Sync-Monitore mit HDR-Support und hohen Wiederholfrequenzen – genau die Kombination, auf die Fans schon lange warten.

In Kooperation mit ASUS