Werbung

Das Highlight der heutigen Keynote der GPU Technology Conference war sicherlich die Vorstellung der Volta-Architektur. Der Weg bis zur Volta-Architektur ist aber eine Geschichte, die NVIDIA ebenfalls erzählen möchte und dabei nimmt das Unternehmen auch Bezug auf Moores Law. Zuletzt sprach auch Intel über die entsprechenden Herausforderungen.

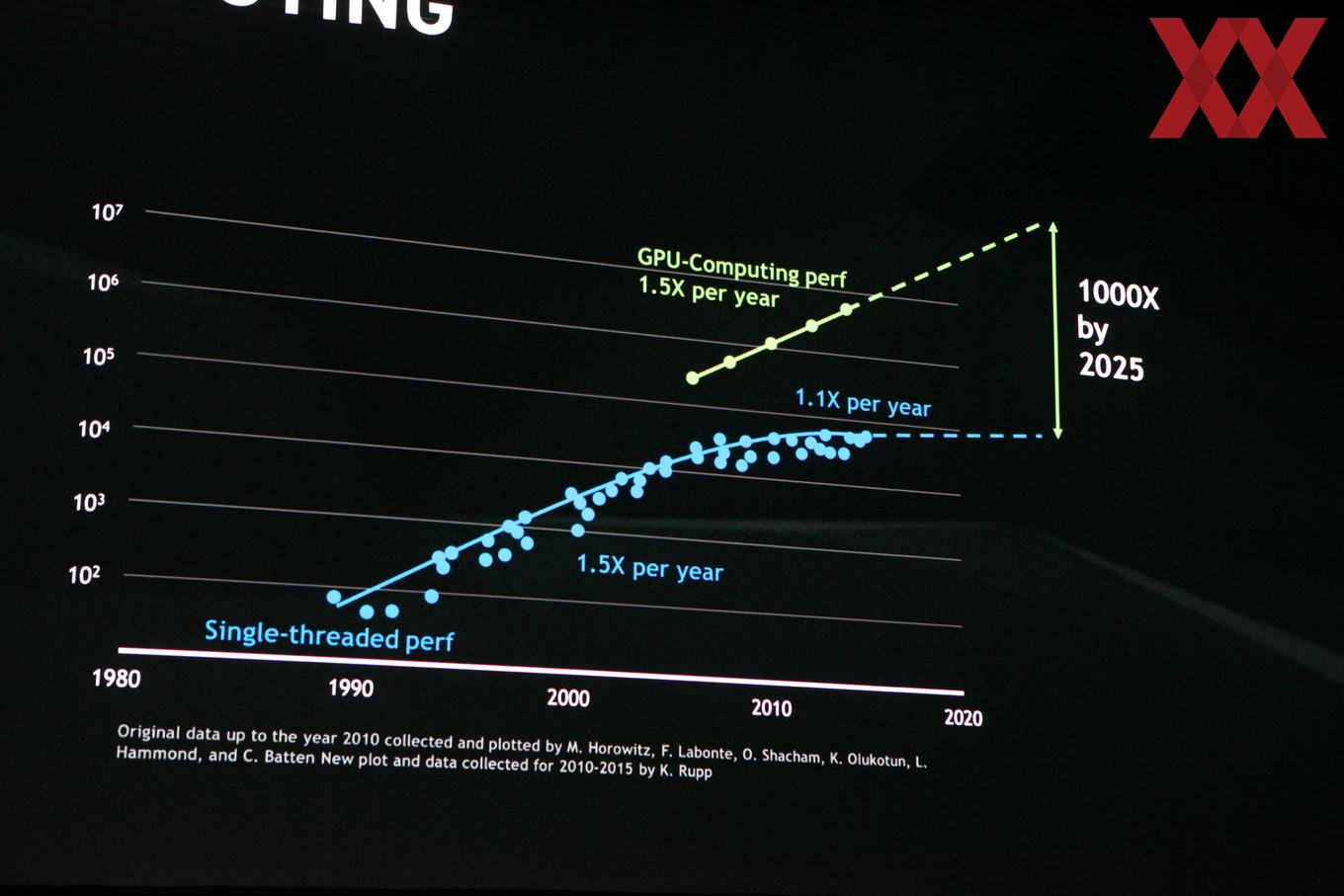

Laut NVIDIA hat Morres Law nur noch durch die Parallelisierung in den vergangenen Jahren bestand. Die Instruktion Pipelines wurden immer größer, um die Single-Threaded-Anwendungen zu beschleunigen. Weitere Optimierungen wie Caches-Hirarchien und Instruktionen wurden ebenfalls immer komplexer, um diese Bedürfnisse zu erfüllen.

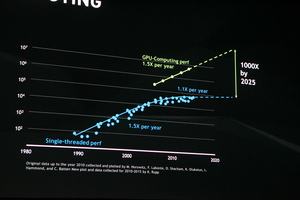

Neue Fertigungstechnologien machen gleichzeitig immer kleinere Strukturen möglich, die Anzahl der Transistoren stieg immer weiter an. Bei der GV100-GPU werden 21 Milliarden Transistoren auf einer Fläche von 812 mm² verwendet. Doch dieser Trend wurde in den vergangenen Jahren spürbar verlangsamt. Wuchs die Single-Threaded-Leistung zwischen 1990 bis 2005 noch um fast 50 % pro Generation und Jahr an, reduzierte sich diese Steigerung auf 10 % und weniger.

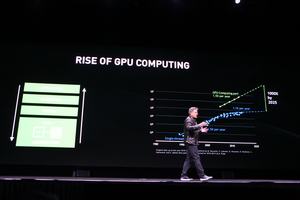

NVIDIA sieht das Ende zweier Straßen gekommen – „We have reached the end of two roads“.GPUs hingegen konnten ab 2005 ein Leistungswachstum von 50 % pro Generation und Jahr halten. Bis 2025 geht NVIDIA davon aus, dass sich dies so fortsetzen lässt.

Vor zehn Jahren legte NVIDIA daher große Teile der finanziellen Ressourcen und Manpower des Unternehmens neu aus. Man orientierte sich in eine Richtung, die heute als gemeinsame Hardware-Plattform im GeForce-Segment und professionellen Bereich die Früchte erntet. Basis dafür ist aber auch die Software. Fast 7.000 Mitarbeiter hat NVIDIA alleine im Software-Bereich. Dem stehen nur 2.000 Ingenieure im Hardware-Bereich gegenüber.

Deep Learning bleibt das Hauptthema

Über Deep-Learning-Netzwerke spricht NVIDIA nun bereits seit einiger Zeit und inzwischen hat sich diese Technik auch in weite Bereiche des Alltags ausgebreitet. In verschiedenen Forschungsbereichen trainieren sich Deep-Learning-Netzwerk gegenseitig, fordern sich gegenseitig in bestimmten Aufgaben heraus und werden damit immer besser.

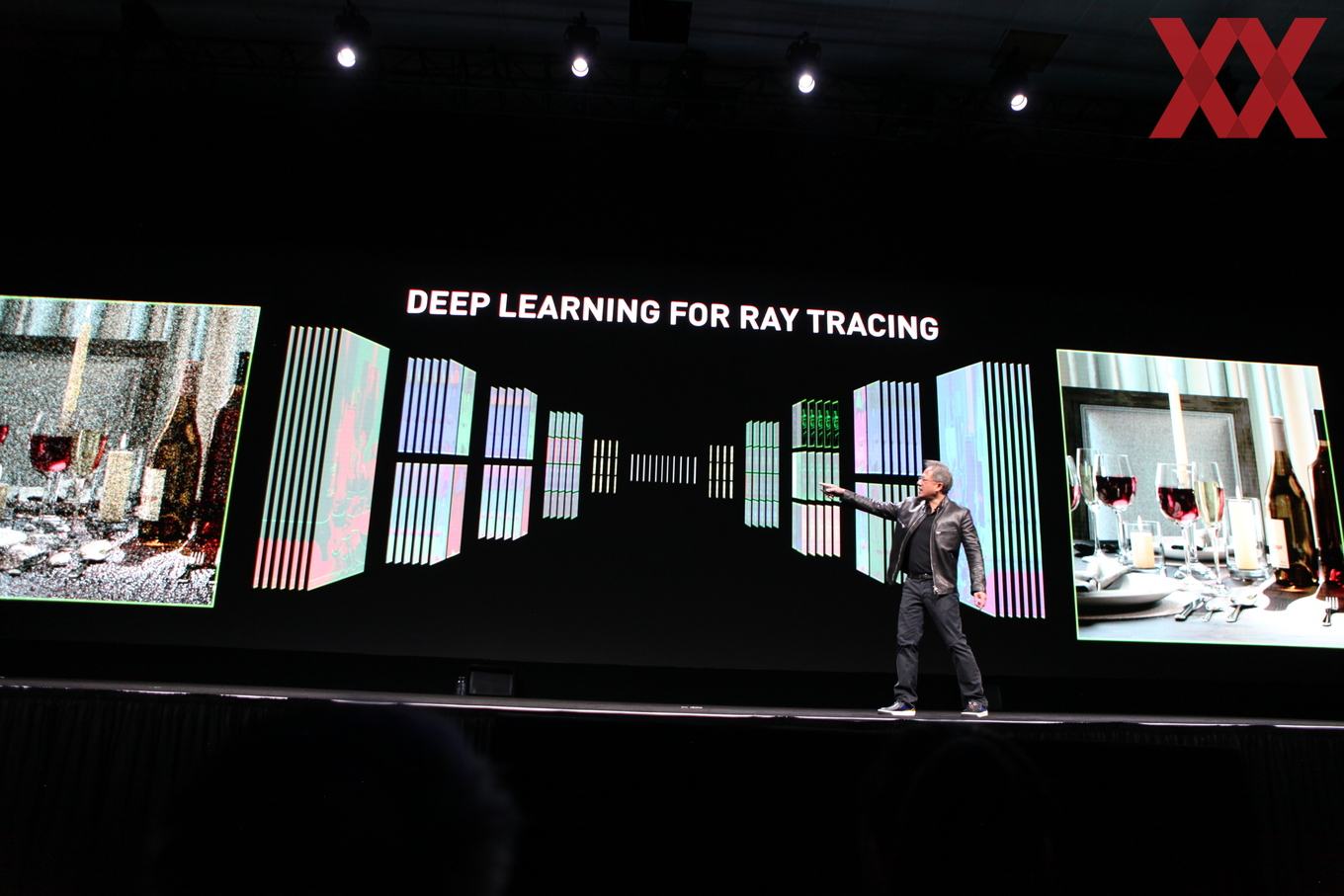

Deep-Learning für Ray Tracing soll das Rauschen beim Prozess des Ray Tracing schneller entfernen können. Die Berechnung von mehreren Tausend oder sogar Millionen Light Rays benötigt auch auf moderner Hardware seine Zeit. Die noch ausstehenden Bereiche der Berechnung werden durch ein Rauschen dargestellt. Da der Renderer aber nicht weiß, welche Objekte einer Szene am wichtigsten sind, berechnet er die Rays einfach in einer für ihn logischen Reihenfolge. Um die Wartezeit auf das fertige Bild zu reduzieren und das Rauschen schneller entfernen zu können, errechnen Deep-Learning-Algorithmen die wichtigen Bereiche des Bildes und berechnen diese schneller.