Werbung

Zur GPU Technologies Conference im vergangenen Jahr stellte NVIDIA mit dem HGX-1 ein Serversystem vor, welches im Grunde genommen eine wassergekühlte Variante des DGX-1 und für den Einsatz in der HPC-Cloud vorgesehen ist. In diesem Jahr hat NVIDIA die Varianten der Tesla V100 mit 32 GB, also verdoppelten HBM2, vorgestellt. Auch die Quadro V100 ist seit dem Frühjahr in dieser Ausbaustufe verfügbar.

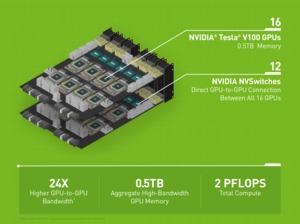

Heute nun stellt NVIDIA das HGX-2 vor. Auch hier kommen wieder Tesla V100 zum Einsatz, allerdings hat NVIDIA die Anzahl der GPU-Beschleuniger von 8 auf 16 verdoppelt. Ebenfalls zum Einsatz kommt der neue NVSwitch, der per NVLink bis zu 16 Komponenten mit voller Geschwindigkeit anbinden kann. Wie beim Vorgänger besteht der Server aus mindestens zwei Prozessoren – welche genau, verrät NVIDIA aber nicht. Es wird scheinbar aber drei Varianten des HGX-2 geben, der je nach Anwendungsbereich eine unterschiedliche Ausstattung bietet. Für das Training von Deep-Learning-Netzwerken sieht NVIDIA den HGX-T2 vor, das Inferencing also Anwenden dieser Netzwerke soll der HGX-I2 übernehmen und für das Supercomputing soll ein SCX getauftes Modell herhalten.

81.920 Shadereinheiten kommen gemeinsam zum Einsatz und werden durch 10.240 Tensor Cores ergänzt. Zur Rechenleistung gibt NVIDIA nur eine Mixed-Precision-Leistung von 2 PFLOPS an. Beim Einsatz von 16 Tesla V100 kommen wir auf eine Rechenleistung von 124,8 TFLOPS bei doppelter Genauigkeit (FP64), 249,6 TFLOPS bei einfacher Genauigkeit (FP32), 499,2 TFLOPS bei halber Genauigkeit (FP16) sowie 2 POPS für INT8-Berechnungen. Der HBM2 aller 16 Karten ist 512 GB groß und kann unter den GPU-Beschleunigern geteilt werden.

Noch unklar ist, wie die restlichen Komponenten des HGX-2 aussehen werden. Diese Details wird NVIDIA sicherlich zur Pressekonferenz auf der Computex 2018 enthüllen. Am Montag den 4. Juni wird NVIDIA diese abhalten.

"The world of computing has changed," sagt Jen-Hsun Huang, CEO von NVIDIA. "CPU scaling has slowed at a time when computing demand is skyrocketing. NVIDIA’s HGX-2 with Tensor Core GPUs gives the industry a powerful, versatile computing platform that fuses HPC and AI to solve the world’s grand challenges."

Lenovo, QCT, Supermicro und Wiwynn werden die HGX-2 anbieten. ODMs wie Foxconn, Inventec, Quanta und Wistron werden eigene Server auf Basis des HGX-2 für große Datacenter entwicklen.