Werbung

Mit der heutigen Veröffentlichung von Llama 2 sowie der bereits erfolgten Veröffentlichung einiger vortrainierter Large Language Modelle soll die Abhängigkeit von kleineren Entwicklern und Firmen verringert und der Zugang zu solchen Modellen vereinfacht werden. Das Training solcher Modelle kostet je nach Größe mehreren Millionen US-Dollar, stellenweise sollen es schon hunderte Millionen sein.

NVIDIA verdient gut daran, denn vermutlich geht jeder verkaufte H100-Beschleuniger aktuell zu den Hyperscalern und "kleineren" Anwendern der LLMs. Der Bestand an Systemen mit dem Vorgänger A100 dürfte ebenfalls noch erheblich sein und so sicherte sich NVIDIA die Vormachtstellung wenn es um das Hardware-Angebot geht.

Aber auch wenn die H100-Beschleuniger aktuell das Maß der Dinge sind, so sollen zukünftige LLMs noch komplexer und somit aufwendiger zu trainieren sein. Aber es geht nicht nur darum, die Modelle zu trainieren, sondern auch darum, sie im Inferencing in Form einer Anwendung zu nutzen – ein Sprachmodell für einen Chat-Assistenten zum Beispiel. Google und Microsoft wollen solche Modelle in ihre Suche einbauen. Aber dies ist mit immensen Kosten verbunden. Die Analysten von SemiAnalysis haben es einmal vorgerechnet und kommen vor eine Standard-Suchanfrage bei Google auf Kosten von 0,0106 US-Dollar. Nutzt Google dafür Chat-GPT, sind es pro Suchanfrage 0,0142 US-Dollar. Bei mehreren Milliarden Suchanfragen pro Tag kommt hier schnell ein schönes Sümmchen an Zusatzkosten zusammen. Damit Google alle Suchanfrage per Chat-GPT verarbeiten kann, wären rund 500.000 A100-Beschleuniger notwendig, die nicht nur in der Anschaffung Geld kosten, sondern auch im Betrieb in Form von Strom und Platz im Rechenzentrum. Andere Quellen gehen sogar von rund zwei Millionen Beschleunigern aus. Die Kosten lägen jedenfalls im Milliardenbereich.

Um dem entgegenzuwirken, soll es ähnlich wie in anderen Bereichen auch noch speziellere Hardware für das Training der LLMs geben. Dies schlägt ein Forschungspapier (PDF) vor, an dem Forscher der Universitäten von Washington und Sidney gearbeitet haben.

Beschrieben wird ein theoretisches Chiplet-Design aus Spezialbeschleunigern, die neben einem SRAM (als Puffer und lokaler Speicher) auch mehrere MAC-Einheiten (Multiply-Accumulate) sowie Akkumulationspuffer. Mehrere dieser Chiplets könnten sich auf einem Package befinden, mehrere dieser Beschleuniger in einem Rechenknoten und mehrere Rechenknoten in einem Rack. Per Chip-2-Chip-Interface miteinander verbunden, erfolgt der schnellen Datenaustausch, der gerade bei LLMs von entscheidender Bedeutung ist.

Auf DRAM oder HBM wird verzichtet, weil dieser erstens zu langsam und auch zu teuer ist. SRAM lässt sich vergleichsweise einfach fertigen und integrieren, kostet pro MB oder GB aber natürlich Chipfläche und ist somit teuer. Die hohe Bandbreite wiegt die Kosten aber wieder auf.

Für die Modelle GPT-3 und PaLM 540B rechnen die Forscher vor, um wie viel geringer die Latenzen und Kosten pro Anfrage ausfallen – die zwei entscheidenden Parameter in der Nutzung von LLMs. Verglichen wird ein System aus 32 sogenannten Chiplet-Cloud-Servern und 32 DGX-Systemen auf Basis der A100-Beschleuniger sowie 64 TPUv4-Beschleunigern von Google:

| Modell | GPT-3 | GPT-3 | PaLM 540B | PaLM 540B |

| 32 Chiplet-Cloud-Server | 32 DGX A100 | 30 Chiplet-Cloud-Server | 64 TPUv4 | |

| Latenz | 1,9 ms | 620 ms | 4,8 ms | 93,8 ms |

| Tokens/s | 33.791 | 4.608 | 26.667 | 5.461 |

| TCO/1K Tokens * | 0,018 Cent | 1,698 Cent | 0,031 Cent | 0,478 Cent |

* Für die TCO-Betrachtung wurden US-Dollar-Cent herangezogen

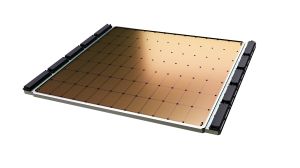

Im Grunde ist die von den Forschern vorgeschlagene Hardware nicht weit von dem entfernt, was Cerebras mit der Wafer Scale Engine macht - oder Tesla mit dem D1-Chip. Hier befinden sich alle Recheneinheiten auf einem kompletten Wafer und sind direkt miteinander verbunden. Je nach Aufgabe sind solche komplexen Systeme dann deutlich schneller als viele einzelne Chips.

Einen Nachteil hat das Konzept aber: Es ist auf bestimmte Modelle, in diesem Fall die Transformer-Modelle, abgestimmt. Ändert sich die Richtung in der solche Modelle arbeiten, muss sich auch die Hardware ändern. Die Forscher gehen von einer Betriebsdauer von 18 Monaten für einen solchen LLM-Supercomputer aus. Dies wäre extrem kurz und so muss er auch in extrem kurzer Zeit seine Kosten wieder herausholen.

Aktuell sind einerseits eine immer höhere Rechenleitung der Recheneinheiten selbst, aber auch ein immer größerer Speicher mit einer möglichst schnellen Anbindung der Fokus in der Hardwareentwicklung der Beschleuniger. Noch hat NVIDIA hier die Nase klar vorne, aber AMD scheint seinem Konkurrenten auf den Fersen zu sein – nicht nur mit den kommenden Instinct-MI300A- und Instinct-MI300X-Beschleunigern.