Werbung

Bereits seit einigen Monaten befinden sich Exoscale, eine Tochter der A1 Digital, als Betreiber mehrerer Rechenzentren in Österreich, sowie als Co-Location-Kunde in mehreren dieser Rechenzentren sowie das österreichische Unternehmen Diggers in einer Versuchsphase für ein effizienteres Rechenzentrum. Ziel ist es, mittels einer Wasserkühlung im Rechenzentrum die Hardware nicht nur effizient zu kühlen, sondern die Abwärme auch besser nutzbar zu machen. Wir haben dazu ein Rechenzentrum von A1 in Wien besucht, in dem Exoscale eigene Server stehen hat und wo zusammen mit Diggers ein Versuchsaufbau betrieben wird, den wir uns genauer anschauen konnten.

Mit einem zunehmenden Stromverbrauch der Rechenzentren weltweit rückt deren Effizienz immer stärker in den Fokus. Der KI-Boom hat diesen Trend zuletzt deutlicher gemacht, aber auch ohne diesen dürfte klar sein, dass die Suche nach Mitteln und Wegen für einen effizienteren Betrieb eines Rechenzentrums unumgänglich sind. Bereits heute gibt es Auflagen für den Betrieb eines Rechenzentrums und zumindest ein Europa werden entsprechende Neubauten in den kommenden Jahren mit immer neuen Auflagen belegt werden.

Zugleich gibt es einen Trend europäischer Nutzer solchen Cloud-Instanzen oder Rechenzentren, sich vom US-Markt unabhängig zu machen und einen möglichen Abfluss der Daten in die USA zu verhindern. Eine European Native Cloud und die digitale Souveränität sind hier die Stichworte, wenngleich man sich über den kompletten Soft- und Hardwarestack für den Betrieb eines Rechenzentrums die Frage stellen muss, wie souverän man letztendlich sein kann.

Exoscale hat ein entsprechendes Angebot im Programm und besitzt in Deutschland (Frankfurt und München), der Schweiz (Genf und Zürich) sowie in Österreich (Wien), in Bulgarien (Sofia) und bald auch in Kroatien (Zagreb) Co-Location-Plätze bei weiteren Betreibern von Rechenzentren. Exoscale ist eine Tochter von A1 Digital und nutzt in Österreich daher auch die dazugehörigen Rechenzentren. Das Service-Angebot von Exoscale umfasst die üblichen Vorgaben und Zertifizierungen in den verschiedenen Anwendungsbereichen für Rechenzentren dieser Art – unter anderem auch für Automotive- und Medizinanwendungen.

Vienna-2 mit Cold Boxes von Diggers

Das Rechenzentrum Vienna-2, in dem Exoscale zahlreiche Server betreibt, hat eine Fläche von etwa 8.000 m² und eine mögliche Spitzenlast von 10 MW vorzusweisen. Hier werden die Proof-of-Concept-Server von Diggers betrieben, die nach weiteren Verbesserungen einmal Bestandteil des Next Generation Datacenters (NGDC) werden sollen.

Diggers ist ein Unternehmen aus Österreich, welches sich auf den Bau von flüssiggekühlten Servern konzentriert. Nun sind solche Flüssigkeitskühlungen im Serverbereich keine echte Neuheit und bereits seit Jahren im Einsatz. Durch die hohe Dichte an Rechenleistung vor allem für KI-Rechenzentren wächst der Bedarf nach einer effizienteren Kühlung aktuell stark. Waren Racks mit einer Leistungsaufnahme von 50 bis 80 kW der Normalfall, sollen Systeme wie Rubin Ultra NVL576 von NVIDIA im Jahre 2027 etwa 600 kW pro Rack verlangen. Solche Systeme werden allerdings nicht in allen Rechenzentren einsetzbar sein, denn die Anforderungen an die Traglast, Stromversorgung und Kühlung sind hoch und können allenfalls in speziell darauf ausgelegten Rechenzentren erfüllt werden.

Die Flüssigkeitskühlung der Hardware ist jedoch nur der generelle Ansatz hinter der Lösung von Diggers. Hier geht es vielmehr darum, die gesamte Abwärme des System nutzbar zu machen. Über den Rücklauf des Kühlwassers ist dies bereits heute möglich. Allerdings umfasst die Wasserkühlung in einem Server nur bestimmte Komponenten wie die Prozessoren, eventuell verbauten Beschleuniger, Netzwerkchips und Speicher. Ein gewisser Anteil an Abwärme bleibt übrig, die über die Umgebungsluft und eine Klimatisierung des Rechenzentrums abgeführt wird.

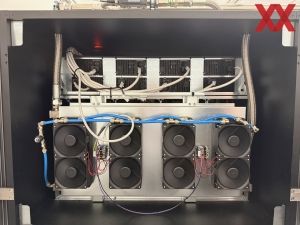

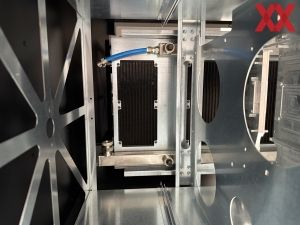

Die flüssiggekühlten Server von Diggers sind hermetisch abgeschlossene und isolierte Boxen, in denen die Hardware betrieben wird. Komponenten mit einer hohen Abwärme, wie die Prozessoren und Beschleuniger, sind mit einem eigens konstruierten Wasserkühler versehen. Die Abwärme der weiteren Komponenten wie die des Speichers, der Netzwerkomponenten, der Stromversorgung und des Massenspeichers verbleiben in der Box und werden über Wärmetauscher auf der Rückseite an den Flüssigkeitskreislauf übergeben. Somit wird die gesamte Abwärme des Servers genutzt.

Im Falle des Betriebs im A1-Rechenzentrum Vienna-2 nutzen Exoscale und Diggers das hier zur Verfügung gestellte Kühlwasser mit einer Vorlauf-Temperatur von etwa 16 bis 17 °C. Eine Wasserpumpe versorgt gleich mehrere Racks und pumpt (oder besser saugt, dazu kommen wir noch) etwa 8 l pro Minute durch die Rohre. Auch die eben angesprochenen Wärmetauscher sind Bestandteil des Wasserkreislaufs. Somit landet die komplette Abwärme des Systems im Kühlwasser. Der Raum, in dem Exoscale die Server von Diggers betreibt, verfügt über keinerlei Kühlung. Warm- und Kaltgänge wie sonst in einem Rechenzentrum üblich, sind nicht notwendig.

Die niedrige Temperatur von etwa 16 °C ist für den Betrieb der Serverboxen nicht zwangsläufig notwendig. A1 als Betreiber des Rechenzentrums in Wien muss noch evaluieren, ob es auch möglich wäre den Rücklauf der Kaltgänge zu nutzen, der etwas wärmer ist. Allerdings will A1 vermeiden, dass die Regelung des Kreislaufs für das gesamte Rechenzentrum davon beeinflusst wird. Die Systeme von Diggers würden auch 40 °C warmes Wasser problemlos verwenden können – mit entsprechend höheren Temperaturen der Hardware.

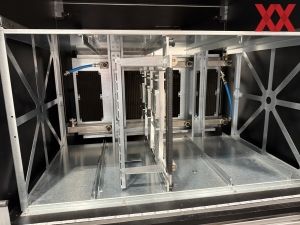

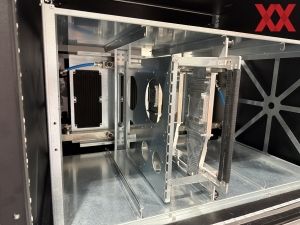

Eine weitere Besonderheit ist der Aufbau der Server, die nicht in einem klassischen U2-, U4- oder U8-Formfaktor vorhanden sind. Stattdessen verbaut Diggers die einzelnen Server auf Trays, auf denen sich ein kompletter Server befindet. Diese Trays können zu Wartungszwecken herausgezogen werden. Ein Schnellverschluss an der Rückseite verbindet den jeweiligen Kühlkreislauf mit dem restlichen Kühlsystem des Racks. Einzelne Schläuche versucht Diggers möglichst zu vermeiden und so sorgen eine Art Backplate für die Verteilung des Kühlwassers auf die einzelnen Trays und die Trays selbst haben ebenfalls einen Verteiler, durch den das Wasser dann auf die einzelnen Kühler verteilt wird.

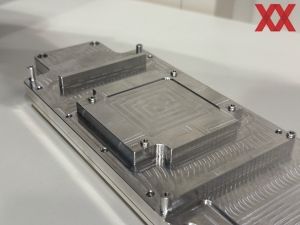

Die Kühler fertigt Diggers, wie auch die restlichen Komponenten des Racks, allesamt selbst. Mit einem GPU-Kühler können zwei GPUs gekühlt werden. In einer Art Sandwich sitzt der Kühler zwischen zwei PCBs. Der Kühler selbst besteht aus Aluminium und wird per CNC-Fräse aus zwei Teilen gefertigt.

Die innere Struktur des Kühlers soll laut Diggers eine Besonderheit aufweisen. Wie genau man die Kanäle im Inneren fertigt, wollte man allerdings nicht verraten. Gefräst werden sie nicht und auch ein Schaben und Aufstellen wie bei manchen Kühlern wird nicht angewendet. Man kann aber davon ausgehen, dass Diggers versucht, die Oberfläche so groß wie möglich zu gestalten – wie genau dies ausgeführt wird, bleibt vorerst ein Geheimnis.

Der Wasserkühler wird nicht mittels Schläuchen, sondern direkt mit Schnellverschlüssen mit dem Verteiler des Kühlwasser für ein Tray verbunden. Alle Kupplungen und Anschlüsse sind laut Diggers eine Fehlerquelle, die man möglichst verhindern möchte. In der aktuellen Form kann der Wasserkühler 1.000 W abführen – zweimal 500 W je Seite. Per Riser-Karte werden die Karten an das System angebunden.

In den Servern von Diggers zum Einsatz kommen zwei Intel Gold 6246R (Cascade Lake) mit jeweils 16 Kernen, 256 GB an Arbeitsspeicher und sechs NVIDIA A5000 oder GeForce RTX 3080 Ti. Mit einer Leistungsaufnahme von 250 bis 350 W kommen diese Karten also bei weitem nicht an die maximal möglichen 1.000 W heran. Je vier Server passen in eine Serverbox, so dass wir hier auf insgesamt 24 GPUs je Box kommen.

An dieser Stelle kommen wir noch einmal auf die Tatsache zurück, dass die Wasserpumpe das Wasser nicht in den Kreislauf drückt, sondern durch diesen saugt. Im Falle eines Lecks, soll kein Wasser austreten, sondern es wird Luft in den Kreislauf gezogen, was wiederum erkannt werden kann. Die Lösung erinnert an den Leakshield von Aqua Computer, der vor einigen Jahren vorgestellt wurde. Der Leakshield sorgte für einen Unterdruck im Ausgleichsbehälter und damit ebenfalls dafür, dass keinerlei Flüssigkeit durch ein Leck austreten sollte.

Weitere Optimierung notwendig

Aktuell noch befindet sich das Projekt in einer "Proof of Concept"-Phase. Mit Streamdiver gibt es aber auch schon einen ersten Kunden, der seine Services auf einem solchen Server laufen lässt.

Für eine nächste Version soll es weitere Änderungen an den Serverboxen geben. So ist geplant, auch auf die Schläuche für den CPU-Kühlkörper zu verzichten und stattdessen eine feste Verrohrung zu verwenden. Auch bei einigen Komponenten wie den Netzteilen dürfte es noch Änderungen geben und sicherlich wird sich auch die Hardware in eine modernere Richtung orientieren müssen, wenn man die Effizienz weiter steigern möchte. Vorgesehen ist zudem das System in den klassischen 19 Zoll anzubieten, so dass diese auch in bestehenden Schränken montiert werden können.

Durch die Wasserkühlung und unter der Voraussetzung, dass die Abwärme genutzt und nicht einfach nur in die Umgebung entlassen wird, reduziert sich die notwendige Leistungsaufnahme eines solchen Servers um 50 %. Allerdings gilt dies für wassergekühlte Server, die ihre Abwärme nutzbar weitergeben, ebenfalls. Eine große Herausforderung für Rechenzentren ist eine sinnvolle Anwendung für die Abwärme zu finden. In Städten wäre die Anbindung an das lokale Fernwärmenetz möglich, andere denken für das Beheizen von Gewächshäusern nach. Den eigenen Heizbedarf können solche Rechenzentren natürlich problemlos decken und auch die Notfall-Dieselaggregate können ständig vorgezeigt werden. Darüber hinaus fällt in einem Rechenzentrum aber wenig Wärmebedarf an. Bislang verpufft die Abwärme meist in der Umwelt und wird nicht weiter genutzt.

Dies wollen A1 Digital und Exoscale ändern. Weil Kunden inzwischen auf den CO2-Belastung ihrer Anwendungen im Rechenzentrum schauen. Exoscale will daher in Zukunft ein entsprechendes Monitoring anbieten, welches die verwendete Hardware und deren Anschaffung ebenso einschließt, wie den direkten Stromverbrauch und die eventuelle Nutzung der Abwärme.

Bis zu 98 % der Abwärme sollen nutzbar sein. Aus einem Serverrack mit 80 kW sollen damit theoretisch etwa 78,5 kW wieder zurückfließen können – beispielsweise in ein Fernwärmesystem oder im Falle von Edge-Anwendungen auch direkt beim Kunden. Dazu sollen die Serverboxen IP67 zertifiziert sein, so dass Feuchtigkeit und Staub kein Problem sind. Diggers ist als Anbieter der Serverbox unabhängig, hat in A1 Digital und Exoscale aber Partner gefunden, die sich bereits mit dem Theme Datacenter und Co. beschäftigen und hier aktiv sind. Theoretisch könnten also Serverhersteller oder andere Datacenter-Betreiber auf die Hardware von Diggers zurückgreifen.

Sinnvolle Nutzung der Abwärme bleibt die größte Hürde

In unseren Gesprächen mit A1 als Betreiber von mehreren Rechenzentren und auch aus der Erfahrung heraus hat sich bisher gezeigt, dass vor allem große Rechenzentren meist nicht dort stehen, wo die Abwärme auch benötigt wird. Ganz im Gegenteil, meist stehen sie an abgelegenen Orten. Die Versorgung mit Strom und eine schnelle sowie redundante Glasfaseranbindung sind die wichtigsten Voraussetzungen für den Betrieb.

Die sinnvolle Nutzung der Abwärme ist somit vor allem eine logistische Herausforderung, die sich mit den sonstigen Voraussetzungen für ein Rechenzentrum nicht wirklich verträgt. Aber die Rechenzentrums-Branche wird sich mit diesem Thema beschäftigen müssen. Auch wenn in den USA sämtliche Regularien für den KI-Boom über den Haufen geworfen werden, auch dort wird man früher oder später zu gewissen Vorgaben für die Nutzung der Abwärme kommen müssen.

Rechenzentren, die vor dem 1. Januar 2026 in Deutschland in Betrieb genommen wurden, müssen ab dem 1. Juli 2027 einen PUE-Wert von höchstens 1,5 und ab dem 1. Juli 2030 einen Wert von höchstens 1,3 erreichen. Für Rechenzentren, die ab dem 1. Juli 2026 den Betrieb aufnehmen, gilt ein PUE-Grenzwert von maximal 1,2. Der PUE-Wert (Power Usage Effectiveness) ist eine Kennzahl zur Messung der Energieeffizienz eines Rechenzentrums. Dabei wird der Gesamtenergieverbrauch des Rechenzentrums mit dem Energieverbrauch der IT-Systeme in ein Verhältnis gesetzt. Das Bestreben der Lösung von Diggers ist einen PUE-Wert von 1,0 zu erreichen, was dann in etwa den 98 % Nutzung an Abwärme entsprechen würde.

Die Serverboxen von Diggers könnten ein Ansatz sein, die Effizienz in Rechenzentren zu erhöhen. In einem größeren Maßstab gedacht erfüllen vollständig wassergekühlte Server, wie sie aktuell bereits eingesetzt werden, diese Voraussetzungen allerdings bereits. Wenn man nun die restliche Abwärme im Rack nach durch Wärmetauscher auffängt und entsprechend verwertet, wäre es auch hier möglich, einen Großteil der Abwärme zu nutzen. Es fehlt aktuell aber an den Standorten der Rechenzentren an Möglichkeiten der sinnvollen Nutzung der Abwärme. Schaut man sich die großen KI-Supercomputer wie Colossus von xAI mit etwa 150 MW oder aber ein von Meta geplantes Rechenzentrum mit mehr als einem Gigawatt an Leistungsaufnahme an, dürfte es schwer werden hier in direkter Nähe die entsprechenden Abnehmer zu finden.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen