Werbung

Virtual Reality ist eines der Hauptthemen der diesjährigen GPU Technology Conference von NVIDIA. Nach einigen Vorträgen zu Grafik-APIs spielte VR auch eine große Rolle und mit GameWorks VR bzw. VRWorks hat NVIDIA auch die entsprechenden Schnittstellen geschaffen, die es Entwicklern einfacher machen sollen, für VR-Anwendungen zu entwickeln.

Derzeit konzentriert sich noch vieles auf die Anwendungen von VR im Bereich der Spiele. Doch auch in anderen Bereichen sollen VR-Headsets in Zukunft eine immer größere Rolle spielen. Dazu gehören Sportübertragungen, Filme, Übertragungen von Konzerten, virtuelle Reiseangebote und das Retail-Geschäft, bei dem die Produkte in der virtuellen Welt angepriesen werden sollen. Aber auch im professionellen Umfeld wird VR eine immer größere Rolle spielen und diesen Bedarf adressiert NVIDIA beispielsweise über ein VR-Ready-Programm für Workstations und die dazugehörige Hardware in Form der Quadro-Karten.

Einmal mehr sprach NVIDIA auf der GTC 2016 auch über bereits bekannte Technologien. Dazu gehört VR SLI, bei dem jedem Auge eine eigene GPU zugeordnet werden kann, was vor allem die Latenzen für die Ausgabe des Bildes im Hinblick auf die letzten Sensordaten nach unten drückt und damit einen großen Vorteil darstellen kann. Ebenfalls zur Reduzierung von Latenzen und Umgehung bestimmter Mechanismen klassischer Renderingprozesse gedacht ist VR Direct. Hier erfolgt die Ausgabe auf dem VR-Headset ohne den vorherigen Umweg über das Betriebssysteme und entsprechende Frame Buffer. Das Front Buffer Rendering hebt die klassische Buffer-Hirarchie auf und sorgt dafür, dass der Scanout, also die Darstellung auf dem VR-Headset, bereits erfolgt, wenn der Front Buffer eigentlich noch mit dem gerenderten Frame gefüllt wird. Auch hier steht die Reduzierung der Latenzen im Fokus.

[h3]Multi Resolution Shading[/h3]

Auf die bereits bekannten Multi Resolution Shading ging NVIDIA ebenfalls noch einmal etwas genauer ein, sprach aber auch von neuen Anwendungsbereichen für diese Technik. Bevor wir dazu kommen aber noch einmal der technische Hintergrund zu Multi Resolution Shading im Zusammenhang mit VR:

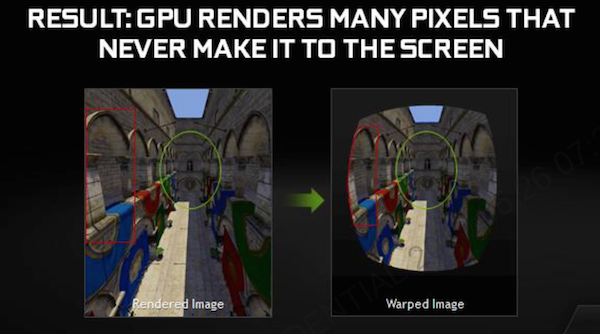

Damit der Nutzer einer VR-Brille überhaupt in der Lage ist auf einer Brille und den darin verbauten Displays etwas zu sehen, wird eine Optik verwendet, die das Bild entsprechend dem Betrachtungsabstand und gewünschtem Blickwinkel anpasst. Die Ausgabe auf dem Display erfolgt daher in einer Fishseye-ähnlichen Verzerrung und zudem wird das Bild an den Rändern noch gestaucht, damit nach der Optik ein für den Nutzer normales und unverzerrtes Bild entsteht. Da GPUs und die Rendering-Prozesse aber nicht darauf ausgelegt sind, ein solches Bild auszugeben, gehen die Hersteller hin und rendern das Bild auf gewöhnliche Art und Weise, um es in einem Post Processing entsprechend anzupassen. Diese nachträgliche Bearbeitung kostet zum einen Leistung, viel entscheidender aber ist, dass eine weitere Verzögerung bis zur Ausgabe des Bildes entsteht und gerade diese ist für ein möglichst optimales VR-Erlebnis störend.

NVIDIA GameWorks VR

NVIDIA wendet nun einen Trick an, um die nicht oder nur eingeschränkt sichtbaren Bereiche anders zu behandeln. Dazu wird das Bild in neun Bereiche aufgeteilt. Diese sogenannten Viewports orientieren sich in etwa an den sonst im Post Processing bearbeiteten Abschnitten. So wird der mit Abstand größte Viewport in der Mitte fast vollständig so belassen, wie er ursprünglich auch behandelt wurde. Die Seitenbereiche und vor allem die vier Ecken aber werden mit einer Art Komprimierung belegt und in ihrer Auflösung entsprechend dem gewünschten Endergebnis angepasst.

Alle neun Viewports werden gleichzeitig durch die GPU berechnet – allerdings getrennt voneinander. Die Ausgabe erfolgt schlussendlich in einer bereits fertig angepassten Form. Ein Post Processing ist damit nicht mehr notwendig. Durch die Aussparung von nicht sichtbaren Bereichen sowie der Anpassung der Auflösung der Ränder und einer zusätzlichen Komprimierung kommt NVIDIA auf eine erhöhte Pixel-Shader-Performance um den Faktor 1,3 bis 2.

[h3]Unterschiedliche Berechnungen für Oculus Rift und HTC Vive - MRS auch für klassische 2D-Darstellung[/h3]

Eine neue Information ist nun, dass es kein einheitliches Multi Resolution Shading, eine keine fixe Aufteilung in die verschiedenen Viewports gibt, denn die Oculus Rift und HTC Vive verwenden unterschiedliche Linsen-Geometrien und sind in dieser Hinsicht nicht identisch aufgebaut, was eine Anpassung notwendig macht. Der Lense Warp ist also für jedes VR-Headset angepasst. Gleiches gilt auch für die Aufteilung der Viewports beim Multi Resolution Shading.

Neben der VR-Anwendung sieht NVIDIA für das Multi Resolution Shading aber auch noch andere Nutzungsszenarien. So könnte ein schneller First Person Shooter bei der Darstellung auf einem klassischen Display davon profitieren, da nur der zentrale Bereich in voller Auflösung berechnet wird. Die Randbereiche hingegen werden per Multi Resolution Shading in einer geringeren Auflösung berechnet. Da der zentrale Bereich bei einem Shooter im Fokus des Betrachters liegt, könnte die geringere Darstellungsqualität in den Randbereichen nicht weiter auffallen. An den Rändern nimmt der Spieler meist nur eine Bewegung war, bevor das Geschehen dann in den zentralen Bereich des aktuellen und zentralen Ausschnitts fällt. Eingeblendete Schriften und das HUD werden erst als Post Processing nach dem Multi Resolution Shading durchgeführt und sind daher davon nicht betroffen.

Ein Leistungsplus von 40 Prozent sieht NVIDIA hier durchaus als machbar an. Allerdings befindet man sich noch in einer Erprobungsphase für diese Technik und ist noch etwas davon entfernt über eine konkrete Umsetzung zu sprechen. In der Maxwell-Architektur sind die Hardwarekomponenten für Multi Resolution Shading aber schon verbaut und dies dürfte auch für die Pascal-Architektur gelten. Noch einen Schritt weiter geht der Gedanke dies mit einem Eyetracking zu koppeln. Hier müssten die Viewports dann im Hinblick auf die aktuelle Blickrichtung des Spielers angepasst werden. Eine dynamische Anpassung der Viewports ist vorgesehen und damit wäre auch dies möglich.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen