Werbung

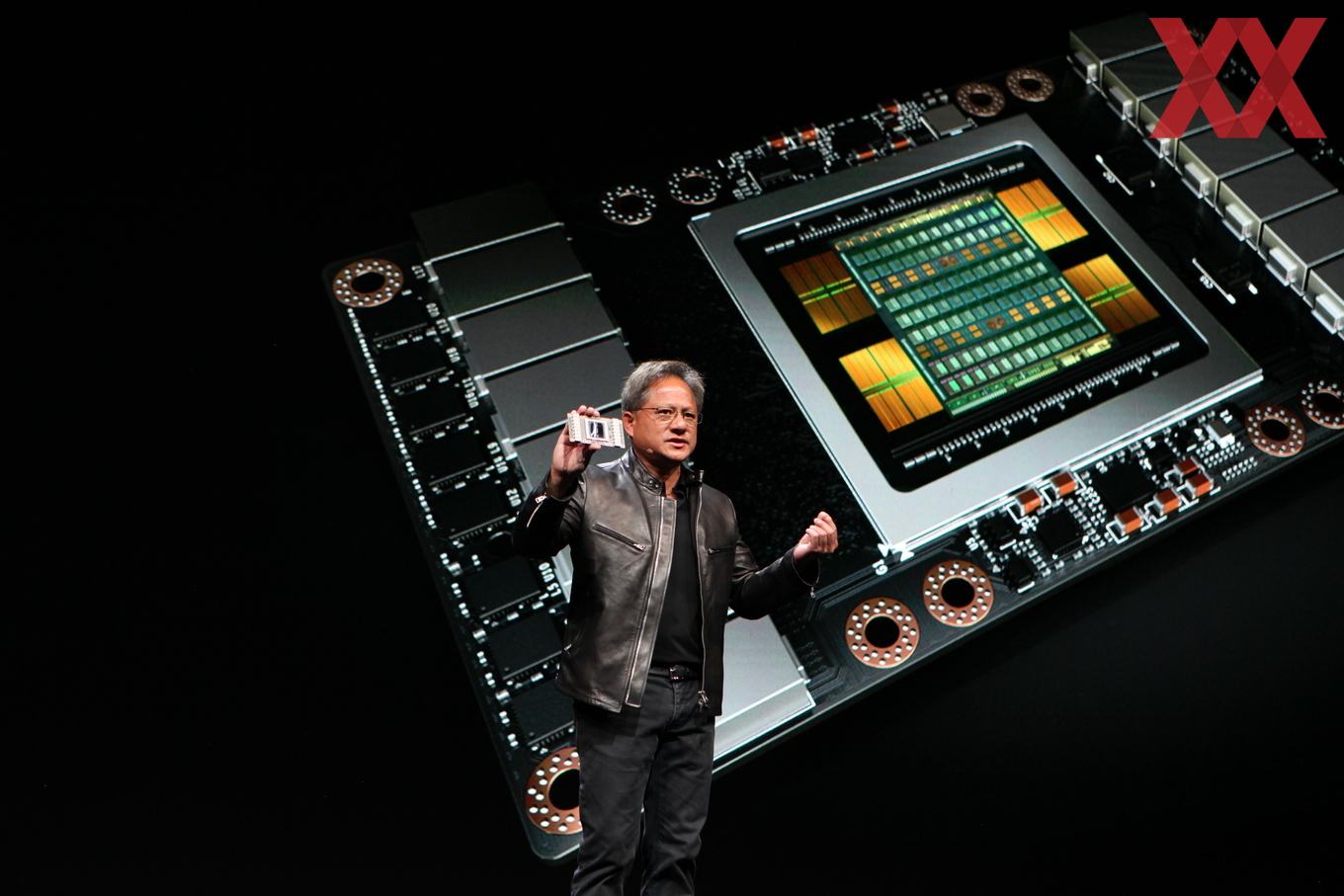

Wenig überraschend hat NVIDIAs CEO Jen-Hsun Huang heute auf der Keynote der GPU Technology Conference 2017 die nächste GPU-Architektur namens Volta vorgestellt. Erstmalig im März 2013 erwähnt, soll die Volta-Architektur die Basis für die zukünftigen Grafik- und Compute-Beschleuniger sein.

Wie im vergangenen Jahr mit der Pascal-Architektur präsentiert NVIDIA die Volta-Architektur zunächst für den HPC-Bereich. Die Tesla V100 ist der erste GPU-Beschleuniger, der die neue Volta-Architektur einsetzt. Die technischen Daten sind beeindruckend:

21 Milliarden Transistoren gefertigt in 12 nm bei TSMC und eine gigantische Chipfläche von 812 mm². 5.120 Shadereinheiten arbeiten auf der GV100-GPU. Über 100 Milliarden einzelne Verbindungen oder Wires sind in der GPU, dem HBM2 und dem Interposer vorhanden.

Die Rechenleistung beläuft sich auf 7,5 TFLOPS für Floating-Point-Berechnungen mit 64 Bit. Bei 32 Bit erreicht die Tesla V100 die doppelte Rechenleistung von 15 TFLOPS und im Deep-Learning-Bereich wichtigen INT8-Berechnungen werden 120 TFLOPS erreicht.

Im Chip selbst befinden sich 20 MB an Register-File-Cache sowie 16 MB an L3-Cache. Bereits angesprochen haben wir den HBM2, der 16 GB an Gesamtkapazität bietet und mit 900 MHz läuft. NVIDIA setzt auf HBM2 aus dem Hause Samsung, den man im Vergleich zur Tesla P100 noch einmal beschleunigen konnte. Die Speicherbandbreite liegt bei 900 GB/s. Das die Speicherkapazität im Vergleich zur Tesla P100 nicht weiter gesteigert werden konnte, liegt vermutlich an der noch immer schlechten Verfügbarkeit von HBM2 – vor allem mit mehr als vier Stacks.

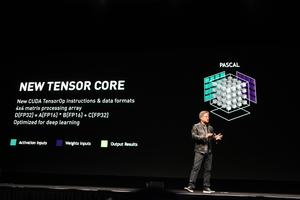

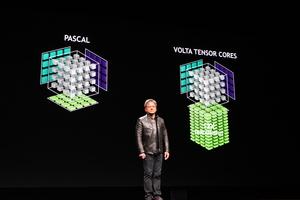

Genauere Details zur Architektur gibt es derzeit noch nicht. NVIDIA hat aber einige Optimierungen vorgenommen, die besonders im Bereich des Deep-Learning eine wichtige Rolle spielen sollen. NVIDIA spricht nur nicht mehr nur von CUDA-Cores, den Shadereinheiten, sondern auch von einem Tensor Core. 640 dieser Tensor Cores sollen sich in der GV100-GPU befinden. Dabei handelt es sich um eine 4x4-Matrix als Recheneinheit, die spezielle Berechnungen deutlich schneller ausführen können soll.

NVIDIA betonte während der Keynote, dass die Volta-Architektur zunächst in der Tesla V100 eingesetzt wird, man die Grafiksparte aber nicht vergessen hat und so wurden auch einige 3D-Anwendungen gezeigt. Darunter war auch ein Live-Rendering von Square Enix.

Volta steht demzufolge auch im GeForce-Markt in den Startlöcher, wenngleich die ersten Tesla V100 GPU-Beschleuniger erst im dritten Quartal ausgeliefert werden sollen. Unklar ist auch, in welcher Form die Volta-Architektur für den Desktop erscheinen wird. HBM2 scheint noch immer recht schlecht verfügbar zu sein, so dass der Endkundenmarkt für NVIDIA womöglich keine Option ist. Mit GDDR6 will SK Hynix ab Anfang 2018 aber den bisher schnellsten DDR-Grafikspeicher liefern können – womöglich mit den dazugehörigen GPUs auf Basis der Volta-Architektur.

| Die technischen Daten der Tesla V100 im Überblick | |||

|---|---|---|---|

| Modell | NVIDIA Tesla P100 | NVIDIA Tesla V100 | |

| Technische Daten | |||

| GPU | GP100 | GV100 | |

| Fertigung | 16 nm | 12 nm | |

| Transistoren | 15,3 Milliarden | 21 Milliarden | |

| Chipgröße | 610 mm² | 815 mm² | |

| GPU-Takt (Base Clock) | 1.328 MHz | - | |

| GPU-Takt (Boost Clock) | 1.480 MHz | 1.455 MHz | |

| Speichertakt | 737 MHz | 878 MHz | |

| Speichertyp | HBM2 | HBM2 | |

| Speichergröße | 16 GB | 16 GB | |

| Speicherinterface | 4.096 Bit | 4.096 Bit Bit | |

| Speicherbandbreite | 720 GB/s | 900 GB/s | |

| Shadereinheiten | 3.584 | 5.120 | |

| Typische Boardpower | 300 W | 300 W | |

NVLink 2.0

Ein schneller Interconnect ist ein wichtiger Bestandteil einer jeden HPC-Hardware. Alle großen Herstellern arbeiten daran ihre Hardware möglichst schnell untereinander und mit externen Komponenten zu verbinden. Mit NVLink präsentierte NVIDIA 2014 auf der GPU Technology Conference seinen eigenen Interconnect.

NVLink basiert auf dem High-Speed Signaling Interconnect (NVHS), eine Entwicklung von NVIDIA. NVLink der ersten Generation stellt in einer NVHS-Verbindung eine Bandbreite von 20 GBit/s und wird über ein Differential Connection ermöglicht. Acht dieser Connections ergeben einen Sub-Link. Zwei Sub-Links stellen wiederum einen Link dar und eben ein solcher Link stellt die Verbindungen zwischen zwei GPUs (GPU-to-GPU oder GPU-to-CPU) sicher. Ein solcher Link hat eine Bandbreite von 40 GB/s in beide Richtungen und für den eigentlichen Datentransfer stehen 97 % dieser Bandbreite zur Verfügung. Damit ist der Overhead sehr gering.

Bei NVLink 2.0 dreht NVIDIA an der Taktschraube. Erste Informationen dazu tauchten bereits im August 2016 im Zusammenhang mit IBMs POWER9-Prozessoren auf. Auch fiel damals schon der Name Volta. Mit Volta beschleunigt NVIDIA NVLink auf 300 GB/s für eine Verbindung von zwei Endpunkten mit der vollen Anzahl an NVLinks. Bisher waren in dieser Form mit NVLink der ersten Generation bis zu 160 GB/s möglich.

Wir werden diese Meldung in den nächsten Stunden noch um weitere Details erweitern, denn NVIDIA will auf der GPU Technology Conference weitere Details bekanntgeben.

Rechenleistung im Vergleich

Zur besseren Übersicht der Rechenleistung haben wir noch eine Tabelle erstellt, in der auch die bald erwarteten Radeon-Instinct-Modelle enthalten sind.

| Rechenleistung von GPU-Beschleunigern im Überblick | |||||

|---|---|---|---|---|---|

| Modell | NVIDIA Tesla P100 | NVIDIA Tesla V100 | AMD Radeon Instinct MI25 | ||

| GPU | GP100 | GV100 | Vega | ||

| FP64 | 5,3 TFLOPS | 7,5 TFLOPS | - | ||

| FP32 | 10,6 TFLOPS | 15 TFLOPS | 12,5 TFLOPs | ||

| FP16 | 21,2 TFLOPS | 30 TFLOPs | - | ||

| IN8 | - | 120 TFLOPs | - | ||

| FP64/FP32-Verhältnis | 1/2 | 1/2 | - | ||

| Speichertyp | HBM2 | GDDR5 | HBM2 | ||

| Speichergröße | 16 GB | 16 GB | 16 GB | ||

| Speicherinterface | 4.096 Bit | 4.096 Bit | - | ||

| Speicherbandbreite | 720 GB/s | 900 GB/s | - | ||

| Shadereinheiten | 3.840 | 5.120 | 4.096 | ||