Werbung

Die Keynote der GPU Technology Conference wurde von NVIDIA dazu genutzt, die neuste GPU-Architektur namens Volta vorzustellen. Mit der Tesla V100 präsentierte man auch gleich das neue Flaggschiff der GPU-Compute-Hardware, nannte aber auch zahlreiche weitere Produkte, in denen Hardware mit Volta-Architektur zum Einsatz kommen und eben auf diese wollen wir nun genauer eingehen. Nach der Keynote gab es einige sogenannte Deep-Dive-Sessions, in denen die Volta-Architektur noch etwas genauer erläutert wurde – dazu hatten wir bereits einen ausführlichen Artikel mit allen Informationen erstellt.

Die neue Hardware auf Basis der Volta-Architektur wollen wir uns nun einmal näher anschauen. Wohlgemerkt handelt es sich dabei ausschließlich um Tesla-Produkte, die sich an die Verwendung im Datacenter richten. Zu den GeForce-Ablegern wollte sich NVIDIA noch nicht äußern, erwähnte aber zumindest, dass die GV100-GPU auch sehr gut für die Ausführung von Renderings geeignet sei. Die GeForce-Karten werden aber sicherlich nicht die GV100-GPU verwenden, sondern vielmehr eine andere Ausbaustufe – ähnlich wie dies bei der Pascal-Architektur schon der Fall war. Die Tensor Cores richten sich ausschließlich an Anwendungen im Deep-Learning-Bereich und wären daher auf den GeForce-Karten unnützer Ballast.

Auf der Keynote erwähnte NVIDIA wie gesagt zumindest die theoretische Möglichkeit, die GV100-GPU als Spielekarte und zeigte außerdem eine entsprechende Demo mit Square Enix.

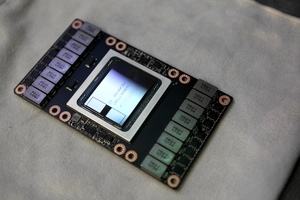

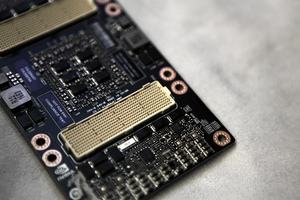

NVIDIA Tesla V100

Zunächst einmal aber zur wohl wichtigsten Hardware-Vorstellung der GPU Technology Conference: Dabei handelt es sich um die Tesla V100. Sie wurde in gleich drei Ausführungen vorgestellt. Zunächst einmal gibt es wieder das typische MXM2-Modul für den Einsatz in Servern mit NVLink. Neu ist vor allem, dass nun NVLink 2.0 mit höherer Bandbreite und einer höheren Anzahl an Links zum Einsatz kommt. Hinzu kommen eine PCI-Express-Variante für das Training sowie eine namensgleiche Tesla V100, die als 150-W-Karte im FHHL-Format für das Inferencing ausgelegt ist.

Allen Tesla V100 gemein sind die technischen Daten, denn sie verwenden alle die gleiche GV100-GPU. Hier zum Einsatz kommen 21 Milliarden Transistoren auf einer Chipfläche von 815 mm². Gefertigt wird der Chip von TSMC im 12-nm-Verfahren. Im Vollausbau kommt die GV100-GPU auf 5.376 Shadereinheiten, im Falle der drei Karten sind aber nur 5.120 Shadereinheiten aktiv. Ebenfalls in allen drei Modellen vorhanden sind die 640 Tensor Cores sowie 16 GB an High Bandwidth Memory der zweiten Generation.

Doch kommen wir nun einmal zu den Unterschieden: Die Tesla V100 wird in drei Varianten angeboten, die sich maßgeblich durch den Verbrauch unterschieden. Die Tesla V100 auf dem MXM2-Modul bietet eine maximale Leistungsaufnahme von 300 W. Die PCI-Express-Version kommt aufgrund der gleichnamigen Spezifikation auf 250 W und taktet die GPU daher etwas niedriger. Der Speicher soll weiterhin mit 878 MHz arbeiten und bietet damit eine Speicherbandbreite von 900 GB/s. Bei der Tesla P100 war dies noch anders, denn hier taktet NVIDIA auch den Speicher im Vergleich zur MXM2-Variante niedriger. Bei der PCI-Express-Version der Tesla V100 soll dies nicht mehr der Fall sein – einzig die Rechenleistung ist aufgrund des leicht niedrigeren Taktes geringer.

Der dritte Ableger der Tesla V100 erinnert etwas an die AMD Radeon R9 Nano. Hier verwendete AMD die Fiji-GPU mit HBM in einem Taktbereich, den man als Sweet Spot bezeichnen kann. Größe und Leistungsfähigkeit der Kühlung gaben sozusagen den Verbrauch vor. Dennoch reichte die Leistung der Radeon R9 Nano recht nahe an die Radeon R9 Fury X heran, denn es kam die gleiche Ausbaustufe der GPU zum Einsatz.

Die Tesla V100 ist explizit für das Inferencing von Deep-Learning-Netzwerken ausgelegt. Sie wird von NVIDIA im FHHL-Format (Full Hight Half Length) angeboten und bietet eine maximale Leistungsaufnahme von 150 W. Mit diesem Verbrauch soll sie laut NVIDIA rund 80 % der Leistung der großen Tesla-V100-Karte erreichen.

Im dritten Quartal 2017 will NVIDIA mit der Auslieferung der Tesla V100 im MXM2-Format beginnen. Zunächst einmal wird man den Supercomputer Summit des Department of Energy (DoE) in den USA bestücken. Ab dem vierten Quartal 2017 sollen die OEMs dann ihre Systeme mit Tesla-V100-Karten bestücken können.

NVIDIA DGX-1 mit Tesla V100

Wie im vergangenen Jahr bietet NVIDIA einen kompletten Server an, der bereits mit bis zu acht Tesla V100 bestückt ist. Der DGX-1 behält seinen Namen und bekommt einfach den Zusatz "mit Tesla V100".

In einem NVIDIA DGX-1 mit Tesla V100 arbeiten acht dieser GPU-Beschleuniger. Die Rechenleistung beläuft sich auf 960 Tensor TFLOPS. Etwas besser vergleichen lassen sich die TFLOPS für 32- und 64-Bit-Berechnungen. Diese belaufen sich auf 60 TFLOPS Double Precision (64 Bit) und 120 TFLOPS bei einfacher Genauigkeit (Single Precision - 32 Bit). Der DGX-1 mit Tesla P100 kommt auf 170 Tensor TFLOPS, 42,4 TFLOPs bei doppelter Genauigkeit und 84,8 TFLOPS bei einfacher. Der NVIDIA DGX-1 mit Tesla V100 ist demnach in Tensor Operationen um den Faktor 5,6, bei FP64 sowie FP32 um den Faktor 1,4 Mal schneller. Maßgeblich sind aber sicherlich die Tensor TFLOPS.

Zur weiteren Ausstattung des DGX-1 gehören zwei 20-Core Intel Xeon E5-2698 v4 mit 2,2 GHz, 512 GB 2.133 MHz DDR4 LRDIMM, 4x 1,92 TB SSD im RAID 0, Dual 10 GbE, bis zu 4 IB EDR und mehrere Netzteile mit zusammen 3.200 W.

Der NVIDIA DGX-1 kann ab sofort direkt bei NVIDIA vorbestellt werden und kostet 149.000 US-Dollar. Da man aber erst im dritten Quartal mit der Auslieferung rechnet, wird dem Käufer zunächst ein DGX-1 mit Tesla P100 geliefert, der dann kostenlos gegen eine Variante mit Tesla V100 ausgetauscht wird.

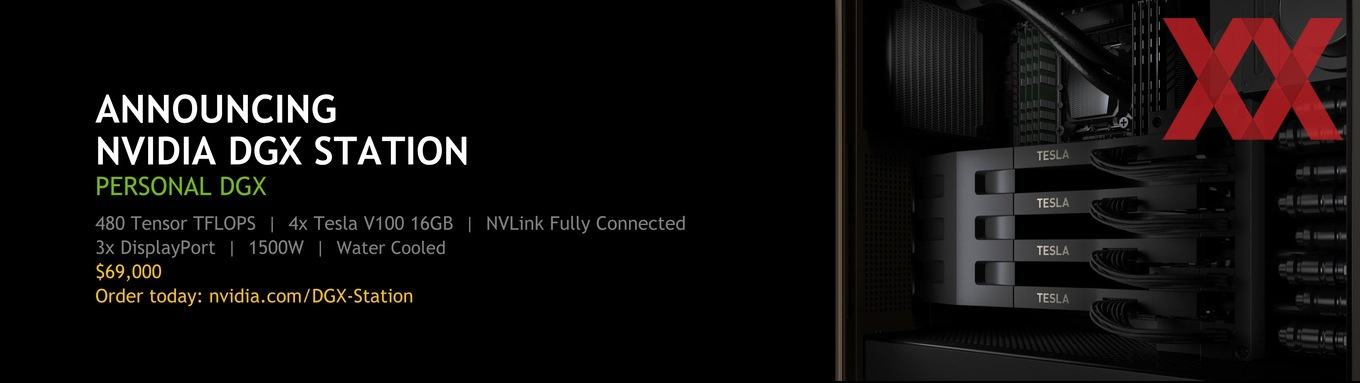

NVIDIA DGX Station

Wer nicht über die richtigen Serverräumlichkeiten verfügt oder nicht gleich die Ausgaben für einen DGX-1 tätigen will, dem bietet NVIDIA nun auch die DGX Station an. Bisher hat man immer gerne auf die GeForce-Produktreihe verwiesen, wenn es um eine kostengünstigere Deep-Learning-Lösung ging. Die DGX Station soll diese Lücke nun schließen.

In der DGX Station arbeiten vier Tesla V100 in der PCI-Express-Variante. Diese sind per NVLink miteinander verbunden. Das komplette System ist wassergekühlt. Neben den vier Tesla V100 kommt hier ein Intel Xeon E5-2698 v4 mit 2,2 GHz zum Einsatz. Hinzu kommen 256 GB LRDIMM DDR4, 3x 1,92 TB SSD im RAID 0 für die Daten und eine weitere 1,92-TB-SSD für das Betriebssystem, Dual 10 Gb LAN und die Möglichkeit, bis zu drei Monitore über DisplayPort anzusteuern.

Die DGX Station kann ebenfalls ab sofort direkt bei NVIDIA vorbestellt werden. Der Preis beträgt 69.000 US-Dollar und die Auslieferung soll im dritten Quartal 2017 beginnen.

NVIDIA HGX-1 mit Tesla V100

Das dritte Angebot im Serverbereich bei NVIDIA umfasst eine Lösung, die dazu ausgelegt ist, in der Cloud zu arbeiten und auf die aus der Ferne zugegriffen wird. Der NVIDIA HGX-1 ist im Grunde genommen eine wassergekühlte Variante des DGX-1 für den Einsatz in der HPC-Cloud.

Der HGX-1 ist nicht für Endkunden direkt verfügbar. Größere Partner wie Amazon, Facebook, Microsoft und Co. können den HGX-1 aber beziehen.

Mit dem HGX-1 will NVIDIA eine schnelle und einfache Lösung für den Zugang zu Deep Learning über die Cloud schaffen. Die NVIDIA GPU Cloud bietet aber nicht nur die Möglichkeit auf der neuesten Hardware zu arbeiten, sondern bietet von der NVIDIA Titan Xp oder GeForce GTX 1080 Ti bis zur Tesla V100 ein breites Angebot.