Werbung

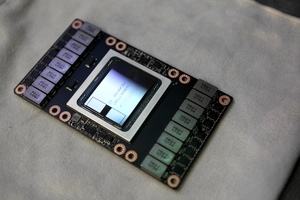

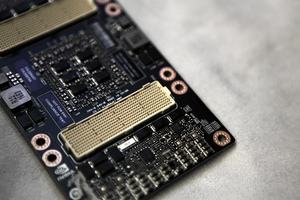

Die auf der GPU Technology Conference 2017 vorgestellte Tesla V100 mit GV100-GPU auf Basis der Volta-Architektur wurde bereits in Form dreier Varianten und davon zwei mit PCI-Express-Interface angekündigt. Nun hat NVIDIA die größere PCI-Express-Variante offiziell vorgestellt und nennt auch einige technische Daten, die bisher unbekannt waren.

Zunächst einmal die Ausgangssituation der drei Modelle: Da wäre das bekannte und typische SXM2-Modul für den Einsatz in Servern mit NVLink. Hinzu kommen die namensgleiche und nun vorgestellte PCI-Express-Variante sowie eine ebenfalls namensgleiche Tesla V100, die als 150-W-Karte im FHHL-Format für das Inferencing ausgelegt ist.

Die große PCI-Express-Variante der Tesla V100 eignet sich für den Einsatz in Servern mit standardisierten Rahmenbedingungen wie Stromverbrauch und Platzbedarf. Daher hält sich NVIDIA hier an die in diesem Bereich üblichen Normen. Die Thermal Design Power sinkt von 300 W des SMX2-Moduls auf 250 W. Damit einher geht auch eine Reduzierung des Taktes und damit auch der theoretischen Rechenleistung. Die PCI-Express-Variante dürfte damit etwa 6 % langsamer sein.

| Die technischen Daten der Tesla V100 im Überblick | |||

|---|---|---|---|

| Modell | Tesla P100 (SMX2) | Tesla V100 (SMX2) | Tesla V100 (PCIe) |

| Technische Daten | |||

| GPU | GP100 | GV100 | GV100 |

| Fertigung | 16 nm | 12 nm | 12 nm |

| Transistoren | 15,3 Milliarden | 21 Milliarden | 21 Milliarden |

| Chipgröße | 610 mm² | 815 mm² | 815 mm |

| GPU-Takt (Base Clock) | 1.328 MHz | - | - |

| GPU-Takt (Boost Clock) | 1.480 MHz | 1.455 MHz | 1.370 MHz |

| Speichertakt | 737 MHz | 878 MHz | 878 MHz |

| Speichertyp | HBM2 | HBM2 | HBM2 |

| Speichergröße | 16 GB | 16 GB | 16 GB |

| Speicherinterface | 4.096 Bit | 4.096 Bit Bit | 4.096 Bit |

| Speicherbandbreite | 720 GB/s | 900 GB/s | 900 GB/s |

| Shadereinheiten | 3.584 | 5.120 | 5.120 |

| Tensor Cores | - | 640 | 640 |

| FP16-Rechenleistung | 21,2 TFLOPS | 30 TFLOPS | 28 TFLOPS |

| FP32-Rechenleistung | 10,6 TFLOPS | 15 TFLOPS | 14 TFLOPS |

| FP64-Rechenleistung | 5,3 TFLOPS | 7,5 TFLOPS | 7 TFLOPPS |

| Int8-Rechenleistung | - | 120 TFLOPS | 112 TFLOPS |

| Typische Boardpower | 300 W | 300 W | 250 W |

Anders als mit der Vorgängergeneration Tesla P100 gibt es offenbar keine kleinere Variante, die noch ein paar Shader weniger verwendet und die auch beim Speicherausbau dementsprechend eingeschränkt wird. Von der Tesla P100 gab es auch eine Variante mit nur 12 anstatt 16 GB HBM2. Da NVIDIA kein solches Modell der Tesla V100 vorstellt, könnte ein Hinweis auf die verbesserte Fertigung sein, die kaum Ausschuss produziert, der sich zweitverwerten lässt.

Die Tesla V100 soll in der PCI-Express-Variante gegen Ende des Jahres erhältlich sein. Der Preis dürfte sich mindestens auf Niveau des Vorgängers bewegen und dieser kostet noch immer etwa 7.000 Euro pro Karte.