Werbung

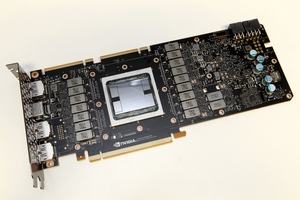

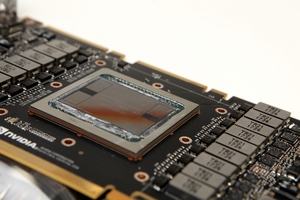

Entwickler sind an TheRegister.co.uk herangetreten und sprechen von Rechenfehlern, die bei wissenschaftlichen Anwendungen auftreten, wenn diese von der NVIDIA Titan V ausgeführt werden. Sogenannte Glitches sind keine Seltenheit, werden durch eine Fehlererkennung meist aber abgefangen, da gerade im wissenschaftlichen Bereich das Vertrauen auf die Korrektheit der Daten entscheidend ist.

Bei der besagten Berechnung soll es sich um die Simulation der Interaktion zwischen Proteinen und Enzymen handeln. Bei mehreren Durchläufen mit gleichen Vorgaben soll es zu unterschiedlichen Ergebnissen gekommen sein. Bei etwa 10 % der Durchläufe soll es zu den Fehlern gekommen sein. Der Test selbst soll derart ausgelegt sein, dass er immer identische Ergebnisse liefern müsste.

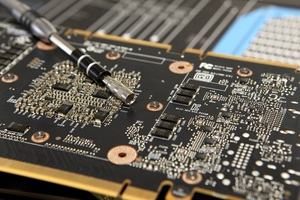

Nun könnte es mehrere Gründe für dieses Verhalten geben. Die Hardware selbst, bzw. die Volta-Architektur wäre eine Möglichkeit, wenngleich dies der kritischste, da schwerwiegendste wäre. Ein Fehler im Treiber, Compiler oder dem Software Framework wäre eine weitere Möglichkeit. Ein Bug in diesem Bereich ließe sich zudem recht einfach beheben.

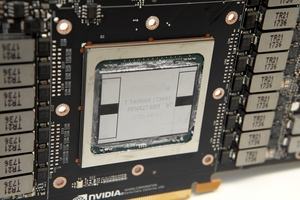

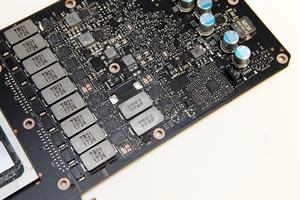

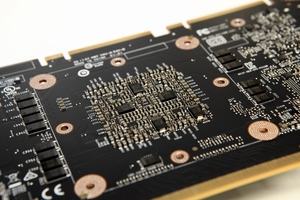

Ein weiterer Grund könnte der High Bandwidth Memory sein. Dieser läuft bei der Titan V mit einem Takt von 850 MHz und erreicht bei verwendeten 3.072 Bit Speicherinterface eine Speicherbandbreite von 652,8 GB/s. Solche Rechenfehler treten gerne auf, wenn es zu Glitches oder einem Bitflip im Speicher kommt. Ohne ECC (Error Correcting Code) können diese Fehler nicht erkannt werden und setzen sich in den Berechnungen fort. Die Titan V kommt ohne aktives ECC, die Datacenter-Varianten Tesla V100 verfügen über ECC und lassen den HBM2 mit bis zu 879 MHz arbeiten.

Es wäre also durchaus möglich, dass der HBM2 Fehler produziert, die bei den Tesla-V100-Varianten durch den ECC erkannt werden, auf der Titan V durch den fehlenden aber nicht. HBM2 verfügt über eine ECC-Unterstützung, diese ist bei den Verwendung auf Consumer-Hardware aber nicht aktiv.

Derzeit sind noch viele Fragezeichen vorhanden. So sind die genauen Gründe für die fehlerhaften Berechnungen, bzw. Varianzen unbekannt. Es gibt zahlreiche Gründe dafür und nicht in jedem Fall ist NVIDIA dafür verantwortlich. Wir haben bei NVIDIA nachgefragt, ob es weitere Erkenntnisse zu diesem Thema gibt. Spätestens auf der GPU Technologies Conference in der kommenden Woche dürfte das Thema noch einmal auf den Tisch kommen.