Werbung

Nicht etwa zur GamesCom nächste Woche, sondern zur aktuell stattfindenden SIGGRAPH im kanadischen Vancouver stellt NVIDIA eine neue GPU-Architektur namens Turing vor und präsentiert auch gleich die erste Hardware. In Anbetracht der Tatsache, dass die Vorstellung auf der SIGGRAPH stattfindet, ist der Fokus auf professionelle, sprich Workstation-Hardware, nicht weiter verwunderlich.

Mit der Ankündigung von NVIDIA RTX und Microsoft DXR will NVIDIA das Ray-Tracing in Echtzeit möglichst bald in die Realität überführen. Auf der Games Developer Conference kündigen NVIDIA, Microsoft und weitere Partner nun eine Umsetzung an, welche ein Echtzeit-Ray-Tracing in Spielen ermöglichen soll. Die NVIDIA Titan V war bislang neben den Tesla-Karten auf Basis der Volta-Architektur die einzige Hardware, welche über eine entsprechende Hardwarebeschleunigung verfügt.

Turing-Architektur mit neuen Tensor Cores

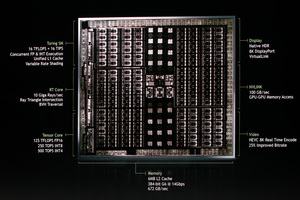

Wichtigster Bestandteil der Turing-Architektur sollen neue Tensor Cores sein. Diese kennen wir bereits von der Volta-Architektur. Mit diesen konnte NVIDIA die Leistung in den für Deep Learning wichtigen FP32-Berechnungen auf 120 TFLOPS steigern. Jeder Tensor Core bietet ein Matrix-Array aus 4 x 4 x 4 Matrizen, welches in einer D = A x B + C Operation durchlaufen wird. Die Eingangs-Matrizen A und B sind FP16-Einheiten, die Akkumulation kann eine FP16- oder FP32-Einheit sein. Diese Tensor Cores sind auch in der Turing-Architektur vorhanden.

Darüber hinaus gibt es neue Tensor Cores. Diese beherrschen nun neben FP16-, INT8- und auch INT4-Berechnungen, die für das Inferencing eine wichtige Rolle spielen. NVIDIA gibt die Rechenleistung der neuen Tensor Cores mit 125 TFLOPS (FP16), 250 TOPS (INT8) und 500 TOPS (INT4) an.

Die RT Cores sind dediziert für die Berechnungen von Sound- und Licht-Rays vorgesehen und verhelfen der Turing-Architektur zu einer um den Faktor 25 gesteigerten Leistung in diesem Bereich. Bis zu 10 Gigarays pro Sekunde können alleine die 576 RT Cores der größten Ausbaustufe verarbeiten. Zudem gibt NVIDIA bekannt, dass die Rasterization-Leistung von Turing gegenüber Pascal um den Faktor drei gesteigert wurde.

Laut NVIDIA misst der große Turing-Chip 754 mm² und ist damit nur geringfügig kleiner, als die GV100-GPU mit 815 mm². Die Anzahl der Transistoren soll bei 18,6 Milliarden liegen, verglichen mit 21,1 Milliarden für die GV100-GPU. Daher ist so gut wie sicher, dass NVIDIA bei TSMC wieder auf die verbesserte Fertigung in 12 nm zurückgreift. Bestätigt ist dies jedoch nicht.

Weitere Details zur Turing-Architektur hat NVIDIA zum aktuellen Zeitpunkt nicht veröffentlicht. Man spricht nur von 10.000 Ingenieurs-Jahren an Arbeit, die in der Turing-Architektur stecken. Damit bewegt man sich auf dem Niveau der Volta-Architektur, die in der Entwicklung zwei Milliarden US-Dollar gekostet haben soll.

Quadro RTX GPUs mit bis zu 48 GB GDDR6

Zur SIGGRAPH stellt NVIDIA auch gleich drei Quadro-Karten vor, welche GPUs mit der neuen Turing-Architektur verwenden.

| Modell | Quadro RTX 8000 | Quadro RTX 6000 | Quadro RTX 5000 |

| UVP | 10.000 US-Dollar | 6.300 US-Dollar | 2.300 US-Dollar |

| Technische Daten | |||

|---|---|---|---|

| GPU-Architektur | Turing | Turing | Turing |

| Shadereinheiten | 4.608 | 4.608 | 3.072 |

| Speicher | 48 GB GDDR6 | 24 GB GDDR6 | 16 GB GDDR6 |

| Tensor Cores | 576 | 576 | 384 |

| Ray-Tracing-Leistung | 10 Gigarays/s | 10 Gigarays/s | 6 Gigarays/s |

Alle Karten verfügen über NVLink 2.0 mit einer Bandbreite von 100 GB/s. Über diese Schnittstelle können jeweils zwei dieser Karten miteinander verbunden werden. Der zur Verfügung stehende Speicher verdoppelt sich dann. Eine Quadro RTX 8000 kann demnach auf 96 GB GDDR6 zurückgreifen und bei der Quadro RTX 6000 und RTX 5000 sind es analog 48 bzw. 32 GB GDDR6.

Ebenfalls allen Karten gemein ist der Einsatz von VirtualLink als Display-Ausgang. VirtualLink soll VR-Headsets über ein Kabel anbinden. Das VirtualLink-Konsortium hat dazu einen eigenen USB-Type-C-Alternate-Modus entwickelt. Dieser verwendet sechs Lanes zur Datenübertragung. Vier sind für ein DisplayPort HBR 3 reserviert. Hinzu kommt ein USB-3.1-Gen-2-Datenlink über zwei weitere Lanes. Daneben wird eine Übertragung von bis zu 27 W ermöglicht, um die VR-Brille zu versorgen.

Die eben erwähnten 27 W Leistung für VirtualLink sind im Leistungsbudget inbegriffen, welches der Quadro RTX 8000 gegeben wird. Dieses soll bei 300 W liegen, so dass etwa 250 bis 270 W Thermal Design Power für diese Karte angenommen werden können. Der GDDR6-Speicher ist bei der Quadro RTX 8000 und Quadro RTX 6000 über ein 384 Bit breites Speicherinterface angebunden. Der Takt des Speichers liegt bei 1.750 MHz, so dass sich eine Speicherbandbreite von 672 GB/s ergibt. Die Quadro RTX 5000 verwendet ein 256 Bit breites Speicherinterface und kommt auf eine Speicherbandbreite von 448 GB/s. Diese Werte sind natürlich geringer als bei Verwendung von HBM2 über ein 3.072 oder gar 4.096 Bit breites Speicherinterface, gegenüber GDDR5(X) sprechen wir aber von einer Steigerung um 30 % bei einem 384 bzw. 256 Bit breiten Speicherinterface.

Eine Quadro RTX 8000 und RTX 6000 soll mit ihren 4.608 Shadereinheiten auf eine Rechenleistung von 16 TFLOPS kommen. Derzeit noch unklar ist, auf welchen Datentypen sich dies bezieht. Die Tesla V100 kommt auf 15,7 TFLOPS bei einfacher Genauigkeit, besitzt aber auch 5.120 Shadereinheiten.

Die verbesserten Tensor Cores sollen eine Rechenleistung von 500 TOPS (INT4) erreichen. Ausgehend davon, dass NVIDIA diese Leistung anhand der bis zu 576 Tensor Cores der Quadro RTX 8000 und 6000 angibt, konnte NVIDIA die Rechenleistung der speziellen Recheneinheiten mehr als vervierfachen – die NVIDIA Tesla V100 kommt mit 640 Tensor Cores auf 125 TOPS, rechnet hier allerdings auch mit INT8-Daten, die doppelt so groß sind.

Weitere Hardwarekomponenten sollen die Quadro-RTX-Server sein. Dabei handelt es sich um Cloudinstanzen, welche die neue Hardware verwenden und auf die Nutzer aus dem Netz heraus zugreifen können. Die Cloudinstanzen sollen flexibel einsetzbar und daher kosteneffektiv sein.

Die neuen Quadro-RTX-Karten und Quadro-RTX-Server werden zum Ende des dritten bzw. Anfang des vierten Quartals erhältlich sein. Einen genauen Termin nennt NVIDIA noch nicht.

Das Zusammenspiel aus Hard- und Software wird immer entscheidender

Neben der Hardware stellt NVIDIA eine Entwicklungsplattform namens RTX vor. Diese stellt die notwendigen Schnittstellen bereit, damit die Software auch von den Hardwarefunktionen (Tensor Cores und RT Cores) Gebrauch machen kann. Im gleichen Atemzug wurde NGX als "NVIDIA technology for bringing artificial intelligence into the graphics pipeline" genannt.

Zu den Softwarepaketen, die RTX bzw. NGX unterstützen sollen, gehören unter anderem Adobe Dimension CC, Autodesk Arnold, Dassault Syste?mes 3DEXPERIENCE CATIA, EA SEED, Epic Games’ Unreal Engine, Otoy OctaneRender und Pixar Renderman.

Eine weitere Neuankündigung ist die MDL-Software. Dabei handelt es sich um ein Open Source Material Definition Language SDK. Das NVIDIA-MDL-SDK ermöglicht die Übertragung von Materialeigenschaften bzw. den dazugehörigen Simulationen über mehrere Anwendungen hinweg. Damit soll es Entwicklern ermöglicht werden, ihre Assets über das initiale Design, bis hin in den Editor der 3D-Engine konsistent zueinander zu verwenden. Epics Unreal Studio 4.20 unterstützt das NVIDIA-MDL-SDK bereits.