Werbung

Im Rahmen der Vorstellung der Tensor-Core-GPU A100 gab NVIDIA ein paar Details zur Ampere-Architektur bekannt. Nun jedoch hat man den Vorhang vollständig fallen lassen, so dass unsere ursprüngliche Analyse um einige Details ergänzt werden kann. Anstatt eines Updates wollen wir das Thema Ampere-Architektur und GA100 aber vollständig neu aufrollen, auch um eventuellen Fehlern, die wir im ursprünglichen Artikel aufgrund der fehlenden Angaben gemacht haben, vorzubeugen.

Die Ampere-Architektur ist NVIDIAs erneuter Ansatz, alle Anforderungen an eine GPU unter einen Hut zu bekommen. Ob dies nur für das Datacenter- oder auch Workstation- und Gaming-Segment gelten wird, bleibt abzuwarten. Die GA100-GPU kommt auf 826 mm². Die Anzahl der Transistoren liegt bei 54 Milliarden.

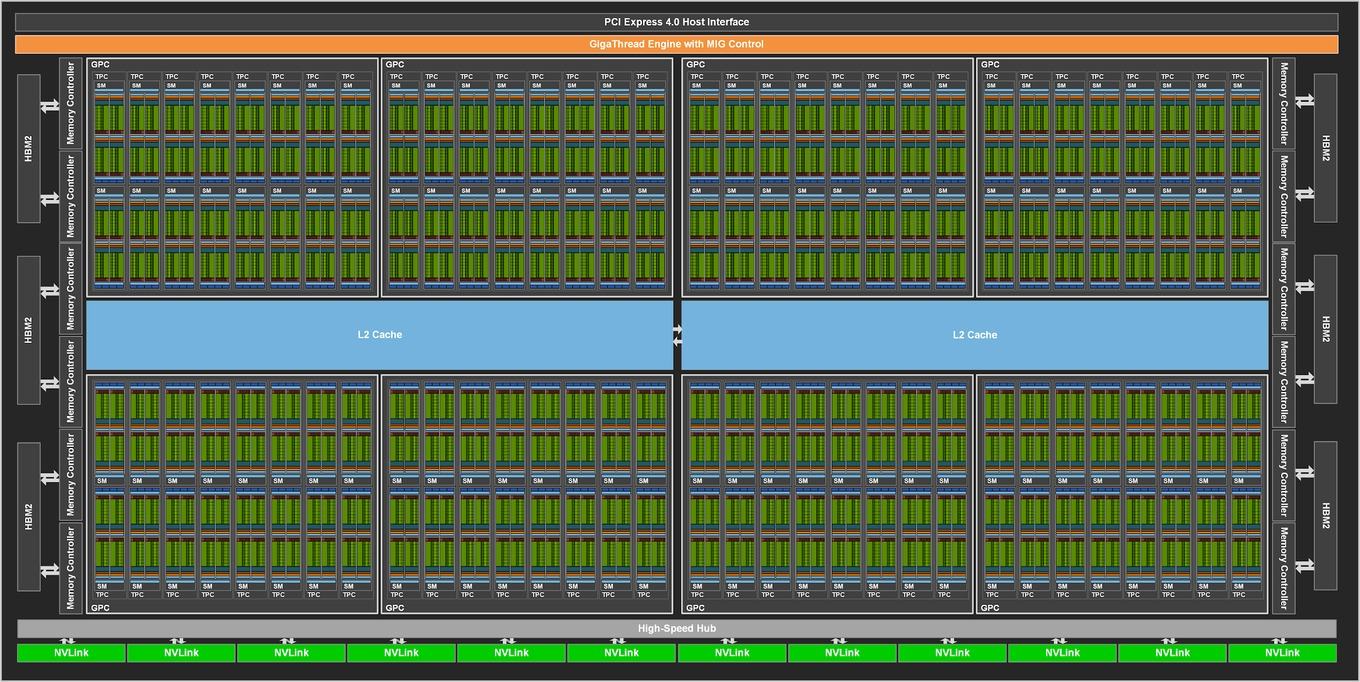

Die vollständige GA100-GPU besteht aus acht GPCs (Graphics Processing Clusters), acht TPCs (Texture Processing Clusters ) pro GPC und zwei SMs (Streaming Multiprocessor) pro TPC bzw. 16 SMs pro GPC, was insgesamt 128 SMs für eine vollständige GA100-GPU ergibt. Bisher vorgestellt hat NVIDIA nur die Tesla A100 mit GA100-GPU, auf der 108 SMs verwendet werden.

Für die Ampere-Architektur sieht NVIDIA weiterhin 64 Shadereinheiten pro SM vor. Somit kommen wir für 128 SMs auf 8.192 Shadereinheiten. Neben 64 FP32-Recheneinheiten pro SM gibt es außerdem 64 INT32-Recheneinheiten pro SM. Hinzu kommen 32 FP64-Recheneinheiten und vier der neuen Tensor Cores der dritten Generation. Einen Vergleich der Rechenleistung zwischen Ampere, Volta und Turing haben wir in der ersten News zum Thema erstellt.

| Voller GA100 | A100 | |

| GPU | GA100 | GA100 |

| SMs | 128 | 108 |

| FP64-Kerne / SM | 32 | 32 |

| FP64-Kerne / GPU | 4.096 | 3.456 |

| FP32-Kerne / SM | 64 | 64 |

| FP32-Kerne / GPU | 8.192 | 6.912 |

| INT32-Kerne / SM | 64 | 64 |

| INT32-Kerne / GPU | 4.096 | 3.456 |

| Tensor-Kerne / SM | 4 | 4 |

| Tensor-Kerne / GPU | 512 | 432 |

| Speicher | 6 HBM2-Stacks 6.144 Bit 1.920 GB/s | 5 HBM2-Stacks 5.120 Bit 1.555 GB/s |

NVIDIA nutzt für die A100-Module also derzeit nur 85 % der GA100-GPU, was weit weniger als beispielsweise bei der GV100-GPU für die Tesla V100 ist, wo 80 von 84 SMs verwendet wurden. Der Grund dürfte die Ausbeute der Chips sein. Einen vollständig funktionsfähigen Chip gibt es in dieser Größe praktisch nicht. NVIDIA muss also Teile deaktivieren.

Dies wirkt sich auf die Anbindung des Speicher aus. Insgesamt verfügt die GA100-GPU über zwölf Speichercontroller. Jeweils zwei davon sind mit einem HBM2-Speicherchip verbunden. Für die Tesla A100 verwendet NVIDIA nur ein 5.120 Bit breites Speicherinterface und demnach nur zehn Speichercontroller – also nur fünf der sechs Speicherchips. Dies passt zur Kapazität von 5x 8 = 40 GB.

Der Takt des HBM2-Speichers liegt bei 1.250 MHz. Für das 5.120 Bit breite Speicherinterface der Tesla A100 ergibt sich eine Speicherbandbreite von 1.555 GB/s. Der Vollausbau käme bei 6.144 Bit und ebenfalls 1.250 MHz auf 1.920 MB/s.

Innerhalb eines SMs gibt es ebenfalls Änderungen. Die Anzahl der FP32- und INT32-Recheneinheiten ist identisch geblieben. Bei den Tensor Cores der dritten Generation gibt es jedoch Neuerungen. So können diese 256 FP16/FP32 Mixed-Precision Fused Multiply-Add (FMA) pro Takt ausführen. Die Tensor Cores der Volta- und Turing-Architektur können 64 dieser FMA pro Takt durchführen, allerdings hat NVIDIA die Anzahl der Tensor Cores halbiert, kann damit aber immer noch die Rechenleistung verdoppeln, die über diese speziellen Einheiten zur Verfügung gestellt werden. Außerdem können die neuen Tensor Cores FP64-Berechnungen ausführen, was die Rechenleistung weiter verbessert.

Auf die Details für TF32 und die dünn-/schwachbesetzten Matrix-Operationen sind wir ebenfalls bereits eingegangen. Diese helfen NVIDIA die Rechenleistung der Ampere-Architektur deutlich zu erhöhen.

Zudem gibt es Änderungen in der Cache-Architektur. So hat NVIDIA die Data- und Instruction-L1-Caches auf 192 kB vergrößert. Dies entspricht einer Steigerung von 50 %. Den L2-Cache hat NVIDIA auf 48 MB (für die GA100-GPU im Vollausbau) vergrößert. Eine GV100-GPU kommt auf 6.144 kB. Die Tesla-A100-GPU verwendet nur 40 MB des L2-Caches. Den großen L2-Cache teilt NVIDIA in zwei Blöcke auf. Jede dieser Partition beinhaltet die Daten der daran angebundenen GPCs. Über die Aufteilung kann NVIDIA die L2-Bandbreite um den Faktor 2,3 erhöhen. Zudem verringern sich darüber die Latenzen.

Zudem gibt es Änderungen in der Cache-Hierarchie, bzw. der Art und Weise wie hier Daten kopiert und abgerufen werden. Asynchrone Befehle lassen bestimmte Abhängigkeiten zwischen einzelnen Komponenten fallen und beschleunigen Zugriffe auf die Caches. So können Asynchronous-Copy-Befehle Daten aus dem Grafikspeicher unter Umgehung des L1-Caches direkt in den Shared Memory laden – die Register müssen dann nicht mehr als Zwischenspeicher dienen. Auch dies reduziert die Latenzen und erhöht die zur Verfügung stehende Bandbreite.

Sind Rückschlüsse auf die GeForce-Ableger möglich?

Die große Frage, die sich nun stellt ist, ob die bisherigen Erkenntnisse zur Ampere-Architektur Rückschlüsse auf mögliche GeForce-Ableger ermöglichen. Dazu müssten wir zunächst einmal wissen, ob die Ampere-Architektur für den Endkundenmarkt vorgesehen ist. NVIDIA hat sich dahingehend noch nicht klar geäußert.

In einem Pre-Briefing machte uns Jen-Hsun Huang keine konkreten Aussagen in dieser Hinsicht. Die Keynote der GTC ist auf Märkte wie HPC, AI und Automotive zugeschnitten.

Halten wir uns an das, was wir wissen: Die Ampere-SMs verfügen weiterhin über 64 FP32- und INT32-Recheneinheiten – wie auch schon in der Turing-Architektur. Insofern ist die reine Shaderleistung in diesem Gebiet vergleichbar. Die gleichzeitige Nutzung von INT32- und FP32-Berechnungen hat die Turing-SMs deutlich beschleunigt, da Spiele in etwa ein Drittel ihrer Berechnungen in INT32 ausführen und die Renderpipeline dahingehend nun besser abgestimmt ist. Die FP64-Recheneinheiten wären für eine GeForce-GPU allerdings weitestgehend überflüssig.

Nehmen wir die TU102-GPU der GeForce RTX 2080 Ti mit ihren 4.352 Shadereinheiten als Referenzwert, so kommt die GA100-GPU, selbst mit nur 108 SMs auf 58 % mehr Shadereinheiten. Man kann also davon sprechen, dass die Rohleistung um 58 % ansteigt. Nun dürfte NVIDIA selbst für die stärkste GeForce-Karte keine Ampere-GPU in dieser Ausbaustufe verwenden. Durch das Plus an SMs und damit den Shadereinheiten wird es aber ein signifikantes Leistungsplus geben. Die SMs der Ampere-Architektur verfügen über jeweils vier Textureinheiten. Über die grundsätzlichen Komponenten für eine Render-Pipeline scheint die Ampere-Architektur also zu verfügen.

Die Rohleistung ist das Eine, eine GPU muss aber auch mit Daten gefüttert werden. NVIDIA hat den L2-Cache für die GA100-GPU in zwei Partitionen aufgeteilt, so dass die Bandbreite hoch und die Latenzen niedrigen bleiben. Der L2-Cache ist unabhängig von den GPCs – genau wie bei Turing. Allerdings ist er nun deutlich größer – genauer gesagt um den Faktor acht. Ob dies in dieser Form für eine GeForce-Karte notwendig ist, können wir allerdings nicht abschätzen. Womöglich ist die Kapazität des L2-Caches, einer der Unterschiede zwischen einer HPC- und Gaming-Auslegung für die Ampere-Architektur.

Ein noch komplett offenes Thema ist die Frage nach dem Vorhandensein der RT Cores. Diese werden für die zukünftigen GeForce-Karten von besonderer Bedeutung sein, denn die RT-Leistung ist einer der Faktoren, die NVIDIA sicherlich weiter verbessern will. Von der vierfachen RT-Leistung ist in den Gerüchten die Rede. Die Blockdiagramme von NVIDIA zeigen zunächst einmal keine RT Cores. Die GA100-GPU scheint also nicht über die speziellen Hardwarebeschleuniger zu verfügen, wohl aber über einige andere Komponenten für eine Render-Pipeline. Es dürfte allerdings unstrittig sein, dass es keine GeForce-Karte auf Basis der GA100-GPU geben wird. Auf das A100-Modul bezogen sagt NVIDIA dazu:

"Because the A100 Tensor Core GPU is designed to be installed in high-performance servers and data center racks to power AI and HPC compute workloads, it does not include display connectors, NVIDIA RT Cores for ray tracing acceleration, or an NVENC encoder."

Eine Tesla-A100- bzw. die A100-Tensor-Core-GPU, wie NVIDIA sie bezeichnet, kann also keinerlei grafische Ausgabe leisten. Virtualisiert natürlich schon, der A100-GPU fehlt es an den Display-Ausgängen und den NVENC-Encoder. Die RT Cores fehlen vollständig.

Der wohl wichtigsten Punkte dürften der verwendete Speicher und das Speicherinterface sein. HBM2 ist im Endkundenbereich zu teuer – sowohl in der Anschaffung, also auch in der Umsetzung. Das Speicherinterface benötigt durch seine größere Breite eine ebenfalls größere physikalische Anbindung in Form der PHYs. Dies kostet Platz und damit Geld. Für die GeForce-Karten dürfte NVIDIA wieder auf GDDR6 setzen. Die kleinere GA10x-Chips werden demnach über ein anderes Speicherinterface verfügen.

Abschließende Einschätzung

Schlussendlich muss man sich eingestehen, dass es kaum möglich ist, aus der gestrigen Präsentation der Ampere-Architektur und der GA100-GPU direkte Rückschlüsse auf mögliche GeForce-Ableger zu ziehen. Die SMs sind bis auf die fehlenden RT Cores grundsätzlich so aufgebaut, dass sie als Basis verwendet werden können.

Die Gerüchten zu möglichen GA10x-GPUs wollen wir nicht weiter kommentieren. Hier jetzt verschiedene, mehr oder weniger sinnvolle GPC- und TPC-Konfigurationen in den Raum zu stellen, würde nicht wirklich weiterhelfen.

Die GA100-GPU bietet viele Komponenten, die es als GeForce-Ableger nicht braucht: HBM-Speicherinterface (stattdessen GDDR6), FP64-Recheneinheiten, einen viel zu großen L2-Cache und die NVLink-PHYs. Auf der anderen Seite lassen sich einige Sachen vermissen: RT Cores und der NVENC-Encoder beispielsweise.

Eine in 7 nm gefertigte GPU mit mehr als 800 mm² und mit HBM2 wäre im GeForce-Segment zudem schlichtweg zu teuer. Auch wenn NVIDIA mit der Ampere-Architektur davon spricht, diese deutlich breiter aufzustellen und damit die verschiedensten Anforderungsbereiche im Datacenter ansprechen zu können, so ist damit eben nicht zwangsläufig das GeForce-Geschäft gemeint. Wir rechnen aktuell in der zweiten Jahreshälfte 2020 mit einem Turing-Nachfolger.