Werbung

Mitte Mai stellte NVIDIA mit dem A100 den ersten GPU-Beschleuniger auf Basis der Ampere-Architektur vor. Die hier verwendete GA100-GPU ist mit 826 mm² und 54 Milliarden Transistoren die größte, die bisher in 7 nm gefertigt wurde. NVIDIA stößt damit gemeinsam mit dem Auftragsfertiger TSMC an die Grenzen des aktuell technisch möglichen.

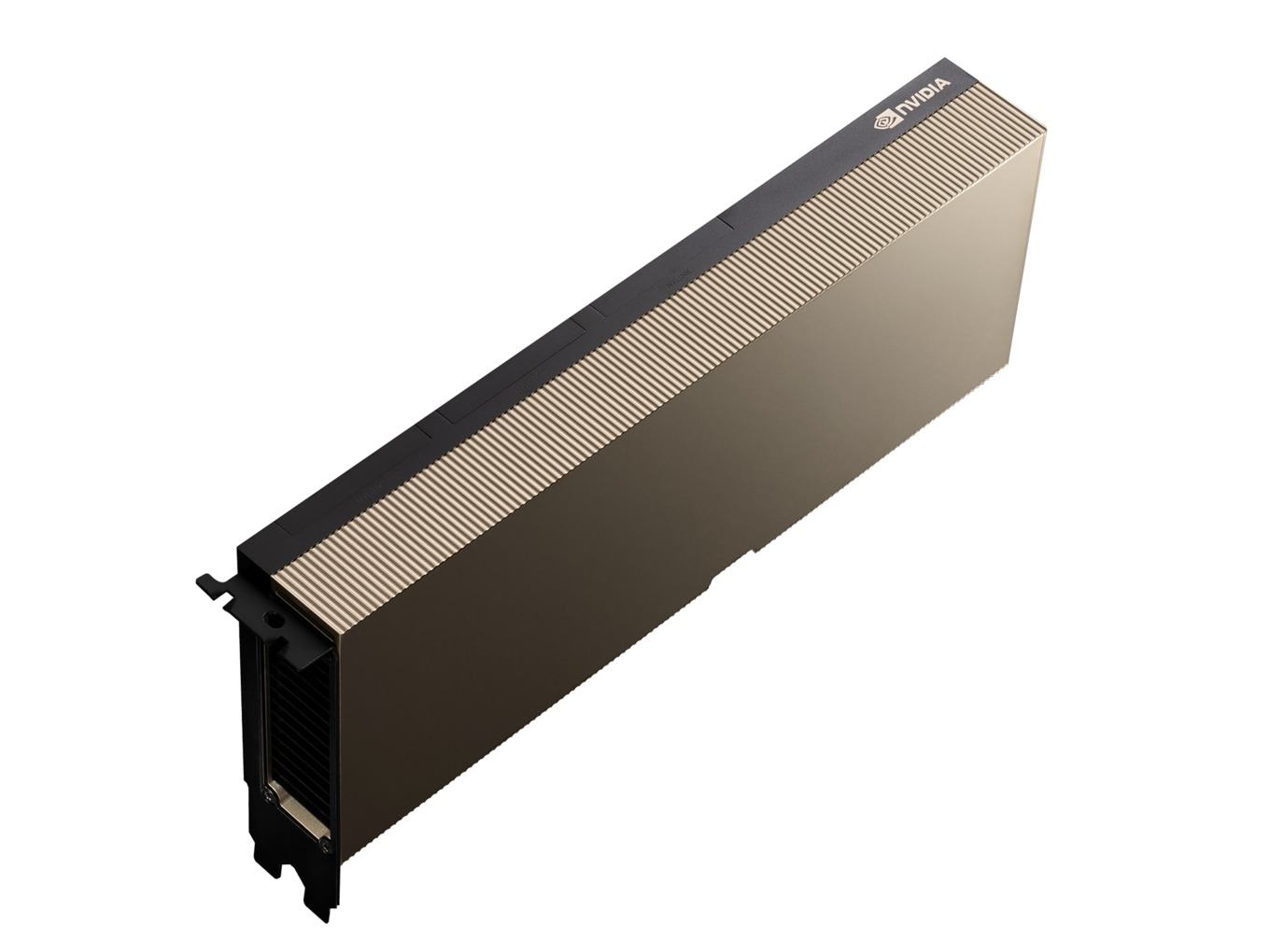

Bisher aber gibt es den A100-Beschleuniger nur in Form der SXM4-Module. Heute kündigt NVIDIA an, die GA100-GPU in Form der A100-PCIe-Karte auch über diesen Weg vertreiben zu wollen. Auf der PCI-Express-Karte kommt die gleich GA100-GPU in der gleichen Ausbaustufe zum Einsatz. Wir sprechen also von 6.912 Shadereinheiten und 432 der neuen Tensor Cores der dritten Generation. Die 40 GB an HBM2 sind über ein 5.120 Bit breites Speicherinterface angebunden. NVIDIA unterscheidet in dieser Hinsicht also nicht zwischen der PCIe- und der SXM4-Variante.

Die A100 PCIe ist der erste GPU-Beschleuniger von NVIDIA, der PCI-Express 4.0 unterstützt. Bei 16 verwendeten Lanes verdoppelt sich die zur Verfügung stehende Bandbreite von rund 15,8 auf 31,5 GB/s. Die höhere Bandbreite ist im Datacenter von besonderer Bedeutung und auch einer der Gründe, warum NVIDIA in größeren Nodes auf den eigenen NVLink setzt. Zugleich deutet die Verwendung von PCI-Express 4.0 bei der A100 PCIe daraufhin, dass auch die GeForce-Ableger der Ampere-Architektur auf den schnelleren Standard setzen werden.

NVIDIA gibt für die A100 PCIe auch die Rechenleistung an, die identisch zur SXM4-Variante ist. Allerdings ist diese für eine Thermal Design Power von 400 W freigegeben, während die PCIe-Variante sich nur 250 W genehmigen kann. NVIDIA begründet die Angaben zur identischen Leistungsaufnahme mit einer identischen Peak-Rechenleistung. Unter Dauerlast soll die Rechenleistung in etwa 10 % niedriger sein – so NVIDIA. Wir halten diese Angaben aber für deutlich zu hoch gegriffen. Eine von 400 auf 250 W reduzierte TDP dürfte einen größeren Einfluss auf die Reduzierung der Rechenleistung haben, wenngleich sich die GA100-GPU bei 250 W im effektiveren Betriebsfenster befinden sollte.

| A100 PCIe | V100S PCIe | Quadro RTX 8000 | |

| GPU | GA100 | GV100 | TU102 |

| SMs | 108 | 80 | 72 |

| FP64-Kerne / SM | 32 | 32 | 2 |

| FP64-Kerne / GPU | 3.456 | 2.560 | 144 |

| FP32-Kerne / SM | 64 | 64 | |

| FP32-Kerne / GPU | 6.912 | 5.120 | |

| Tensor-Kerne / SM | 4 | 8 | 8 |

| Tensor-Kerne / GPU | 432 | 640 | 576 |

| FP64-Rechenleistung | 9,7 TFLOPS | 8,2 TFLOPS | 510 GFLOPS |

| FP64-Rechenleistung Tensor Core | 19,5 TFLOPS | - | - |

| FP32-Rechenleistung | 19,5 TFLOPS | 16,4 TFLOPS | 16,3 TFLOPS |

| TF32-Rechenleistung | 156 / 312 TFLOPS | - | - |

| FP16-Rechenleistung | 78 TFLOPS | 32,8 TFLOPS | 32,6 TFLOPS |

| FP16-Rechenleistung Tensor Core | 312 / 624 TFLOPS | - | - |

| BFLOAT16-Rechenleistung | 39 TFLOPS | - | - |

| BFLOAT16-Rechenleistung Tensor Core | 312 / 624 TFLOPS | - | - |

| INT8-Rechenleistung | 624 / 1.248 TOPS | 130 TOPS | 261 TOPS |

| INT4-Rechenleistung | 1.248 / 2.496 TOPS | 260 TOPS | 522 TOPS |

| Speicher | 40 GB HBM2 5.120 Bit 1.536 GB/s | 32 GB HBM2 4.096 Bit 1.134 GB/s | 48 GB GDDR6 384 Bit 672 GB/s |

| TDP | 250 W | 250 W | 280 W |

| PCIe | 4.0 | 3.0 | 3.0 |

Noch einmal sei angemerkt, dass die von NVIDIA angegebenen Leistungswerte der A100 PCIe sich auf Peak-Werte des GA100-Ausbaus beziehen.

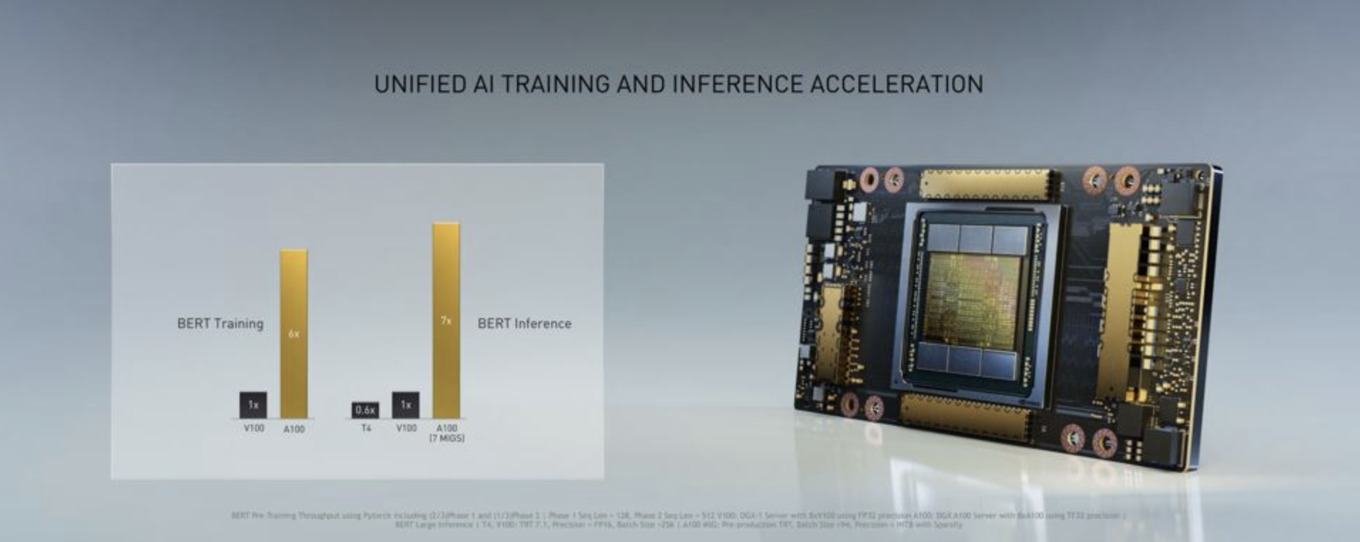

Im Vergleich zum Vorgänger, der Tesla V100, spricht NVIDIA von einer um den Faktor 20 höheren Leistung. Dies führte man so auch für die SXM-Variante Volta vs. Ampere an. In wie weit dies auch Gültigkeit für den Vergleich der PCI-Express-Varianten hat, steht auf einem anderen Blatt.

Die FP32- und FP64-Recheneinheiten steuern die Rechenleistung für hochpräzise Fließkommaberechnungen bei. In den weniger genauen Bereichen aber kommen die Tensor Cores der dritten Generation ins Spiel. Erwartungsgemäß baut NVIDIA die Tensor Cores in ihrer Funktionsweise weiter aus und lässt diese neben INT16 und FP16 als Datensätze mit der bisher höchsten Genauigkeit nun auch FP32- und FP64-Berechnungen durchführen. Damit helfen die Tensor Cores nicht nur die Rechenleistung im AI-Bereich deutlich zu verbessern, sondern unterstützen die Shader nun auch im HPC-Segment, wo höhere Genauigkeit gefordert sind. NVIDIA spricht von einer um den Faktor 20 höheren AI-Rechenleistung für FP32-Berechnungen.

Zusammen mit den Tensor Cores der dritten Generation führt NVIDIA ein neues Gleitkommaformat ein. TF32 oder Tensor Float 32 soll den Wertebereich von FP32 aufweisen, dabei aber nur die Genauigkeit von FP16 verwenden. NVIDIA kombiniert hier also die Vorteile aus FP32 und FP16 und passt diese den Bedürfnissen in bestimmten Bereichen an.

Eine Optimierung in der Nutzung der Tensor Cores bzw. der zur Verfügung stehenden Matrix-Multiplikationen macht die entsprechenden Berechnungen noch effektiver – Sparsity/Sparse Matrix oder die dünnbesetzte/schwachbesetzte Matrix. Besteht eine Matrix aus sehr vielen mit Nullen besetzten Einträgen, können über verschiedene Techniken diese Bereiche in der Berechnung und Speicherung effizienter genutzt werden. Bei aktivierter Structural Sparsity verdoppelt sich die Rechenleistung daher theoretisch (siehe die Angaben in der Tabelle).

Auch die A100 PCIe verfügt über den schnellen NVLink-Interconnect. In der PCI-Express-Variante können aber nur zwei dieser Karten zusammengeschaltet werden, während es in der SXM4-Variante bis zu acht sind. Per NVSwitch verbunden werden können alle acht dieser GPUs. Bei der PCI-Express-Karte sollen die beiden GPUs per NVLink mit 600 GB/s über 12 NVLinks zu je 50 GB/s verbunden sein. Dazu stehen drei NVLink-Schnittstellen an der Oberseite der Karte zur Verfügung.

Bei einer TDP von 250 W ist eine zusätzliche Stromversorgung erforderlich. Die Bilder der Karte zeigen diese nicht, 2x 8-Pin oder 1x 8-Pin + 1x 6-Pin dürften aber vorhanden sein. Zudem verfügt die Karte nicht über einen eigenen Lüfter – wird also über den im Server vorhandenen Luftstrom gekühlt. Display-Ausgänge sind an der A100-PCIe nicht vorhanden.

Multi Instance GPU ist mit dabei

Die A100 PCIe unterstützt genau wie die SXM4-Variante das Multi Instance GPU (MIG). MIG ermöglicht es die zur Verfügung stehenden Ressourcen in sieben unabhängige Instanzen zu verwandeln. Aus der GA100-GPU werden sozusagen sieben eigenständige, kleinere GPUs. Diesen sieben virtuelle GPUs können eigenen Ressourcen in Form von Speicherbandbreite, Caches, etc. zugeteilt werden. Letztendlich ist eine GA100-GPU in der Lage sieben Tesla T4 zu ersetzen.

Die MIG-Technik ist laut NVIDIA einer der Schlüssel, um aus einer aufgrund der Größe und Komplexität recht unflexiblen GPU eine solche für ein Elastic Datacenter zu machen, in dem sie für die verschiedensten Anwendungsbereiche genutzt werden kann. Die bisherige Technologie namens Virtual GPU (vGPU) benötigte mehrere Software-Ebenen (Hypervisor und die Virtualisierungssoftware), um einen ähnlichen Effekt zu erzielen. MIG virtualisiert die GPU aber schon deutlich näher zur Hardwareebene und macht diese Funktion daher deutlich effektiver – durch die fehlenden Abstraktionsschichten weniger verlustbehaftet.

Wir wollen noch einmal ein paar Worte zur Rechenleistung der A100 PCIe verlieren. Laut Angaben von NVIDIA sind diese im Peak-Bereich identisch zur SXM4-Variante, auf Dauer aber etwa 10 % niedriger. Allerdings haben auch die verwendeten Daten bzw. deren Größe einen Einfluss. Der A100 PCIe stehen 40 GB an HBM2 zur Verfügung. Zwei Karten können somit auf einen insgesamt 80 GB großen Speicher zurückgreifen. Für Deep-Learning-Netzwerke und anderen Anwendungen die weitaus mehr Platz belegen, spricht NVIDIA von einer um 50 % reduzierten Rechenleistung. Vier A100 PCIe (jeweils zwei per NVLink miteinander verbunden) haben also bei weitem nicht die Leistung eines DGX-Systems mit vier A100 SXM4-GPUs.

NVIDIA nennt keinen Preis der A100 PCIe. Die Tesla V100 mit 16 GB HBM2 kostet allerdings bereits 7.990 Euro und die Variante mit 32 GB fast 10.000 Euro. Die A100 PCIe wird vorerst nur über OEMs und ODMs verfügbar sein.

Zur Ampere-Architektur haben wir bereits einige Berichte online gebracht: