Werbung

NVIDIA hat eine Reihe von Ankündigungen zur ISC High Performance und dem eigentlich ebenfalls ab heute geplanten Mobile World Congress zu machen, die über die kommenden Tage in virtueller Form stattfinden werden. Einer der Bereiche, auf den sich NVIDIA zum MWC fokussiert hat, ist AI-on-5G. Viele an der 5G-Infrastruktur beteiligten Unternehmen sehen zukünftig eine tiefere Integration einer höheren Rechenleistung nahe finalen Netzwerkknoten vor. NVIDIA stellt daher mit der Aerial A100 einen kompakten Server vor, der aus einem Host-Prozessor, einem A100 GPU-Beschleuniger und einer BlueField-DPU besteht. Auf etwa 450 W kommt ein solches System.

Zukünftig will NVIDIA solche Systeme auf die nächste Generation der BlueField-DPUs umstellen, die dann gemeinsam mit einem GPU-Beschleuniger arbeiten. Die ARM-Kerne zukünftiger DPU-Lösungen von NVIDIA machen einen Host-Prozessor überflüssig. Für die weitere Zukunft sieht NVIDIA eine weitere, noch engere Verzahnung der beteiligten Hardware-Komponenten vor.

Als Erweiterung der Produktpalette stellt NVIDIA die PCI-Express-Variante des A100-GPU-Beschleunigers nun mit doppeltem Speicher vor. Bisher war dieses Modell mit 40 GB erhältlich, nun sind es 80 GB. Die SXM4-Variante wird bereits seit einiger Zeit mit 80 GB angeboten. Durch den Einsatz von HBM2E steigt aber nicht nur die Kapazität, sondern auch die Speicherbandbreite. Sind es bei der Variante mit 40 GB 1.555 GB/s, kommt das Modell mit 80 GB nun auf 2.039 GB/s. Die Thermal Design Power der PCIe-Variante liegt bei 250 W, während die SXM4-Modelle sich bis zu 400 W genehmigen können.

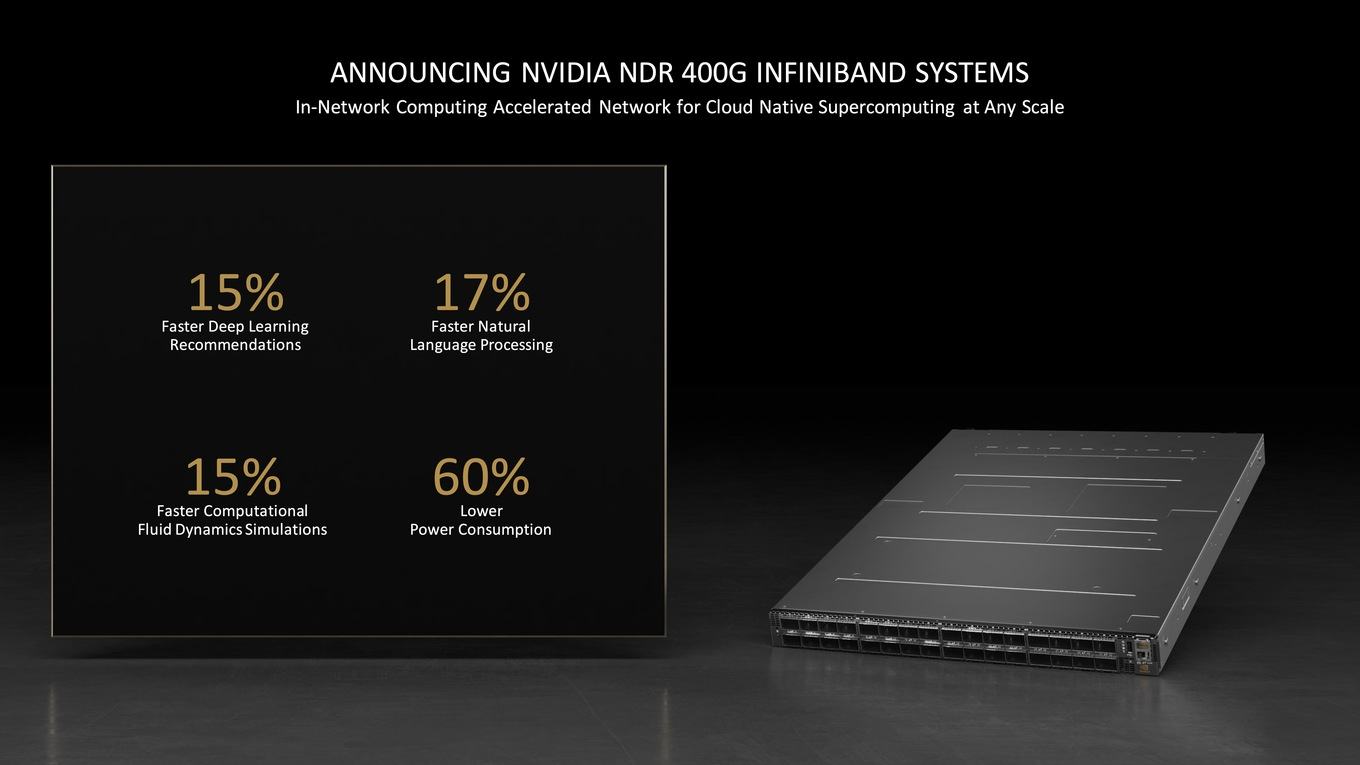

Zuletzt verweist NVIDIA im Rahmen der Präsentation noch darauf, dass eine möglichst schnelle Netzwerkanbindung immer wichtiger wird. Durch den Kauf von Mellanox hat sich NVIDIA die dazugehörige Expertise einverleibt. Immer schnellere Netzwerkswitches mit bis zu 64 NDR-Ports (400 GBit/s InfiniBand) für zwei Höheneinheiten solle dabei helfen, die Netzwerk-Infrastruktur besser skalieren zu können. Für ein einzelnes Rack, voll bestückt mit solchen Switches, spricht NVIDIA von 1.024 NDR-400G-Ports. Zwei Racks nebeneinander kommen dementsprechend auf 2.048 Ports.

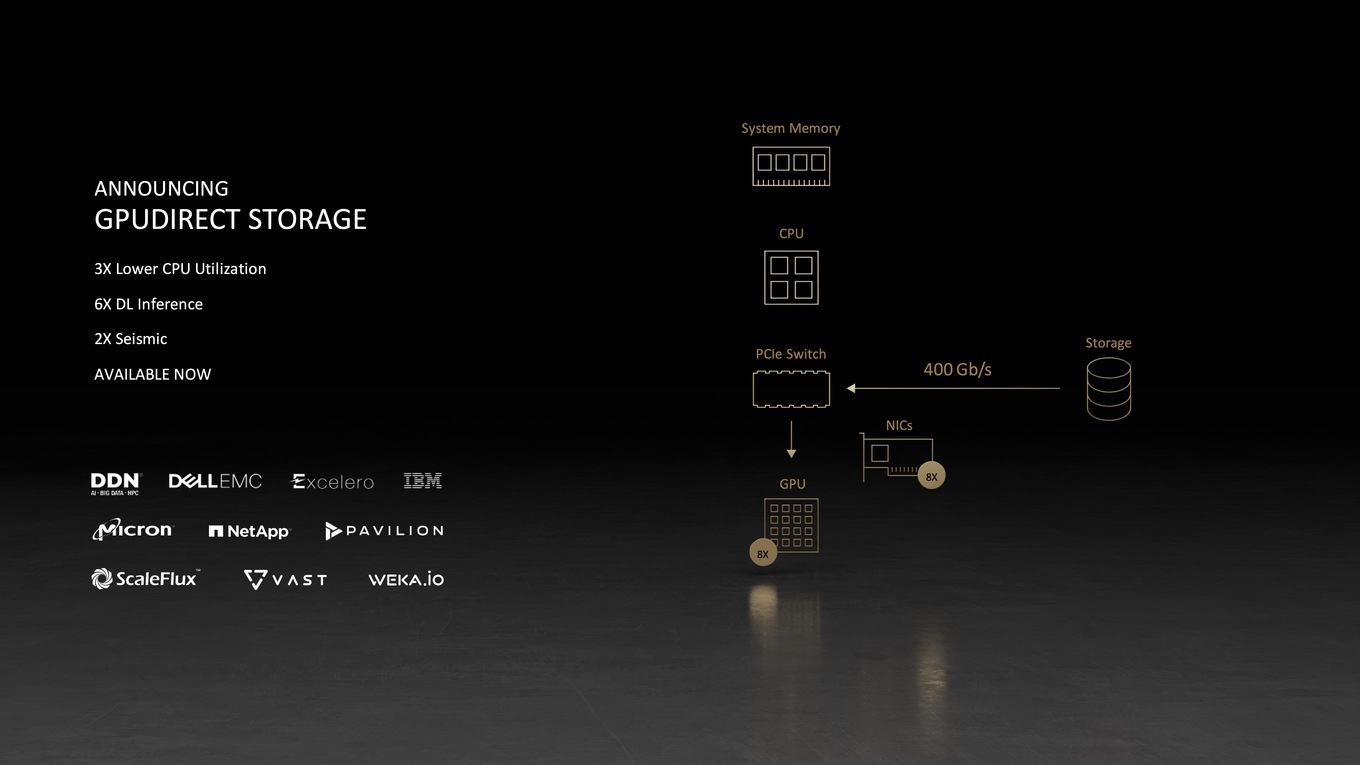

In diesem Zusammenhang bringt NVIDIA die Funktion GPUDirect Storage in den Produktiveinsatz. Vorgestellt wurde die Technik zum Speicherzugriff ohne Umwege bereits Mitte 2019. Anstatt den Umweg über den Host-Prozessor zu machen, sollen Daten von einem im Netzwerk verfügbaren Speicher direkt zu den GPU-Beschleunigern übertragen werden. Im Endkundenbereich wird diese Funktion als DirectStorage umgesetzt und bietet den direkten Zugriff der GPU auf den NVMe-Speicher.

Im Rahmen der ISC High Performance 2021 wird es zahlreiche Supercomputer in den Top20 geben, die auf GPU-Beschleuniger von NVIDIA setzen. Statt klassischer FP64-Rechenleistung benötigen viele Anwendungen diesen hohen Grad der Genauigkeit gar nicht und sind auf die Höchstleistung im Bereich von INT16 oder gar INT8 ausgelegt. An dieser Stelle bietet NVIDIA mit den A100-GPU-Beschleunigern auch eine Hardware, die von FP64 bis INT8 alle Genauigkeiten bedienen kann. Der Elektroautohersteller Tesla betreibt beispielsweise gleich mehrere Cluster, von denen die dritte und aktuellste Ausbaustufe es durchaus in den Top10 der Supercomputer schaffen würde.