Werbung

Am vergangenen Freitag löste NVIDIA mit seiner neuen G-Sync-Technologie ein Jahrzehnte lang existierendes Problem, das immer wieder zu Tearing, Rucklern und langsamen Reaktionszeiten bei der Bildausgabe auf den Bildschirm führte. Zwar hat man in den letzten Jahren Grafik, Performance und damit das Spielerlebnis kräftig nach oben geschraubt, doch die lang existierenden Probleme, die bei vielen Gamern das Erlebnis wieder etwas gemindert haben dürfte, hat man bislang nicht aus der Welt geschafft. Um zu verstehen, wie NVIDIA die Probleme von Tearing und Rucklern lösen konnte, muss man erst einmal deren Ursachen erkunden.

Aus alten Relikten ist heute die Bildwiederholungsrate von Monitoren, also die Anzahl der Einzelbilder, die pro Sekunde auf einen Monitor gezeichnet werden kann, meist fest auf 60, 120 oder 144 Hz gestellt. Grafikkarten rendern die Bilder allerdings mit ständig wechselnden Bildfrequenzen, die dann mit dem Monitor immer wieder abgeglichen werden müssen. Hat man die Bildwiederholrate auf 60 Hz gestellt, dann sollte die Grafikkarte im Optimalfall eine Bildrate von 60 FPS an den Monitor liefern, damit Bildausgabe und Bildzeichnung synchron verlaufen können. In der Praxis ist das aber selten der Fall, da jede Spielszene unterschiedliche Anforderungen bei der Berechnung an die Grafikkarte stellt und deren Performance damit unterschiedlich ausfällt.

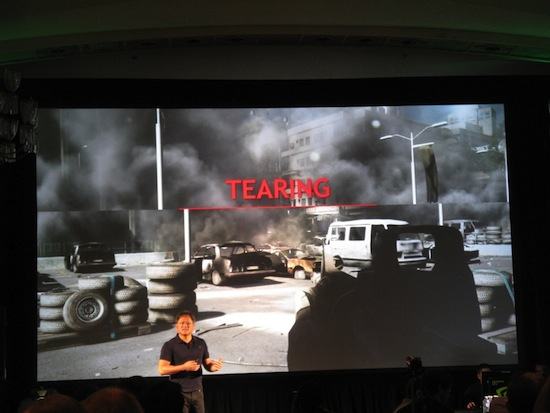

Liefert die Grafikkarte mehr Bilder an den Monitor als dieser verarbeiten kann, kommt es zum störenden Tearing-Effekt. Ein neues Frame wird an den Monitor geschickt, obwohl das aktuell zu zeichnende Bild noch nicht fertig angezeigt wurde. Die Folge ist eine Bildausgabe mit einer horizontalen Teilung. Das obere Bild ist das ältere, das untere hingegen schon das neue bzw. nächste. Das Bild wirkt „zerrissen“.

Tearing lässt sich durch den Einsatz von V-Sync verhindern. Ist die vertikale Synchronisation aktiviert, wird die Aktualisierung der Bilddaten verhindert, während der Bildschirm das Frame noch aufbaut. Erst wenn die Übertragung eines kompletten Bildes beendet ist, wird zum nächsten gewechselt. Bei eingeschalteter V-Sync werden damit nur komplette Bilder übertragen. Fällt jedoch die Performance unterhalb der Bildwiederholfrequenz des Monitors, werden Bilder doppelt dargestellt – das Spiel ruckelt.

Spieler standen also bislang vor der Wahl, V-Sync zu deaktivieren, dafür schnelle Input-Response-Zeiten, aber zerrissene Bilder zu haben, oder aber V-Sync zu aktiveren mit möglichen Rucklern. Tearing, Lags und Stutter lassen sich softwareseitig nicht beheben, vielmehr muss die Hardware angepasst werden.

Monitor richtet sich nach der Grafikkarte

Das hat NVIDIA mit G-Sync nun getan. Die Lösung des Problems ist eigentlich ganz simpel: Eine variable Refresh-Rate. Die Bildwiederholraten des Monitors werden mit den Bildfrequenzen der Grafikkarte synchronisiert. Die Grafikkarte soll sich nicht mehr nach dem Monitor richten, sondern umgekehrt. Sinkt die Framerate der Grafikkarte, wird automatisch die Widerholrate des Monitors auf das gleiche Level abgesenkt, so dass immer nur komplette Bilder ausgegeben werden und so Tearing und Ruckler verhindert und die Reaktionszeit verbessert werden.

In Montreal zeigten die Kalifornier G-Sync in Aktion – im Direktvergleich mit einem normalen Monitor und wahlweise mit oder deaktiviertem V-Sync. Die Unterschiede zwischen den beiden Systemen waren bemerkenswert – gezeigt wurden die Effekte nicht nur in einer NVIDIA-eigenen Demo, sondern auch in Tomb Raider. Das Spielerlebnis verbessert sich durch G-Sync nach unserem Empfinden tatsächlich um Welten. Allerdings sollte man sich von G-Sync live ein Bild machen, denn aufgrund der unterschiedlichen Bildwiederholfrequenzen aktueller Foto- und Videokameras lassen sich die Effekte nicht in Bewegtbild optimal wiedergeben.

{jphoto image=45195}

Der Erfolg von G-Sync hängt allein davon ab, wie viele Monitor-Hersteller die neuen Module verbauen und ob NVIDIA diese auch an andere Hersteller weitergibt. Zwar haben mit ASUS, BenQ, Philips und Viewsonic die ersten Hersteller entsprechende Geräte für das erste Quartal 2014 angekündigt, doch benötigt man dafür auch eine NVIDIA-Grafikkarte der „Kepler“-Generation ab der GeForce GTX 650 Ti Boost. Andere Monitore lassen sich mit einem separat erhältlichen Upgrade-Kit nachrüsten.