Werbung

Ob für schnelle Datenverbindungen zwischen Rechenzentren oder im Datacenter-Segment: Die Netzwerke, welche solche Systeme untereinander und miteinander verbinden, müssen immer mehr Daten bewältigen. Inzwischen ist es daher nicht unüblich, dass in Knoten von Supercomputern eigene Interconnects verwendet werden (Infinity Fabric oder NVLink), um beispielsweise GPGPU-Beschleuniger schnellstmöglich an die Prozessoren anzubinden. Für die Verbindung zwischen den Knoten kommen dann Lösungen wie der Slingshot-Interconnect von Cray oder InifiBand von Mellanox zum Einsatz.

Doch für solche Verbindungen forscht Intel seit Jahren an einem Mix aus Glasfaserübertragung und Verarbeitung der Signale in Halbleiterbauelementen: Dem Silicon Photonics Link. Inzwischen bietet Intel hier schon Hardware an, die in Netzwerken eingesetzt wird. Aber natürlich soll die Entwicklung weiter vorangetrieben werden, um immer höhere Datenraten zu erreichen.

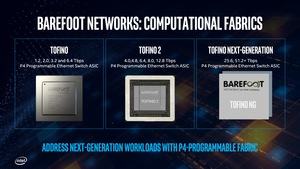

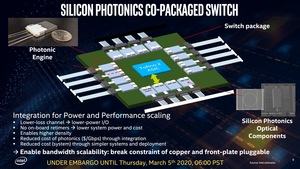

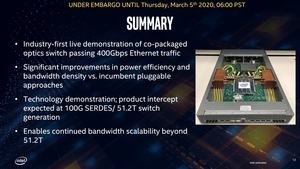

Nun hat Intel einen Ethernet-Switch gezeigt, der einen Barefoot Tofino 2 Switch mit dazugehörigem ASIC mit sogenannten Silicon Photonics Engines koppelt, die jeweils bis zu 1,6 TBit/s übertragen können. Der Switch ist damit in der Lage einen Gesamtdatendurchsatz von 12,8 TBit/s zu verarbeiten. Aktuell stellen diese 12,8 TBit/s das Maximum dar, was ein Tofino 2 verarbeiten kann. Man arbeitet aber bereits an Systemen, die 25,6 oder gar 51,2 TBit/s an Durchsatz verarbeiten können.

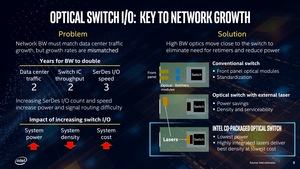

Die Verwendung von Silicon Photonics Link in Netzwerken hat weitere Vorteile, als nur die geringeren Latenzen und hohen Durchsatzraten durch die direkte Kopplung von Datenübertragung und Datenverarbeitung. Auch der Stromverbrauch und die Kosten können durch eine Integration deutlich reduziert werden. Dies verwundert auch nicht weiter, schaut man sich bestehende Systeme wie InfiniBand and Slingshot an, deren Switch-Hardware teilweise mit einer Wasserkühlung versehen werden müssen.

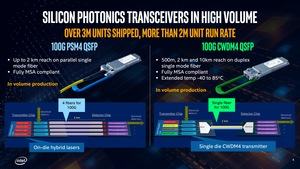

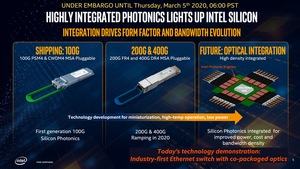

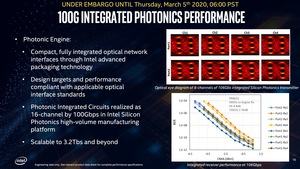

Derzeit erreichen Silicon-Photonics-Verbindungen Durchsatzraten von 200 und 400 GBit/s – auf einer Strecke von maximal 2 km. In einem weiteren Schritt soll die Bandbreite einzelner Verbindungen auf 1,6 TBit/s gesteigert werden. Aktuell werden dazu vier 400GBase-DR4 Interfaces zusammengeführt. Um auf aktuell 400 GBit/s zu kommen, wird der Datenstrom in mehrere getrennte Wellenlängen umgewandelt, per Mux zusammengeführt und per DMUX wieder aufgeschlüsselt. Die Anzahl der einzelnen Wellenlängen, die zur Übertragung genutzt werden, soll aber weiter gesteigert werden, so dass sich die Datenübertragungsrate weiter drastisch steigern lässt.

Die ASICs, welche dann letztendlich das Switching übernehmen, sind aktuell der limitierende Faktor. Aber auch hier hat Barefoot Networks bereits die nächste Generation der Tofino-ASICs auf der Roadmap, die 25,6 und 51,2 TBit/s an Daten verarbeiten können sollen.