Werbung

Die Keynote der GPU Technologies Conference in China enthielt einige interessante Details zu Technologien, an denen NVIDIA aktuell arbeitet. Um die Rechenleistung der eigenen HPC-Chips weiter steigern zu können, wird es notwendig sein, dass die Netzwerk- oder besser Interconnect-Verbindungen schneller werden.

Aktuell sieht NVIDIA bereits ein Missverhältnis zwischen dem Senden und Empfangen der Daten zur eigentlichen Berechnung – das Handling der Datenmengen nimmt einen essentiellen Anteil am Verbrauch und der Hardware selbst ein. Dies gilt zum Beispiel für die Serializer/Deserializer (SerDes) für den NVLink-Interconnect. Mit NVLink 2.0 und den dazugehörigen NVSwitch können diese zwar 18 Links mit zusammengenommen 7,2 TBit/s verarbeiten, sind mit zwei Milliarden Transistoren jedoch sehr komplex. Auf Seiten der GPUs müssen diese Interfaces natürlich auch umgesetzt werden – verbrauchen Chipfläche und Energie. Optische Verbindungen sollen in einem nächsten Schritt die Effizienz verbessern und die Übertragungskapazitäten deutlich erhöhen.

Interessanterweise sprach Intel auf dem Lab Day 2020 vor wenigen Tagen ebenfalls über optische Übertragungstechniken. Möglich wird dies durch immer weiter verbesserte Packaging-Technologien – Integrated Silicon Photonics. Intel hat bereits Transmitter und Receiver in Halbleitern entwickelt, welche die notwendigen Wellenlängen erzeugen und erkennen. Modulatoren und weitere notwendige Komponenten können immer kompakter integriert werden. Intel spricht hier von mehreren hundert pro Package. Auch optische Verstärker kann man inzwischen in Halbleiterchips fertigen. Somit sieht man sich fast an der Schwelle, Integrated Silicon Photonics in marktreife Produkte einzuführen.

NVIDIA arbeitet ebenfalls an optischen Übertragungstechnologien für NVLink. Während NVLink 2.0 etwa 8 pJ/B (Pico Joule pro Bit) verbraucht und sich nur bis zu 0,3 m übertragen lässt (ohne Repeater), soll eine optische Verbindung nur die Hälfte an Energie verbrauchen (4 pJ/B) und längere Übertragungen ermöglichen. Von 20 bis 100 m spricht NVIDIA hier.

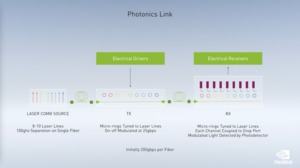

Auf dem Konzept für eine Optical DGX Station sind jeweils vier GPUs pro vertikaler Erweiterungskarte zu sehen. Der Interconnect zwischen allen GPUs findet hier auf Basis einer optischen Verbindung statt. Dahinter sind die Lichtquellen abgebildet, welche Wellenlängen zur Übertragung bereitstellen. Acht bis zehn Wellenlängen soll die Laserquelle (Laser Comb Source) zur Verfügung stellen. Auf diese werden die Signale anfangs mit 25 GBit/s pro Wellenlänge aufmoduliert (über Ring-Resonatoren), so dass diese Verbindung eine Gesamtdatenrate von mindestens 200 GBit/s bietet – also dort beginnt, wo für NVLink 2.0 vermutlich das Ende des technisch Möglichen erreicht ist. Auf der Empfangsseiten kommen ebenfalls Ring-Resonatoren zum Einsatz, die eine Wellenlänge aufnehmen und in einem Fotodetektor führen.

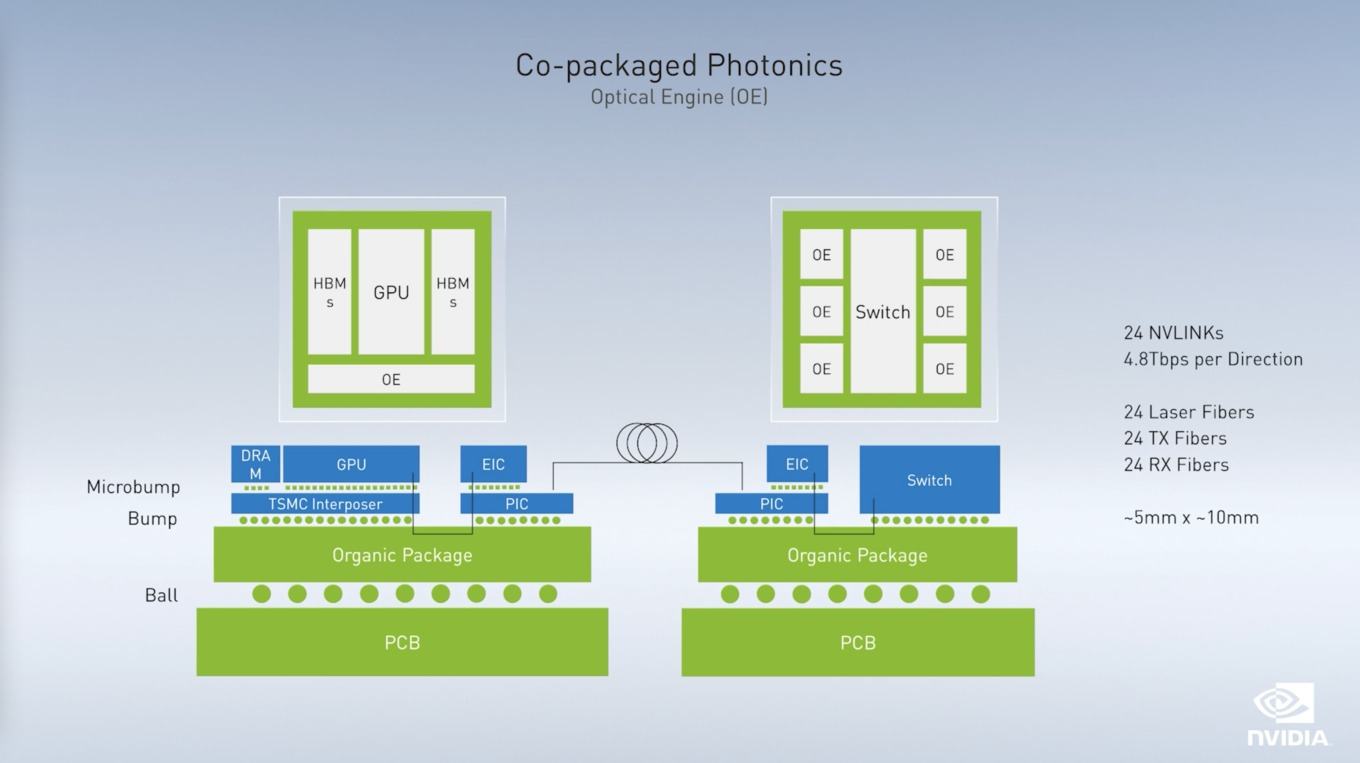

Der Chip würde wie oben abgebildet aussehen. Auf dem als TSMC-Interposer bezeichneten klassischen Chip (zum Beispiel die GA100-GPU) sitzen die GPU selbst und der Speicher. Der TSMC-Interposer wiederum sitzt auf einem Organic Package, das auch einen Photonic Integrated Circuit (PIC) anbindet. Ein Electrical Interface Chip (EIC) verwandelt die Interconnect-Signale der GPU über die Resonatoren in ein Signal, welches optisch übertragen wird. Für einen solch optischen Interconnect benötigt es zudem einen Switch, der auf diese Art und Weise aufgebaut ist, dessen Datenrate im Switching der Signale jedoch deutlich höher sein wird.

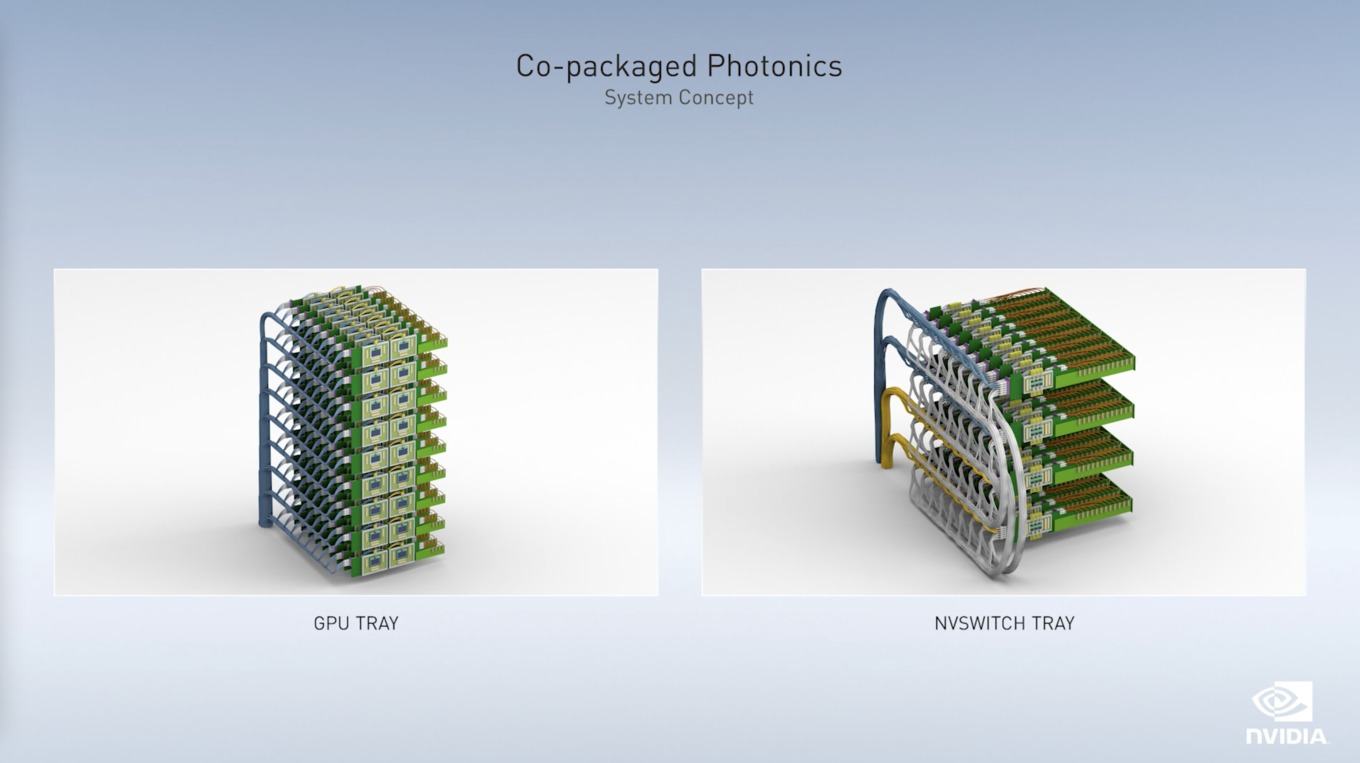

Ein Konzept für die Infrastruktur könnte so aussehen, dass es GPU Trays gibt, die bereits teilweise untereinander verbunden sind, die ihre Ausgangs-Signale aber auch über ein NVSwitch Tray austauschen. Dazu sind hier die blauen Lichtwellenleiter abgebildet, der Output wiederum erfolgt über die gelben Lichtwellenleiter und die Interconnects der NVSwitch Trays und sind als graue Lichtwellenleiter dargestellt.

Die Vorteile eines optischen Interconnects sind hinlängst bekannt: Der Strom- und Platzverbrauch auf den einzelnen Chips sinkt, die Datenraten können signifikant erhöht werden. Außerdem skaliert eine optische Verbindung deutlich einfacher, als dies bei elektromagnetischen Verbindungen aktuell der Fall ist, die inzwischen auf extrem komplexe Modulationsverfahren zurückgreifen müssen. Anstatt 8x 25 GBit/s kann ein solcher Lichtwellenleiter auch 32x 25 GBit/s übertragen, was die Datenrate der Verbindung vervierfacht.

Konkrete Pläne zur Umsetzung der Co-Packaged-Photonics-Technik hatte NVIDIA derzeit allerdings nicht zu verkünden.