Werbung

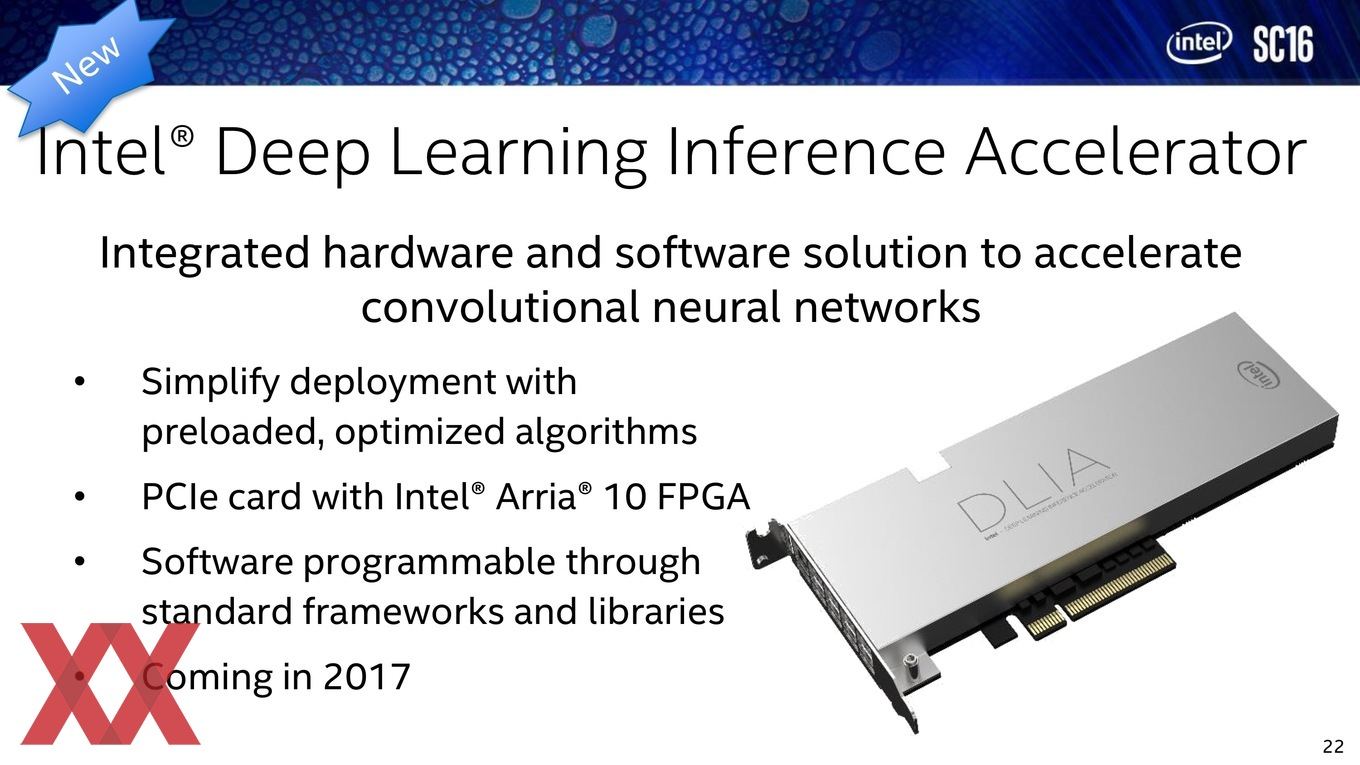

In Zusammenarbeit mit ZTE wollen Intel und der Kommunikationsspezialist aus China neue Rekorde für die Gesichtserkennung mittels eines Deep-Learning-Netzwerkes gebrochen haben. Bereits auf der Supercomputing 2016 präsentierte Intel spezielle Hardware für das Training und Inferencing von Deep-Learning-Netzwerken auf Basis der Arria-10-Hardware.

Die nun vorgestellte Hardware soll eine um den Faktor zehn höhere Leistung erreichen, wie dies zuvor der Fall war. Konkrete Zahlen werden nicht genannt, allerdings soll die Plattform in der Lage sein, tausende Gesichter pro Sekunde zu erkennen. Die Rechenleistung des Arria-10-FPGA beträgt 1,5 TFLOPS für Fließkommaberechnungen mit einfacher Genauigkeit. Der FPGA selbst besteht aus 1,15 Millionen logischen Elementen und ist zudem über einen Interconnect verbunden, der 1 TBit/s erreicht. Dies ist wesentlich schneller, als vieles andere in diesem Bereich und der Schlüssel zum Inferencing eines Deep-Learning-Netzwerkes.

Die Hardware selbst bestand aber nicht nur aus den PCI-Express-Karten mit Arria-10-FPGA, sondern zusätzlich aus einem Server mit vier CPU-Sockeln, in denen jeweils ein Intel Xeon E5-2670v3 bei 2,3 GHz steckte. Diesen zur Seite standen 128 GB DDR4 sowie das besagte Intel PSG Arria 10 FPGA Development Kit mit einem 10AGX115 FPGA, der wiederum auf 4 GB DDR4 SODIMM zugreifen kann. Als Software kamen Intel Quartus Prime und OpenCL SDK v16.1 zum Einsatz.

Duan Xiangyang, Vizapräsident des ZTE Wireless Institut sagte: "Perception, such as recognizing a face in an image, is one of the essential goals of the ZTE 5G System. Deep learning technology is very important as it can enable such perception in mobile edge computing systems, thus making ZTE’s 5G System smarter."

Sein Kollege Xiong Tiankui, Chefingeneur bei ZTE Wireless Institute fügte hinzu: "With the Intel reference design, and using the Intel SDK for OpenCL to program the FPGA, our development time was greatly shortened. We are pleased with the benchmark achieved and thank the Intel Programmable Solutions Group for supporting our project."