Werbung

Im vergangenen Jahr, ebenfalls zur Hausmesse I/O, stellte Google die erste Generation der Tensor Processing Units oder kurz TPU vor. Auf der gestrigen Keynote der I/O 2017 wurde die zweite Generation präsentiert. Dies macht vor allem den Bedarf an schneller Deep-Learning- und AI-Hardware deutlich, der von aktuellen Prozessoren und GPUs wohl nicht mehr lange gedeckt werden kann. Stattdessen entwickeln immer mehr Hersteller Spezialhardware.

Bei der TPU handelt es sich um einen Custom-ASIC (Application Specific Integrated Circuit), der speziell auf das Machine Learning mittels TensorFlow zugeschnitten ist. Die erste Generation erreicht mit Hilfe einer Matrix aus 256 × 256 Multiplizier/Aufaddier-Einheiten (Multiplier/Accumulator, MAC) und einem Takt von 700 MHz eine Rechenleistung von 91,75 TOPS (Tera Operations per Second). Damit gemeint sind 8-Bit-Operationen für das Inferencing.

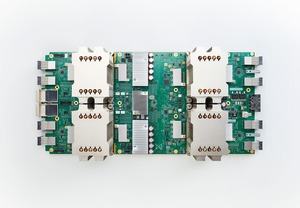

Die Rechenleistung kann zwischen der ersten und zweiten Generation nicht wirklich verglichen werden, da die neue TPU auch Floating-Point-Operationen ausführen kann. 16-Bit-Berechnungen kommt sie damit auf 180 TFLOPS. Auf den Bildern von Google ist ein Board zu sehen, auf dem sich vier Chips befinden. Ob Google für jedes dieser Module die 180 TFLOPS angibt oder damit den einzelnen Prozessor meint, ist unklar.

Jede TPU verfügt über einen von Google eigens entwickelten Interconnect, über den man aber keine weiteren Angaben macht. Er soll aber besonders schnell sein, was ebenfalls eine wichtige Komponente für das Training eines Deep-Learning-Netzwerkes ist. 64 TPUs lassen sich zu einem TPU Pod zusammenfassen und kommen damit auf eine Rechenleistung von 11,5 PFLOPS.

Zum Vergleich: Ein Intel Intel Xeon E5-2699 v3 kommt auf 2,6 TFLOPS und eine NVIDIA Tesla K80 auf 2,8 TFLOPS. NVIDIA stellte auf der GPU Technology Conference 2017 die Tesla V100 mit GV100-GPU vor und verwendet hier die sogenannten Tensor Cores. Mit Hilfe dieser speziellen Recheneinheiten erreicht eine Tesla V100 eine Rechenleistung von 120 TFLOPS. Umklar ist, bei welcher Leistungsaufnahme Google die 180 TFLOPS der zweiten TPU-Generation realisieren kann.

Google hat auch gleich die ersten Leistungsvergleiche zur Hand. Während ein Deep-Learning-Netzwerk für ein großes Übersetzungssystem einen kompletten Tag auf 32 der schnellsten GPUs benötigt, soll die gleiche Arbeit auf nur acht der neuesten TPUs an einem Nachmittag erledigt sein.

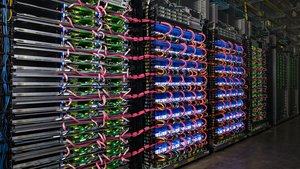

Google wird die neuen TPUs als Teil der Compute Engine als Cloud TPUs anbieten. Einen Zugang wird es vorerst aber nur für Tester in einer kostenpflichtigen Alpha-Version geben. In virtuellen Maschinen werden die TPUs mit Skylake-CPUs und NVIDIA-GPUs zusammengefasst und können je nach Bedarf und den speziellen Bedürfnissen gemeinsam verwendet werden. Im Rahmen der TensorFlow Research Cloud wird Google 1.000 der neuen TPUs kostenlos betreiben und zugänglich machen.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen