News und Artikel durchsuchen

{{#data.error.root_cause}}

{{/data.error}}

{{^data.error}}

{{#texts.summary}}

[{{{type}}}] {{{reason}}}

{{/data.error.root_cause}}{{texts.summary}} {{#options.result.rssIcon}} RSS {{/options.result.rssIcon}}

{{/texts.summary}} {{#data.hits.hits}}

{{#_source.featured}}

FEATURED

{{/_source.featured}}

{{#_source.showImage}}

{{#_source.image}}

{{/_source.image}}

{{/_source.showImage}}

{{/data.hits.hits}}

{{{_source.title}}} {{#_source.showPrice}} {{{_source.displayPrice}}} {{/_source.showPrice}}

{{#_source.showLink}} {{/_source.showLink}} {{#_source.showDate}}{{{_source.displayDate}}}

{{/_source.showDate}}{{{_source.description}}}

{{#_source.additionalInfo}}{{#_source.additionalFields}} {{#title}} {{{label}}}: {{{title}}} {{/title}} {{/_source.additionalFields}}

{{/_source.additionalInfo}}

TPU

-

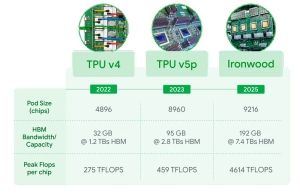

Google TPU Ironwood: Google bereitet sich auf den Inferencing-Boom vor

Auf der Google Cloud Next 25 hat der Internetriese Google oder besser die Cloud-Sparte die nächste Generation seiner eigenen Tensor Processing Unit (TPU) präsentiert. Der Ironwood genannte Prozessor bietet eine Spitzen-Rechenleistung von 4.614 TFLOPs an FP8-Rechenleistung. Nach NVIDIA und AMD richtet Google die eigene Hardware klar auf das Inferencing von KI-Modellen aus. Die Hardware kommt also weniger für das Training neuer Modelle zum... [mehr]

Auf der Google Cloud Next 25 hat der Internetriese Google oder besser die Cloud-Sparte die nächste Generation seiner eigenen Tensor Processing Unit (TPU) präsentiert. Der Ironwood genannte Prozessor bietet eine Spitzen-Rechenleistung von 4.614 TFLOPs an FP8-Rechenleistung. Nach NVIDIA und AMD richtet Google die eigene Hardware klar auf das Inferencing von KI-Modellen aus. Die Hardware kommt also weniger für das Training neuer Modelle zum... [mehr] -

Google TPU Trillium: Auslegung für größere KI-Modelle

Auf der gestrigen Google I/O stand alles im Fokus der Gemini-KI-Modelle, die auf den Android-Geräten ausgeführt werden sollen, die aber auch ein gewisses Rückgrat in den Rechenzentren benötigen. Dazu nutzt Google in weiten Teilen die eigens entwickelten TPUs. Nun hat man mit dem Trillium die nächste Generation vorgestellt. Sie soll die aktuellen TPU v5e ersetzen bzw. erweitert die Hardware um die aktuellen... [mehr]

Auf der gestrigen Google I/O stand alles im Fokus der Gemini-KI-Modelle, die auf den Android-Geräten ausgeführt werden sollen, die aber auch ein gewisses Rückgrat in den Rechenzentren benötigen. Dazu nutzt Google in weiten Teilen die eigens entwickelten TPUs. Nun hat man mit dem Trillium die nächste Generation vorgestellt. Sie soll die aktuellen TPU v5e ersetzen bzw. erweitert die Hardware um die aktuellen... [mehr] -

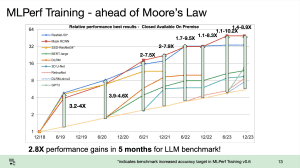

MLPerf-Benchmarks: NVIDIA mit über 10.000 GPUs, Google TPU-v5e und Gaudi2 mit guten Ergebnissen

Die MLCommons hat eine weitere Runde Ergebnisse im Bereich Datacenter-Training und HPC vorgestellt. Interessant sind dabei die Trainings-Ergebnisse, denn hier taucht einiges an Hardware erstmals auf bzw. skaliert mit deutlich mehr Beschleunigern, als dies bei den bisherigen Ergebnissen der Fall war. NVIDIA und Azure präsentieren Ergebnisse mit 1.344 Knoten. In seiner Cloud-Instanz setzt Azure dazu pro Knoten auf jeweils zwei Intel Xeon... [mehr]

Die MLCommons hat eine weitere Runde Ergebnisse im Bereich Datacenter-Training und HPC vorgestellt. Interessant sind dabei die Trainings-Ergebnisse, denn hier taucht einiges an Hardware erstmals auf bzw. skaliert mit deutlich mehr Beschleunigern, als dies bei den bisherigen Ergebnissen der Fall war. NVIDIA und Azure präsentieren Ergebnisse mit 1.344 Knoten. In seiner Cloud-Instanz setzt Azure dazu pro Knoten auf jeweils zwei Intel Xeon... [mehr] -

Googles TPUs werden enger gepackt und wassergekühlt

Auf der Keynote der diesjährigen Google I/O drehte sich vieles um Machine Learning und intelligente Assistenzsysteme. Um diese trainieren zu können, arbeitet Google seit einigen Jahren an eigener Hardware, die auf diese Anwendungen ausgelegt sind – Tensor Processing Units oder kurz TPUs. Bei der TPU handelt es sich um einen Custom-ASIC (Application Specific Integrated Circuit), der speziell auf das Machine Learning... [mehr]

Auf der Keynote der diesjährigen Google I/O drehte sich vieles um Machine Learning und intelligente Assistenzsysteme. Um diese trainieren zu können, arbeitet Google seit einigen Jahren an eigener Hardware, die auf diese Anwendungen ausgelegt sind – Tensor Processing Units oder kurz TPUs. Bei der TPU handelt es sich um einen Custom-ASIC (Application Specific Integrated Circuit), der speziell auf das Machine Learning... [mehr] -

Googles TPUs werden Bestandteil der Google Cloud Plattform

Bisher hat Google seine Tensor Processing Units oder kurz TPUs nur für eigene Projekte verwendet. Dazu gehören der Suchalgorithmus ebenso wie Übersetzungen per Google Translate. Nun aber sollen die TPUs auch den ersten Beta-Nutzern der Cloud Platform zugänglich gemacht werden. Bei der TPU handelt es sich um einen Custom-ASIC (Application Specific Integrated Circuit), der speziell auf das Machine Learning... [mehr]

Bisher hat Google seine Tensor Processing Units oder kurz TPUs nur für eigene Projekte verwendet. Dazu gehören der Suchalgorithmus ebenso wie Übersetzungen per Google Translate. Nun aber sollen die TPUs auch den ersten Beta-Nutzern der Cloud Platform zugänglich gemacht werden. Bei der TPU handelt es sich um einen Custom-ASIC (Application Specific Integrated Circuit), der speziell auf das Machine Learning... [mehr] -

Hot Chips: AMD Vega, Intel Knights Mill, GDDR5 TPU von Google und IBM z14 mit viel Cache

Im kalifornischen Cupertino findet in jedem Jahr die Hot Chips statt. Auch in diesem Jahr gaben zahlreiche Unternehmen wieder einen Einblick in die aktuellen Entwicklungen im jeweiligen Bereich. AMD sprach über die Vega-Architektur, Intel über die Weiterentwicklung bei den Xeon-Phi-Beschleunigern, Google über den Einsatz von GDDR5 oder HBM für die TPU und IBM über den z14 mit massiv viel Cache. Wir haben eine kleine Zusammenfassung zu einigen... [mehr]

Im kalifornischen Cupertino findet in jedem Jahr die Hot Chips statt. Auch in diesem Jahr gaben zahlreiche Unternehmen wieder einen Einblick in die aktuellen Entwicklungen im jeweiligen Bereich. AMD sprach über die Vega-Architektur, Intel über die Weiterentwicklung bei den Xeon-Phi-Beschleunigern, Google über den Einsatz von GDDR5 oder HBM für die TPU und IBM über den z14 mit massiv viel Cache. Wir haben eine kleine Zusammenfassung zu einigen... [mehr] -

Google stellt 2. Generation der Tensor Processing Units vor

Im vergangenen Jahr, ebenfalls zur Hausmesse I/O, stellte Google die erste Generation der Tensor Processing Units oder kurz TPU vor. Auf der gestrigen Keynote der I/O 2017 wurde die zweite Generation präsentiert. Dies macht vor allem den Bedarf an schneller Deep-Learning- und AI-Hardware deutlich, der von aktuellen Prozessoren und GPUs wohl nicht mehr lange gedeckt werden kann. Stattdessen entwickeln immer mehr Hersteller Spezialhardware. Bei... [mehr]

Im vergangenen Jahr, ebenfalls zur Hausmesse I/O, stellte Google die erste Generation der Tensor Processing Units oder kurz TPU vor. Auf der gestrigen Keynote der I/O 2017 wurde die zweite Generation präsentiert. Dies macht vor allem den Bedarf an schneller Deep-Learning- und AI-Hardware deutlich, der von aktuellen Prozessoren und GPUs wohl nicht mehr lange gedeckt werden kann. Stattdessen entwickeln immer mehr Hersteller Spezialhardware. Bei... [mehr] -

Ein Blick in Google’s Tensor Processing Unit (TPU)

Themen wie Machine Learning, Deep Learning und Artificial Intelligence, die eigentlich nur Synonyme füreinander sind, spielen in der heutigen Welt eine immer wichtigere Rolle. Unternehmen wie Intel, Google und NVIDIA haben sich darauf vorbereitet und entsprechende Hardware entwickelt. Google hat dazu die Tensor Processing Unit (TPU) entwickelt, zu der es nun weitere Informationen gibt. Bei der TPU handelt es sich um einen Custom-ASIC... [mehr]

Themen wie Machine Learning, Deep Learning und Artificial Intelligence, die eigentlich nur Synonyme füreinander sind, spielen in der heutigen Welt eine immer wichtigere Rolle. Unternehmen wie Intel, Google und NVIDIA haben sich darauf vorbereitet und entsprechende Hardware entwickelt. Google hat dazu die Tensor Processing Unit (TPU) entwickelt, zu der es nun weitere Informationen gibt. Bei der TPU handelt es sich um einen Custom-ASIC... [mehr]