Werbung

Auf der Keynote der diesjährigen Google I/O drehte sich vieles um Machine Learning und intelligente Assistenzsysteme. Um diese trainieren zu können, arbeitet Google seit einigen Jahren an eigener Hardware, die auf diese Anwendungen ausgelegt sind – Tensor Processing Units oder kurz TPUs.

Bei der TPU handelt es sich um einen Custom-ASIC (Application Specific Integrated Circuit), der speziell auf das Machine Learning mittels TensorFlow zugeschnitten ist. Die zweite Generation der TPUs berechnet 256 × 256 Multiplizier/Aufaddier-Einheiten (Multiplier/Accumulator, MAC) – bestehend aus 2x 128 x 128 Rechencluster. Hinzu kommen 16 GB an HBM2. Diese 16 GB erreichen eine Speicherbandbreite von 600 GB/s und arbeiten demnach mit einem Takt von etwas weniger als 600 MHz. Die Rechenleistung pro TPU gibt Google mit 180 TFLOPS an.

Zur I/O-Keynote stellt Google nun die dritte Iteration der TPUs vor. Auf Seiten der ASICs und damit der eigentlichen Hardware tut sich allerdings nichts. Wir sprechen also weiterhin von zwei Rechenkernen pro Chip und vier Chips ergeben eine TPU. Eine solche TPU kommt auf 180 TFLOPs. Hinzu kommen Scalar-, Vektor- und eine Matrix-Einheit.

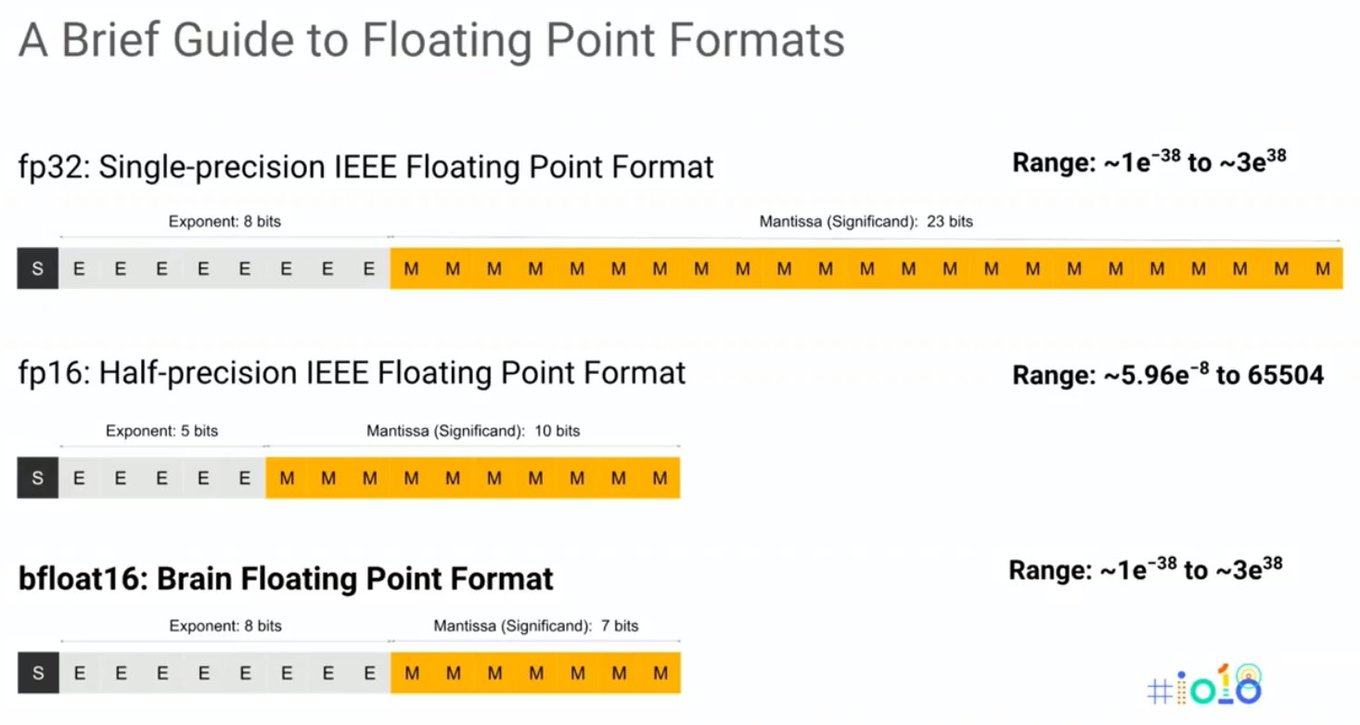

Für das Training eines Deep-Learning-Netzwerkes sind FP32-Berechnungen, also Fließkommaberechnungen mit einfacher Genauigkeit, entscheidend. Um einmal die Komplexität der angewendeten Matrix-Multiplikationen vor Augen zu führen, stellt Google die mathematischen Zusammenhänge etwas besser grafisch dar.

Schnell wird also klar, mit welchen Zahlen solche Systeme umgehen müssen und diese Berechnungen werden milliardenfach pro Sekunde ausgeführt. bfloat16 ist ein neuer Datentyp, der so in dieser Form bisher nur von Google verwendet wird. Er soll den Umfang von FP32 bieten, ohne aber die Genauigkeit übernehmen zu müssen, die in diesem Fall unnötig ist.

Keine neue Hardware – wohl aber dichter gepackt und wassergekühlt

An der eigentlichen Hardware in Form der Chips hat sich also nichts getan. Offenbar aber kann Google die Chips nun dichter zusammen packen und der eigene Interconnect, über den es keinerlei technische Details zur Bandbreite oder Anzahl der Links gibt, ist in der Lage mehr TPUs anzusprechen, so dass die Pods, in denen Google mehrere Dutzend mit hunderten oder gar tausenden TPUs betreibt, größer werden. Bisher bestanden solche Pods aus 64 TPUs. Diese erbringen eine Rechenleistung von 11,5 PFLOPS und bieten 4 TB an HBM2. Die neue Pods können mehr als zehnmal so groß sein und erreichen eine Rechenleistung von 100 PFLOPS für INT8-Berechnungen, die für das Machine Learning wichtig sind.

Die TPUs der dritten Generation kommen allerdings nicht mehr mit einer Luftkühlung aus. Nicht, weil die Leistung derart gesteigert werden konnte, sondern weil Google sie in den Pods dichter zusammenpackt und die Abwärme über eine Wasserkühlung besser abgeleitet werden kann.

Inzwischen verwendet Google die TPUs aber nicht nur für eigene Anwendungen, sondern stellt sie auch in der eigenen Cloud zur Verfügung. Eine Cloud-TPU-Konfiguration besteht aus vier dieser Chips, kommt also auf 64 GB HBM2 und acht „Dual-Cores". Diese kleinste Cloud-TPU-Konfiguration kann durch Nutzer angemietet werden. Die Kosten belaufen sich auf 6,50 US-Dollar pro Cloud-TPU und Stunde.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen