Werbung

Intel schließt eine seiner Abteilungen für die Entwicklung von AI-Hardware, die 2016 als externes Unternehmen Nervana übernommen wurde und eingegliedert werden sollte. Doch die Entwicklung der Neural Network Prozessoren (NNPs) soll eingestellt und der Fokus auf die Weiterentwicklung der von Habana Labs entwickelten Technologien gerückt werden. Dies berichtet Forbes.

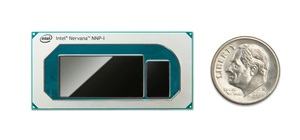

Ende 2019 kaufte Intel das israelische Unternehmen Habana Labs für 2 Milliarden US-Dollar. 2020 sollten allerdings die ersten kommerziellen Produkte aus dem Hause Nervana auf den Markt kommen. In Form des NNP-T und NNP-I sollte die zweite Generation der Entwicklung in aktuellen HPC-Systemen zum Einsatz kommen. Doch auch wenn die Hardware inzwischen verfügbar sein sollte, so zeichnete sich dennoch ab, dass der große Durchbruch damit nicht gelingen wird.

Zwar wird man die bisher an Partner ausgelieferten Chips weiterhin unterstützen, es wird allerdings keinerlei Weiterentwicklung geben. Die Inferencing-Lösung NNP-I soll dabei noch mehr Unterstützung erfahren, als die Trainings-Lösung NNP-T, wo offenbar sämtliche Arbeiten eingestellt wurden.

Aus den bisherigen Präsentation von Intel kennen wir die wichtigsten technischen Details zur Hardware (siehe nächster Abschnitt der News). Mit der Hardware von Habana Labs haben wir uns bisher nicht beschäftigt. Die Chips hören auf die Namen Gaudi für das Training und Goya für das Inferencing von Deep-Learning-Netzwerken.

Bisher setzt Habana Labs auch hier auf eine Fertigung bei TSMC in 16 nm. Langfristig wird Intel die entsprechenden Chips sicherlich in eigener Hand fertigen wollen. Gaudi und Goya setzen auf spezielle Tensor Processing Cores (TPCs), die wie die Tensor-Cores von NVIDIA Vektor- bzw. Matrixberechnungen ausführen können und dabei gegebenenfalls geringere Genauigkeit wie INT4- und INT8-Berechnungen sowie geringere Komplexität wie durch Bflout16 setzen.

Für Gaudi sind 32 GB an schnellem HBM2 verbaut. Goya kommt mit DDR4-Speicher und einem 128 Bit breiten Speicherinterface aus. Der Gaudi-Chip bietet zudem ein On-Die 100-GbE-Fabric mit der Unterstützung von RDMA über Converged Ethernet (ROCE). Damit lässt sich die Hardware per Mellanox NIC in einen Datacenter-Interconnect einbinden und die Lösung skaliert für mehrere tausend Nodes.

Rückblick auf NNP-T und NNP-I

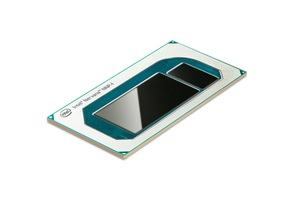

Der NNP-T1000 alias Spring Crest besteht aus 27 Milliarden Transistoren und besitzt 32 GB HBM2-Speicher. Dies alles packt Intel auf einen Interposer mit einer Fläche von 1.200 mm². Der ASIC besteht aus 24 Tensor Prozessoren (TPCs). Diese kommen auf eine Rechenleistung von 119 TOPS. Auf dem SoC befinden sich zudem 60 MB an on-chip Speicher (SRAM). Um möglichst viele Daten möglichst nahe an den TPCs zu haben, verbaut Intel vier HBM2-Speicherchips mit einer Kapazität von jeweils 8 GB – zusammen also 32 GB. Zusammen mit einem PCIe-4.0-Interface mit 16 Lanes sowie 64 SerDes (Serialisierer/Deserialisierer). Gefertigt wird der NNP-T von TSMC im 16-nm-Prozess (CLN16FF+).

Etwas weniger bekannt ist zum NNP-I1000 alias Spring Hill. Hier verwendet Intel zwei in 10 nm gefertigte Sunny-Cove-Kerne. Per DL-Boost werden die entsprechenden Inferencing-Instruktionen beschleunigt. Hinzu kommen 12 Inference and Compute Units (ICE). Der NNP-I1000 kann mit einer TDP von 10 bis 50 W konfiguriert werden. Die Leistung bewegt sich dementsprechend zwischen 48 und 92 TOPS in INT8.

An Speicher vorhanden sind 3 MB an Tightly-Coupled Memory (TCM), der eine Bandbreite von 68 TB/s hat. Hinzu kommen 48 MB an SRAM, der eine Datenrate von 6,8 TB/s hat. Weitere 24 MB an Low Latency Cache (LLC) sind mit 680 GB/s angebunden. Schlussendlich können bis zu 32 GB an LPDDR4 verbaut werden, die mit 67,2 GB/s angebunden sind.

Doch auch wenn die technischen Daten beider Chips beeindruckend klingen, so scheint es am Ende an der Unterstützung durch die entsprechenden Software zu fehlen. Eben hier setzt Intel mit der One-API-Strategie an. Egal welche Hardware verwendet wird, ob Xeon-Prozessor, GPGPU auf Basis der Xe-Architektur oder Consumer-Lösungen wie durch DL-Boost unterstützte Bildbearbeitung – alles soll durch die One API angesprochen werden können.

Dr. Naveen G. Rao verlässt Intel

Wohl maßgeblich aufgrund der Entscheidung von Intel die Nervana-Produkte einzustellen hat Dr. Naveen G. Rao das Unternehmen verlassen. Sein weiterer Werdegang ist bisher nicht bekannt.

Datenschutzhinweis für Twitter

An dieser Stelle möchten wir Ihnen einen Twitter Feed zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Twitter setzt durch das Einbinden des Applets Cookies auf ihrem Rechner, mit welchen sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf diesen Feed. Der Inhalt wird anschließend geladen und Ihnen angezeigt.Ihr Hardwareluxx-Team

Tweets ab jetzt direkt anzeigen