Werbung

Intel ist nicht der einzige Hersteller, der an neuronalen Chips arbeitet. Vor drei Jahren stellte Intel die erste Generation der Hardware für das neuronale Computing vor: den Loihi. Der Chip verwendete rund 130.000 Neuronen aus Silizium und soll die Art und Weise, wie Deep-Learning-Netzwerke arbeiten, effizienter machen und vor allem beschleunigen. Inzwischen gibt es die zweite Generation alias Loihi 2w, die aus insgesamt 1.048.576 Neuronen besteht.

Geringe Latenzen und eine hohe Effizienz sollen das neuronale Computing auszeichnen, aber wie genau die erreicht wird und welche konkreten Umsetzungen es vielleicht schon gibt, das war uns bisher nicht ganz klar. Gemeinsam mit der Technischen Universität München und dem Italian Institute of Technology hat Intel eine Grundlagenforschung vorangetrieben, die eine Objekterkennung mittels neuronalem Computing darstellt. Auf der International Conference on Neuromorphic Systems (ICONS) wurde das Forschungspapier (PDF) mit einem Preis ausgezeichnet.

Aber worum geht es eigentlich? Computersysteme können bereits heute schon Objekte erkennen und in der Praxis gibt es im Automotive- und Robotik-Segment schon zahlreiche Praxis-Anwendungen dafür. In der Robotik verlässt man sich allerdings häufig darauf, dass man sich in kontrollierten Umgebungen befindet. Dies ist in gewisser Weise auch auf der Straße der Fall – vom vollautonomen Fahren sind wir ohnehin noch weit entfernt. Sobald Menschen in direkte Interaktion mit einem solchen System treten, sind die sicherheitsrelevanten Hürden nicht ohne Grund relativ hoch.

Zudem ist der Aufwand, solche "klassischen" KI-Systeme zu trainieren, recht groß. Google, NVIDIA, Microsoft, Tesla sowie alle weiteren Unternehmen, die auf eine Text-, Bild, Objekt- oder sonstige Erkennung setzen, trainieren ihre Systeme auf riesigen Systemen, nur damit am anderen Ende der Produkt-Kette dann ein Auto ein Stoppschild (hoffentlich) erkennt, Text in Sprache und umgekehrt oder Katzen auf einem Bild erkannt werden. Werden die Parameter des Systems verändert, muss das gesamte Training erneut gestartet werden. Dieser enorme Aufwand um einem Roboter beizubringen ein bestimmtes Objekt zu erkennen und zu greifen, soll durch das neuronale Computing deutlich reduziert werden.

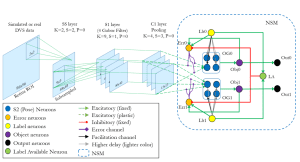

Das kleine und flexible neuronale Netzwerk an dem Intel nun geforscht hat, verwendet eine Neuronal State Machine (NSM), die direkt auf einem neuronalen Chip ausgeführt werden kann und ein aufwändiges Training überflüssig macht. Dem Roboter, bzw. der Kamera wird ein Objekt aus nur 20 Blickwinkeln gezeigt. Eine sogenannte "event based" Kamera erkennt nicht ein komplettes Foto mit Pixeln in X- und Y-Richtung, sondern nur Änderungen zum vorherigen Frame. Damit wird einerseits die Datenmenge reduziert, andererseits passen die übermittelten Daten besser zur Methodik, wie die neuronale Hardware arbeitet.

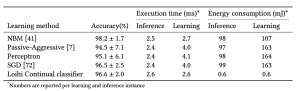

Auf einem Loihi-Chip ausgeführt sahen die Ergebnisse wie folgt aus:

Im Hinblick auf die Erkennung der Objekte (Inferencing) und dem Training (Learning) auf diese sind die Latenzen für den "Loihi Continual Classifier" auf Niveau klassischer, offline trainierter Systeme. Die Genauigkeit ist mit 96,6 % (± 2.0) ebenfalls bereits recht hoch.

Interessant wird es beim Energieverbrauch. Benötigen klassische Systeme für ein Erkennen fast 100 mJ und für das Training sogar bis zu 160 mJ, sind es unter Verwendung der Loihi-Hardware nur 0,6 mJ. Natürlich sprechen wir hier nun über extrem kleine Netzwerke, die für moderne Hardware keinerlei Herausforderung darstellen. Aber skaliert man diese Werte auf größere Anwendungsgebiete, macht ein um den Faktor 100 und mehr effizienteres Rechnen natürlich einen Unterschied.

Von den 128.000 Neuronen und 128 Millionen möglichen Verbindungen der Synapsen des Loihi nutzten die Forscher für ihre Arbeit gerade einmal 18.000 Neuronen und 500.000 Synapsen. Die Hardware bietet also ein noch weitaus größeres Potential, welches mit Fortschreiten der Arbeiten aber auch ausgenutzt werden wird. In einem nächsten Schritt soll ergründet werden, ob solches interaktives und kontinuierliches Netzwerk mit 100 Objekten noch so effizient arbeiten kann.

Ein weiterer Vorteil dürfte sein, dass diese neuronalen Netze direkt auf dem Chip trainiert werden und sozusagen selbstständig lernen. Ändert man bestimmte Parameter eines Deep-Learning-Netzwerks, muss das Training zumindest teilweise erneut durchgeführt werden. Dies kostet einerseits Zeit, aber auch Rechenleistung und damit Energie. Vor allem bedeutet dies für zum Beispiel ein Robotor-System, welches dem Menschen zuarbeiten soll: Ändern sich bestimmte Parameter, kann der Roboter darauf nicht direkt reagieren, bzw. die Latenzen in der Erkennung, Bewertung und Reaktion werden so groß, dass dies eine Hürde für den Einsatz darstellt. Ein interaktives, kontinuierliches Lernen ist effizient und nur mittels neuronalen Chips und dazugehöriger Software möglich.

Die Entwicklung steht hier aber noch ganz am Anfang. Ähnlich wie bei den Deep-Learning-Netzwerken gilt es zunächst einmal die Algorithmen zu entwickeln, diese zu verbessern oder sich komplett neue Ansätze zu überlegen. Die ersten Schritte werden aktuell in den Laboren gemacht. Hard- und Software müssen zunächst einmal zueinander finden – Anwendungsbereiche ausgeleuchtet und Lösungen entwickelt werden.