News und Artikel durchsuchen

{{#data.error.root_cause}}

{{/data.error}}

{{^data.error}}

{{#texts.summary}}

[{{{type}}}] {{{reason}}}

{{/data.error.root_cause}}{{texts.summary}} {{#options.result.rssIcon}} RSS {{/options.result.rssIcon}}

{{/texts.summary}} {{#data.hits.hits}}

{{#_source.featured}}

FEATURED

{{/_source.featured}}

{{#_source.showImage}}

{{#_source.image}}

{{/_source.image}}

{{/_source.showImage}}

{{/data.hits.hits}}

{{{_source.title}}} {{#_source.showPrice}} {{{_source.displayPrice}}} {{/_source.showPrice}}

{{#_source.showLink}} {{/_source.showLink}} {{#_source.showDate}}{{{_source.displayDate}}}

{{/_source.showDate}}{{{_source.description}}}

{{#_source.additionalInfo}}{{#_source.additionalFields}} {{#title}} {{{label}}}: {{{title}}} {{/title}} {{/_source.additionalFields}}

{{/_source.additionalInfo}}

ML

-

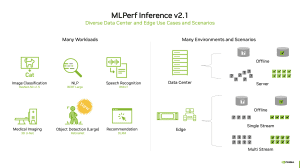

MLPerf Inference 2.1: H100 mit erstem Auftritt und mehr Diversität

Es gibt eine neue Runde unabhängiger, bzw. gegenseitig geprüfter Benchmark-Ergebnisse aus dem Server-Bereich. Genauer gesagt geht es um die Inferencing-Ergebnisse in der Version 2.1. Diese sollen eine unabhängige Beurteilung der Server-Systeme in den verschiedenen Anwendungsbereichen ermöglichen. Große Unternehmen werden natürlich weiterhin eine eigene Evaluierung vornehmen, aber in der Außendarstellung konnten die Hersteller meist nur mit... [mehr]

Es gibt eine neue Runde unabhängiger, bzw. gegenseitig geprüfter Benchmark-Ergebnisse aus dem Server-Bereich. Genauer gesagt geht es um die Inferencing-Ergebnisse in der Version 2.1. Diese sollen eine unabhängige Beurteilung der Server-Systeme in den verschiedenen Anwendungsbereichen ermöglichen. Große Unternehmen werden natürlich weiterhin eine eigene Evaluierung vornehmen, aber in der Außendarstellung konnten die Hersteller meist nur mit... [mehr] -

Schneller und effizienter: Forschung zeigt Vorteile neuronaler Chips

Intel ist nicht der einzige Hersteller, der an neuronalen Chips arbeitet. Vor drei Jahren stellte Intel die erste Generation der Hardware für das neuronale Computing vor: den Loihi. Der Chip verwendete rund 130.000 Neuronen aus Silizium und soll die Art und Weise, wie Deep-Learning-Netzwerke arbeiten, effizienter machen und vor allem beschleunigen. Inzwischen gibt es die zweite Generation alias Loihi 2w, die aus... [mehr]

Intel ist nicht der einzige Hersteller, der an neuronalen Chips arbeitet. Vor drei Jahren stellte Intel die erste Generation der Hardware für das neuronale Computing vor: den Loihi. Der Chip verwendete rund 130.000 Neuronen aus Silizium und soll die Art und Weise, wie Deep-Learning-Netzwerke arbeiten, effizienter machen und vor allem beschleunigen. Inzwischen gibt es die zweite Generation alias Loihi 2w, die aus... [mehr] -

MLPerf Training 2.0: NVIDIA die beständige Konstante, Graphcore, Google und Habana mit neuer Hardware

Die MLCommons hat die neuesten Ergebnisse für das Training von AI-Netzwerken veröffentlicht. Im Rahmen des MLPerf Training v2.0 geht es einmal mehr darum, eine Vergleichsbasis für solche Systeme zu bilden. Unternehmen wie Dell, HPE, Google, Inspur, Intel, Lenovo, NVIDIA, Gigabyte, Supermicro, Graphcore und viele weitere können an den Benchmarks teilnehmen, müssen sich natürlich an die aufgestellten Regeln halten und dürften auch die... [mehr]

Die MLCommons hat die neuesten Ergebnisse für das Training von AI-Netzwerken veröffentlicht. Im Rahmen des MLPerf Training v2.0 geht es einmal mehr darum, eine Vergleichsbasis für solche Systeme zu bilden. Unternehmen wie Dell, HPE, Google, Inspur, Intel, Lenovo, NVIDIA, Gigabyte, Supermicro, Graphcore und viele weitere können an den Benchmarks teilnehmen, müssen sich natürlich an die aufgestellten Regeln halten und dürften auch die... [mehr] -

Hot Chips 33: Esperanto ET-SoC-1 ist der Inferencing-Effizienz-König

Machine-Learning, bzw. AI-Anwendungen lassen sich in zwei Bereiche aufteilen. Im Training werden verschiedenste Eingabewerte so verarbeitet, dass sie über das Inferencing schnell wieder ausgewertet werden können. Für das autonome Fahren werden Videodaten ausgewertet und ein Netzwerk trainiert, damit die Erkennung der verschiedenen Situationen verbessert wird. Im Inferencing wird das Erlernte dann über die lokalen Systeme in den Fahrzeugen nur... [mehr]

Machine-Learning, bzw. AI-Anwendungen lassen sich in zwei Bereiche aufteilen. Im Training werden verschiedenste Eingabewerte so verarbeitet, dass sie über das Inferencing schnell wieder ausgewertet werden können. Für das autonome Fahren werden Videodaten ausgewertet und ein Netzwerk trainiert, damit die Erkennung der verschiedenen Situationen verbessert wird. Im Inferencing wird das Erlernte dann über die lokalen Systeme in den Fahrzeugen nur... [mehr] -

Hot Chips 33: Samsung Aquabolt-XL - HBM2 mit integrierter Rechenkapazität

Anfang des Jahres stellte Samsung den HBM-PIM, den ersten HBM-Speicher mit eingebauter AI-Engine, vor. Einige Details kennen wir also bereits, auf der Hot-Chips-Konferenz sprach Samsung aber etwas genauer über die Motivation und die Ziele hinter einem solchen Speichertyp. Auch hat man bereits erste Produkte mit diesem Speicher ausgestattet und testet diese zusammen mit seinen potenziellen Kunden. Beim Aquabolt-XL handelt es sich um... [mehr]

Anfang des Jahres stellte Samsung den HBM-PIM, den ersten HBM-Speicher mit eingebauter AI-Engine, vor. Einige Details kennen wir also bereits, auf der Hot-Chips-Konferenz sprach Samsung aber etwas genauer über die Motivation und die Ziele hinter einem solchen Speichertyp. Auch hat man bereits erste Produkte mit diesem Speicher ausgestattet und testet diese zusammen mit seinen potenziellen Kunden. Beim Aquabolt-XL handelt es sich um... [mehr] -

MLPerf Training 1.0: Graphcore und Google greifen NVIDIAs Vormachtstellung an

Die MLCommons haben pünktlich zur ISC 21 die Ergebnisse des MLPerf Training in der Version 1.0 veröffentlicht. Für diese neueste Version der Benchmark-Ergebnisse wurden einige Prozesse in der Teilnahme geändert, sodass es für Unternehmen einfacher werden soll, daran teilzunehmen. So wurden die bisher verwendeten Übersetzungs-Benchmarks GNMT und Transformer aus der Wertung genommen. Auf der anderen Seite wurde mit RNNT eine... [mehr]

Die MLCommons haben pünktlich zur ISC 21 die Ergebnisse des MLPerf Training in der Version 1.0 veröffentlicht. Für diese neueste Version der Benchmark-Ergebnisse wurden einige Prozesse in der Teilnahme geändert, sodass es für Unternehmen einfacher werden soll, daran teilzunehmen. So wurden die bisher verwendeten Übersetzungs-Benchmarks GNMT und Transformer aus der Wertung genommen. Auf der anderen Seite wurde mit RNNT eine... [mehr] -

Neuer Intelligence X280 von SiFive verbindet RISC-V mit Vektorbeschleunigung

Auf der Linley Spring Processor Conference 2021 in der vergangenen Woche stellte Cerebras die zweite Generation der Wafer Scale Engine mit 850.000 AI-Kernen vor. Außerdem verkündete SiFive eine Erweiterung seiner Intelligence IP um den neuen X280-Prozessor. Eingebaut werden kann dieser in die U7-Series-Kerne mit RISC-V ISA. Der Intelligence X280 soll sämtliche AI- und ML-Workloads beschleunigen – von INT8, über BF16 und... [mehr]

Auf der Linley Spring Processor Conference 2021 in der vergangenen Woche stellte Cerebras die zweite Generation der Wafer Scale Engine mit 850.000 AI-Kernen vor. Außerdem verkündete SiFive eine Erweiterung seiner Intelligence IP um den neuen X280-Prozessor. Eingebaut werden kann dieser in die U7-Series-Kerne mit RISC-V ISA. Der Intelligence X280 soll sämtliche AI- und ML-Workloads beschleunigen – von INT8, über BF16 und... [mehr] -

MLPerf Inference 1.0 Power legt den Fokus auf die Effizienz

In all unseren Tests versuchen wir über Benchmarks und Messungen unter gleichen Bedingungen des korrekte Leistungsbild der Hardware darzustellen. Für Prozessoren, Grafikkarten, Speicher, aber auch für Lüfter und Kühler stellt sich dies noch recht einfach und nachvollziehbar dar. Schon anders sieht dies für Serveranwendungen, die weitaus komplexer und weniger einfach nachvollziehbar sein können. Auf die Spitze getrieben wird dies mit AI-, bzw... [mehr].

In all unseren Tests versuchen wir über Benchmarks und Messungen unter gleichen Bedingungen des korrekte Leistungsbild der Hardware darzustellen. Für Prozessoren, Grafikkarten, Speicher, aber auch für Lüfter und Kühler stellt sich dies noch recht einfach und nachvollziehbar dar. Schon anders sieht dies für Serveranwendungen, die weitaus komplexer und weniger einfach nachvollziehbar sein können. Auf die Spitze getrieben wird dies mit AI-, bzw... [mehr]. -

NVIDIA und Mellanox wollen Supercomputer per AI schützen

Zusammen mit der Ampere-Architektur bzw. der gigantischen GA100-GPU präsentierten NVIDIA und Mellanox auch die ersten Früchte der engeren Zusammenarbeit durch den Kauf des israelischen Netzwerkspezialisten. In den DGX-Systemen finden sich unter andere gleich mehrere ConnectX-6 Lx SmartNICs von Mellanox. Die EGX A100 ist eine Erweiterungskarte mit GA100-GPU ist direkt mit den ConnectX-6 Lx SmartNICs bestückt. Heute nun kündigt... [mehr]

Zusammen mit der Ampere-Architektur bzw. der gigantischen GA100-GPU präsentierten NVIDIA und Mellanox auch die ersten Früchte der engeren Zusammenarbeit durch den Kauf des israelischen Netzwerkspezialisten. In den DGX-Systemen finden sich unter andere gleich mehrere ConnectX-6 Lx SmartNICs von Mellanox. Die EGX A100 ist eine Erweiterungskarte mit GA100-GPU ist direkt mit den ConnectX-6 Lx SmartNICs bestückt. Heute nun kündigt... [mehr] -

Zwei Cerebras CS-1 für den AI-Supercomputer Neocortex

Bereits ausführlich haben wir in der Vergangenheit über die Wafer Scale Engine (WSE) von Cerebras berichtet. Es handelt sich dabei um einen gigantischen Chip mit einer Fläche von 46.225 mm² – 215 x 215 mm. In der Fertigung wird dazu die maximale Fläche für ein Rechteck aus einer 300-mm-Wafer herausgeholt. Die Fertigung findet bei TSMC statt. Das System, welches eine solche WSE verwendet, ist das CS-1 getaufte System... [mehr]

Bereits ausführlich haben wir in der Vergangenheit über die Wafer Scale Engine (WSE) von Cerebras berichtet. Es handelt sich dabei um einen gigantischen Chip mit einer Fläche von 46.225 mm² – 215 x 215 mm. In der Fertigung wird dazu die maximale Fläche für ein Rechteck aus einer 300-mm-Wafer herausgeholt. Die Fertigung findet bei TSMC statt. Das System, welches eine solche WSE verwendet, ist das CS-1 getaufte System... [mehr] -

Chips designen Chips: Machine Learning übernimmt das Floorplanning

Mit dem Chip Design with Deep Reinforcement Learning haben einige Forscher bei Google AI, genauer gesagt dem Brain Team, eine selbstlernende Methode für das Floorplaning von Chips vorgestellt. Moderne Chip-Architekturen befinden sich über Jahre in der Entwicklung. Je nach Größe des Projekts und der Auslegung vergehen zwischen zwei und fünf Jahren. Heute bereits zu wissen, welche Anforderungen in zwei bis fünf Jahren an das Design... [mehr]

Mit dem Chip Design with Deep Reinforcement Learning haben einige Forscher bei Google AI, genauer gesagt dem Brain Team, eine selbstlernende Methode für das Floorplaning von Chips vorgestellt. Moderne Chip-Architekturen befinden sich über Jahre in der Entwicklung. Je nach Größe des Projekts und der Auslegung vergehen zwischen zwei und fünf Jahren. Heute bereits zu wissen, welche Anforderungen in zwei bis fünf Jahren an das Design... [mehr] -

Star Trek Voyager per AI auf 4K gebracht

Bereits häufiger haben wir über die Möglichkeiten der Machine-Learning-Anwendungen berichtet, altes Bildmaterial zu verbessern. Den Anfang machte ein Versuch mit Star Trek Deep Space Nine, zuletzt wurde aber auch ein altes Schwarz-Weiß-Video in ein 4K@60FPS-Format gebracht. Auf Reddit wurden nun die Ergebnisse einer solchen Bearbeitung einer alten Star-Trek-Voyager-Folge präsentiert. Diese wurde vom DVD-Format auf ein 4K... [mehr]

Bereits häufiger haben wir über die Möglichkeiten der Machine-Learning-Anwendungen berichtet, altes Bildmaterial zu verbessern. Den Anfang machte ein Versuch mit Star Trek Deep Space Nine, zuletzt wurde aber auch ein altes Schwarz-Weiß-Video in ein 4K@60FPS-Format gebracht. Auf Reddit wurden nun die Ergebnisse einer solchen Bearbeitung einer alten Star-Trek-Voyager-Folge präsentiert. Diese wurde vom DVD-Format auf ein 4K... [mehr] -

NVIDIA DLSS 2.0: Ein AI-Upscaling wie von Anfang an geplant

Neben der Vorstellung bzw. Teilnahme an DirectX 12 Ultimate hat NVIDIA im Rahmen der Game Developers Conference eine Neuerung zum Deep Learning Super Sampling verkünden. Als DLSS 2.0 hat man den bisherigen Ansatz für das Training und Inferencing weitestgehend verworfen und startet von Vorne. Das Ergebnis: Eine Bildqualität für ein Upscaling, die Tatsächlich besser als je zuvor aussieht. Wir haben uns die Details... [mehr]

Neben der Vorstellung bzw. Teilnahme an DirectX 12 Ultimate hat NVIDIA im Rahmen der Game Developers Conference eine Neuerung zum Deep Learning Super Sampling verkünden. Als DLSS 2.0 hat man den bisherigen Ansatz für das Training und Inferencing weitestgehend verworfen und startet von Vorne. Das Ergebnis: Eine Bildqualität für ein Upscaling, die Tatsächlich besser als je zuvor aussieht. Wir haben uns die Details... [mehr] -

Neuronaler Chip: Intel bringt Loihi das Riechen bei (Update)

Intel treibt die Entwicklung seines neuronalen Chips Loihi voran. Dazu hat man 72 chemische Sensoren an seine Testplattform angebunden, um über ein Deep-Learning-Netzwerk eine Analyse der Sensordaten zu ermöglichen. Dazu musste das Netzwerk zunächst einmal trainiert werden, was üblicherweise 3.000 Trainingsdurchläufe voraussetzt. Der Grund dafür ist, dass eine gesicherte Erkennung über die Sensordaten gewährleistet werden sollte. Im Falle des... [mehr]

Intel treibt die Entwicklung seines neuronalen Chips Loihi voran. Dazu hat man 72 chemische Sensoren an seine Testplattform angebunden, um über ein Deep-Learning-Netzwerk eine Analyse der Sensordaten zu ermöglichen. Dazu musste das Netzwerk zunächst einmal trainiert werden, was üblicherweise 3.000 Trainingsdurchläufe voraussetzt. Der Grund dafür ist, dass eine gesicherte Erkennung über die Sensordaten gewährleistet werden sollte. Im Falle des... [mehr] -

Machine Learning macht aus altem S/W-Video 4K60FPS

Alte Filmaufnahmen haben durchaus ihren Charme und können je nach Genre dazu beitragen, dass bestimmte Filme und Serien nur in der jeweiligen Optik funktionieren. Doch in Zeiten immer hochauflösender Inhalte fallen so manche Filmsequenzen optisch weiter zurück. Die Ankunft eines Dampfzuges in La Ciotat ist eine der ikonischsten Aufnahmen der Filmgeschichte. Die 1896 von Auguste und Louis Lumière gemachten Aufnahmen stellten zur... [mehr]

Alte Filmaufnahmen haben durchaus ihren Charme und können je nach Genre dazu beitragen, dass bestimmte Filme und Serien nur in der jeweiligen Optik funktionieren. Doch in Zeiten immer hochauflösender Inhalte fallen so manche Filmsequenzen optisch weiter zurück. Die Ankunft eines Dampfzuges in La Ciotat ist eine der ikonischsten Aufnahmen der Filmgeschichte. Die 1896 von Auguste und Louis Lumière gemachten Aufnahmen stellten zur... [mehr] -

ISC19: Intel sieht HPC-Markt im Wandel – neuer HPL-AI-Benchmark für mehr Klarheit

Regelmäßig zur Supercomputing im November und zur International Supercomputing Conference im Juni wird eine neue Liste der Top500-Supercomputer vorgestellt. Dies ist auch am gestrigen Tag, dem ersten der ISC19 in Frankfurt geschehen. In Gesprächen mit einigen Herstellern ist schnell zu spüren, dass die Top500-Liste zunehmend in den Hintergrund des Interesses rückt und dies hat gleich mehrere Gründe. Zudem gibt es einen Wandel in der Auslegung... [mehr]

Regelmäßig zur Supercomputing im November und zur International Supercomputing Conference im Juni wird eine neue Liste der Top500-Supercomputer vorgestellt. Dies ist auch am gestrigen Tag, dem ersten der ISC19 in Frankfurt geschehen. In Gesprächen mit einigen Herstellern ist schnell zu spüren, dass die Top500-Liste zunehmend in den Hintergrund des Interesses rückt und dies hat gleich mehrere Gründe. Zudem gibt es einen Wandel in der Auslegung... [mehr] -

Qualcomm stellt dedizierte AI-Beschleunigerhardware vor

In seinen eigenen SoCs verbaut Qualcomm schon seit geraumer Zeit dedizierte Inferencing-Hardware und beschleunigt damit beispielsweise Mechanismen zur Verbesserung von Bildern, der Spracherkennung und in weiteren Anwendungsbereichen. Doch nun scheint Qualcomm einen Schritt weiter gehen zu wollen und kündigt auf dem AI Day in San Francisco dedizierte Inferencing-Hardware für 2020 an. Qualcomm sieht in diesem Markt ein Potential von 17... [mehr]

In seinen eigenen SoCs verbaut Qualcomm schon seit geraumer Zeit dedizierte Inferencing-Hardware und beschleunigt damit beispielsweise Mechanismen zur Verbesserung von Bildern, der Spracherkennung und in weiteren Anwendungsbereichen. Doch nun scheint Qualcomm einen Schritt weiter gehen zu wollen und kündigt auf dem AI Day in San Francisco dedizierte Inferencing-Hardware für 2020 an. Qualcomm sieht in diesem Markt ein Potential von 17... [mehr] -

NVIDIA will 3D-Welten durch AI erzeugen lassen

Der Begriff prozeduales Leveldesign ist vielen sicherlich von Spielen wie No Man's Sky und Star Citizen bekannt. Dahinter verbirgt sich die prozedurale Synthese oder prozedurale Generierung von Inhalten wie Texturen, 3D-Objekten und Musik in einem vom Entwickler gesteckten Rahmen, um nicht eine zu 100 % vordefinierte Welt anfertigen zu müssen. Im Falle der beiden Weltraum-Abenteuer ist es nur so möglich hundert oder gar tausenden... [mehr]

Der Begriff prozeduales Leveldesign ist vielen sicherlich von Spielen wie No Man's Sky und Star Citizen bekannt. Dahinter verbirgt sich die prozedurale Synthese oder prozedurale Generierung von Inhalten wie Texturen, 3D-Objekten und Musik in einem vom Entwickler gesteckten Rahmen, um nicht eine zu 100 % vordefinierte Welt anfertigen zu müssen. Im Falle der beiden Weltraum-Abenteuer ist es nur so möglich hundert oder gar tausenden... [mehr] -

Neuronale Entwicklerplattform: Pohoiki Springs verwendet 768 Loihi-Chips

Auch wenn die Entwicklung neuer CPU-Architekturen bei Intel derzeit stillzustehen scheint, so macht der Chipgigant in anderen Bereichen große Fortschritte. Dazu gehört der im September 2017 vorgestellte Loihi-Chip, der aus 130.000 „Neuronen" aus Silizium besteht, die sich abhängig von der jeweiligen Anwendung selbstständig verknüpfen sollen. In einem ersten Schritt ging es für Intel darum das Potential der Hardware auszuloten und... [mehr]

Auch wenn die Entwicklung neuer CPU-Architekturen bei Intel derzeit stillzustehen scheint, so macht der Chipgigant in anderen Bereichen große Fortschritte. Dazu gehört der im September 2017 vorgestellte Loihi-Chip, der aus 130.000 „Neuronen" aus Silizium besteht, die sich abhängig von der jeweiligen Anwendung selbstständig verknüpfen sollen. In einem ersten Schritt ging es für Intel darum das Potential der Hardware auszuloten und... [mehr] -

Füttern der Bestie: PNY PURE AIRI verbindet HPC mit Storage und Netzwerk

Seit einigen Jahren bietet NVIDIA Systeme für das High Performance Computing und Deep-Learning-Anwendungen an. Über seine Partner wie IBM, Dell, HPE und einige andere sind entsprechende Server ebenfalls für entsprechende Anwendungen verfügbar. PNY ist seit 2003 der exklusive Partner für den Verkauf der Hardware von NVIDIA im Bereich von Quadro- und Tesla-Karten und bietet seit einiger Zeit auch auf Kundenwunsch gefertigte HPC-Server an. Dieses... [mehr]

Seit einigen Jahren bietet NVIDIA Systeme für das High Performance Computing und Deep-Learning-Anwendungen an. Über seine Partner wie IBM, Dell, HPE und einige andere sind entsprechende Server ebenfalls für entsprechende Anwendungen verfügbar. PNY ist seit 2003 der exklusive Partner für den Verkauf der Hardware von NVIDIA im Bereich von Quadro- und Tesla-Karten und bietet seit einiger Zeit auch auf Kundenwunsch gefertigte HPC-Server an. Dieses... [mehr]