Werbung

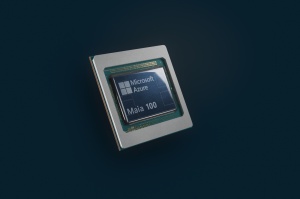

Auf der hauseigenen IGNITE-Konferenz hat Microsoft zwei eigene Chips für den Cloud-Einsatz vorgestellt. Damit will man sich offenkundig unabhängiger von externen Zulieferern wie Intel sowie NVIDIA machen und kann die Hardware zudem auf die eigenen Bedürfnisse anpassen. Bei den zwei Chips handelt es sich um den Azure Maia 100 AI getauften Beschleuniger und einen Azure Cobalt 100 getauften Prozessor.

Fertigen lässt Microsoft die Chips in einem aktuellen Fertigungsverfahren bei TSMC – nennt aber nur wenige Details. So findet die Fertigung offenbar in 5 nm statt und der Azure Maia 100 AI soll auf 105 Milliarden Transistoren kommen. Die ersten Server werden aktuell bereits mit den Chips bestückt und in einem Azure-Rechenzentrum in Quincy, im US-Bundesstaat Washington, aufgebaut. Ausgelegt ist der Azure Maia 100 AI, wie der Name schon sagt, auf AI-Anwendungen in der Cloud.

Gekühlt wird der Azure Maia 100 AI mittels Wasserkühlung. Microsoft wählt dazu einen integrierten Ansatz, bei dem die Wasserkühlung mitsamt Chiller im gleichen Rack sitzt. Es handelt sich aber auch nicht um eine Standardgröße oder ein Standardlayout für das Rack.

Auf den Fotos des Packages des Azure Maia 100 AI zu erkennen ist ein Multi-Chip-Design bestehend aus einem zentralen Compute-Chiplet und vier HBM-Chips. Dabei handelt es sich vermutlich um HBM2E, da HBM3E in fast quadratischen Chips gefertigt wird.

Die Azure Cobalt 100 CPU hingegen ist auf Effizienz ausgelegt. Sie basiert auf auf einem ARM Neoverse Compute Subsystem (CSS) und verwendet 128 Kerne. Welche Kerne hier genau verwendet werden, ist nicht bekannt.

Microsoft scheut den Vergleich

Keinerlei Angaben macht Microsoft zur Rechenleistung des Azure Maia 100 AI oder Azure Cobalt 100. Wir sind daher gespannt, ob zumindest der Azure Maia 100 AI irgendwann in den MLPerf-Ergebnissen auftaucht – analog zu den Einreichungen von Google mit dem TPU-v5e. Bisher nimmt Microsoft hier mit seiner Azure-Cloud bestückt mit H100-Beschleunigern von NVIDIA teil. Diese kommen auch für den Supercomputer Eagle zum Einsatz, der die neue Nummer drei bei den Supercomputern ist und von Microsoft als Azure-Cloud-System zusammengestellt wurde.

AMD und NVIDIA sind weiterhin Partner

Microsoft wird auf absehbare Zeit aber weiterhin ein Hauptabnehmer der Beschleuniger von NVIDIA sein. Dies gilt auch für die Prozessoren. Die Cloud-Instanzen von Azure sind breit für etliche Anwendungsbereiche aufgestellt. Kunden verlangen nach den NVIDIA-Beschleunigern, also bietet Microsoft diese an. In wie weit ein Azure Maia 100 AI den Zukauf bei NVIDIA reduzieren kann, lässt sich kaum abschätzen.

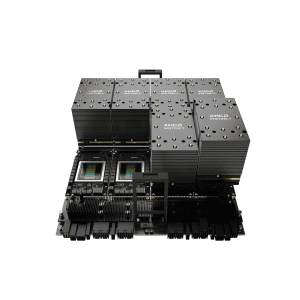

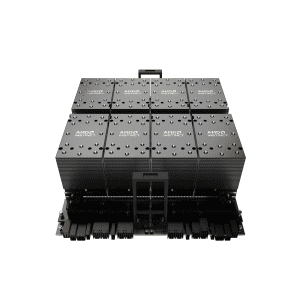

Zudem geben AMD und Microsoft heute eine weitere Zusammenarbeit bekannt. In der NG-Serie einiger neuer VMs kommen EPYC-Prozessoren zum Einsatz. Zukünftig will Microsoft zudem eine ND MI300x v5 Virtual Machine anbieten, welche auf AMDs Instinct MI300X Beschleuniger setzt.