Werbung

Google hat mit dem Axion einen weiteren, selbstentwickelten Chip vorgestellt, den man in den eigenen Rechenzentren einsetzt und per Google Cloud Kunden anbieten möchte. Axion basiert auf dem Neoverse-V2-Design von ARM, wobei nicht klar ist, über wie viele Kerne der Prozessor verfügt. Das Neoverse-V2-Design wird auch von NVIDIA für die Grace-CPU verwendet.

Axion soll in Kürze in den eigenen C4A-Instanzen angeboten werden. Mit diesen richtet sich Google Cloud vor allem an den Bedarf an Web- und App-Server, Microservices, Databases, In-Memory Caches, Datenanalyse, Media-Processing sowie das CPU-basierte Training und Inferencing von KI-Modellen.

Laut Google bietet Axion eine um 30 % höhere Leistung im Vergleich zu den sonst hier verwendeten Prozessoren in der eigenen Cloud. Darüber hinaus spricht man von einer um 50 % höheren Leistung und 60 % besseren Effizienz gegenüber sonst verwendeten x86-Instanzen. Die C4A-Instanzen auf Basis des Axion sollen in Kürze zur Verfügung stehen. Interessierte Kunden können sich bereits heute für die Vorschau anmelden.

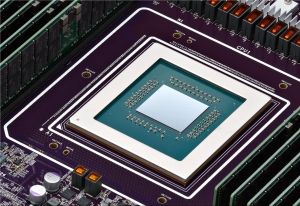

Für das Training und das Inferencing der eigenen KI-Modelle verwendet Google seine neuesten TPUv5p. Diese hat man ebenfalls In-House entwickelt. Im Vergleich zu den TPUv4 können die aktuellen Chips in Cluster mit bis zu 8.960 Chips zusammengefasst werden. Beim Vorgänger waren es 4.096.

Google Cloud wird HGX B200 und GB200 NVL72 Hardware verwendet

Die eigenen TPU-Pods reichen nicht aus und so geben NVIDIA und Google heute eine weitere Partnerschaft bekannt. Ab dem kommenden Jahr wird Google in seiner Cloud Systeme mit NVIDIAs HGX B200 und GB200 NVL72 auf Basis der Blackwell-GPU anbieten. HGX-B200-Server sind für KI-, Datenanalyse- und HPC-Computing gedacht, während GB200 NVL72 für das Training von KI-Modellen mit Billionen von Parametern sowie ein möglichst schnelles Inferencing vorgesehen ist.

Im aktuellen Jahr wird Google Cloud sein Angebot an Instanzen mit H100-Beschleunigern erweitern. Als A3 Mega können Instanzen mit tausenden Beschleunigern verwendet werden.