Werbung

Unser Technik-Check für Control hat gezeigt, dass das Spiel optisch von den RTX-Effekten profitiert und diese auch sinnvoll eingesetzt werden, die Effekte aber auch ordentlich an Leistung kosten. Auf der anderen Seite erreicht die Anwendung von Deep Learning Super Sampling (DLSS) eine Anhebung der FPS auf das Ursprungsniveau, ohne dass die Grafikqualität derart leidet, wie das bei bisherigen DLSS-Implementierungen der Fall war.

Unsere Vermutung war also, dass NVIDIA weitere Verbesserungen am Algorithmus vorgenommen hat, die dazu führen, dass die Bildqualität mit DLSS deutlich gesteigert werden konnte. Ein Blog-Beitrag von NVIDIA und eine Analyse von Digital Foundry unterstützen diese These, wenngleich sich NVIDIA nicht vollständig in die Karte schauen lässt.

Bevor wir die Thematik nun genauer ausführen, noch ein paar Worte zur Funktionsweise von DLSS. NVIDIA trainiert ein neurales Netzwerk mit Spielen, deren Frames mit 64 Samples pro Pixel berechnet werden. Dies stellt die Darstellung im Idealzustand in maximal möglicher Qualität dar. In den Spielen mit DLSS-Unterstützung erfolgt das eigentliche Rendering mit einer niedrigeren Auflösung, als die vorhergesehene Ausgabe-Auflösung. Der gerenderte Frame in niedrigerer Auflösung wird mit den Ergebnissen des neuronalen Netzwerks verglichen und daraus ein neuer Frame zusammengebaut. Dieser soll dann möglichst nahe an die Bildqualität der nativen Auflösung herankommen.

Control bietet mehr Flexibilität für DLSS

Anders als bei den Spielen mit DLSS-Unterstützung in der Vergangenheit, konnten wir mit allen drei GeForce-RTX-Karten das DLSS für alle drei Ausgangsauflösungen aktivieren. In Control gibt es also keinerlei Einschränkungen für die Nutzung von DLSS. Auch müssen die RTX-Effekte nicht aktiv sein, um DLSS nutzen zu können. Aufgrund der Unterscheidung von Ausgabe- und Render-Auflösung im Menü kennen wir nun auch die Auflösung, in der NVIDIA die Karten intern rechnen lässt.

| Ausgangs-Auflösung | Render-Auflösung |

| 1.920 x 1.080 Pixel | 1.280 x 720 Pixel |

| 2.560 x 1.440 Pixel | 1.706 x 960 Pixel |

| 3.840 x 2.160 Pixel | 2.560 x 1.440 Pixel |

Wird also bei einer Ausgangsauflösung von 1.920 x 1.080 Pixeln das DLSS aktiviert, rendert die Hardware die Frames in 1.280 x 720 Pixeln. Für eine Ausgangsauflösung von 2.560 x 1.440 sprechen wir von einer Berechnung in 1.706 x 960 Pixeln und wer auf UHD spielt, berechnet die Frames in 2.560 x 1.440 Pixel.

Es ist aber auch möglich, die Render-Auflösung manuell anzupassen. Im Controler-Spieleordner befindet sich eine renderer.ini-Datei und diese kann manuell angepasst werden. Durch Wahl der "Output Resolution" und "Render Resolution" wird das DLSS-Level, also der Upscaling-Faktor, festgelegt. So lange man die Seitenverhältnisse beibehält, ergeben sich daraus auch keinerlei Probleme. Control bietet bei den Einstellungen also viel mehr Flexibilität für das DLSS, als dies bisher der Fall war. Allerdings muss dazu eine Textdatei angepasst werden. Schöner wäre es natürlich, wenn dies direkt in den Grafikeinstellungen des Spiels möglich wäre.

DLSS besser als Engine-Upscaling

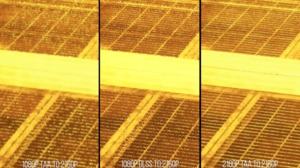

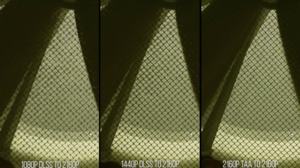

Digital Foundry hat sich die Darstellungsqualität in Control genauer angeschaut. Dabei in Betracht gezogen werden die native Darstellung, ein durch das Spiel angebotenes Upscaling, die Anwendung von TAA und eben DLSS mit verschiedenen Upscaling-Schritten.

Das Upscaling im Spiel selbst (von 1080p auf 2160p) hat im Zusammenspiel mit TAA zum Beispiel die Problematik der flackernden dünnen Linien. Erst in nativer Auflösung (2160p) mit TAA treten solche Fehler nicht mehr auf. Mit aktiven RTX-Effekten ist Control in 2160p aber nur noch mit einer GeForce RTX 2080 Ti als spielbar anzusehen. Entsprechend stellt DLSS eine Alternative dar. Es ermöglicht ein Upscaling von 1080p auf 2160p ohne das eine Grafikkarte für mehr als 1.000 Euro fällig wird, bietet in einigen Bereichen aber sogar Vorteile in der Darstellung. So sind Kanten deutlich schärfer und einige Details, die beim Upscaling verloren gehen, werden durch DLSS wieder hinzugefügt.

Mehr als in allen Spielen zuvor stellt die Umsetzung von DLSS in Control eine Verbesserung der Darstellungsqualität im Zusammenspiel mit einem Upscaling dar. Eine Rendering in nativer Auflösung bietet noch immer die beste Darstellung, frisst im Falle von Control aber auch enorme Ressourcen.

Hier kommt dann auch der bereits erwähnte Blog-Beitrag von NVIDIA ins Spiel. NVIDIA beschriebt DLSS hier als einen "Image Processing Algorithm", also einen Algorithmus zur Bildverbesserung. Weiter heißt es:

"(...) we started working on a new AI research model that used these artifacts to recreate details that would otherwise be lost from the final frame.

This AI research model has made tremendous progress and produces very high image quality. However, we have work to do to optimize the model's performance before bringing it to a shipping game.

Leveraging this AI research, we developed a new image processing algorithm that approximated our AI research model and fit within our performance budget. This image processing approach to DLSS is integrated into Control, and it delivers up to 75% faster frame rates."

Die Frage die sich nun stellt ist, ob das DLSS in Control überhaupt noch auf einem AI-Modell basiert oder inzwischen eine Stufe zurückgefahren wurden hinsichtlich der Automatik, die ein AI-Modell suggeriert. Der Blog-Beitrag lässt sich auf vielerlei Wege interpretieren. Für Aufsehen sorgt folgender Abschnitt:

"Our next step is optimizing our AI research model to run at higher FPS. Turing’s 110 Tensor teraflops are ready and waiting for this next round of innovation."

Dies kann so interpretiert werden, als würden aktuell noch nicht die vollen 110 TOPS an Rechenleistung der Tensor Cores verwendet werden. In der Tat ist es schwer abzuschätzen, wie hoch die Auslastung der verschiedenen Funktionseinheiten ist. Die Tools lesen ein GPU-Last aus. Unklar ist ab, wie hoch die Auslastung der RT Cores und Tensor Cores im einzelnen ist. Schnell kamen also die Gerüchte auf, NVIDIA würde die Tensor Cores aktuell kaum bis gar nicht nutzen. Stattdessen würden FP16-Rechenoperationen über die Shadereinheiten laufen. Überprüfen lassen sich diese Mutmaßungen aktuell nicht.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen

DLSS hat noch viel Potenzial

DLSS hat ein großes Potenzial und zeigt dies in ersten Ansätzen in Control. Das NVIDIA erst jetzt mit DLSS so weit ist, wie man schon im Sommer des letzten Jahres sein wollte, daran trägt natürlich alleine NVIDIA die Schuld. An den DLSS-Umsetzungen in Battlefield V, Metro Exodus, Final Fantasy XV, Shadow of the Tomb Raider und Anthem haben wir immer die verminderte Darstellungsqualität bemängelt. Erst bei Control zeigten wir uns überzeugt davon, dass DLSS eine Verbesserung bringen kann.

Und hier hat NVIDIA noch viel Potenzial. Auch dieses kündigte man in Form von DLSS x2 bereits im vergangenen Sommer an. Aktuell trainiert NVIDIA mit Trainingsdaten bestehend aus einem 64x Sampling pro Pixel auf eine Ausgangsauflösung von 2160p. Denkbar wäre diese zu verdoppelt bzw. das Sampling weiter zu erhöhen. Aufgrund des aktuellen Samplings kann das Resultat noch nicht mit einem direkten Rendering auf der nativen Auflösung gleichgesetzt werden, nähert sich diesem abhängig von den Trainingsdaten und den Optimierungen aber inzwischen stark an. NVIDIA scheint aber auch manuelle Verbesserungen vorzunehmen und verlässt sich nicht gänzlich auf das AI-Modell. Dies wird letztendlich als "Image Processing Algorithm" beschrieben.

Um die Ergebnisse weiter zu verbessern, müssten die Trainingsdaten theoretisch unendlich groß sein und das Deep-Learning-Netzwerk ebenso unendlich lange trainiert werden. Man wird also im Vergleich zu den Trainingsdaten immer irgendwelche Artefakte und Ungenauigkeiten haben – die Frage ist, ob diese auch sichtbar sind bzw. ob es eine weitere Methode (sprich den "Image Processing Algorithm") gibt, um diese Effekte zu minimieren. Bei Control gelingt dies schon ganz gut.