HWL News Bot

News

Thread Starter

- Mitglied seit

- 06.03.2017

- Beiträge

- 121.194

... weiterlesen

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Sag das mal der Silent-Fraktion.Sie haben mit der "Eagle" doch auch ein Modell mit nur zwei Lüftern im Angebot. Sie müssen da also nichts neu designen. Sie könnten sich dieses Triple Fan Monster einfach sparen, weil völlig unnötig.

Ich soll mir das also selbst sagen?Sag das mal der Silent-Fraktion.

Und mit der Powercolor mit 1 Lüfter hat man doch was ITX taugliches??

Stimmt, ich denke bei ITX aber eher kleiner, kompakter. In Cases, wo die RX 6500XT reinpasst, passen dann meist auch andere Leistungsklassen à la RX 6800 oder RTX 3080.Dimensions - 179 x 124 x 40 mm, 2-slot

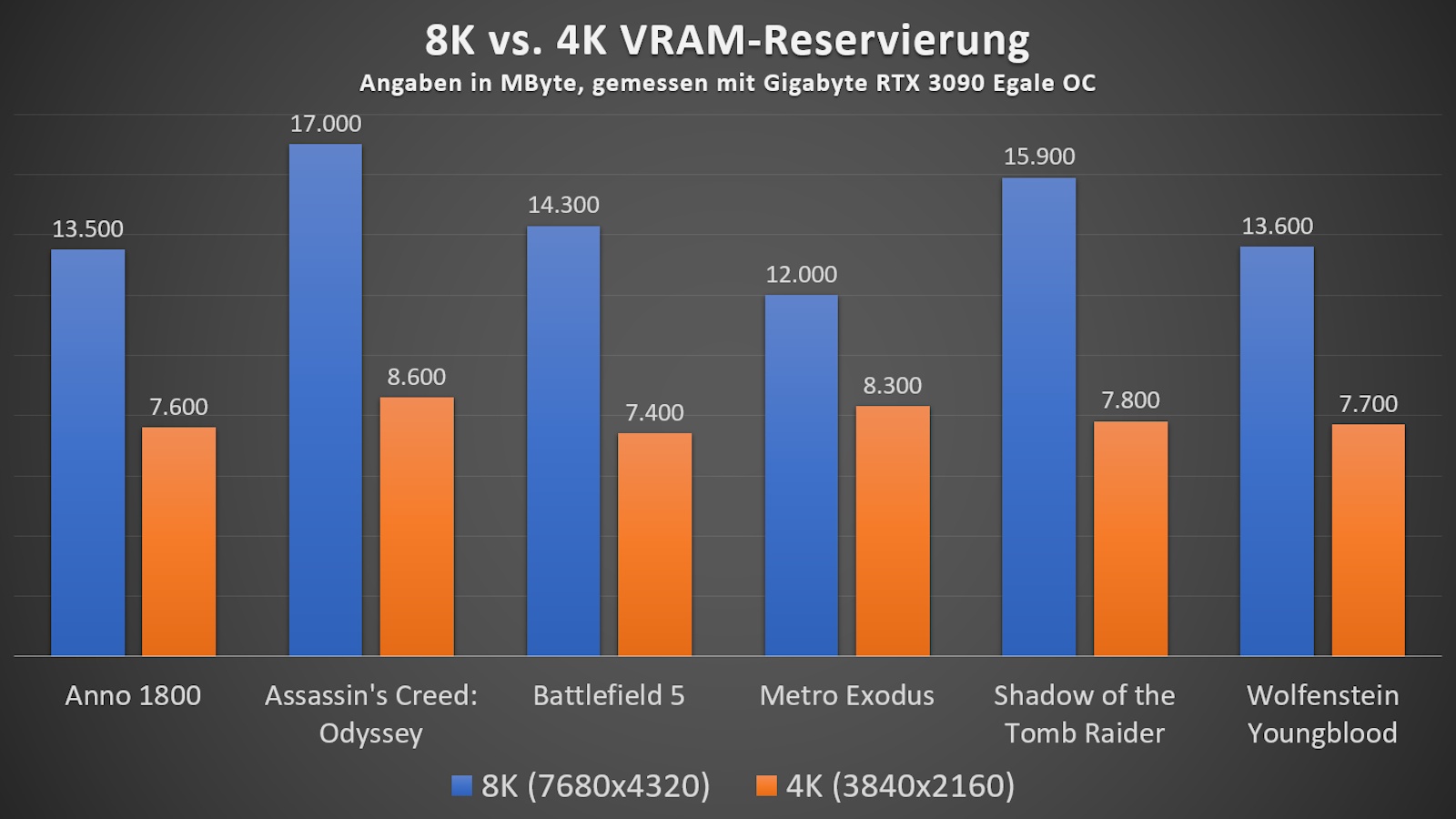

Kommt drauf an, besonders wenn man sich anguckt was wirklich an VRam genutzt wird.Wenn 8GB oder wenigstens 6GB drauf wären..

4GB sind leider wirklich zu wenig, daher uninteressant. Hier wird die 3050 mit 8GB wahrscheinlich wesentlich attraktiver.

Was hast Du da eingestellt?Aber ich, absolut.

Klar ist das eine 1080p Karte, alles andere macht keinen Sinn.

Ich sehe es aber ganz deutlich an meiner aktuellen GTX 1060 welche sogar 6GB VRam hat.

Die reichen auch ganz oft nicht mehr. Aktuelles Beispiel ist Forza Horizon 5. Kommt Regelmäßig Meldung das der Grafikspeicher voll ist.

Die 4GB reichen hinten und vorne nicht. Zumindest nicht, wenn man alles auf Low spielen möchte.

Kann es sein, dass die komplett unbrauchbar fürs Mining ist?

Zu viel beschnitten. Keine 150€ wert.Kann es sein, dass die komplett unbrauchbar fürs Mining ist? Dann würde sie für 200 € ja ganz gut dastehen. Also für den Preis, würd ich sie zur Überbrückung nehmen...

Ist ne typische Karte für billig fertig PCs.ja wegen den 4GB ist sie für gamer und miner quasi unbrauchbar.