Datenmessi bin ich auch (aber gut sortiert)

hab aber angefangen Daten einfach auszulagern - Hab jetzt einfach n kleinen externen Stapel mit alten Samsung 850er, 10TB Daten, alles nochmal gespiegelt auf Magnet.

- im Rechner sind nur noch 2x M.2 - mit Verlängerungskabeln, so das sie direkt vorm Gehäuselüfter sitzen = 30° C

Soviel brauch ich dann doch nie jederzeit verfügbar, komm doch überraschend gut mit meinem 3TB klar, sind nichtmal voll.

Selbst wenn ich mehrfachn falsches Ramdrive Image lade, Platten drosseln selten - passtschon

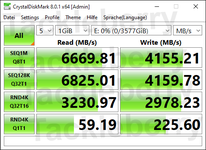

Klar, wenn das nicht reicht - alles was drüber oder mehr bräuchte, würde ich wohl auch nur zu der Samsung PM9A3 greifen wollen.

Sind auch recht weit verbreitet, kenn die und die Vorgänger aus diversen Kundensystemen - sind echt gut, beliebt, zuverlässig.

Was anderes gibs kaum - alles andere ist dann entweder Raid, n ganzer Verbund, halber Schrank, sündhaft teuer.

Klär hätt ich gern 4x 1TB PCI-E 4.0 NVME Raid..aber frag nicht nach Preis^^

Alternativ, Rechner dicker machen - 20x gleiche Programm schließen ?! Warum nicht einfach auflassen ?

Oder es einfach gleich in Ramdrive packen - Rechner einfach nie ausmachen :P Threadripper geht bis 512GB Ram

Oder es einfach gleich in Ramdrive packen - Rechner einfach nie ausmachen :P Threadripper geht bis 512GB Ram

Oder es einfach gleich in Ramdrive packen - Rechner einfach nie ausmachen :P Threadripper geht bis 512GB Ram

Werde aber wohl zwei Moras für die beiden 3090 brauchen und habe keine Ahnung wo ich die hinstellen soll.

Werde aber wohl zwei Moras für die beiden 3090 brauchen und habe keine Ahnung wo ich die hinstellen soll.