sTOrM41

Admiral , HWLUXX Superstar

Thread Starter

- Mitglied seit

- 13.10.2005

- Beiträge

- 22.353

- Details zu meinem Desktop

- Prozessor

- Ryzen 5700X

- Speicher

- 32GB

- Grafikprozessor

- RX 9070

Nach 8 Jahren Team-Red ist mir die Tage beim Sidegrade von R9 290 auf GTX 970 in einigen Spielen etwas reichlich seltsames aufgefallen.

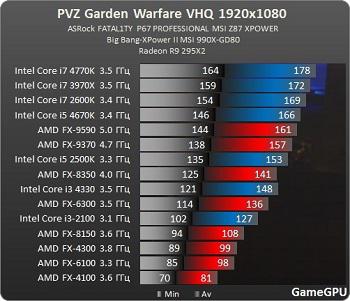

Einige Spiele laufen auf einmal bei CPU Limit deutlich besser, obwohl die R9 290 und GTX 970 prinzipiell ähnlich schnell sind.

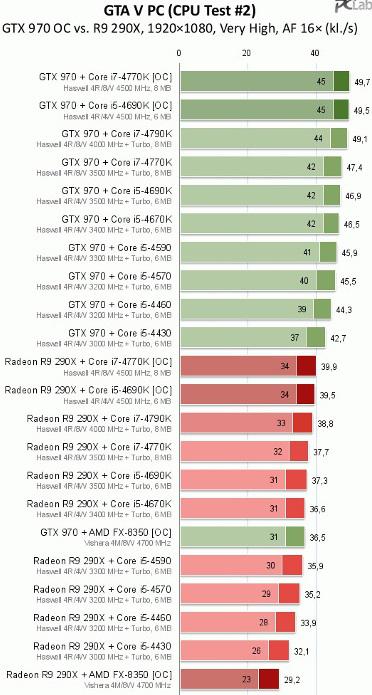

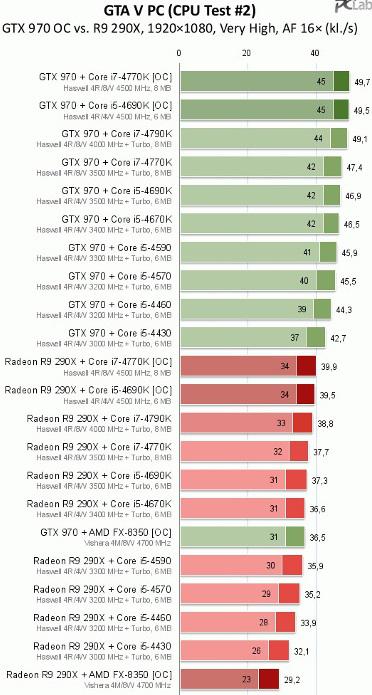

GTA V (mit angepassten grafiksettings) mit meinem FX8320@4,5ghz und der GTX 970 problemlos mit stabilen 60 FPS, mit der R9 290 drops runter auf 45 (ohne das die Graka dabei voll ausgelastet ist! Ergo > CPU Limit)

http://pclab.pl/art57777-24.html

Selbes Spiel in Dying Light, 40 statt 30 FPS im CPU Limit, das bedeutet immerhin 33% bessere FPS.

Enttäuscht wurde ich dann etwas in DayZ, das läuft immer noch genau so schlecht wie vorher. Warum auch immer..

NFS Rivals hat ja nun standardmäßig nen FPS Limit bei 30, lief mit der 290 95% der Zeit auch mit eben diesen 30 FPS, droppte aber immer wieder an der selben Stelle im Dorf auf 24 FPS.

Mit der 970 passierte das nun nicht mehr.

Dann war mir eingefallen das man das FPS Limit in dem Spiel ja auch irgendwie noch deaktivieren konnte ( [Update: 60 Fps möglich] Need for Speed: Rivals im Test mit Benchmarks )

Also dieses mal probiert, die FPS bis 60 unlocked, und dann bin ich bald vom Stuhl gefallen..

An der selben Stelle im Dorf lagen nun 60 FPS an,

das bedeutet 250% bessere FPS im CPU Limit.

Ich hatte das in meinem GTX 970 Review ( http://www.hardwareluxx.de/communit...-vs-powercolor-r9-290-pcs-review-1087784.html) letztens schon mal angesprochen,

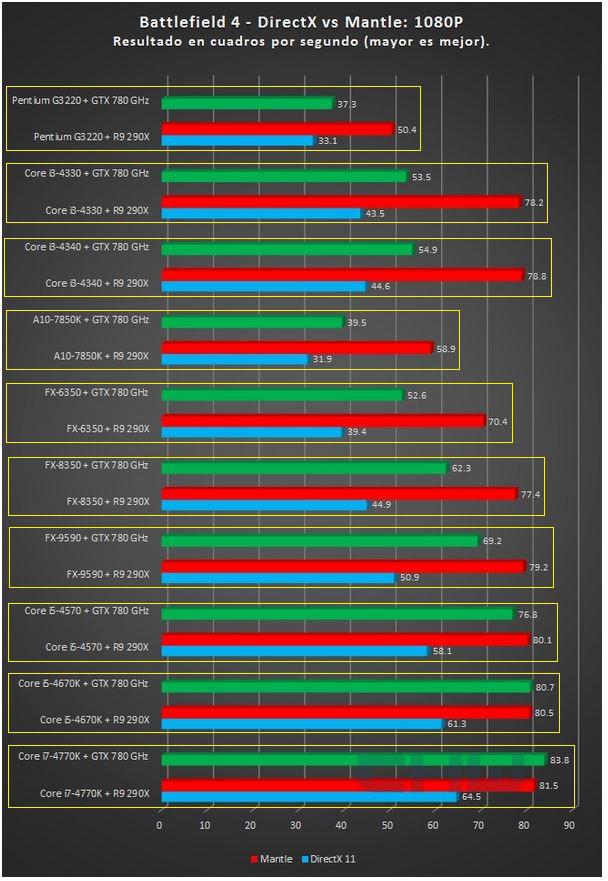

Battlefield 4 läuft mit der 970 in DX11 so gut wie mit der 290 unter Mantle, Hardline läuft gar besser.

Genaue Zahlen habe ich dafür leider keine.

Erinnert sich noch jemand an Project Cars?

Das Spiel lief bei Release kurioserweise bei den grünen mit doppelt so vielen FPS als mit dem entsprechenden roten Gegenstück, völlig absurd eigentlich.

http://pclab.pl/art63572-7.html

Schuld ist vermutlich der DX11 CPU Overhead.

Mittlerweile läuft das Spiel auch auf AMD Karten besser, aber immer noch deutlich schlechter als eigentlich möglich.

http://www.3dcenter.org/news/die-grafikkarten-performance-unter-project-cars

Aufgrund der ganzen Thematik habe ich mal das Internet durchforstet, mit der Hoffnung Quellen zu finden die sich mit dem DX11 CPU Overhead beschäftigen.

Bei guru3d bin ich fündig geworden (Achtung: Englisch!)

High DX11 CPU overhead, very low performance. - Guru3D.com Forums

Rise of the Tomb Raider: PC graphics performance benchmark review - CPU core performance scaling

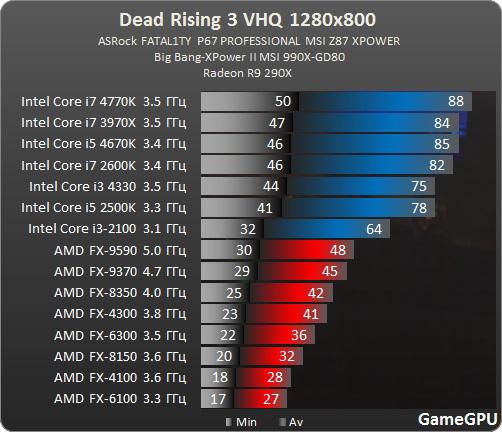

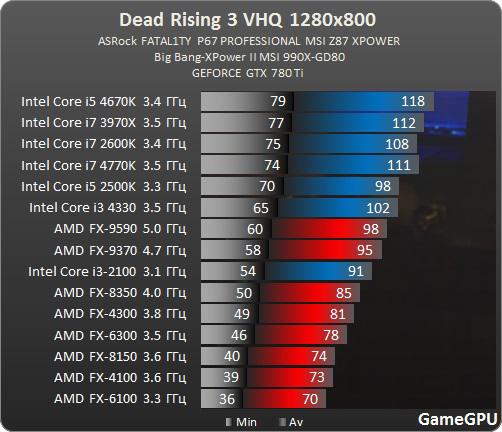

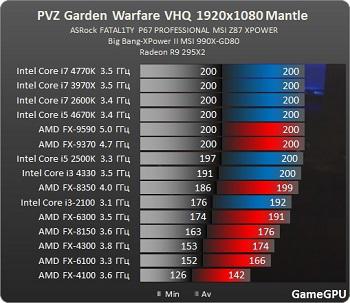

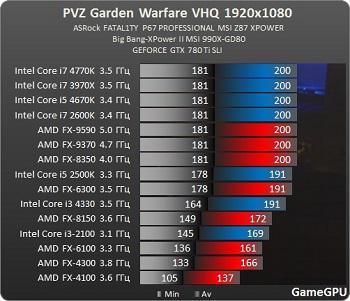

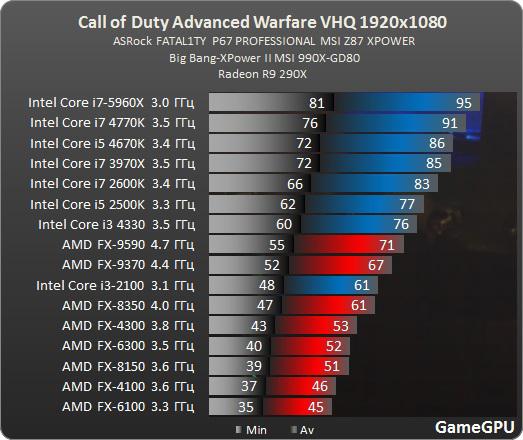

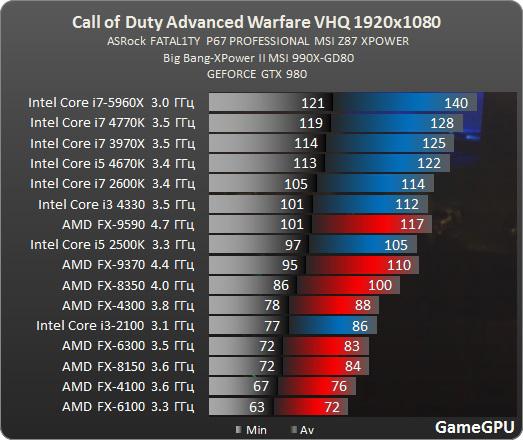

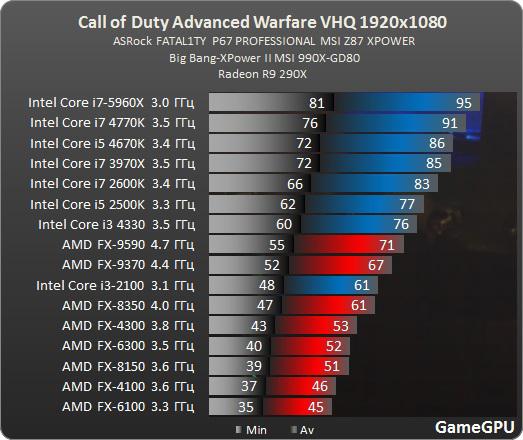

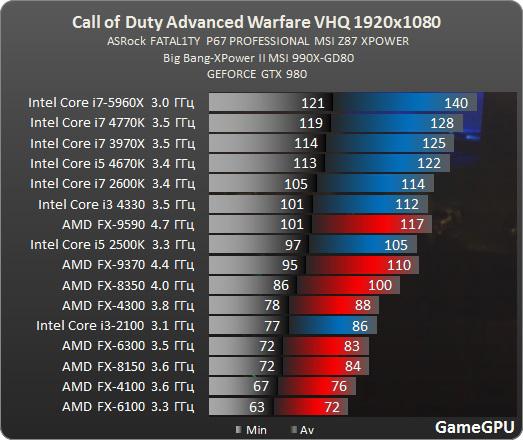

Ab und an bieten auch die Jungs bei gamegpu.ru CPU Benchmarks mit Nvidia und AMD Grafikkarten an die eben diesen DX11 CPU Overhead aufzeigen.

Wie man hier schön sehen kann liefert die GTX980 in Advanced Warfare im CPU Limit etwa 50% bessere FPS als die r9 290X.

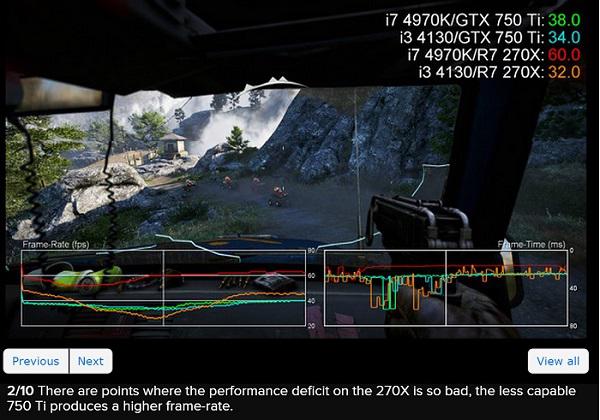

Auch bei eurogamer.net hat man sich dem CPU Limit mal angenommen.

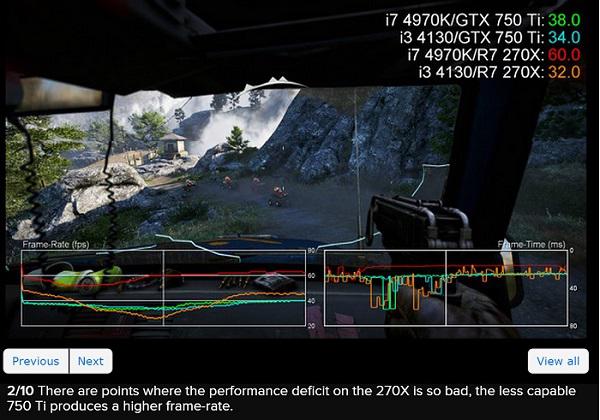

Eine normal deutlich flinkere R9 270X produziert in Kombination mit einer schwachen CPU im CPU Limit auf einmal weniger FPS als die normal deutlich langsamere 750TI.

http://www.eurogamer.de/articles/20...-spieler-ein-game-changer-ist-digital-foundry

Auch den Leuten bei AMD ist dieses vor geraumer Zeit wohl schon mal aufgefallen, so das man sich entschied Mantle zu entwickeln.

Prinzipiell ist dieses ja zu begrüßen, Mantle funktioniert auch tadellos.

Mantle hat aber den Nachteil das es nur in Spielen funktioniert die eben Mantle unterstützen, reine DX11 Spiele tun dieses nur eben nicht.

Die Anzahl an Spielen mit Mantle Support kann man auch Heute, über 1 Jahr nach Mantle Release noch an ein-zwei Händen abzählen.

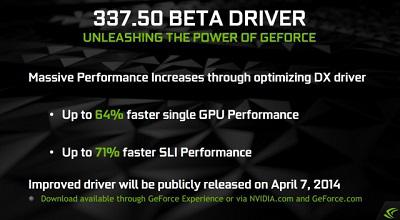

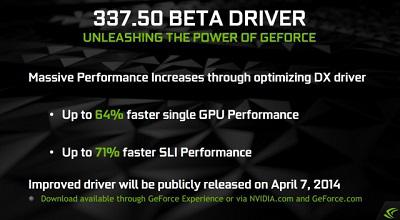

Nvidia stand dann Anfang 2014 wohl reichlich unter Druck, die Roten hatten auf einmal ein Mittel gegen das CPU Limit, und die Green-IT nicht.

Was man dann machte war "leider" schlauer als bei AMD. Statt sich wie die Roten eine neue low-Level API auszudenken packte man das Problem bei der Wurzel und versuche den CPU Overhead, den DX11 produziert eben zu reduzieren.

Geglückt ist das ganze dann scheinbar im April 2014 mit dem Forceware 337.50

Aktuell schaut es so aus das bei AMD die DX12 Performance besser ausfallen könnte, Ashes of Singularity und der 3DMark API Test prognostizieren dieses jedenfalls.

Das ist wie ich finde begrüßenswert.

Man sollte dabei allerdings nicht vergessen das es vermutlich noch eine ganze Weile dauert bis es überhaupt eine breite Masse an Spielen mit DX12 Support gibt.

Bis dieses so weit ist zählen die meisten aktuellen Grafikkarten vermutlich schon wieder zum alten Eisen.

Meine Bitte an AMD: versucht das CPU Overhead in DX11 in den Griff zu bekommen.

Meine Bitte an Hardwareluxx, Computerbase, PCGH und wie ihr euch alle nennt: testet aktuelle Grafikkarten bitte nicht nur auf übertakteten i7, sondern auch mal auf einer CPU die deutlich massentauglicher ist, wie z.B. einem i3, i5, FX6300 oder 8350.

Wenn ihr CPU Benchmarks in Spielen veröffentlicht bitte auf beiden Plattformen, Rot und Grün.

Einige Spiele laufen auf einmal bei CPU Limit deutlich besser, obwohl die R9 290 und GTX 970 prinzipiell ähnlich schnell sind.

GTA V (mit angepassten grafiksettings) mit meinem FX8320@4,5ghz und der GTX 970 problemlos mit stabilen 60 FPS, mit der R9 290 drops runter auf 45 (ohne das die Graka dabei voll ausgelastet ist! Ergo > CPU Limit)

http://pclab.pl/art57777-24.html

Selbes Spiel in Dying Light, 40 statt 30 FPS im CPU Limit, das bedeutet immerhin 33% bessere FPS.

Enttäuscht wurde ich dann etwas in DayZ, das läuft immer noch genau so schlecht wie vorher. Warum auch immer..

NFS Rivals hat ja nun standardmäßig nen FPS Limit bei 30, lief mit der 290 95% der Zeit auch mit eben diesen 30 FPS, droppte aber immer wieder an der selben Stelle im Dorf auf 24 FPS.

Mit der 970 passierte das nun nicht mehr.

Dann war mir eingefallen das man das FPS Limit in dem Spiel ja auch irgendwie noch deaktivieren konnte ( [Update: 60 Fps möglich] Need for Speed: Rivals im Test mit Benchmarks )

Also dieses mal probiert, die FPS bis 60 unlocked, und dann bin ich bald vom Stuhl gefallen..

An der selben Stelle im Dorf lagen nun 60 FPS an,

das bedeutet 250% bessere FPS im CPU Limit.

Ich hatte das in meinem GTX 970 Review ( http://www.hardwareluxx.de/communit...-vs-powercolor-r9-290-pcs-review-1087784.html) letztens schon mal angesprochen,

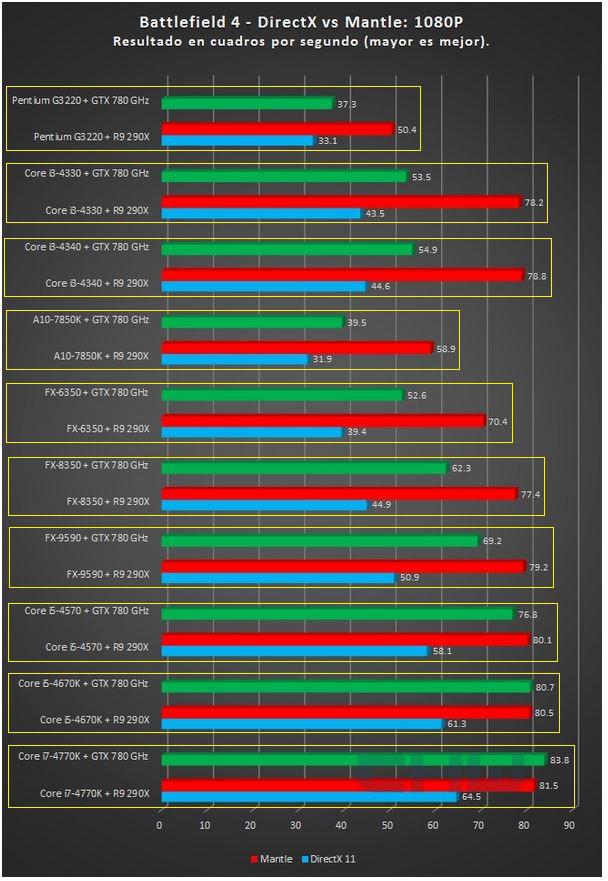

Battlefield 4 läuft mit der 970 in DX11 so gut wie mit der 290 unter Mantle, Hardline läuft gar besser.

Genaue Zahlen habe ich dafür leider keine.

Erinnert sich noch jemand an Project Cars?

Das Spiel lief bei Release kurioserweise bei den grünen mit doppelt so vielen FPS als mit dem entsprechenden roten Gegenstück, völlig absurd eigentlich.

http://pclab.pl/art63572-7.html

Schuld ist vermutlich der DX11 CPU Overhead.

Mittlerweile läuft das Spiel auch auf AMD Karten besser, aber immer noch deutlich schlechter als eigentlich möglich.

http://www.3dcenter.org/news/die-grafikkarten-performance-unter-project-cars

Aufgrund der ganzen Thematik habe ich mal das Internet durchforstet, mit der Hoffnung Quellen zu finden die sich mit dem DX11 CPU Overhead beschäftigen.

Bei guru3d bin ich fündig geworden (Achtung: Englisch!)

High DX11 CPU overhead, very low performance. - Guru3D.com Forums

Rise of the Tomb Raider: PC graphics performance benchmark review - CPU core performance scaling

Ab und an bieten auch die Jungs bei gamegpu.ru CPU Benchmarks mit Nvidia und AMD Grafikkarten an die eben diesen DX11 CPU Overhead aufzeigen.

Wie man hier schön sehen kann liefert die GTX980 in Advanced Warfare im CPU Limit etwa 50% bessere FPS als die r9 290X.

Auch bei eurogamer.net hat man sich dem CPU Limit mal angenommen.

Eine normal deutlich flinkere R9 270X produziert in Kombination mit einer schwachen CPU im CPU Limit auf einmal weniger FPS als die normal deutlich langsamere 750TI.

http://www.eurogamer.de/articles/20...-spieler-ein-game-changer-ist-digital-foundry

Auch den Leuten bei AMD ist dieses vor geraumer Zeit wohl schon mal aufgefallen, so das man sich entschied Mantle zu entwickeln.

Prinzipiell ist dieses ja zu begrüßen, Mantle funktioniert auch tadellos.

Mantle hat aber den Nachteil das es nur in Spielen funktioniert die eben Mantle unterstützen, reine DX11 Spiele tun dieses nur eben nicht.

Die Anzahl an Spielen mit Mantle Support kann man auch Heute, über 1 Jahr nach Mantle Release noch an ein-zwei Händen abzählen.

Nvidia stand dann Anfang 2014 wohl reichlich unter Druck, die Roten hatten auf einmal ein Mittel gegen das CPU Limit, und die Green-IT nicht.

Was man dann machte war "leider" schlauer als bei AMD. Statt sich wie die Roten eine neue low-Level API auszudenken packte man das Problem bei der Wurzel und versuche den CPU Overhead, den DX11 produziert eben zu reduzieren.

Geglückt ist das ganze dann scheinbar im April 2014 mit dem Forceware 337.50

Aktuell schaut es so aus das bei AMD die DX12 Performance besser ausfallen könnte, Ashes of Singularity und der 3DMark API Test prognostizieren dieses jedenfalls.

Das ist wie ich finde begrüßenswert.

Man sollte dabei allerdings nicht vergessen das es vermutlich noch eine ganze Weile dauert bis es überhaupt eine breite Masse an Spielen mit DX12 Support gibt.

Bis dieses so weit ist zählen die meisten aktuellen Grafikkarten vermutlich schon wieder zum alten Eisen.

Meine Bitte an AMD: versucht das CPU Overhead in DX11 in den Griff zu bekommen.

Meine Bitte an Hardwareluxx, Computerbase, PCGH und wie ihr euch alle nennt: testet aktuelle Grafikkarten bitte nicht nur auf übertakteten i7, sondern auch mal auf einer CPU die deutlich massentauglicher ist, wie z.B. einem i3, i5, FX6300 oder 8350.

Wenn ihr CPU Benchmarks in Spielen veröffentlicht bitte auf beiden Plattformen, Rot und Grün.

Zuletzt bearbeitet:

Wollte aber damals Keiner sehen und man geilte sich viel eher am tollen DX11 AMD Umsetzung zu Mantle Umsetzungssprung auf... Zurecht auf der einen Seite. Aber eben nur die halbe Wahrheit.

Wollte aber damals Keiner sehen und man geilte sich viel eher am tollen DX11 AMD Umsetzung zu Mantle Umsetzungssprung auf... Zurecht auf der einen Seite. Aber eben nur die halbe Wahrheit.