Hallo zusammen,

ich habe aktuell noch ein ASUS WS C246 Pro Mainboard und möchte dort einen MegaRAID 9271-8i Controller installieren.

An diesem RAID-Controller sind aktuell 4 SSD-Festplatten abgeschlossen.

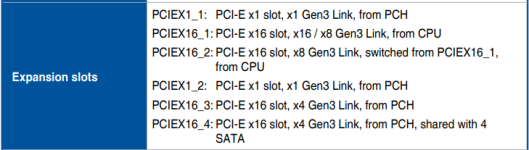

Meine Frage ist nun, in welchen PCIe-Slot wollte ich den Controller am besten einstecken?

Aktuell läuft der Controller im PCIEX16_3

MfG

Pascal

ich habe aktuell noch ein ASUS WS C246 Pro Mainboard und möchte dort einen MegaRAID 9271-8i Controller installieren.

An diesem RAID-Controller sind aktuell 4 SSD-Festplatten abgeschlossen.

Meine Frage ist nun, in welchen PCIe-Slot wollte ich den Controller am besten einstecken?

Aktuell läuft der Controller im PCIEX16_3

MfG

Pascal