BartKoRn

Enthusiast

- Mitglied seit

- 12.06.2013

- Beiträge

- 112

- Ort

- Berlin

- Desktop System

- Define

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5800 X

- Mainboard

- Asus Tuf Gaming X570-Pro Wifi

- Kühler

- EK-AIO 360 D-RGB +4x Noctua NF-A14 PWM chromax.Black (Gehäuse)

- Speicher

- Corsair Vengeance LPX schwarz DIMM Kit 32GB, DDR4-3600, CL18-22-22-42

- Grafikprozessor

- INNO3D GeForce RTX 4080 Super iChill X3

- Display

- Asus Rog Strix PG32UQ + Asus Tuf Gaming VG289Q

- SSD

- Samsung Pro 990 2TB, Samsung Evo Plus 870 2 TB, Samsung Evo 860 2 TB

- Gehäuse

- Fractal Design Define 7

- Netzteil

- Be quiet! Straight Power 11 Platinum 750W

- Keyboard

- Keychron Q6 QMK Custom Mechanical Keyboard

- Mouse

- Keychron M1 Wireless Mouse

- Betriebssystem

- Windows 11 Pro 20H2

- Webbrowser

- Google Chrome

- Internet

- ▼100 MBit ▲45 MBit

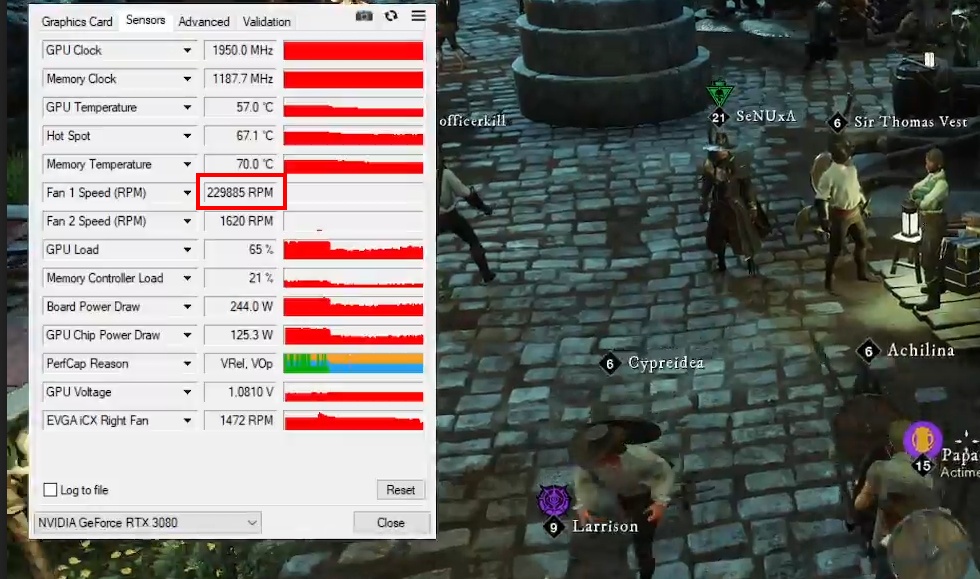

Bin jetzt quasi 3 Tage am dauer daddeln mit einer EVGA 3080 XC3 UG und soweit Problemlos