Nemetron

Experte

Thread Starter

- Mitglied seit

- 31.12.2021

- Beiträge

- 1.294

Hallo zusammen,

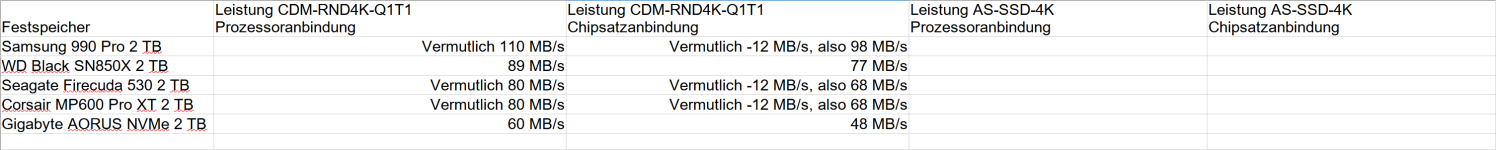

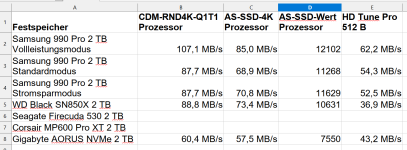

hier nun der Faden, welche SSD denn nun aktuell die beste PCIE4-SSD ist. Wichtig beim Test ist auch breit zu testen. Allgemein kann man sagen, dass der Anschluss der SSD an den Prozessor viel bringt und deutlich besser ist als am Chipsatz. Nimmt man die 4K-Werte zur Hand, dann verlierte man bei der WD Black SN850X stolze 15% wenn man diese an den Z690-Chipsatz von Intel-1700 steckt. Statt 90 MB/s gibt es nur 77 MB/s (Bilder einfügen). Genau um diesen Leistungsverlust am Chipsatz soll es gehen hier in diesem Faden, zusammen mit der Frage welcher PCIe Gen4 Festspeicher aktuell der beste ist.

Der eingesteckte Festspeicher muss gut sitzen und darf danach in keinster Weise mehr wackeln oder sich bewegen. Ist da was locker kann der Anschluss-Modus von PCIe4x4 auf x2 runtergeregelt werden mit entsprechend schwachen Leistungswerten. Den Anschluss sieht man am Besten in CrystalDiskInfo (CDI).

Als Kühler kommt, falls keiner vom Werk angebracht ist, immer der BeQuiet MC1 Pro zum Einsatz. Das war vor Jahren der beste SSD-Kühler, wenn einer einen aktuell besseren kennt bitte melden. Man kann bei dem Festspeicher große ~8°C runterkühlen in dem man einfach ein Seitenteil hat rechts neben der befestigten Hauptplatine hat, die dann mit drei 120mm Lüftern frische Luft anzieht. Leider haben das die meisten Gehäuse nicht, dort gibt es nur ein Vorderteil und der Abstand von den meist drei 140mm Lüftern zu der SSD auf der Hauptplatine ist zu groß um noch von davon gekühlt zu werden.

1. Das Testsystem

Zum Testen wurde immer das gleiche Testsystem verwendet:

2. Welcher PCIe Gen4 Festspeicher ist der Beste?

Die Beste SSD ist aktuell die Corsair MP600 Pro XT 2 TB. Zumindest zu diesem Schluss bin ich gekommen und es ist ein knappes Rennen. Die neuste Samsung 990 Pro schafft einige neue Höchstwerte wie die ~110 MB/s im 4KRDN1-Q1T1-Lesen, gefällt aber nicht bei 4KRDN1-Q1T1-Schreiben und auch das Kleinstdateienverhalten gefällt nicht bei der Samsung 990 Pro und auch nicht bei der WD Black SN850X.

Gleichzeitig ist die Samsung 990 Pro 2 TB deutlich überteuert. Die MP600 Pro XT 2 TB gibt es aktuell für ~120 EUR und dort ist ein guter Kühler schon mit drin. Für die Samsung 990 Pro muss man etwa 135 EUR bezahlt und mit dem M.2-Kühler landet man bei ~150 EUR, also 25% überteuert.

Folgende Aussagen können zu den vier Spitzen-Festspeichern getroffen werden:

2.1 Leistungsvergleich

Die SSDs geben sich nicht viel. Sie erreichen alle 10500 Punkte im AS-SSD-Benchmark und die Samsung 990 Pro erreicht etwas mehr, 11270 bis 12100, je nachdem welchen Modus man im Samsung Magican einstellt.

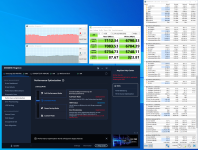

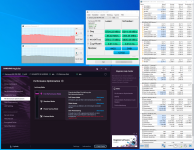

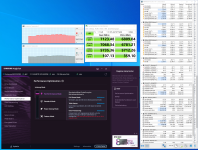

2.2 Samsung Magican Software

Bei Samsung sollte man sich die Magician Software auf der Win-Installation runterladen und dort installieren. Man kann den Modus für die SSD einstellen. So wie es aussieht wird der Modus dann in der Firmware gespeichert. Für den Vollleistungsmodus muss der Rechner leider neugestartet werden und von ihm zurück in den Standard- und Stromsparmodus auch. Der Stromsparmodus kommt noch mit einem dann sogenannten Overprovisioning, was einem 10% nochmals an verfügbarem Speicher abzwackt. Angeblich soll dieses eben Strom sparen und der Haltbarkeit des Festspeichers dienen, auch wenn ich das natürlich nicht überprüfen kann. Es sollte möglich sein den Festspeicher auf eine Win-Installation zu stecken, dort dann auf den Vollleistungsmodus zu gehen und dort dann bspw. Ubuntu-Server oder weitere Linuxe zu installieren.

2.3 Verhalten bei Kleinstdateien

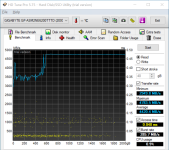

Die Samsung 990 Pro zeigt wie die WD Black SN850X bei den Kleinstdateien ein eher schwaches Verhalten in den Benchmarks. Im Windows NTFS wird die Clustergröße bis 16 TB standardmäßig bei 4K formatiert. Von 512 B bis etwa 1 MB sieht das Verhalten eher schwach aus, wie man es bei den Atto-Benchmarks auslesen kann. Die beiden praktisch baugleichen Seagate 530 und die Corsair MP600 Pro XT gefallen weitaus mehr bei Kleinstdateien. Vor allem die Schreibwerte sind bei der Samsung 990 Pro eher schwach und deutlich niedriger als die Lesewerte. Eigentlich sollten sich beide Werte, also Lesen und Schreiben ausgleichen aber das Schreiben fällt hier deutlich zurück. Bei der Corsair/Seagte ist es dann ziemlich ausgeglichen.

2.4 Benchmarks

Bei den Festspeichern gibt es eine Reihe von Benchmarks, mit Besonderheiten die man kennen muss. Folgende gibt es:

2.4.1 CrystalDiskMark (CDM)

2.4.2 CrystalDiskInfo (CDI)

2.4.3 ATTO-Disk Benchmark

2.4.4 AS SSD Benchmark

2.4.5 AJA System Test

2.4.6 HD Tune Pro

2.4.7 UL PCMark 10

Bei dem 1.4.4 AS SSD Benchmark gibt es bei der Standardgröße von 1 GB für die Seagate und die Corsair zu hohe Werte im 4K. Dort steht dann ~90 MB/s statt 72 MB/s und ergibt dann ein 12200 Punkteergebnis statt 10500:

Hier einmal mit der Standardgröße von 1 GB und danach mit 10 GB:

Das also nicht vergessen und am besten immer mit 10 GB im AS SSD testen.

Bei dem 1.4.7 UL PCMark 10 gibt es einen extra Storage-Bereich. Leider gibt es den nur in der Vollversion, die ihrererseits einige Tausenddolllars im Jahr an Lizenz kostet.

3. Leistungsverlust mit der Chipsatz- statt Prozessoranbindung:

Man verliert gewaltige ~10% am Chipsatz, in einer hohen Streung von 5% bis 15%, in einen Ausreißer 20%, an Lesen und an Schreiben.

4. Belege

Folgende CDM- und Atto-Werte gibt es für die folgenden SSDs:

Samsung 990 Pro 2 TB

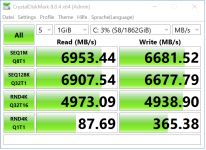

Angebunden an Intel-1700-Prozessor:

Vollleistungsmodus:

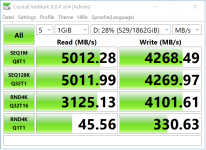

Angebunden an Intel-1700-Z690-Chipsatz:

Seagate Firecuda 530 2 TB (Werte mit Screenshots einfügen)

Angebunden an Intel-1700-Prozessor:

Angebunden an Intel-1700-Z690-Chipsatz:

WD Black SN850X 2 TB

Angebunden an Intel-1700-Prozessor:

Angebunden an Intel-1700-Z690-Chipsatz:

Die WD Black SN850X hat sehr schwache Leistungswerte bei Kleinstdateien von 0,5 KB bis 2 KB. Selbst die ältere Gigabyte AORUS NVMe hat x3 höhere Werte. Das habe ich bei den Testberichten in Youtube noch nie gehört. Und ich kann diese Werte bei Anschluss am Prozessor und am Chipsatz bestätigen (Bilder einfügen). Die Kleinstdateienleistung ist auch wichtig, da doch so viele Systemdateien und auch Logging-Schreibungen wie im Server-Betrieb doch genau solche Dateien produzieren.

Gigabyte AORUS NVME 2 TB (Werte mit Screenshots einfügen)

Angebunden an Intel-1700-Prozessor:

Angebunden an Intel-1700-Z690-Chipsatz:

hier nun der Faden, welche SSD denn nun aktuell die beste PCIE4-SSD ist. Wichtig beim Test ist auch breit zu testen. Allgemein kann man sagen, dass der Anschluss der SSD an den Prozessor viel bringt und deutlich besser ist als am Chipsatz. Nimmt man die 4K-Werte zur Hand, dann verlierte man bei der WD Black SN850X stolze 15% wenn man diese an den Z690-Chipsatz von Intel-1700 steckt. Statt 90 MB/s gibt es nur 77 MB/s (Bilder einfügen). Genau um diesen Leistungsverlust am Chipsatz soll es gehen hier in diesem Faden, zusammen mit der Frage welcher PCIe Gen4 Festspeicher aktuell der beste ist.

Der eingesteckte Festspeicher muss gut sitzen und darf danach in keinster Weise mehr wackeln oder sich bewegen. Ist da was locker kann der Anschluss-Modus von PCIe4x4 auf x2 runtergeregelt werden mit entsprechend schwachen Leistungswerten. Den Anschluss sieht man am Besten in CrystalDiskInfo (CDI).

Als Kühler kommt, falls keiner vom Werk angebracht ist, immer der BeQuiet MC1 Pro zum Einsatz. Das war vor Jahren der beste SSD-Kühler, wenn einer einen aktuell besseren kennt bitte melden. Man kann bei dem Festspeicher große ~8°C runterkühlen in dem man einfach ein Seitenteil hat rechts neben der befestigten Hauptplatine hat, die dann mit drei 120mm Lüftern frische Luft anzieht. Leider haben das die meisten Gehäuse nicht, dort gibt es nur ein Vorderteil und der Abstand von den meist drei 140mm Lüftern zu der SSD auf der Hauptplatine ist zu groß um noch von davon gekühlt zu werden.

1. Das Testsystem

Zum Testen wurde immer das gleiche Testsystem verwendet:

| Komponentenart | Komponente |

|---|---|

| Gehäuse | Phanteks Enthoo Pro 2 Server Edition, Closed Panel |

| Netzgerät | Seasonic Focus GX 850W |

| Hauptplatine | ASRock Z690 Extreme, UEFI 14.04 |

| Prozessor | Intel Core i7-13700K |

| Prozessorkühler | BeQuiet Dark Rock Pro 4 |

| Arbeitsspeicher | 2 * Crucial DDR4-3200 CL22 32 GB = 64 GB |

2. Welcher PCIe Gen4 Festspeicher ist der Beste?

Die Beste SSD ist aktuell die Corsair MP600 Pro XT 2 TB. Zumindest zu diesem Schluss bin ich gekommen und es ist ein knappes Rennen. Die neuste Samsung 990 Pro schafft einige neue Höchstwerte wie die ~110 MB/s im 4KRDN1-Q1T1-Lesen, gefällt aber nicht bei 4KRDN1-Q1T1-Schreiben und auch das Kleinstdateienverhalten gefällt nicht bei der Samsung 990 Pro und auch nicht bei der WD Black SN850X.

Gleichzeitig ist die Samsung 990 Pro 2 TB deutlich überteuert. Die MP600 Pro XT 2 TB gibt es aktuell für ~120 EUR und dort ist ein guter Kühler schon mit drin. Für die Samsung 990 Pro muss man etwa 135 EUR bezahlt und mit dem M.2-Kühler landet man bei ~150 EUR, also 25% überteuert.

Folgende Aussagen können zu den vier Spitzen-Festspeichern getroffen werden:

2.1 Leistungsvergleich

Die SSDs geben sich nicht viel. Sie erreichen alle 10500 Punkte im AS-SSD-Benchmark und die Samsung 990 Pro erreicht etwas mehr, 11270 bis 12100, je nachdem welchen Modus man im Samsung Magican einstellt.

2.2 Samsung Magican Software

Bei Samsung sollte man sich die Magician Software auf der Win-Installation runterladen und dort installieren. Man kann den Modus für die SSD einstellen. So wie es aussieht wird der Modus dann in der Firmware gespeichert. Für den Vollleistungsmodus muss der Rechner leider neugestartet werden und von ihm zurück in den Standard- und Stromsparmodus auch. Der Stromsparmodus kommt noch mit einem dann sogenannten Overprovisioning, was einem 10% nochmals an verfügbarem Speicher abzwackt. Angeblich soll dieses eben Strom sparen und der Haltbarkeit des Festspeichers dienen, auch wenn ich das natürlich nicht überprüfen kann. Es sollte möglich sein den Festspeicher auf eine Win-Installation zu stecken, dort dann auf den Vollleistungsmodus zu gehen und dort dann bspw. Ubuntu-Server oder weitere Linuxe zu installieren.

2.3 Verhalten bei Kleinstdateien

Die Samsung 990 Pro zeigt wie die WD Black SN850X bei den Kleinstdateien ein eher schwaches Verhalten in den Benchmarks. Im Windows NTFS wird die Clustergröße bis 16 TB standardmäßig bei 4K formatiert. Von 512 B bis etwa 1 MB sieht das Verhalten eher schwach aus, wie man es bei den Atto-Benchmarks auslesen kann. Die beiden praktisch baugleichen Seagate 530 und die Corsair MP600 Pro XT gefallen weitaus mehr bei Kleinstdateien. Vor allem die Schreibwerte sind bei der Samsung 990 Pro eher schwach und deutlich niedriger als die Lesewerte. Eigentlich sollten sich beide Werte, also Lesen und Schreiben ausgleichen aber das Schreiben fällt hier deutlich zurück. Bei der Corsair/Seagte ist es dann ziemlich ausgeglichen.

2.4 Benchmarks

Bei den Festspeichern gibt es eine Reihe von Benchmarks, mit Besonderheiten die man kennen muss. Folgende gibt es:

2.4.1 CrystalDiskMark (CDM)

2.4.2 CrystalDiskInfo (CDI)

2.4.3 ATTO-Disk Benchmark

2.4.4 AS SSD Benchmark

2.4.5 AJA System Test

2.4.6 HD Tune Pro

2.4.7 UL PCMark 10

Bei dem 1.4.4 AS SSD Benchmark gibt es bei der Standardgröße von 1 GB für die Seagate und die Corsair zu hohe Werte im 4K. Dort steht dann ~90 MB/s statt 72 MB/s und ergibt dann ein 12200 Punkteergebnis statt 10500:

Hier einmal mit der Standardgröße von 1 GB und danach mit 10 GB:

Das also nicht vergessen und am besten immer mit 10 GB im AS SSD testen.

Bei dem 1.4.7 UL PCMark 10 gibt es einen extra Storage-Bereich. Leider gibt es den nur in der Vollversion, die ihrererseits einige Tausenddolllars im Jahr an Lizenz kostet.

3. Leistungsverlust mit der Chipsatz- statt Prozessoranbindung:

Man verliert gewaltige ~10% am Chipsatz, in einer hohen Streung von 5% bis 15%, in einen Ausreißer 20%, an Lesen und an Schreiben.

4. Belege

Folgende CDM- und Atto-Werte gibt es für die folgenden SSDs:

Samsung 990 Pro 2 TB

Angebunden an Intel-1700-Prozessor:

Vollleistungsmodus:

Angebunden an Intel-1700-Z690-Chipsatz:

Seagate Firecuda 530 2 TB (Werte mit Screenshots einfügen)

Angebunden an Intel-1700-Prozessor:

Angebunden an Intel-1700-Z690-Chipsatz:

WD Black SN850X 2 TB

Angebunden an Intel-1700-Prozessor:

Angebunden an Intel-1700-Z690-Chipsatz:

Die WD Black SN850X hat sehr schwache Leistungswerte bei Kleinstdateien von 0,5 KB bis 2 KB. Selbst die ältere Gigabyte AORUS NVMe hat x3 höhere Werte. Das habe ich bei den Testberichten in Youtube noch nie gehört. Und ich kann diese Werte bei Anschluss am Prozessor und am Chipsatz bestätigen (Bilder einfügen). Die Kleinstdateienleistung ist auch wichtig, da doch so viele Systemdateien und auch Logging-Schreibungen wie im Server-Betrieb doch genau solche Dateien produzieren.

Gigabyte AORUS NVME 2 TB (Werte mit Screenshots einfügen)

Angebunden an Intel-1700-Prozessor:

Angebunden an Intel-1700-Z690-Chipsatz:

Anhänge

-

CDM_SN850X_Prozessor.png21,6 KB · Aufrufe: 97

CDM_SN850X_Prozessor.png21,6 KB · Aufrufe: 97 -

CDM_AORUS_NVMe.png22,5 KB · Aufrufe: 93

CDM_AORUS_NVMe.png22,5 KB · Aufrufe: 93 -

1694373217043.png57,2 KB · Aufrufe: 85

1694373217043.png57,2 KB · Aufrufe: 85 -

1694443177158.png27,1 KB · Aufrufe: 179

1694443177158.png27,1 KB · Aufrufe: 179 -

1694534280521.png803,3 KB · Aufrufe: 123

1694534280521.png803,3 KB · Aufrufe: 123 -

1694540700063.png35,2 KB · Aufrufe: 94

1694540700063.png35,2 KB · Aufrufe: 94 -

1694709697682.png543,3 KB · Aufrufe: 68

1694709697682.png543,3 KB · Aufrufe: 68 -

1694709723182.png509,9 KB · Aufrufe: 86

1694709723182.png509,9 KB · Aufrufe: 86 -

1694709757544.png550,2 KB · Aufrufe: 69

1694709757544.png550,2 KB · Aufrufe: 69 -

1694709771199.png583,6 KB · Aufrufe: 66

1694709771199.png583,6 KB · Aufrufe: 66 -

1694710437920.png51,4 KB · Aufrufe: 76

1694710437920.png51,4 KB · Aufrufe: 76 -

1694710755669.png17 KB · Aufrufe: 79

1694710755669.png17 KB · Aufrufe: 79

Zuletzt bearbeitet:

ShortStroke musst du auf 5GB einstellen und in den settings "Benchmark" musst du Full Test und den Regler ganz auf runter auf Acurate stellen, dazu die Block Size auf 8MB stellen. Ob das die trial allerdings zu läßt, keine Ahnung.

ShortStroke musst du auf 5GB einstellen und in den settings "Benchmark" musst du Full Test und den Regler ganz auf runter auf Acurate stellen, dazu die Block Size auf 8MB stellen. Ob das die trial allerdings zu läßt, keine Ahnung.