Reenact5139

Profi

Thread Starter

- Mitglied seit

- 26.02.2023

- Beiträge

- 6

Hallo Leute,

wie der Titel schon sagt überlege ich aktuell mir ein System auf EPYC Basis zusammenzustellen.

Mit der Hilfe von @java4ever bin ich jetzt auf folgende grobe Eckdaten gekommen:

Verwendungszweck: NAS, VM Host, Container Host

Wegen der einfachen Wartung und vielen Empfehlungen ein NAS immer bare metal laufen zu lassen habe ich mich für den "L1Techs-HomeServer" Weg entschlossen.

Dieser lautet grob: TrueNas bare metal, Linux VM (Debian, Ubuntu Server od. ähnliches und darauf dann Docker) und ein bisschen Networking Modifikation damit ne Network-Bridge läuft.

(hier zum nachlesen: https://forum.level1techs.com/t/truenas-scale-ultimate-home-setup-incl-tailscale/186444)

wichtige Fragen die ich mir noch stelle sind:

wie der Titel schon sagt überlege ich aktuell mir ein System auf EPYC Basis zusammenzustellen.

Mit der Hilfe von @java4ever bin ich jetzt auf folgende grobe Eckdaten gekommen:

- AMD EPYC 7302(p) 16 Kerner sollte völlig ausreichen

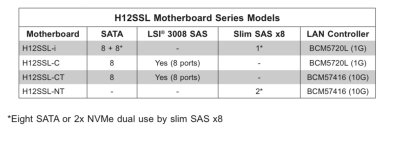

- Supermicro H12SSL-i version 2.0

- Fractal Design Define 7 (bereits vorhanden)

Verwendungszweck: NAS, VM Host, Container Host

Wegen der einfachen Wartung und vielen Empfehlungen ein NAS immer bare metal laufen zu lassen habe ich mich für den "L1Techs-HomeServer" Weg entschlossen.

Dieser lautet grob: TrueNas bare metal, Linux VM (Debian, Ubuntu Server od. ähnliches und darauf dann Docker) und ein bisschen Networking Modifikation damit ne Network-Bridge läuft.

(hier zum nachlesen: https://forum.level1techs.com/t/truenas-scale-ultimate-home-setup-incl-tailscale/186444)

wichtige Fragen die ich mir noch stelle sind:

- Onboard NIC ausreichend oder separat besser? plane 10G zu Unifi Switch

- je nach Drive Typ, Onboard Controller ausreichend oder separat besser?

- da ich das System möglichst auf low Power ausrichten möchte (€€€) stelle ich mir die Frage:

lohnt es sich bei 24/7 Betrieb auf Dauer SSDs statt HDDs zu kaufen?

Plane aktuell Storage im Bereich von 8-10TB also jz keine Unmengen

Außerdem sollte man doch sowieso für Container SSDs haben od? - Kann man auf Supermicro Boards auch andere Kühler z.B. von Noctua montieren?

Hat zumindest bei meinem X11SSL-F nicht geklappt - Wie viel und welchen RAM?

- Sonst irgendwas wichtiges was ich vergessen habe?