Magic_Merlin schrieb:Also, unser Elektriker Meister sagt, dass wir n neues Kabel, getrennt von den anderen verlegen können. Wir nehmen also zur Sicherheit n Cat 6 oder 7 Kabel vom Server zum Switch.

Jetzt brauch ich aber immernoch ne Switch Empfehlung für weniger als 2000€.

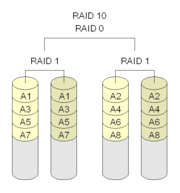

Lohnt sich denn dieses Port Trunking oder kann ich das in der Praxis sowieso nicht ausnutzen? Wäre ja schon super, wenn z.b. im optimal Fall zwei Clients mit je 1GBit habe, kann jeder diese dann auch ausnutzen? (bei nem entsprechenden Server mit 4 15k SCSI Platten im Raid 10 und entsprechend 2 PCI-X NICs)

Das mit dem Kabel könntest/solltest Du machen - da es sich ja nur um einen PC (Server) und nur einer kurzen Strecke handelt zahlt sich das auf jeden Fall aus.

Port Trunking macht nur Sinn wenn wirklich die benötigte Platten Leistung dahinter steht. Bei 4 15k SCSI Platten oder auch 10k SATA1/2 Platten im Raid0 oder 10 denke ich sollte es reichen 2-5 Clients wie sie derzeit angebunden sind gleichzeitig optimal zu versorgen.

Macht aber nur Sinn wenn wirklich viele Clients gleichzeitig drauf zugreifen oder ein 2. Server (Backup Server o.Ä.) auch sehr flott am Netzwerk angebunden ist und viel Bandbreite braucht.

Ist halt die Frage was entprechende Netzwerkkarten / Switches die das Port Trunking optimal unterstützen kosten.

Wenn Switch und Karte zusammen gleich mal 2000-3000 EUR kosten zahlt es sich bei Euch meiner Meinung nach nicht aus.

Da bist Du mit einem 24Port 1000er Switch um die 500 EUR besser bedient.

Server mit 2 x Adaptec ISA SCSI Controller und jeweils 2 x 80 MB Quantum SCSI Platten dran.

Server mit 2 x Adaptec ISA SCSI Controller und jeweils 2 x 80 MB Quantum SCSI Platten dran.

) besteht aus:

) besteht aus: