Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

GTX 1060 GB oder RX 480 8GB?

- Ersteller Dokter

- Erstellt am

entryway

Enthusiast

- Mitglied seit

- 16.10.2011

- Beiträge

- 754

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800X3D

- Mainboard

- MSI Tomahawk WIFI AMD B650

- Kühler

- Alpenföhn Gletscherwasser 280

- Speicher

- 32GB G.Skill Trident Z5 NEO DDR5-6000 CL30

- Grafikprozessor

- Palit GeForce RTX 4070 Ti GamingPro

- Display

- LG OLED 27GS95QX-B / LG 27GP850P-B

- SSD

- 2TB Kingston KC3000 M.2 PCIe 4.0

- Gehäuse

- LianLi Lancool 216

- Netzteil

- 750W be quiet! Pure Power 12 M Modular 80+ Gold

Geschmacksache, die eine ist grün, die andere rot. Leistungstechnisch nur kleine Unterschiede. Die GTX ist wesentlich effizienter, die RX480 hat dafür mehr VRAM. Auflösung FHD / WQHD?

Belo79

Enthusiast

- Mitglied seit

- 30.11.2010

- Beiträge

- 1.614

- Ort

- Nähe Koblenz

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 5800X

- Mainboard

- Asus TUF B550 Gaming Plus

- Kühler

- Noctua NHD 15

- Speicher

- G.Skill 3600 Mhz

- Grafikprozessor

- MSI RTX 4090 Suprim X

- Display

- LG GL850

- SSD

- WD Black 750 1TB; Samsung EVO Plus 960 500GB; Crucial MX500 1TB

- Soundkarte

- Fiio K5 Pro

- Gehäuse

- Fractal Define R6

- Netzteil

- Cosair RM1000X

- Keyboard

- Sharkoon Pure Writer

- Mouse

- Logitech Pro

- Betriebssystem

- Windows 10

- Internet

- ▼VDSL 250

Ich persönlich würde eher zur 1060 greifen, ist für mich das rundere Produkt.

Scrush

Legende

- Mitglied seit

- 31.12.2008

- Beiträge

- 59.507

- Ort

- Ladadi

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800x3D

- Mainboard

- MSI B650 Tomahawk WIFI

- Kühler

- Noctua U12A

- Speicher

- 32GB G.Skill Trident Z5 Neo 6000CL30

- Grafikprozessor

- ASUS RTX 4090 TUF OC

- Display

- Dell AW3423DW

- SSD

- 960evo, 970evo, 850evo

- Soundkarte

- KEF LSX

- Gehäuse

- NZXT H7 Flow

- Netzteil

- Seasonic Focus PX 850

- Keyboard

- QK65 V2 Classic, Zoom75, Cycle8, Wind X80, Paper 80

- Mouse

- Lamzu Thorn

- Betriebssystem

- Windows 11 Pro

- Webbrowser

- Vivaldi

- Internet

- ▼VDSL250

Hatte mal die RX480 und muss ehrlich sagen fande die GK für 280€ ziemlich schwach daher dann zu einer 980ti ( gebraucht ) gegriffen

mopsmopsen

Enthusiast

ich würde andere partnerkarten wählen:

1060: https://geizhals.de/inno3d-geforce-gtx-1060-6gb-gaming-oc-n1060-1sdn-n5gnx-a1479074.html?hloc=de

480: https://geizhals.de/?cmp=1480295&cmp=1473074

die amd dürfte sich zukünftig leistungsmäßig etwas von der geforce absetzen, vor allem wenn im laufe von 2017 mehr und mehr dx12 titel auf den markt kommen. dazu unterstützt die karte freesync.

an der geforce gefällt mir, dass man eine niedrigere lautstärke erwarten kann, selbst wenn man das oc-potential ausnutzt (bei der amd gehen die käufer eher etwas runter mit spannung bzw takt).

1060: https://geizhals.de/inno3d-geforce-gtx-1060-6gb-gaming-oc-n1060-1sdn-n5gnx-a1479074.html?hloc=de

480: https://geizhals.de/?cmp=1480295&cmp=1473074

die amd dürfte sich zukünftig leistungsmäßig etwas von der geforce absetzen, vor allem wenn im laufe von 2017 mehr und mehr dx12 titel auf den markt kommen. dazu unterstützt die karte freesync.

an der geforce gefällt mir, dass man eine niedrigere lautstärke erwarten kann, selbst wenn man das oc-potential ausnutzt (bei der amd gehen die käufer eher etwas runter mit spannung bzw takt).

Zuletzt bearbeitet:

Narbennarr

Urgestein

- Mitglied seit

- 11.10.2013

- Beiträge

- 9.855

Dieses dürfte sich absetzen etc pp wäre mir zu vage^^

Man will ja die Leistung jetzt und all zu oft haben sich Prognosen zu eventuellen optimierungen etc nicht bewahrheitet.

Beides ordentliche Karten, ich finde die 1060 6gb aber runder im Gesamten

Man will ja die Leistung jetzt und all zu oft haben sich Prognosen zu eventuellen optimierungen etc nicht bewahrheitet.

Beides ordentliche Karten, ich finde die 1060 6gb aber runder im Gesamten

mopsmopsen

Enthusiast

wie stark und wie schnell die entwicklung voran schreitet, kann natürlich niemand sagen. ich nehme nicht an, dass sich irgendwann riesige gräben zwischen den karten auf tun.

allerdings sprechen mmn alle zeichen dafür, dass die zeit eher für die amd arbeitet. oder rechnest du noch mit dem geforce async compute wundertreiber?

man kann auf jeden sagen, dass die low level apis bisher der polaris zu gute kamen. teilweise marginal, teilweise ziemlich deutlich.

und es sind eine ganze menge dx12 titel für das nächste jahr angekündigt.

allerdings sprechen mmn alle zeichen dafür, dass die zeit eher für die amd arbeitet. oder rechnest du noch mit dem geforce async compute wundertreiber?

man kann auf jeden sagen, dass die low level apis bisher der polaris zu gute kamen. teilweise marginal, teilweise ziemlich deutlich.

und es sind eine ganze menge dx12 titel für das nächste jahr angekündigt.

Zuletzt bearbeitet:

könnte mir auch vorstellen dass die 480 irgendwann in den meisten Spielen vorne liegt, aber mehr als 10% kann ich mir nicht vorstellen

habe mich trotzdem für die 1060 entschieden weil sie einfach kühler läuft und weniger stromhungrig ist

habe mich trotzdem für die 1060 entschieden weil sie einfach kühler läuft und weniger stromhungrig ist

Lachssalat

Banned

- Mitglied seit

- 30.11.2016

- Beiträge

- 26

Wenn du nicht rätseln willst und auch keine Glaskugel hast nimm doch einfach die letzten Generationen zur Hand und vergleiche früher und heute. Natürlich gleicher Preisbereich:

Gtx670 vs 7970

Gtx780 vs 290

Gtx970 vs 390

Und was sagt uns das nun? Nichts. AMD wurde nicht schneller, die haben nur damals ein kleines Leistungsproblem mit Directx11 gehabt und hamm sich n bisschen verbessert, das ist lange her, das gilt für heute nicht mehr.

Es gibt keinen Grund wieso die rx480 vorne liegen soll.

Die GTX 1060 ist leiser und hat deutlich weniger Strombedarf und ist 10% schneller, die RX480 hat 2GB mehr Ram und ist in neueren Titeln gleichschnell wie sich das entwickelt weiß niemand, entscheide selbst.

Zuletzt bearbeitet:

def

Legende

- Mitglied seit

- 02.12.2006

- Beiträge

- 9.798

- Ort

- Hamburg

- Details zu meinem Desktop

- Prozessor

- Intel i5-10600K

- Mainboard

- GIGABYTE Z590I AORUS ULTRA

- Kühler

- Thermalright Peerless Assassin 120 SE White ARGB

- Speicher

- G.Skill Trident Z RGB 16GB DDR4 B-Dies

- Grafikprozessor

- ASUS Dual GeForce RTX 2080 OC

- Display

- Acer Nitro XV2 XV272UP

- SSD

- Kingston KC3000

- Soundkarte

- Fiio K5 Pro @ Sivga SV004&7 + FIFINE K670 / Canton Smart GLE 9 S2

- Gehäuse

- Cooler Master MasterBox NR200P

- Netzteil

- Corsair SF450 80 PLUS Gold

- Keyboard

- WOB Rainy75 E-White

- Mouse

- CoolerMaster MM730

- Betriebssystem

- Microsoft Windows 11 Pro 64Bit

- Sonstiges

- Google Pixel 7 & 7a

lang leben die fanboy trolle. sogar extra n account dafür angelegt. respekt!

mopsmopsen

Enthusiast

Wenn du nicht rätseln willst und auch keine Glaskugel hast nimm doch einfach die letzten Generationen zur Hand und vergleiche früher und heute. Natürlich gleicher Preisbereich:

Gtx670 vs 7970

Gtx780 vs 290

Gtx970 vs 390

müsste man nicht eher 680/770 mit der 7970 und 780ti mit der 290 vergleichen?

grundlegend erkenne ich aber ebenfalls diese tendenz in den letzten jahren. der größere vram hat sich rückblickend immer als hilfreich herausgestellt und aus den amd karten konnte im laufe der zeit durch treiberverbesserungen noch etwas leistung heraus geholt werden. teilweise sogar lange zeit nach release.

zu einem gewissen grad sieht man das jetzt schon bei polaris, ca ein halbes jahr nach release.

dazu kommt halt noch die low level api geschichte. da sehe ich bisher nur vorteile für die amd karten (async compute, verminderter treiberoverhead). zumidnest können die karten immer mal wieder zugewinne verzeichnen, wogegen ich bei den geforce karten das gefühl habe, dass man sich glücklich schätzen kann, wenn die dx11 performance beibehalten wird.

wir werden sehen. die wahrheit ist die tochter der zeit

ich denke, in 12 monaten ergibt sich ein deutlich klareres bild.

Solange der Preisunterschied zwischen Freesync und Gsync so hoch ist (Monitore mit Gsync kosten ca. 150,- Euro mehr), würde ich rein aus Prinzip schon zur Radeon greifen. Wenn eine 1070er nicht im Budget liegt, dann würde ich mir auf jeden Fall die RX480 holen.

Vielleicht auch noch ein paar Tage warten um zu schauen, was Radeon hinsichtlich der RX490 bringt, aber die wird wohl deutlich außerhalb deines Budgets liegen.

Vielleicht auch noch ein paar Tage warten um zu schauen, was Radeon hinsichtlich der RX490 bringt, aber die wird wohl deutlich außerhalb deines Budgets liegen.

sTOrM41

Admiral , HWLUXX Superstar

- Mitglied seit

- 13.10.2005

- Beiträge

- 22.313

- Details zu meinem Desktop

- Prozessor

- Ryzen 5700X

- Speicher

- 32GB

- Grafikprozessor

- RTX 4070

oder rechnest du noch mit dem geforce async compute wundertreiber?

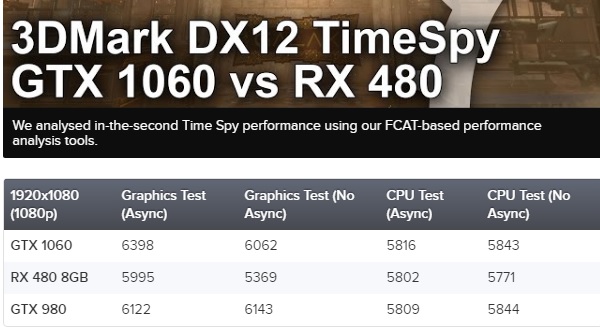

http://www.eurogamer.net/articles/d...-new-dx12-benchmark-tested-gtx-1060-vs-rx-480

@Dokter

prinzipiell ist es egal ob du eine 480 oder 1060 kaufst, wie schaut denn das restliche system aus?

mopsmopsen

Enthusiast

ich kenne den benchmark. aber in spielen hat sich dies bisher nicht gezeigt.

rosek

Neuling

- Mitglied seit

- 09.12.2016

- Beiträge

- 95

ich kenne den benchmark. aber in spielen hat sich dies bisher nicht gezeigt.

https://www.youtube.com/watch?v=3uoanTrMenI&t=364s

DasKlose

Experte

- Mitglied seit

- 25.02.2015

- Beiträge

- 1.558

- Desktop System

- DasKlose

- Details zu meinem Desktop

- Prozessor

- Intel 13600KS

- Mainboard

- ASrock Steel Leged Z690

- Kühler

- EkWaterBlocks Nickel + Acetal

- Speicher

- 4x8GB DDR4 G.Skill Ripjaw 3600 CL16

- Grafikprozessor

- Manli 4090 RTX

- Display

- Asus ROG PG32UQX (Für schön) & BenQ Zowie XL2546K (Shooter Kompetitiv)

- SSD

- 1x 240GB, 1x 500GB, 1x2TB

- Soundkarte

- Xonar Essence STX

- Gehäuse

- Fractal Define R6

- Netzteil

- MSI 850W

- Keyboard

- Wooting TWO HE

- Mouse

- Razer Basilisk V3 Pro

- Betriebssystem

- Win 10

Man sollte aber bedenken das bei dem genannten Freesync Protestkauf, die Syncrange öfter erst ab 45fps anfängt und nur bis 144fps reicht, dieses Problem hast du bei G-Sync nicht.

Habe gerade welche gesehen die erst bei 75fps anfangen

Habe gerade welche gesehen die erst bei 75fps anfangen

Zuletzt bearbeitet:

mopsmopsen

Enthusiast

das soll uns was genau sagen?

bei hitman und aots gab es leichte zugewinne bei dx11 auf dx12 bei der 1060 iirc. aber die tendenz bei den bisher erschienenen low level api titeln ist schon ziemlich eindeutig (im bezug auf pascal vs polaris).

Man sollte aber bedenken das bei dem genannten Freesync Protestkauf, die Syncrange öfter erst ab 45fps anfängt und nur bis 144fps reicht, dieses Problem hast du bei G-Sync nicht.

Habe gerade welche gesehen die erst bei 75fps anfangen

auf jeden. gerade in dem niedrigen fps-bereich sehe ich den großen vorteil von adaptive sync. bis zu 40fps sollte es mmn mindestens herunter reichen.

hiernach kann man den bereich von hand vergrößern: 3DCenter Forum - G-/Free-/A-Sync: framesynchronisierter Displayrefresh per variablem vblank-Intervall - Seite 193

Zuletzt bearbeitet:

unl34shed

Enthusiast

Man sollte aber bedenken das bei dem genannten Freesync Protestkauf, die Syncrange öfter erst ab 45fps anfängt und nur bis 144fps reicht, dieses Problem hast du bei G-Sync nicht.

Habe gerade welche gesehen die erst bei 75fps anfangen

AFAIK können beide in den unteren Bereichen framedoubling, weswegen das egal ist, solange die maximal refreshrate doppelt so groß ist wie das minimum.

GTX 1060 6GB: Weniger Stromverbrauch, kühler , Vorteile bei kleinen CPUs

RX480 8GB: 2gb Mehr Speicher , möglich das sie besser altert -->Erfahrungen mit GNC GFX der letzten Generationen, muss aber nicht übetragbar sein wenn Vega wirklich eine neue Architektur hat, könnte es zu einem Bruch wie seinerzeit von VLIW4/5 zu GCN kommen

Preis vergleichbar

Freesync vs.Gsync kann ich nichts zu beitragen , beide noch nicht in Aktion gesehen.

Was auf der GTX1060 ruckelt ruckelt imn ormal Fall auch auf der RX480 und anders herum

Was dir wichtiger ist entscheide selbst .

RX480 8GB: 2gb Mehr Speicher , möglich das sie besser altert -->Erfahrungen mit GNC GFX der letzten Generationen, muss aber nicht übetragbar sein wenn Vega wirklich eine neue Architektur hat, könnte es zu einem Bruch wie seinerzeit von VLIW4/5 zu GCN kommen

Preis vergleichbar

Freesync vs.Gsync kann ich nichts zu beitragen , beide noch nicht in Aktion gesehen.

Was auf der GTX1060 ruckelt ruckelt imn ormal Fall auch auf der RX480 und anders herum

Was dir wichtiger ist entscheide selbst .

oooverclocker

Semiprofi

- Mitglied seit

- 29.08.2012

- Beiträge

- 5.610

Man sollte aber bedenken das bei dem genannten Freesync Protestkauf, die Syncrange öfter erst ab 45fps anfängt und nur bis 144fps reicht, dieses Problem hast du bei G-Sync nicht.

Das ist falsch! Fallen die FPS unter die minimale Bildwiederholfrequenz das Bildschirms, werden die FPS automatisch verdoppelt, verdrei- oder vervierfacht. Das wurde schon vor über einem Jahr in der Radeon Sofware eingeführt und die Behauptung, es könne nur G-Sync wird trotzdem ständig weiter verbreitet. Ich bin wirklich enttäuscht, dass man sich nicht vorher informieren kann.

Mittlerweile ist FreeSync zudem im randlosen Fenstermodus nutzbar, sodass G- Sync keinen einzigen Vorteil mehr zu bieten hat. Es ist teuer, benötigt ein Modul im Bildschirm, was einiges an Strom verbraucht(Da wird das bisschen Strom, was man zur RX 480 spart, quasi direkt wieder verbraten), und hat tendenziell höhere Latenzen, weil eben das Sync- Modul noch dazwischenhängt, und es ist im Gegensatz zu FreeSync nicht VESA- standardisiert, sodass ausschließlich Nvidia- GPUs damit laufen.

Insofern kann man kaum von Protestkauf sprechen, sondern nur von G-Sync-ProtestNICHTkauf.

Zuletzt bearbeitet:

DasKlose

Experte

- Mitglied seit

- 25.02.2015

- Beiträge

- 1.558

- Desktop System

- DasKlose

- Details zu meinem Desktop

- Prozessor

- Intel 13600KS

- Mainboard

- ASrock Steel Leged Z690

- Kühler

- EkWaterBlocks Nickel + Acetal

- Speicher

- 4x8GB DDR4 G.Skill Ripjaw 3600 CL16

- Grafikprozessor

- Manli 4090 RTX

- Display

- Asus ROG PG32UQX (Für schön) & BenQ Zowie XL2546K (Shooter Kompetitiv)

- SSD

- 1x 240GB, 1x 500GB, 1x2TB

- Soundkarte

- Xonar Essence STX

- Gehäuse

- Fractal Define R6

- Netzteil

- MSI 850W

- Keyboard

- Wooting TWO HE

- Mouse

- Razer Basilisk V3 Pro

- Betriebssystem

- Win 10

Also wenn der PC nicht mal 45FPS schafft dann baucht man keinen 144Hz Monitor und erst recht kein G-Sync für 150€ Aufpreis.

Dann lieber eine neue Grafikkarte kaufen damit es nie weniger als 60 oder sogar 100FPS sind um die 144Hz sinnvoll zu nutzen.

AMD FreeSync mit RX480 und AOC G2460PF kostet ca. 500€ vs. Nvidia G-Sync mit GTX1060 und AOC G2460PG kostet ca. 650€

Man sieht also in der Klasse bietet AMD das deutlich bessere Preis/Leistungs Verhältnis. Ohne Monitor spielt das aber keine Rolle.

Sind wir wieder bei dem Thema ja? Hatten wir schon durchgekaut.

Gehe auf die Nvidia Homepage da steht G-Sync macht games die sich unter 60HZ schwammig anfühlen besser spielbar.

Das habe ich bei Witcher 3 auch gemerkt 4K und 30 - 45 FPS und dank G-Sync wars spielbar also erzähle nicht wieder son mist.

Das ist falsch! Fallen die FPS unter die minimale Bildwiederholfrequenz das Bildschirms, werden die FPS automatisch verdoppelt, verdrei- oder vervierfacht. Das wurde schon vor über einem Jahr in der Radeon Sofware eingeführt und die Behauptung, es könne nur G-Sync wird trotzdem ständig weiter verbreitet. Ich bin wirklich enttäuscht, dass man sich nicht vorher informieren kann.

Mittlerweile ist FreeSync zudem im randlosen Fenstermodus nutzbar, sodass G- Sync keinen einzigen Vorteil mehr zu bieten hat. Es ist teuer, benötigt ein Modul im Bildschirm, was einiges an Strom verbraucht(Da wird das bisschen Strom, was man zur RX 480 spart, quasi direkt wieder verbraten), und hat tendenziell höhere Latenzen, weil eben das Sync- Modul noch dazwischenhängt, und es ist im Gegensatz zu FreeSync nicht VESA- standardisiert, sodass ausschließlich Nvidia- GPUs damit laufen.

Insofern kann man kaum von Protestkauf sprechen, sondern nur von G-Sync-ProtestNICHTkauf.

Wurde ja schon gesagt

da ich ne Nvidia hatte habe ich mich da nicht weiter mit befasst. Hatte nur gesehen ab 45fps.

da ich ne Nvidia hatte habe ich mich da nicht weiter mit befasst. Hatte nur gesehen ab 45fps.Aber wenn ich mir das jetzt so überlege was brings wenn ich vervierfachte fps habe statt echte fps???

Zuletzt bearbeitet:

oooverclocker

Semiprofi

- Mitglied seit

- 29.08.2012

- Beiträge

- 5.610

Muss ich übersehen haben, sorry.Wurde ja schon gesagt

Dass der Pixeltakt höher bleiben kann, sodass die Pixel ihre Reaktionsfähigkeit behalten können. Ich gehe mal schwer davon aus, dass das G-Sync- Modul genau das gleiche macht, weil es sonst sicherlich äußerst hässlich aussehen würde - schon die Farbgebung beim ändern des Pixeltakts ist normalerweise problematisch - ich denke also, dass in den Sync- Monitoren auch entsprechende Profile drin sind, die jeweils einen Farbausgleich beim Ändern der Schaltgeschwindigkeit machen... Das ist relativ komplex. Deshalb habe ich auch immer die höhere Range(56-144Hz) ausgewählt, sodass unter 56Hz verdoppelt werden kann, weil sonst die Darstellungsqualität wegen den verschlechterten Monitoreigenschaften ungünstig wird, zumindest um ca. 40Hz herum.was brings wenn ich vervierfachte fps habe statt echte fps???

Zuletzt bearbeitet:

DasKlose

Experte

- Mitglied seit

- 25.02.2015

- Beiträge

- 1.558

- Desktop System

- DasKlose

- Details zu meinem Desktop

- Prozessor

- Intel 13600KS

- Mainboard

- ASrock Steel Leged Z690

- Kühler

- EkWaterBlocks Nickel + Acetal

- Speicher

- 4x8GB DDR4 G.Skill Ripjaw 3600 CL16

- Grafikprozessor

- Manli 4090 RTX

- Display

- Asus ROG PG32UQX (Für schön) & BenQ Zowie XL2546K (Shooter Kompetitiv)

- SSD

- 1x 240GB, 1x 500GB, 1x2TB

- Soundkarte

- Xonar Essence STX

- Gehäuse

- Fractal Define R6

- Netzteil

- MSI 850W

- Keyboard

- Wooting TWO HE

- Mouse

- Razer Basilisk V3 Pro

- Betriebssystem

- Win 10

Dass der Pixeltakt höher bleiben kann, sodass die Pixel ihre Reaktionsfähigkeit behalten können. Ich gehe mal schwer davon aus, dass das G-Sync- Modul genau das gleiche macht, weil es sonst sicherlich äußerst hässlich aussehen würde - alleine die Farbgebung beim ändern des Pixeltakts ist normalerweise problematisch - ich denke also, dass in den Sync- Monitoren auch entsprechende Profile drin sind, die jeweils einen Farbausgleich beim Ändern der Schaltgeschwindigkeit machen... Das ist relativ komplex. Deshalb habe ich auch immer die höhere Range(56-144Hz) ausgewählt, sodass unter 56Hz verdoppelt werden kann, weil sonst die Darstellungsqualität wegen den verschlechterten Monitoreigenschaften ungünstig wird, zumindest um ca. 40Hz herum.

Verstehe ich nicht ganz, aber ich habe keinen unterschied zwischen 30, 45, 100 oder 200fps mit aktiviertem gsync bemerkt.

@ Performer

Nur Müll kommt da rum hauptsache rum Trollen, die 1080 Phoenix GLH ist auf dem Weg und trotzdem hat das 0 damit zutun, bei G-Sync haste eben ab 30fps nen gefühlt schnelleres Bild und fertig.

unl34shed

Enthusiast

Wurde ja schon gesagtda ich ne Nvidia hatte habe ich mich da nicht weiter mit befasst. Hatte nur gesehen ab 45fps.

Aber wenn ich mir das jetzt so überlege was brings wenn ich vervierfachte fps habe statt echte fps???

Die Panels sind nicht in der Lage das Bild permanent anzuzeigen, die Pixel werden ohne Ansteuerung weiß, gerade bei den schnellen Displays ist das ein Problem, die die Pixel nicht so träge sind, wie bei einem 60Hz Panel und das ganze recht schnell passiert.

Deswegen gibt es eine minimal Refreshrate bei den Monitoren und niedriger ist hier nicht unbedingt besser. Prinzipiell kann es bei FPS am unteren Limit zu Flackern kommen, das empfindliche Menschen wahrnehmen können und hier ist die Wahrscheinlichkeit bei weniger Hz höher.

Und zur Verdopplung:

Am Ende besteht kein Unterschied ob ein Bild mit 40Hz oder 80Hz und jedes zweite Bild ändert sich erst angezeigt wird, sind beides Effektiv 40Hz/FPS.

Solange der Frequenzbereich des Freesync / G-Sync Monitors groß genug ist, dass die minimal Frequenz <= die halbe max. Frequenz ist, ist das kein Problem.

DasKlose

Experte

- Mitglied seit

- 25.02.2015

- Beiträge

- 1.558

- Desktop System

- DasKlose

- Details zu meinem Desktop

- Prozessor

- Intel 13600KS

- Mainboard

- ASrock Steel Leged Z690

- Kühler

- EkWaterBlocks Nickel + Acetal

- Speicher

- 4x8GB DDR4 G.Skill Ripjaw 3600 CL16

- Grafikprozessor

- Manli 4090 RTX

- Display

- Asus ROG PG32UQX (Für schön) & BenQ Zowie XL2546K (Shooter Kompetitiv)

- SSD

- 1x 240GB, 1x 500GB, 1x2TB

- Soundkarte

- Xonar Essence STX

- Gehäuse

- Fractal Define R6

- Netzteil

- MSI 850W

- Keyboard

- Wooting TWO HE

- Mouse

- Razer Basilisk V3 Pro

- Betriebssystem

- Win 10

bla bla bla ... ich habe bei CS-Go über 300 bis 500 FPS also erzähle hier nicht son mist, Doom läuft auch mit 120-140.

BF1 ist auch über 100 und das mit ner 1070, also wenn du kein Plan hast dann sei still.

Und pass auf ... SCHOCK meiner kann sogar 165Hz ...

BF1 ist auch über 100 und das mit ner 1070, also wenn du kein Plan hast dann sei still.

Und pass auf ... SCHOCK meiner kann sogar 165Hz ...

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 9

- Aufrufe

- 1K

- Antworten

- 6

- Aufrufe

- 954