Hallo liebe Luxxer

Ich hab mich mal wieder dazu entschlossen, ein kleines Review zu schreiben.

Grundsätzlich will ich die GTX580 so ausführlich wie möglich testen, sowie die Leistung mit und ohne OC darzulegen.

Später werde ich noch Einfluss des CPU Taktes, Treibervergleiche und Stromverbrauch in den Test einfließen lassen.

Unteranderem werde ich auch noch kurz Vergleiche zur GTX 560 bei gleichem Takt in das Review aufnehmen.

==================================================

Zum System:

- Asus Rampage II Extreme, Bios 1406

- Intel W3520 4,2GHz (200x21)

- 6x2GB Corsair Dominator (1600MHz 8-9-8-24)

- POV GTX 580 @ 772/1544/2004 (default)

- POV GTX 580 @ 875/1750/2100

- POV GTX 580 @ 950/1900/2200

- POV GTX 580 @ 1000/2000/2400

- POV GTX 580 @ 1050/2100/2475

- OCZ Vertex 2 (120GB)

- Seasonic X-850 Semi passiv 850W

- CPU und GTX580 unter Wakü

In den Tests kommt jeweils ein absolut identisches System zum Einsatz, so dass keine externen Parameter die Ergebnisse beeinflussen.

Ich will noch im Vorraus sagen, dass ich erst mal nur ein paar Dinge testen konnte, sobald ich Zeit finde, kommen neue Tests hinzu!

Würde ich auch über Anregungen und Wünsche freuen, auf die ich, wenn ich die Möglichkeit habe, eingehen will!

So dann erst mal zu Beginn ein paar Bilder der Komponenten:

(alle Bilder zu Vergrößern anklicken (1920x1080))

Point of View GTX 580, ... schöne Karte

==================================================

Erste Eindrücke

Erste Eindrücke der Karte, welche ich sammeln konnte, liste ich hier einfach mal stichpunktartig auf, um die Übersicht zu wahren:

- Die Karte ist sauber und ordentlich verarbeitet und macht einen soliden Eindruck.

- Idle ist die GTX580 sehr leise, fast nicht hörbar (Lüfter 40%, wer das anpasen will kann gern auf 30% gehen)

- Idle lässt sich die Lüfterdrehzahl problemlos auf 25% senken, dadurch wird die Karte unhörbar.

- Verbrauch Idle liegt bei Standardspannung bei ca. 30W (bei 0,962v).

- Bei 85% Lüfterdrehzahl ist die Karte schon recht laut, aber so hoch muss der Lüfter in der Regel nicht drehen.

- Umbau des Kühlers auf Wasserkühlung ist sehr einfach.

- Unter Last hängt sowohl Temperatur als auch Lautstärke stark von der verwendeten Spannung ab. Hier gibt es Unterschiede von Karte zu Karte, welche im folgenden Abschnitt dargelegt werden. Generell verbraucht die Karte recht viel unter 3D Last.

==================================================

Spannung 2D/3D / Lautstärke / Lüfterdrehzahl

Zur zeit lassen sich bereits die Spannungen der Karte per Software im laufenden Betrieb anpassen.

Nützliche Tools hierzu sind zur Zeit der "MSI Afterburner" oder der "Nvidia Inspector".

Mittels dieser Tools lassen sich zur Zeit Spannungen von 0,825v - 1,150v auf den Chip anlegen.

Liste der möglichen Spannungen:

Bisher scheint es so zu sein, dass unter 2D alle 580er Karten mit 0,962v angesteuert werden.

3D hingegen gibt es da deutliche Unterschiede welche Standardspannung anliegt.

Hier wird wahrscheinlich nach Qualität der Chips unterschieden und entsprechende Spannung angelegt.

Die 3D Werte liegen bisher zw. 1,000v und 1,088v.

Per Biosflash und dem Anpassen der Spannungen lassen sich bis 1,213v "freigeben".

Daraus resultiet natürlich die Temperatur, der Verbrauch und somit auch die Lautstärke der Karte.

An dieser Stelle sei erwähnt, dass viele Karten mit einer deutlich verringerten, als die vorgegebene Spannung auskommen.

Hier ein kleines Beispiel:

772/1544/2004 (default) - 1,000v > 82°C > 56% Lüfter (Lautstärke: deutlich hörbar)

772/1544/2004 (default) - 0,900v > 78°C > 47% Lüfter (Lautstärke: recht angenehm)

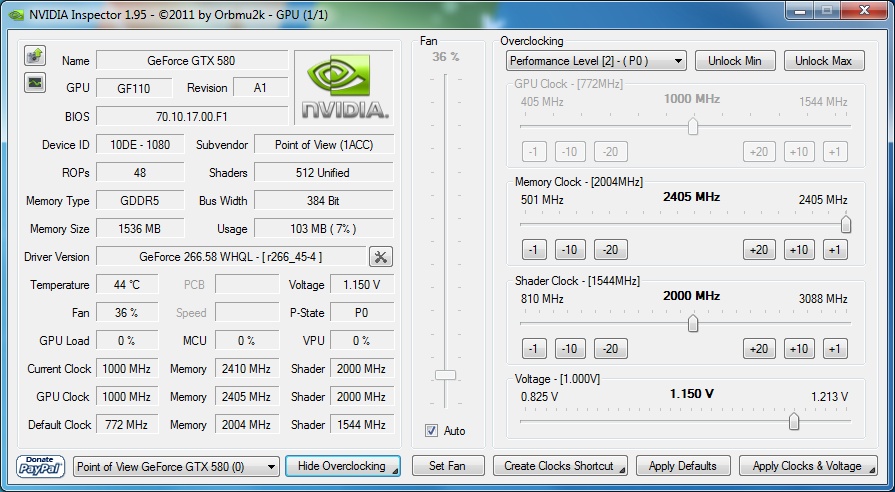

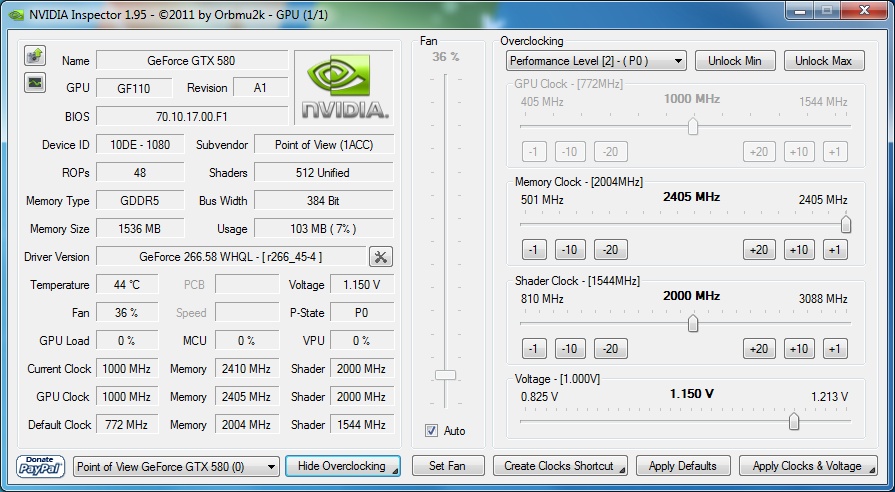

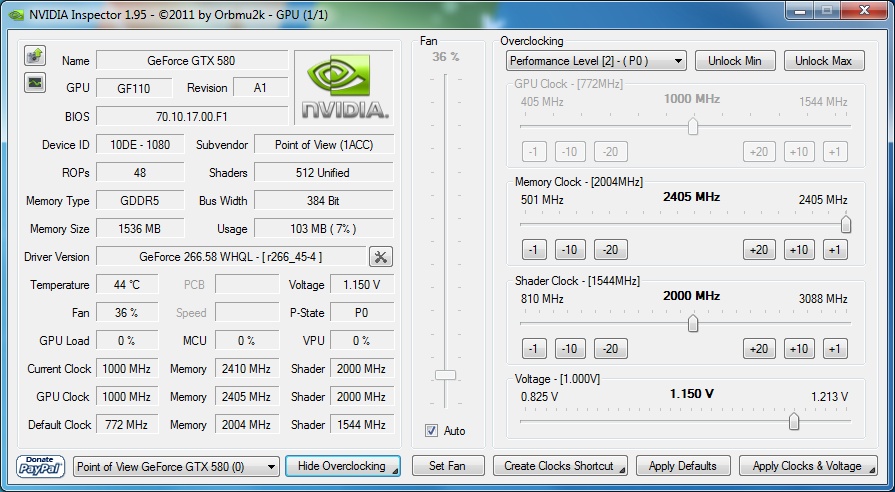

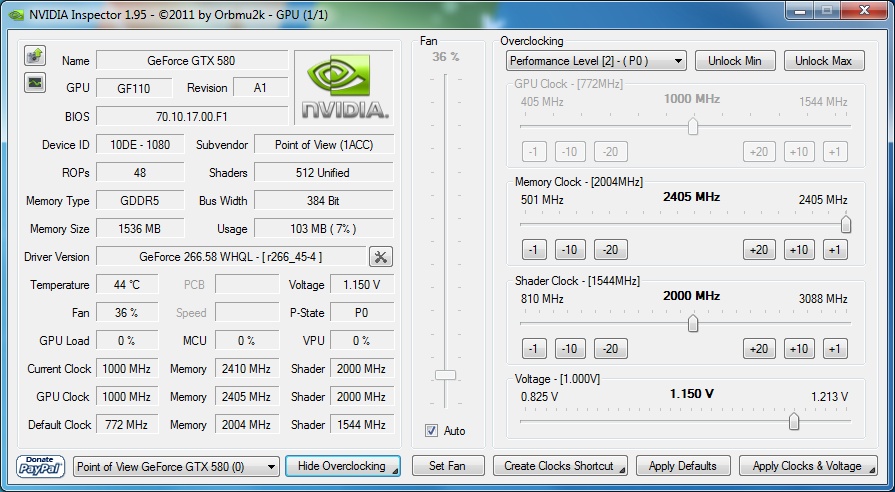

Einstellungen sowie OC lassen sich einwandfrei mittels Nvidia Inspector vornehmen:

Genauere Tests dazu im Abschnitt "Leistungsaufnahme / vGPU"

==================================================

Umbau auf Wakü:

Da für mich klar war, dass die Karte zu etwas laut sein wird für einen Silent-PC, habe ich mich schon gleich dazu entschlossen auf Wakü um zurüsten.

Ich habe mich für den EK FC-580 entschieden.

Um die Karte optisch ist was schicker zu machen, habe ich der GTX 580 zusätzlich die EVGA Backplate spendiert.

Der Umbau ist sehr einfach und größtenteils problemlos.

Auf Wunsch kann ich den Vorgang aber gern genauer beschreiben.

Fürs ersten sollten hier einige Bilder genügen.

(alle Bilder zu Vergrößern anklicken (1920x1080))

Update 17.01.2012

So, ich hab mal die Wasserkühler gereinigt und neu zusammen gebaut. Sieht jetzt wie folgt aus.

Ist noch nicht ganz fertig, der PowerAmp für die 9 Lüfter fehlt z.B. noch, der sollte aber jeden Moment per DHL hier ankommen.

==================================================

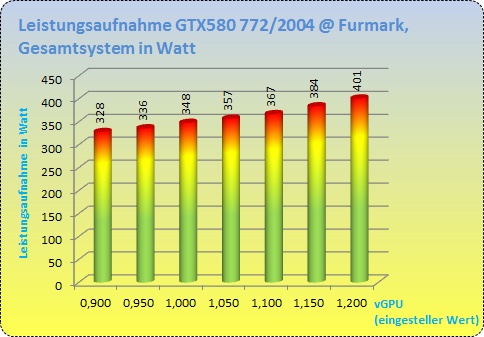

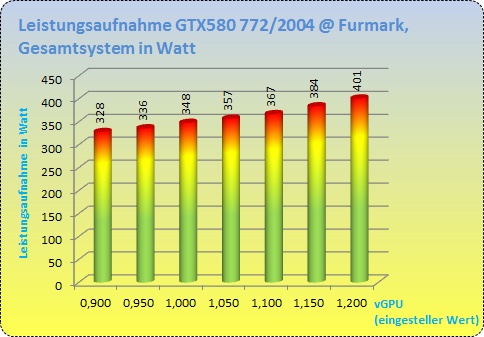

Leistungsaufnahme / vGPU

Zum messen der Leistungsaufnahme dient mir ein Energy Check 3000,

Den direkten Verbrauch an der Karte kann ich leider nicht messen, somit sind alle angegebenen Werte jeweils die Verbrauchswerte des gesamten Systems.

Idle:

Idle verbrauche ich zur Zeit 193W, welche aber nicht optimiert sind, da die CPU z.B. immer mit voller Spannung läuft. Mit Optimierten Werten braucht obiges System ca. 180W wobei ca. 30W auf die Rechnung der GTX 580 gehen.

Unter Last:

Unter Last ist die GTX 580 recht stromhungrig. Aber auch hier ist wieder zu sagen, dass die sehr stark von der anliegenden GPU Spannung im 3D Modul anhängt, welche ja, wie bereits erwählt von Karte zu Karte unterschiedlich ist. Daher rühren auch die unterschiedlichen Ergebnissen in den Reviews.

Damit ihr euch ein Bild machen könnt, anbei drei Beispiele mit unterschiedlichen Konfigurationen bzgl. Takt und 3D Spannung.

Bei den folgenden Tests lief jeweils Furmark, CPU lag bei 4200MHz bei 1,28v, was ja sicherlich auch nicht unbedeutend ist.

Tests jeweils mit Furmark und CPU bei 4200MHz bei 1,28v.

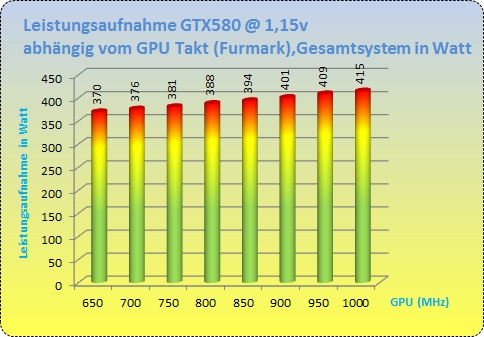

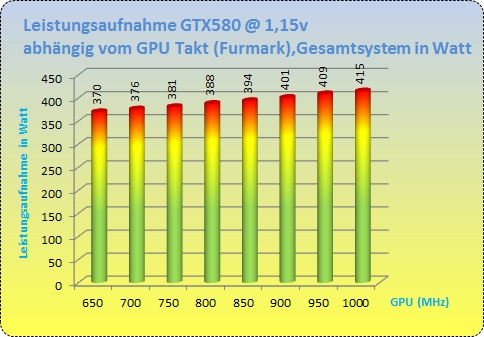

Gleicher Takt bei unterschiedlicher Spannung:

GTX 580 @ 772/1544/2004 @ x,xxv

Gleiches hier grafisch dargestellt.

Gleiche Spannung bei unterschiedlichem Takt:

GTX 580 @ xxx/xxxx/2004 @ 1,150v

==================================================

Overclocking

Overclocking

Zum übertakten der GTX 580 eigenen sich zur Zeit zwei Tools ganz gut.

Zum einen der Nvidia Inspector (z.Z. in der Version 1.9.5)

Und zum zweiten das von MSI bereitgestellte Tool "MSI Afterburner"

Beide sind denke ich inhaltlich selbsterklärend, wodurch ich nicht näher auf die Funktion der beiden Tools eingehen werde.

Beim MSI Afterburner ist vlt. zu sagen, dass das Verändern der Spannung (vGPU) erst in den Einstellungen aktiviert werden muss.

Taktraten:

Die GTX 580 benutzt standardmäßig drei Taktstufen, jeweils Core/Shader/Mem:

P12: 51/101/135

P8: 405/810/324

P0: 772/1544/2004

Core und Shader sind bisher fest im Verhältnis 1:2 verbunden.

Spannungen

Wie bereits erwähnt, lassen sich Spannungen zw. 0,825 und 1,150v (default Bios) wählen.

Das ist die Spannung, mit der die GPU versorgt wird.

Wie schon bei der GTX 480 ist aber auch die Spannung für den VRam unmittelbar an diese Einstellung gekoppelt. Mit höher eingestellter vGPU lässt sich also auch der Speicher höher übertakten.

Dieser wird offensichtlich von Nvidia aber mit deutlich weniger als der für den Speicher vorgesehenen Spannung versorgt. Somit sind Taktraten von 1250MHz und mehr, die der 0.4er Speicher erreichen sollte, kaum zu erreichen.

Stabilität testen

Furmark heizt nach wie vor die Karten richtig ein was Verbrauch und Temperatur angeht, ist allerdings für Stabilität nicht die beste Wahl.

Um sicher zustellen dass die Karte stabil arbeitet sollte man einige Heaven und Vantage oder 3DMark11 Runs laufen lassen, wobei 3D Mark Vantage oftmals noch etwas sensibler reagiert. Auch Crysis und Crysis Warhead sind zum testen eine gute Wahl.

2D Modus untervolten

Im 2D Modus taktet die Karte mit 51/100/135MHz und wird bei bisher allen Karten mit 0,962v befeuert.

Hier haben schon viele User die Erfahrung gemacht, dass auch die minimal einzustellenden 0,825v vollkommen ausreichend sind.

Hier muss aber jeder für sich mal testen, welche Spannungen für die eigene Karte ausreichend sind.

==================================================

Bios anpassen (2D/3D Taktraten, vGPU 2D/3D)

Nachdem man ausführlich getestet hat, welche OC Einstellungen auf die Karte passen, ist es durchaus sinnvoll, diese auch im Bios speichern zu können.

Hier erst mal ein großes Lob an den User Orbmu2k_, ohne ihn wäre es nicht so leicht die entsprechenden Änderungen vorzunehmen.

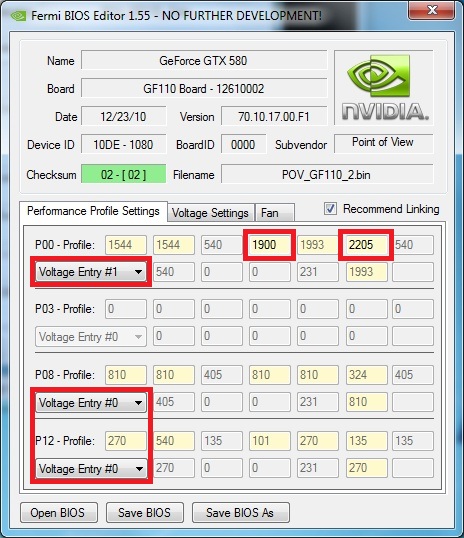

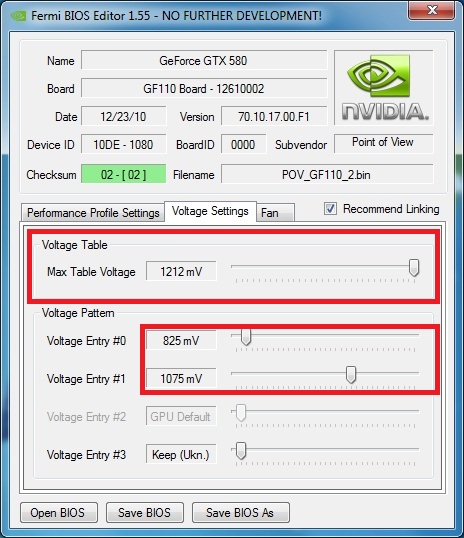

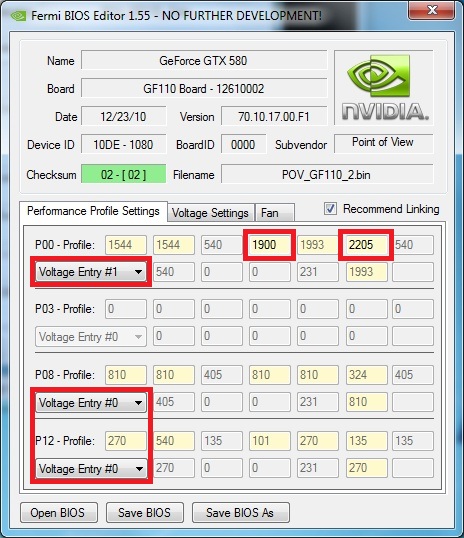

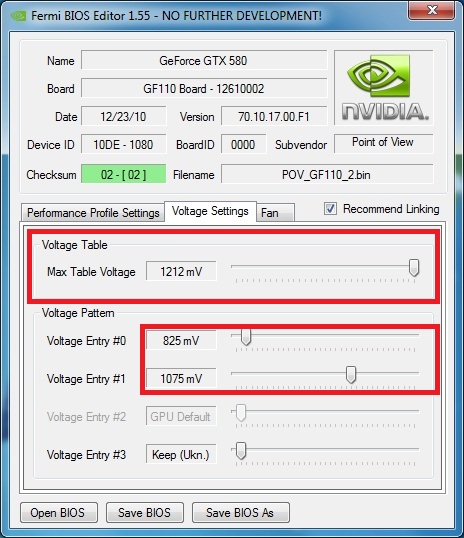

Mit dem Tool 'Fermi Bios Editor' ist es möglich, wie auf den beiden folgenden Bildern zu sehen, sämtliche Taktdomains und Spannungseinstellungen zu ändern. Zudem ist es möglich, die maximal einzustellende vGPU zu definieren.

Noch mals sei erwählt, dass es sehr wichtig ist, die drei Taktdomains vorher mit den gewünschten Spannungen durchzutesten und erst dann die Einstellungen im Bios anzupassen.

In meinem Beispiel habe ich dem entsprechend die Werte wie folgt geändert.

P12 - 51/101/135MHz bei 0.825v

P00 - 950/1900/2205 bei 1.075v

Max. vGPU auf 1.213v erhöht

Lüfterdrehzahl auf 30 - 100% abgeändert.

Nach dem Speichern und anschließendem Flashen (nächster Abschnitt) des Bios, spiegeln sich die geflashten Werte natürlich als Defaultwerte wieder.

==================================================

Bios flashen

Das Flashen des Bios ist eigentlich bei der GTX 580 nichts neues gegenüber den vorherigen Karten.

Zum Flashen nutzt mal z.B. das Tool "nvFlash" in der aktuellen Version.

Der Vorgang selbst ist sehr simpel:

- Bootfähige CD oder USB Stick erstellen

- NVFlash und das zu flashende Bios in der Form "Biosname.rom" auf die CD kopieren

- PC neustarten

- Von CD/USB booten

- Den Befehl 'NVFLASH -5 -6 Biosname.rom' ausführen

- Mit 'y' bestätigen

- FERTIG! PC neustarten.

Das ganze noch ein mal bebildert um es etwas anschaulicher zu machen.

==================================================

Video- /BluRaywiedergabe - Verbrauch

Hier kann ich erfreuliches berichten. Die Karte taktet zum wiedergeben von Blu-Rays / *.mkv Files auf 405/810/324MHz und nutzt die 2D Spannung und verbraucht so nur ca. 10W mehr als idle.

==================================================

Einfluss PCIe Takt

... Tests folgen ...

==================================================

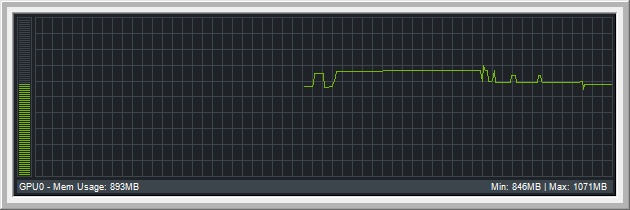

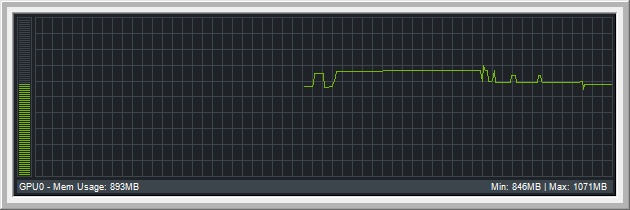

VRam Auslastung

Die GTX 580 hat ja 1,5GB VRam, hier mal einige Beispiele wie stark der Speicher von verschiedenen Anwendungen ausgelastet wird.

Crysis Warhead

1920x1080, Enthusiast, 16xQ AA - 1215MB

F1 2010

1920x1080, 16xQ 16xAF 8xSS im Treiber - 1071MB

3D Mark 11

Performance Preset - 354MB

... auch hier folgen natürlich weitere Tests

==================================================

Vergleich GTX 560 / GTX 580 bei gleichem Takt

Hier ein kleiner Vergleich des kleineren Ablegers GTX 560.

Getestet wurde im gleichen System und bei gleichem Takt der Karten.

Jeweils bei 1000/2000/2400MHz

3DMark 11

Entry:

GTX 560 (E8088) - 100% / GTX 580 (E11251) - 139,1%

Performance:

GTX 560 (P5094) - 100% / GTX 580 (P7581) - 148,8%

Extreme:

GTX 560 (X1682) - 100% / GTX 580 (X2506) - 148,9%

Crysis Warhead

1920x1080, Ent. 16xQ GTX 560 (33,29FPS) - 100% / GTX 580 (49,33FPS) - 148,2%

Hier anbei noch ein paar Bilder einer EVGA GTX 560, auch recht schick wie ich finde:

==================================================

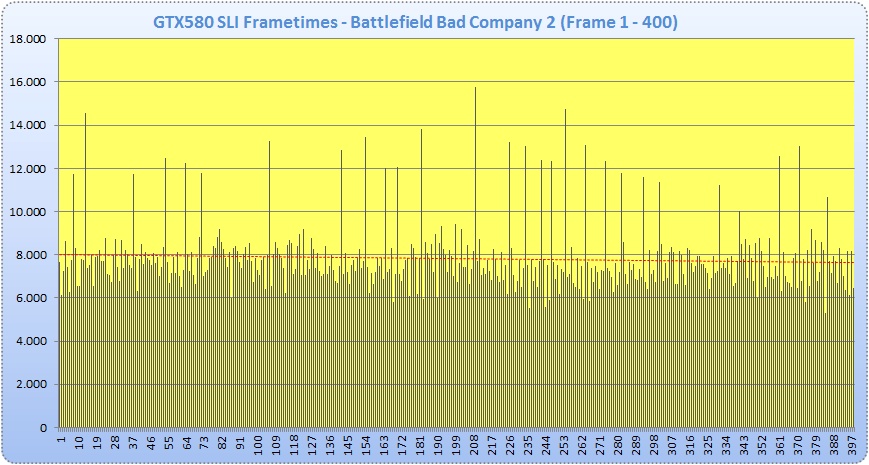

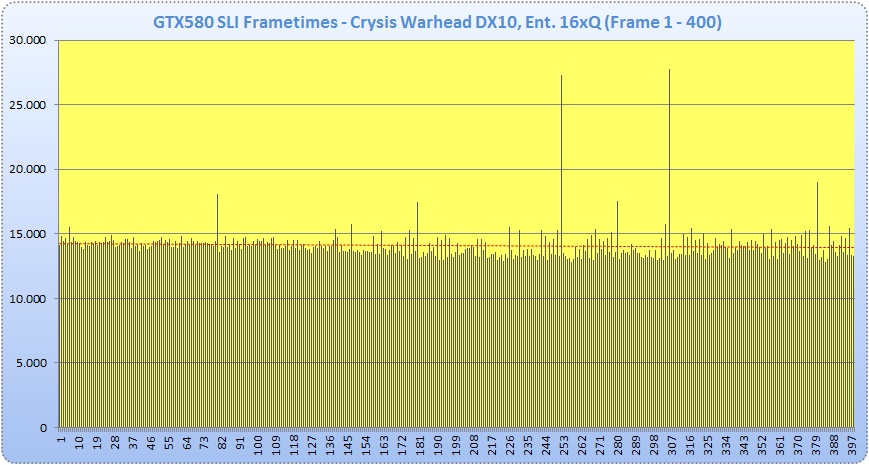

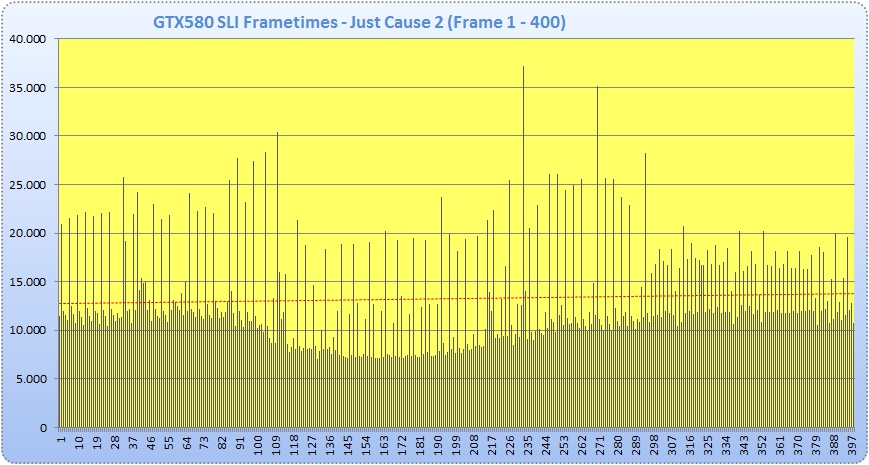

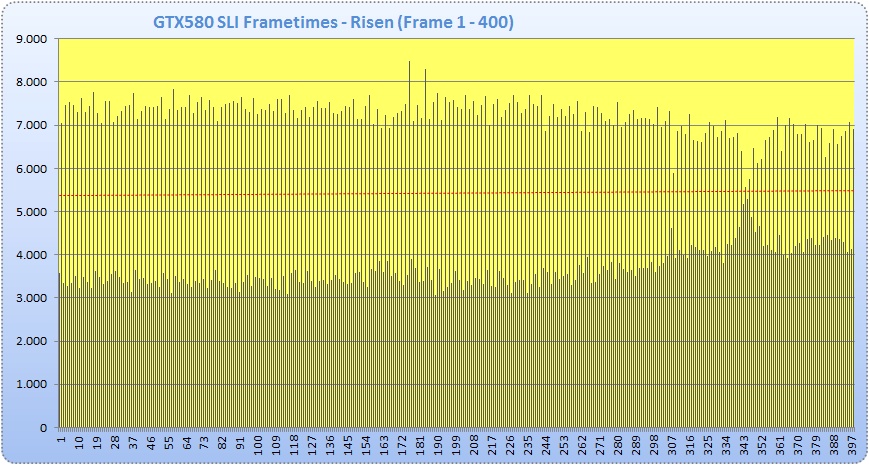

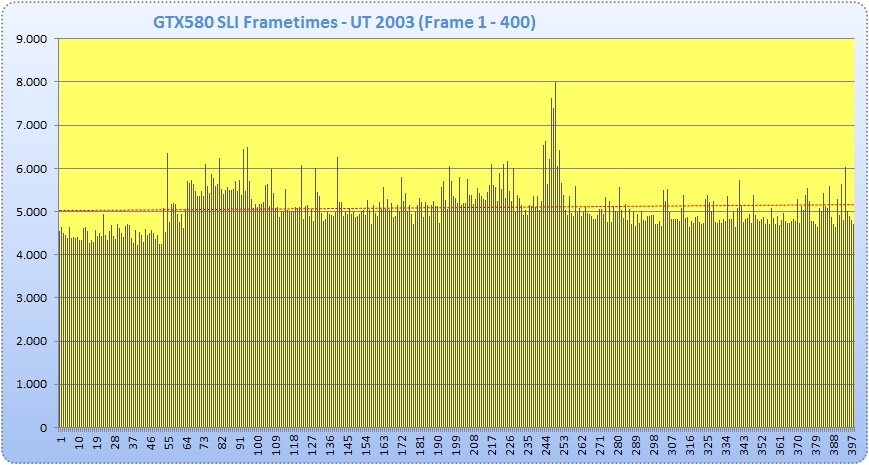

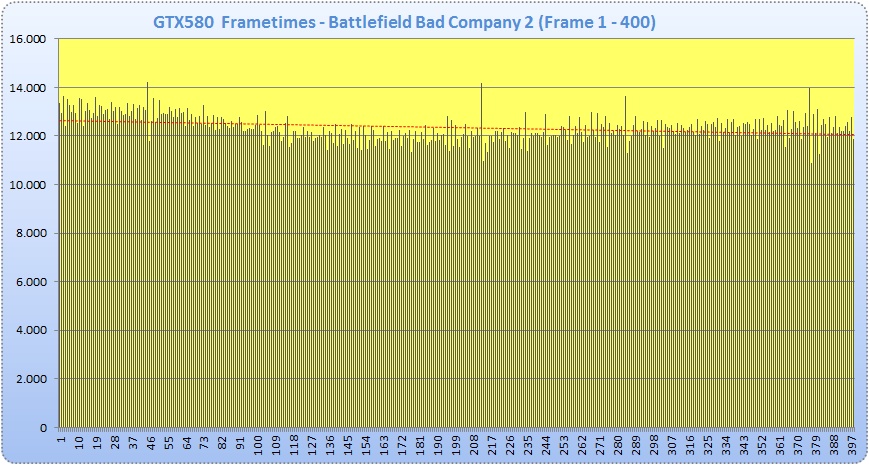

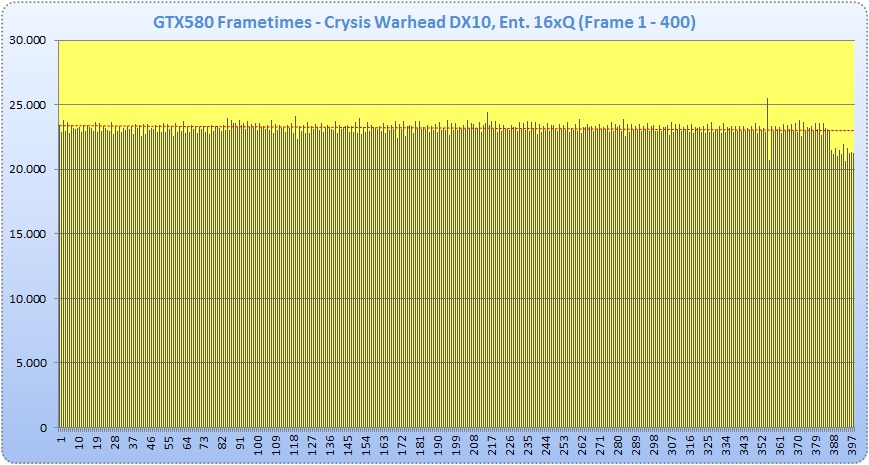

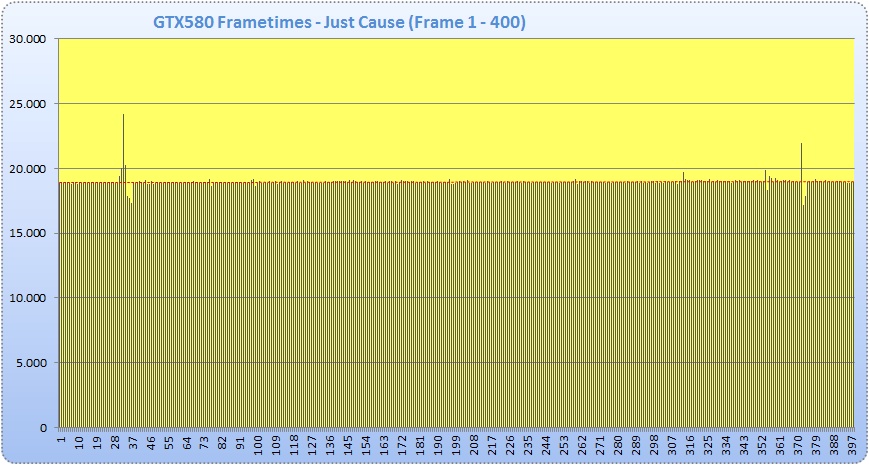

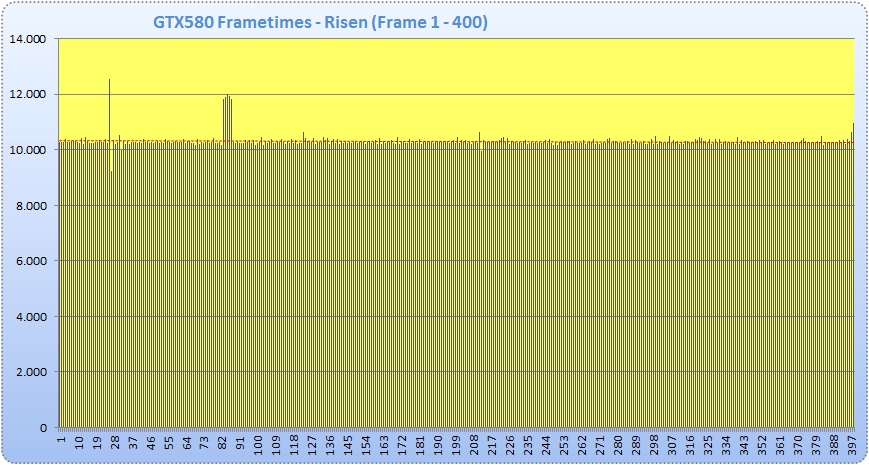

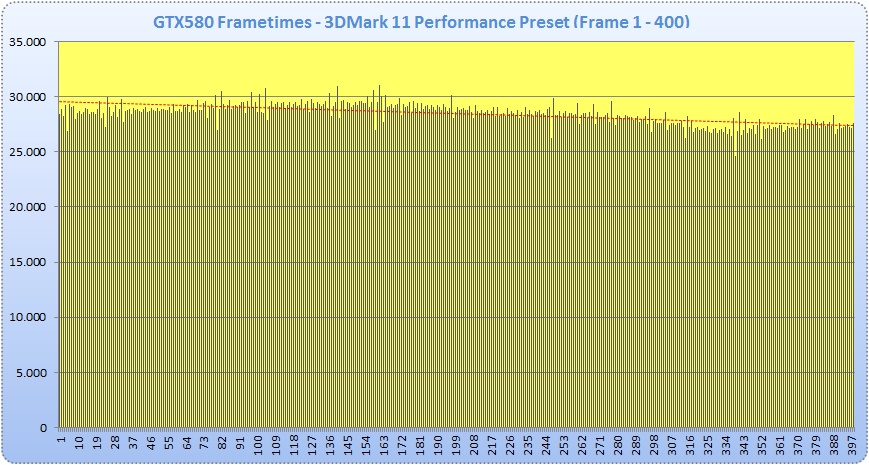

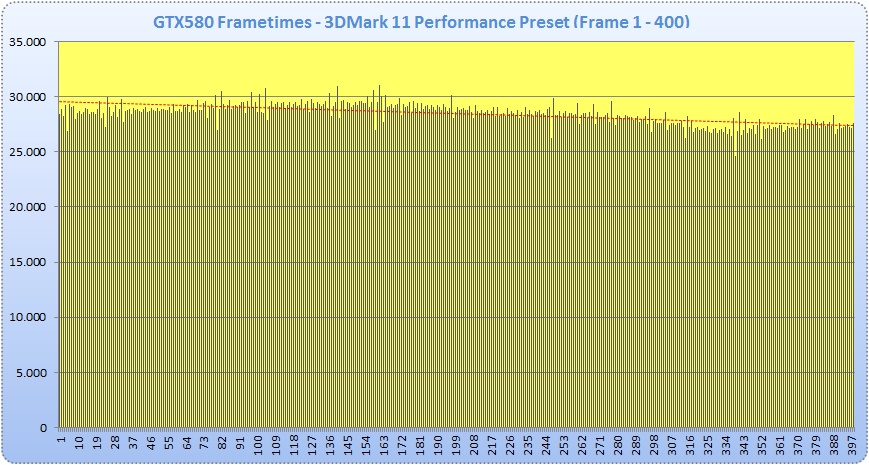

Frametimes

Da die Thematik der Mircoruckler immer noch ein leidiges Thema ist, werde ich auch hier kurz darauf eingehen.

Für die User, denen das kein Begriff ist, vielleicht eine kurze Erklärung.

Frametimes sind die Zeitabstände zwischen zweier Frames, sprich der Abstand zwischen Frame 1 und 2, ... und 2 und 3 ... usw.

Optimalerweise sollten diese natürlich immer möglichst gleich groß sein. Mit Single Karten ist das auch in der Regel so.

Sobald aber mehr als eine Karte zum Einsatz kommt, ist es offenbar seitens der Hersteller nicht einfach, diese Zeitabstände gleich zu halten.

Merklich störend wirken diese sog. Mircoruckler eigentlich nur ein Framebereichen von 0 bis ca. 40FPS.

Wenn ein Spiel mit mehr FPS läuft, sind diese nur schwer bis gar nicht wahrnehmbar.

Hier einige Test dazu:

Frametimes mit aktivem SLI:

3DMark11

Im Spoiler die restlichen Tests:

Edit:

Hier noch die entsprechenden Tests ohne SLI

3DMark11

Im Spoiler die restlichen Tests:

Was festzustellen ist, ist dass die MRs nach wie vor bestehen. Allerdings muss ich dazu sagen, dass diese kaum mehr wahrnehmbar sind.

Früher waren die schon deutlich störend, was nun nicht mehr der Fall ist.

Hinzuzufügen ist, dass in Games wie Crysis, bei denen man überhaupt mal in FPS Bereiche unter 40 kommen kann, die Microruckler deutlich vermindert wurden.

Da hat nVidia offenbar gute Arbeit geleistet.

==================================================

Treibervergleiche

... Tests folgen ...

==================================================

SLI Skalierung

Auch das Thema wollte ich etwas anreißen.

Früher war es leider oft so, dass es noch viele Anwendungen und Spiele gab, die SLI nicht ordentlich nutzen konnten. Mittlerweile sieht das schon ganz anders aus.

Zwar werden nicht in allen Games die unten zu sehenden Werte erreicht, aber dennoch sieht die Unterstützung der Spiele bzw. die Weiterentwicklung der Treiber sehr gut aus.

Hier drei Beispiele:

GTX580 einmal als Single Karte und einmal im SLI Verbund.

3DMark11 GPU Score: 6446 vs. 12742 >> + 97,7%

Crysis Warhead DX10, 16xQ: 43,40 FPS vs. 80,92 FPS >> + 86,5%

Unigine Heaven 2.1: 52,4 FPS vs. 97,7 FPS >> + 86,5%

==================================================

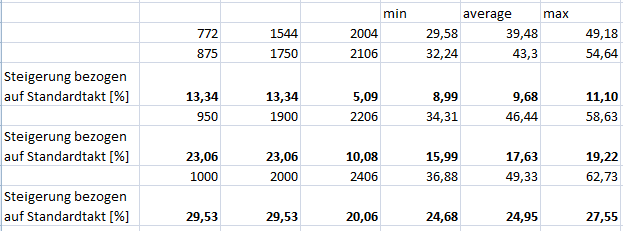

Gamebenchmarks und Leistungszuwachs bei OC

In deisem Test will ich testen die gut die GF110 Architektur mit dem Takt skaliert.

Crysis Warhead

Settings:

1920x1080, 16QxAA, Alles auf Enthusiast, DX10

GTX 580 @ 772/1544/2004 > 00,0% OC > 100,0% Leistung

GTX 580 @ 875/1750/2105 > 10,5% OC > 109,9% Leistung

GTX 580 @ 950/1900/2205 > 18,7% OC > 117,6% Leistung

GTX 580 @ 1000/2000/2410 > 26,4% OC > 124,9% Leistung

Unigine Heaven 2.1

Settings:

1920x1080, Exteme Tesslation, DX 11, Shaders high, 4xAF

GTX 580 @ 772/1544/2004 > 00,0% OC > 100,0% Leistung

GTX 580 @ 875/1750/2105 > 10,5% OC > 111,2% Leistung

GTX 580 @ 950/1900/2205 > 18,7% OC > 119,5% Leistung

GTX 580 @ 1000/2000/2410 > 26,4% OC > 125,7% Leistung

Just Cause 2

GTX 580 @ 772/1544/2004 > 00,0% OC > 100,0% Leistung

GTX 580 @ 875/1750/2105 > 10,5% OC > 110,5% Leistung

GTX 580 @ 950/1900/2205 > 18,7% OC > 118,6% Leistung

GTX 580 @ 1000/2000/2410 > 26,4% OC > 124,4% Leistung

F1 2010 Min. FPS

GTX 580 @ 772/1544/2004 > 00,0% OC > 100,0% Leistung

GTX 580 @ 875/1750/2105 > 10,5% OC > 107,8% Leistung

GTX 580 @ 950/1900/2205 > 18,7% OC > 115,6% Leistung

GTX 580 @ 1000/2000/2410 > 26,4% OC > 120,3% Leistung

==================================================

3D Marks

3D Mark Vantage Performance

GTX 580 @ 772/1544/2004 > 00,0% OC > 100,0% Leistung

GTX 580 @ 875/1750/2105 > 10,5% OC > 109,9% Leistung

GTX 580 @ 950/1900/2205 > 18,7% OC > 116,9% Leistung

GTX 580 @ 1000/2000/2410 > 26,4% OC > 121,8% Leistung

3D Mark 11 Performance

GTX 580 @ 772/1544/2004 > 00,0% OC > 100,0% Leistung

GTX 580 @ 875/1750/2105 > 10,5% OC > 110,3% Leistung

GTX 580 @ 950/1900/2205 > 18,7% OC > 117,7% Leistung

GTX 580 @ 1000/2000/2410 > 26,4% OC > 123,5% Leistung

==================================================

Verschiedenes und max. OC Ergebnisse

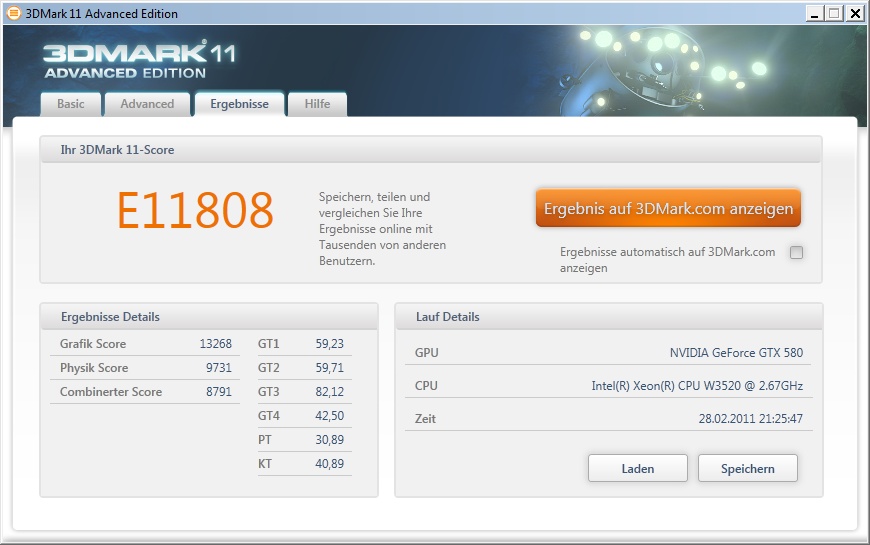

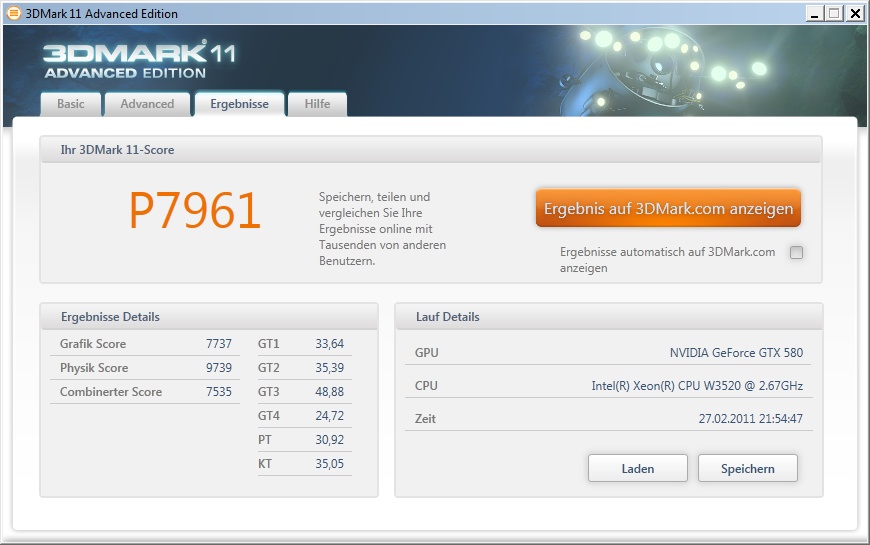

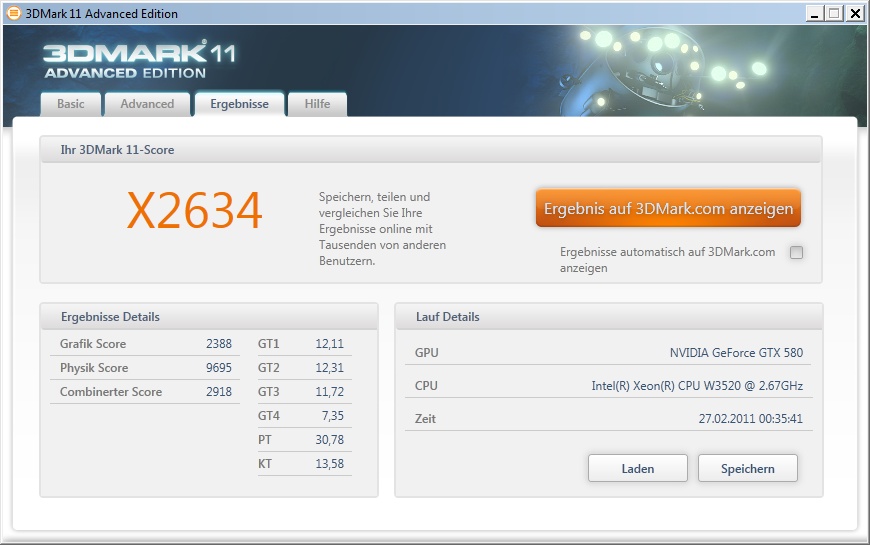

Update 28.02.2011

So Leute, hier mal ein paar OC Tests unter Wasser:

3DMark 11 @ 1060/2120/2475 .... leider ist die CPU nicht mehr die schnellste ...

Entry (E) Rangliste - Single GPU

OliverM84 - Microsoft Windows 7 x64 - Intel W3520 @ 4200Mhz - X58 - 6x 2GB DDR3-1600Mhz - GTX 580 @ 1055/2110/2450 - E11808

Performance (P) Rangliste - Single GPU

OliverM84 - Microsoft Windows 7 x64 - Intel W3520 @ 4200Mhz - X58 - 6x 2GB DDR3-1600Mhz - GTX 580 @ 1060/2120/2475 - P7961

Extreme(X) Rangliste - Single GPU

OliverM84 - Microsoft Windows 7 x64 - Intel W3520 @ 4200Mhz - X58 - 6x 2GB DDR3-1600Mhz - GTX 580 @ 1050/2100/2450 - X2634

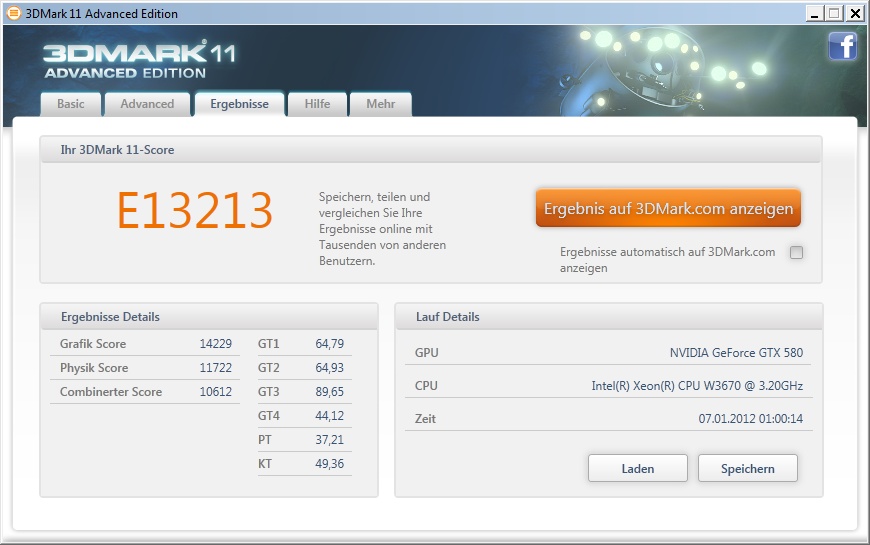

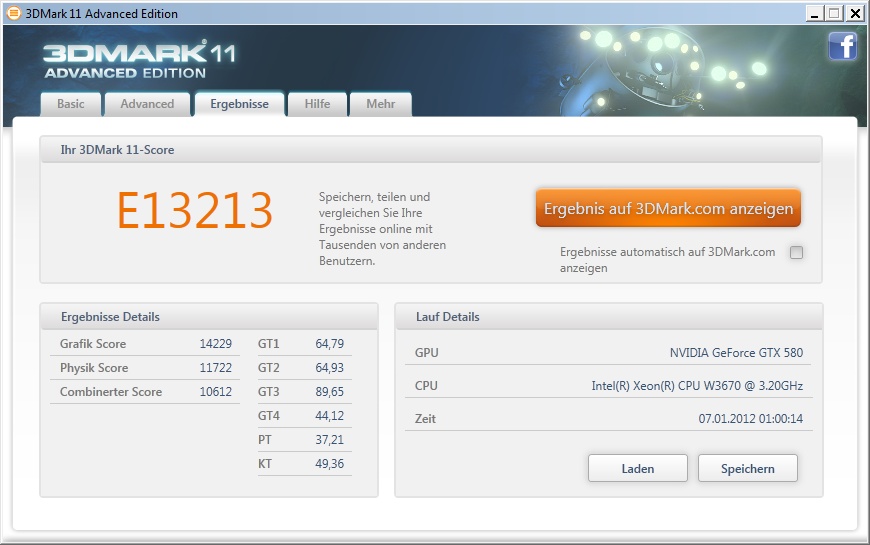

Update 07.01.2012

kleines Update von mir mit aktuellen Treibern und etwas mehr CPU Takt..

Entry (E) Rangliste - Single GPU

OliverM84 - Microsoft Windows 7 x64 - Intel W3670 @ 4,6GHz - Asus Rampage III Extreme - 6x 2GiB DDR3-1600 - nVidia GTX 580 @ 1065/2450 - E13213

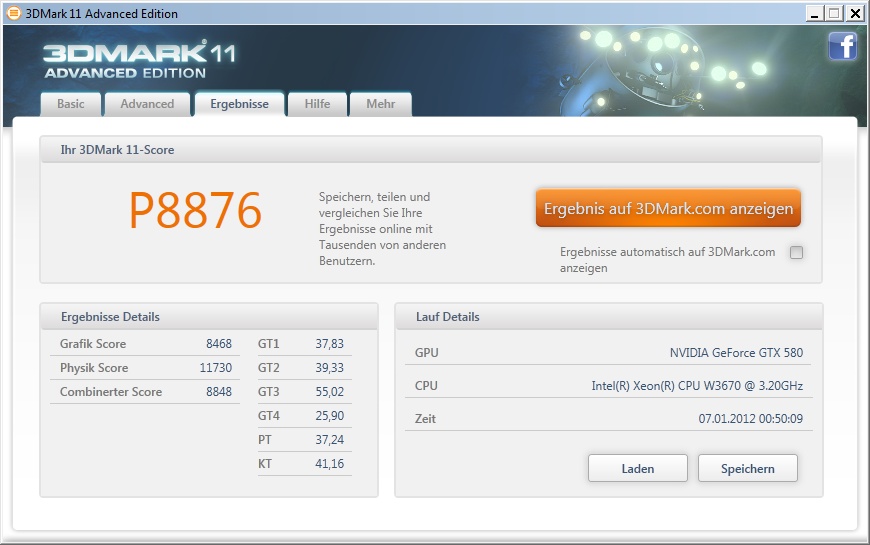

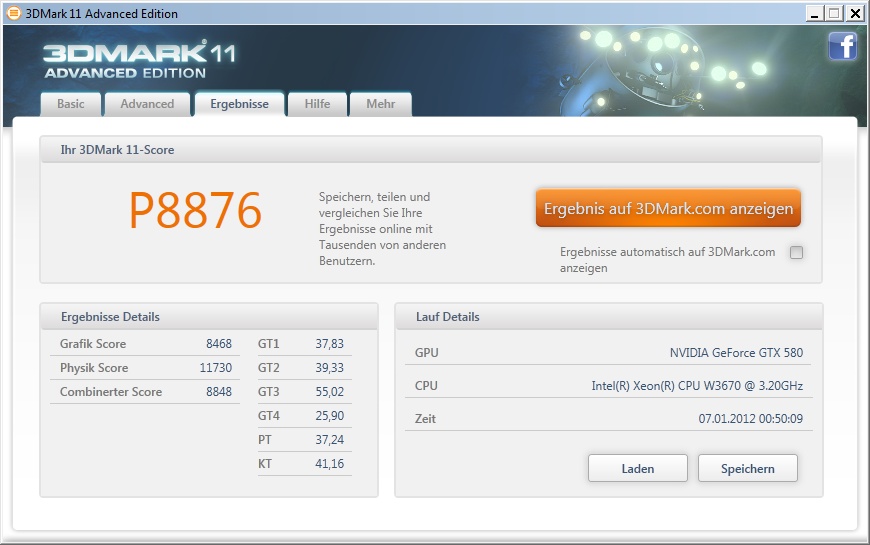

Performance (P) Rangliste - Single GPU

OliverM84 - Microsoft Windows 7 x64 - Intel W3670 @ 4,6GHz - Asus Rampage III Extreme - 6x 2GiB DDR3-1600 - nVidia GTX 580 @ 1070/2450 - P8876

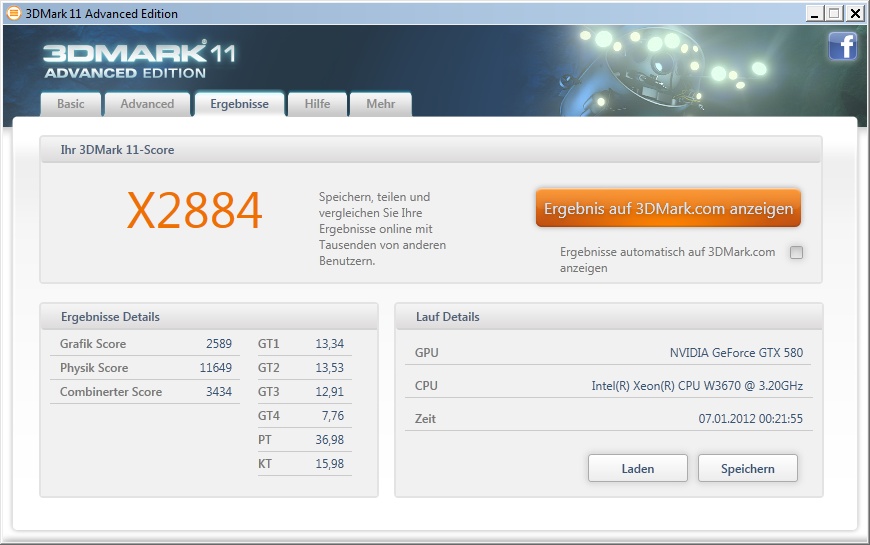

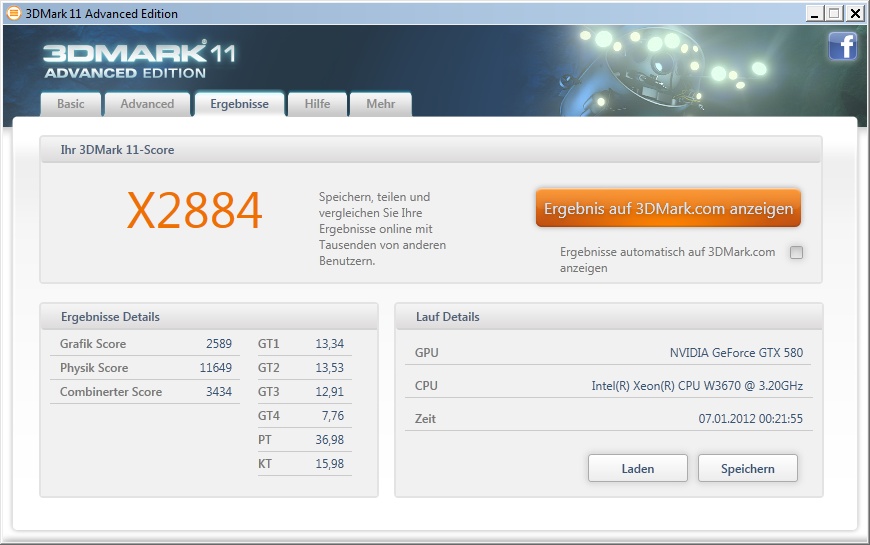

Extreme(X) Rangliste - Single GPU

OliverM84 - Microsoft Windows 7 x64 - Intel W3670 @ 4,6GHz - Asus Rampage III Extreme - 6x 2GiB DDR3-1600 - nVidia GTX 580 @ 1065/2475 - X2884

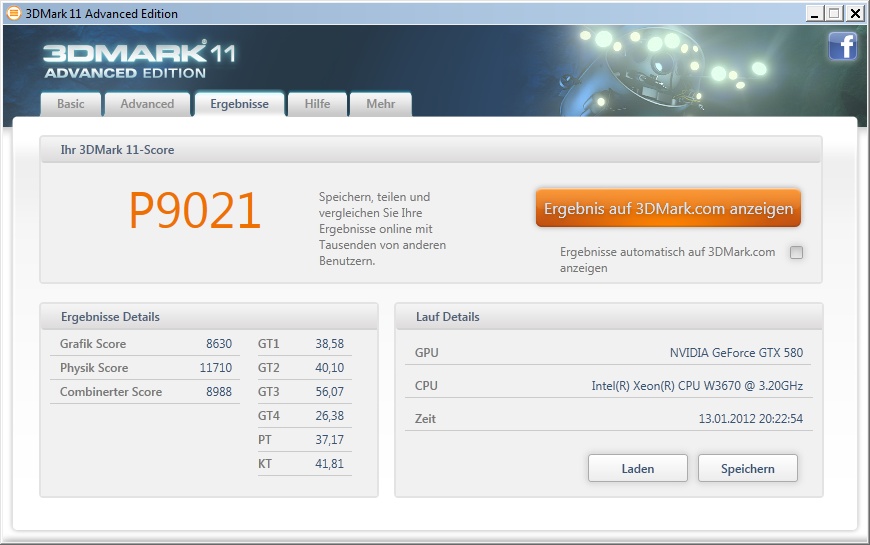

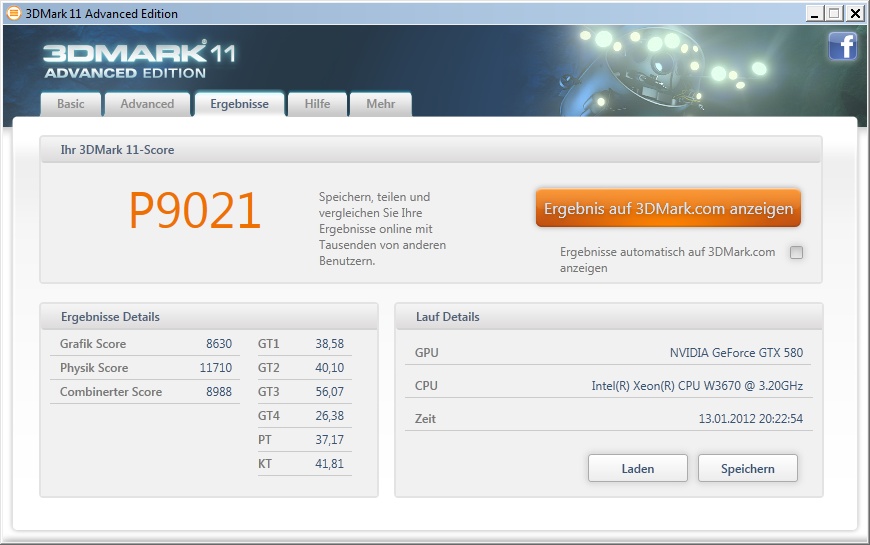

Update 19.01.2012

kleines Update mit 1095/2450MHz auf der GPU. Die Punkte sind jetzt nicht soo doll, aber mit der etwas betagten CPU und ohne besondere Kühlung ganz OK, denke ich.

Performance (P) Rangliste - Single GPU

OliverM84 - Microsoft Windows 7 x64 - Intel W3670 @ 4,6GHz - Asus Rampage III Extreme - 6x 2GiB DDR3-1600 - nVidia GTX 580 @ 1095/2450 - P9021

......

Soweit erst mal, ... kommen natürlich wie gesagt noch weitere Tests hinzu, das ist erst mal das was ich bis gestern Abend hin bekommen habe!

Bei Wünschen, Anregungen, Fehlern, usw. .. meldet euch!

Allgemeine Fragen zu der Karte, bitte im GTX 580 Sammthread stellen, danke

lg Olli

Wichtig! ... NEUSTE Benches/Tests/Ergebnisse am Ende des ersten Posts!!!!!

Ich hab mich mal wieder dazu entschlossen, ein kleines Review zu schreiben.

Grundsätzlich will ich die GTX580 so ausführlich wie möglich testen, sowie die Leistung mit und ohne OC darzulegen.

Später werde ich noch Einfluss des CPU Taktes, Treibervergleiche und Stromverbrauch in den Test einfließen lassen.

Unteranderem werde ich auch noch kurz Vergleiche zur GTX 560 bei gleichem Takt in das Review aufnehmen.

==================================================

Zum System:

- Asus Rampage II Extreme, Bios 1406

- Intel W3520 4,2GHz (200x21)

- 6x2GB Corsair Dominator (1600MHz 8-9-8-24)

- POV GTX 580 @ 772/1544/2004 (default)

- POV GTX 580 @ 875/1750/2100

- POV GTX 580 @ 950/1900/2200

- POV GTX 580 @ 1000/2000/2400

- POV GTX 580 @ 1050/2100/2475

- OCZ Vertex 2 (120GB)

- Seasonic X-850 Semi passiv 850W

- CPU und GTX580 unter Wakü

In den Tests kommt jeweils ein absolut identisches System zum Einsatz, so dass keine externen Parameter die Ergebnisse beeinflussen.

Ich will noch im Vorraus sagen, dass ich erst mal nur ein paar Dinge testen konnte, sobald ich Zeit finde, kommen neue Tests hinzu!

Würde ich auch über Anregungen und Wünsche freuen, auf die ich, wenn ich die Möglichkeit habe, eingehen will!

So dann erst mal zu Beginn ein paar Bilder der Komponenten:

(alle Bilder zu Vergrößern anklicken (1920x1080))

Point of View GTX 580, ... schöne Karte

==================================================

Erste Eindrücke

Erste Eindrücke der Karte, welche ich sammeln konnte, liste ich hier einfach mal stichpunktartig auf, um die Übersicht zu wahren:

- Die Karte ist sauber und ordentlich verarbeitet und macht einen soliden Eindruck.

- Idle ist die GTX580 sehr leise, fast nicht hörbar (Lüfter 40%, wer das anpasen will kann gern auf 30% gehen)

- Idle lässt sich die Lüfterdrehzahl problemlos auf 25% senken, dadurch wird die Karte unhörbar.

- Verbrauch Idle liegt bei Standardspannung bei ca. 30W (bei 0,962v).

- Bei 85% Lüfterdrehzahl ist die Karte schon recht laut, aber so hoch muss der Lüfter in der Regel nicht drehen.

- Umbau des Kühlers auf Wasserkühlung ist sehr einfach.

- Unter Last hängt sowohl Temperatur als auch Lautstärke stark von der verwendeten Spannung ab. Hier gibt es Unterschiede von Karte zu Karte, welche im folgenden Abschnitt dargelegt werden. Generell verbraucht die Karte recht viel unter 3D Last.

==================================================

Spannung 2D/3D / Lautstärke / Lüfterdrehzahl

Zur zeit lassen sich bereits die Spannungen der Karte per Software im laufenden Betrieb anpassen.

Nützliche Tools hierzu sind zur Zeit der "MSI Afterburner" oder der "Nvidia Inspector".

Mittels dieser Tools lassen sich zur Zeit Spannungen von 0,825v - 1,150v auf den Chip anlegen.

Liste der möglichen Spannungen:

Voltage level 0 : 825mv

Voltage level 1 : 838mv

Voltage level 2 : 850mv

Voltage level 3 : 863mv

Voltage level 4 : 875mv

Voltage level 5 : 888mv

Voltage level 6 : 900mv

Voltage level 7 : 913mv

Voltage level 8 : 925mv

Voltage level 9 : 938mv

Voltage level 10 : 950mv

Voltage level 11 : 963mv

Voltage level 12 : 975mv

Voltage level 13 : 988mv

Voltage level 14 : 1000mv

Voltage level 15 : 1013mv

Voltage level 16 : 1025mv

Voltage level 17 : 1038mv

Voltage level 18 : 1050mv

Voltage level 19 : 1063mv

Voltage level 20 : 1075mv

Voltage level 21 : 1088mv

Voltage level 22 : 1100mv

Voltage level 23 : 1113mv

Voltage level 24 : 1125mv

Voltage level 25 : 1138mv

Voltage level 26 : 1150mv

Bisher scheint es so zu sein, dass unter 2D alle 580er Karten mit 0,962v angesteuert werden.

3D hingegen gibt es da deutliche Unterschiede welche Standardspannung anliegt.

Hier wird wahrscheinlich nach Qualität der Chips unterschieden und entsprechende Spannung angelegt.

Die 3D Werte liegen bisher zw. 1,000v und 1,088v.

Per Biosflash und dem Anpassen der Spannungen lassen sich bis 1,213v "freigeben".

Daraus resultiet natürlich die Temperatur, der Verbrauch und somit auch die Lautstärke der Karte.

An dieser Stelle sei erwähnt, dass viele Karten mit einer deutlich verringerten, als die vorgegebene Spannung auskommen.

Hier ein kleines Beispiel:

772/1544/2004 (default) - 1,000v > 82°C > 56% Lüfter (Lautstärke: deutlich hörbar)

772/1544/2004 (default) - 0,900v > 78°C > 47% Lüfter (Lautstärke: recht angenehm)

Einstellungen sowie OC lassen sich einwandfrei mittels Nvidia Inspector vornehmen:

Genauere Tests dazu im Abschnitt "Leistungsaufnahme / vGPU"

==================================================

Umbau auf Wakü:

Da für mich klar war, dass die Karte zu etwas laut sein wird für einen Silent-PC, habe ich mich schon gleich dazu entschlossen auf Wakü um zurüsten.

Ich habe mich für den EK FC-580 entschieden.

Um die Karte optisch ist was schicker zu machen, habe ich der GTX 580 zusätzlich die EVGA Backplate spendiert.

Der Umbau ist sehr einfach und größtenteils problemlos.

Auf Wunsch kann ich den Vorgang aber gern genauer beschreiben.

Fürs ersten sollten hier einige Bilder genügen.

(alle Bilder zu Vergrößern anklicken (1920x1080))

Update 17.01.2012

So, ich hab mal die Wasserkühler gereinigt und neu zusammen gebaut. Sieht jetzt wie folgt aus.

Ist noch nicht ganz fertig, der PowerAmp für die 9 Lüfter fehlt z.B. noch, der sollte aber jeden Moment per DHL hier ankommen.

==================================================

Leistungsaufnahme / vGPU

Zum messen der Leistungsaufnahme dient mir ein Energy Check 3000,

Den direkten Verbrauch an der Karte kann ich leider nicht messen, somit sind alle angegebenen Werte jeweils die Verbrauchswerte des gesamten Systems.

Idle:

Idle verbrauche ich zur Zeit 193W, welche aber nicht optimiert sind, da die CPU z.B. immer mit voller Spannung läuft. Mit Optimierten Werten braucht obiges System ca. 180W wobei ca. 30W auf die Rechnung der GTX 580 gehen.

Unter Last:

Unter Last ist die GTX 580 recht stromhungrig. Aber auch hier ist wieder zu sagen, dass die sehr stark von der anliegenden GPU Spannung im 3D Modul anhängt, welche ja, wie bereits erwählt von Karte zu Karte unterschiedlich ist. Daher rühren auch die unterschiedlichen Ergebnissen in den Reviews.

Damit ihr euch ein Bild machen könnt, anbei drei Beispiele mit unterschiedlichen Konfigurationen bzgl. Takt und 3D Spannung.

Bei den folgenden Tests lief jeweils Furmark, CPU lag bei 4200MHz bei 1,28v, was ja sicherlich auch nicht unbedeutend ist.

Tests jeweils mit Furmark und CPU bei 4200MHz bei 1,28v.

Gleicher Takt bei unterschiedlicher Spannung:

GTX 580 @ 772/1544/2004 @ x,xxv

GTX 580 default @ 0,900v - 328W

GTX 580 default @ 0,950v - 336W

GTX 580 default @ 1,000v - 348W

GTX 580 default @ 0,050v - 357W

GTX 580 default @ 1,100v - 367W

GTX 580 default @ 1,150v - 384W

GTX 580 default @ 1,200v - 401W

Gleiches hier grafisch dargestellt.

Gleiche Spannung bei unterschiedlichem Takt:

GTX 580 @ xxx/xxxx/2004 @ 1,150v

GTX 580 @ 1,150v - 650/1300/2004MHz - 370W

GTX 580 @ 1,150v - 700/1400/2004MHz - 376W

GTX 580 @ 1,150v - 750/1500/2004MHz - 381W

GTX 580 @ 1,150v - 800/1600/2004MHz - 388W

GTX 580 @ 1,150v - 850/1700/2004MHz - 394W

GTX 580 @ 1,150v - 900/1800/2004MHz - 401W

GTX 580 @ 1,150v - 950/1900/2004MHz - 409W

GTX 580 @ 1,150v - 1000/2000/2004MHz - 415W

==================================================

Overclocking

Overclocking

Zum übertakten der GTX 580 eigenen sich zur Zeit zwei Tools ganz gut.

Zum einen der Nvidia Inspector (z.Z. in der Version 1.9.5)

Und zum zweiten das von MSI bereitgestellte Tool "MSI Afterburner"

Beide sind denke ich inhaltlich selbsterklärend, wodurch ich nicht näher auf die Funktion der beiden Tools eingehen werde.

Beim MSI Afterburner ist vlt. zu sagen, dass das Verändern der Spannung (vGPU) erst in den Einstellungen aktiviert werden muss.

Taktraten:

Die GTX 580 benutzt standardmäßig drei Taktstufen, jeweils Core/Shader/Mem:

P12: 51/101/135

P8: 405/810/324

P0: 772/1544/2004

Core und Shader sind bisher fest im Verhältnis 1:2 verbunden.

Spannungen

Wie bereits erwähnt, lassen sich Spannungen zw. 0,825 und 1,150v (default Bios) wählen.

Das ist die Spannung, mit der die GPU versorgt wird.

Wie schon bei der GTX 480 ist aber auch die Spannung für den VRam unmittelbar an diese Einstellung gekoppelt. Mit höher eingestellter vGPU lässt sich also auch der Speicher höher übertakten.

Dieser wird offensichtlich von Nvidia aber mit deutlich weniger als der für den Speicher vorgesehenen Spannung versorgt. Somit sind Taktraten von 1250MHz und mehr, die der 0.4er Speicher erreichen sollte, kaum zu erreichen.

Stabilität testen

Furmark heizt nach wie vor die Karten richtig ein was Verbrauch und Temperatur angeht, ist allerdings für Stabilität nicht die beste Wahl.

Um sicher zustellen dass die Karte stabil arbeitet sollte man einige Heaven und Vantage oder 3DMark11 Runs laufen lassen, wobei 3D Mark Vantage oftmals noch etwas sensibler reagiert. Auch Crysis und Crysis Warhead sind zum testen eine gute Wahl.

2D Modus untervolten

Im 2D Modus taktet die Karte mit 51/100/135MHz und wird bei bisher allen Karten mit 0,962v befeuert.

Hier haben schon viele User die Erfahrung gemacht, dass auch die minimal einzustellenden 0,825v vollkommen ausreichend sind.

Hier muss aber jeder für sich mal testen, welche Spannungen für die eigene Karte ausreichend sind.

==================================================

Bios anpassen (2D/3D Taktraten, vGPU 2D/3D)

Nachdem man ausführlich getestet hat, welche OC Einstellungen auf die Karte passen, ist es durchaus sinnvoll, diese auch im Bios speichern zu können.

Hier erst mal ein großes Lob an den User Orbmu2k_, ohne ihn wäre es nicht so leicht die entsprechenden Änderungen vorzunehmen.

Mit dem Tool 'Fermi Bios Editor' ist es möglich, wie auf den beiden folgenden Bildern zu sehen, sämtliche Taktdomains und Spannungseinstellungen zu ändern. Zudem ist es möglich, die maximal einzustellende vGPU zu definieren.

Noch mals sei erwählt, dass es sehr wichtig ist, die drei Taktdomains vorher mit den gewünschten Spannungen durchzutesten und erst dann die Einstellungen im Bios anzupassen.

In meinem Beispiel habe ich dem entsprechend die Werte wie folgt geändert.

P12 - 51/101/135MHz bei 0.825v

P00 - 950/1900/2205 bei 1.075v

Max. vGPU auf 1.213v erhöht

Lüfterdrehzahl auf 30 - 100% abgeändert.

Nach dem Speichern und anschließendem Flashen (nächster Abschnitt) des Bios, spiegeln sich die geflashten Werte natürlich als Defaultwerte wieder.

==================================================

Bios flashen

Das Flashen des Bios ist eigentlich bei der GTX 580 nichts neues gegenüber den vorherigen Karten.

Zum Flashen nutzt mal z.B. das Tool "nvFlash" in der aktuellen Version.

Der Vorgang selbst ist sehr simpel:

- Bootfähige CD oder USB Stick erstellen

- NVFlash und das zu flashende Bios in der Form "Biosname.rom" auf die CD kopieren

- PC neustarten

- Von CD/USB booten

- Den Befehl 'NVFLASH -5 -6 Biosname.rom' ausführen

- Mit 'y' bestätigen

- FERTIG! PC neustarten.

Das ganze noch ein mal bebildert um es etwas anschaulicher zu machen.

==================================================

Video- /BluRaywiedergabe - Verbrauch

Hier kann ich erfreuliches berichten. Die Karte taktet zum wiedergeben von Blu-Rays / *.mkv Files auf 405/810/324MHz und nutzt die 2D Spannung und verbraucht so nur ca. 10W mehr als idle.

==================================================

Einfluss PCIe Takt

... Tests folgen ...

==================================================

VRam Auslastung

Die GTX 580 hat ja 1,5GB VRam, hier mal einige Beispiele wie stark der Speicher von verschiedenen Anwendungen ausgelastet wird.

Crysis Warhead

1920x1080, Enthusiast, 16xQ AA - 1215MB

F1 2010

1920x1080, 16xQ 16xAF 8xSS im Treiber - 1071MB

3D Mark 11

Performance Preset - 354MB

... auch hier folgen natürlich weitere Tests

==================================================

Vergleich GTX 560 / GTX 580 bei gleichem Takt

Hier ein kleiner Vergleich des kleineren Ablegers GTX 560.

Getestet wurde im gleichen System und bei gleichem Takt der Karten.

Jeweils bei 1000/2000/2400MHz

3DMark 11

Entry:

GTX 560 (E8088) - 100% / GTX 580 (E11251) - 139,1%

Performance:

GTX 560 (P5094) - 100% / GTX 580 (P7581) - 148,8%

Extreme:

GTX 560 (X1682) - 100% / GTX 580 (X2506) - 148,9%

Crysis Warhead

1920x1080, Ent. 16xQ GTX 560 (33,29FPS) - 100% / GTX 580 (49,33FPS) - 148,2%

Hier anbei noch ein paar Bilder einer EVGA GTX 560, auch recht schick wie ich finde:

==================================================

Frametimes

Da die Thematik der Mircoruckler immer noch ein leidiges Thema ist, werde ich auch hier kurz darauf eingehen.

Für die User, denen das kein Begriff ist, vielleicht eine kurze Erklärung.

Frametimes sind die Zeitabstände zwischen zweier Frames, sprich der Abstand zwischen Frame 1 und 2, ... und 2 und 3 ... usw.

Optimalerweise sollten diese natürlich immer möglichst gleich groß sein. Mit Single Karten ist das auch in der Regel so.

Sobald aber mehr als eine Karte zum Einsatz kommt, ist es offenbar seitens der Hersteller nicht einfach, diese Zeitabstände gleich zu halten.

Merklich störend wirken diese sog. Mircoruckler eigentlich nur ein Framebereichen von 0 bis ca. 40FPS.

Wenn ein Spiel mit mehr FPS läuft, sind diese nur schwer bis gar nicht wahrnehmbar.

Hier einige Test dazu:

Frametimes mit aktivem SLI:

3DMark11

Im Spoiler die restlichen Tests:

Edit:

Hier noch die entsprechenden Tests ohne SLI

3DMark11

Im Spoiler die restlichen Tests:

Was festzustellen ist, ist dass die MRs nach wie vor bestehen. Allerdings muss ich dazu sagen, dass diese kaum mehr wahrnehmbar sind.

Früher waren die schon deutlich störend, was nun nicht mehr der Fall ist.

Hinzuzufügen ist, dass in Games wie Crysis, bei denen man überhaupt mal in FPS Bereiche unter 40 kommen kann, die Microruckler deutlich vermindert wurden.

Da hat nVidia offenbar gute Arbeit geleistet.

==================================================

Treibervergleiche

... Tests folgen ...

==================================================

SLI Skalierung

Auch das Thema wollte ich etwas anreißen.

Früher war es leider oft so, dass es noch viele Anwendungen und Spiele gab, die SLI nicht ordentlich nutzen konnten. Mittlerweile sieht das schon ganz anders aus.

Zwar werden nicht in allen Games die unten zu sehenden Werte erreicht, aber dennoch sieht die Unterstützung der Spiele bzw. die Weiterentwicklung der Treiber sehr gut aus.

Hier drei Beispiele:

GTX580 einmal als Single Karte und einmal im SLI Verbund.

3DMark11 GPU Score: 6446 vs. 12742 >> + 97,7%

Crysis Warhead DX10, 16xQ: 43,40 FPS vs. 80,92 FPS >> + 86,5%

Unigine Heaven 2.1: 52,4 FPS vs. 97,7 FPS >> + 86,5%

==================================================

Gamebenchmarks und Leistungszuwachs bei OC

In deisem Test will ich testen die gut die GF110 Architektur mit dem Takt skaliert.

Crysis Warhead

Settings:

1920x1080, 16QxAA, Alles auf Enthusiast, DX10

GTX 580 @ 772/1544/2004 > 00,0% OC > 100,0% Leistung

GTX 580 @ 875/1750/2105 > 10,5% OC > 109,9% Leistung

GTX 580 @ 950/1900/2205 > 18,7% OC > 117,6% Leistung

GTX 580 @ 1000/2000/2410 > 26,4% OC > 124,9% Leistung

Unigine Heaven 2.1

Settings:

1920x1080, Exteme Tesslation, DX 11, Shaders high, 4xAF

GTX 580 @ 772/1544/2004 > 00,0% OC > 100,0% Leistung

GTX 580 @ 875/1750/2105 > 10,5% OC > 111,2% Leistung

GTX 580 @ 950/1900/2205 > 18,7% OC > 119,5% Leistung

GTX 580 @ 1000/2000/2410 > 26,4% OC > 125,7% Leistung

Just Cause 2

GTX 580 @ 772/1544/2004 > 00,0% OC > 100,0% Leistung

GTX 580 @ 875/1750/2105 > 10,5% OC > 110,5% Leistung

GTX 580 @ 950/1900/2205 > 18,7% OC > 118,6% Leistung

GTX 580 @ 1000/2000/2410 > 26,4% OC > 124,4% Leistung

F1 2010 Min. FPS

GTX 580 @ 772/1544/2004 > 00,0% OC > 100,0% Leistung

GTX 580 @ 875/1750/2105 > 10,5% OC > 107,8% Leistung

GTX 580 @ 950/1900/2205 > 18,7% OC > 115,6% Leistung

GTX 580 @ 1000/2000/2410 > 26,4% OC > 120,3% Leistung

==================================================

3D Marks

3D Mark Vantage Performance

GTX 580 @ 772/1544/2004 > 00,0% OC > 100,0% Leistung

GTX 580 @ 875/1750/2105 > 10,5% OC > 109,9% Leistung

GTX 580 @ 950/1900/2205 > 18,7% OC > 116,9% Leistung

GTX 580 @ 1000/2000/2410 > 26,4% OC > 121,8% Leistung

3D Mark 11 Performance

GTX 580 @ 772/1544/2004 > 00,0% OC > 100,0% Leistung

GTX 580 @ 875/1750/2105 > 10,5% OC > 110,3% Leistung

GTX 580 @ 950/1900/2205 > 18,7% OC > 117,7% Leistung

GTX 580 @ 1000/2000/2410 > 26,4% OC > 123,5% Leistung

==================================================

Verschiedenes und max. OC Ergebnisse

Update 28.02.2011

So Leute, hier mal ein paar OC Tests unter Wasser:

3DMark 11 @ 1060/2120/2475 .... leider ist die CPU nicht mehr die schnellste ...

Entry (E) Rangliste - Single GPU

OliverM84 - Microsoft Windows 7 x64 - Intel W3520 @ 4200Mhz - X58 - 6x 2GB DDR3-1600Mhz - GTX 580 @ 1055/2110/2450 - E11808

Performance (P) Rangliste - Single GPU

OliverM84 - Microsoft Windows 7 x64 - Intel W3520 @ 4200Mhz - X58 - 6x 2GB DDR3-1600Mhz - GTX 580 @ 1060/2120/2475 - P7961

Extreme(X) Rangliste - Single GPU

OliverM84 - Microsoft Windows 7 x64 - Intel W3520 @ 4200Mhz - X58 - 6x 2GB DDR3-1600Mhz - GTX 580 @ 1050/2100/2450 - X2634

Update 07.01.2012

kleines Update von mir mit aktuellen Treibern und etwas mehr CPU Takt..

Entry (E) Rangliste - Single GPU

OliverM84 - Microsoft Windows 7 x64 - Intel W3670 @ 4,6GHz - Asus Rampage III Extreme - 6x 2GiB DDR3-1600 - nVidia GTX 580 @ 1065/2450 - E13213

Performance (P) Rangliste - Single GPU

OliverM84 - Microsoft Windows 7 x64 - Intel W3670 @ 4,6GHz - Asus Rampage III Extreme - 6x 2GiB DDR3-1600 - nVidia GTX 580 @ 1070/2450 - P8876

Extreme(X) Rangliste - Single GPU

OliverM84 - Microsoft Windows 7 x64 - Intel W3670 @ 4,6GHz - Asus Rampage III Extreme - 6x 2GiB DDR3-1600 - nVidia GTX 580 @ 1065/2475 - X2884

Update 19.01.2012

kleines Update mit 1095/2450MHz auf der GPU. Die Punkte sind jetzt nicht soo doll, aber mit der etwas betagten CPU und ohne besondere Kühlung ganz OK, denke ich.

Performance (P) Rangliste - Single GPU

OliverM84 - Microsoft Windows 7 x64 - Intel W3670 @ 4,6GHz - Asus Rampage III Extreme - 6x 2GiB DDR3-1600 - nVidia GTX 580 @ 1095/2450 - P9021

......

Soweit erst mal, ... kommen natürlich wie gesagt noch weitere Tests hinzu, das ist erst mal das was ich bis gestern Abend hin bekommen habe!

Bei Wünschen, Anregungen, Fehlern, usw. .. meldet euch!

Allgemeine Fragen zu der Karte, bitte im GTX 580 Sammthread stellen, danke

lg Olli

Zuletzt bearbeitet: