Gohst_oc

Enthusiast

Thread Starter

- Mitglied seit

- 25.05.2007

- Beiträge

- 2.179

Hallo zusammen

Ich möchte gerne ein neues Projekt starten, und mein mittlerweile viel zu grosses Home Lab umstellen.

Da ich einfach zu wenig Platz im Büro hatte, musste mein bisheriges Home Lab welches aus 3 19" Rack-Server bestand abgelöst werden....

Neu soll ein Server in einem kompakten Gehäuse entstehen. Das Ziel ist es, unter 20L Volumen zu kommen.

Folgende Komponenten sind vorgesehen (oder schon gekauft).

Ich bin froh um ein paar Inputs bezüglich CPU Kühler (keine Ahnung wie viel die Xeon CPU tatsächlich "heizt") und eventuell ein anderes Gehäuse, sofern es Platzprobleme beim Kühler gibt.

Folgende CPU Kühler habe ich in der engeren Auswahl (wobei keiner für den 2011 Narrow ILM Socke passt - hier hilft nur Basteln):

Leider ist das Motherboard eine echte Herausforderung, denn die RAM Slots sind sehr nahe bei der CPU:

Es gäbe von Nocuta zwei Kühler die explizit auf das Motherboard passen sollten:

https://noctua.at/de/nh-u12dx-i4/specification und https://noctua.at/de/nh-u9dx-i4

Leider sind sie etwas schwach bei der Kühlleistung oder blockieren die RAM Slots....

Ich möchte gerne ein neues Projekt starten, und mein mittlerweile viel zu grosses Home Lab umstellen.

Da ich einfach zu wenig Platz im Büro hatte, musste mein bisheriges Home Lab welches aus 3 19" Rack-Server bestand abgelöst werden....

Neu soll ein Server in einem kompakten Gehäuse entstehen. Das Ziel ist es, unter 20L Volumen zu kommen.

Folgende Komponenten sind vorgesehen (oder schon gekauft).

- Xeon E5 2698 V4 (20 Core Broadwell EP) - vorhanden

- Asrock EPC612D4I (C612 mITX Mainboard) - vorhanden

- 2* 16 GB DDR4 ECC (So-DIMM Module...) - vorhanden

- Kolink Sattelite Mini-ITX - vorhanden (lag halt so rum...)

- CPU Kühler ???

- Netzteil: Corsair AX760 - vorhanden

- SSD: 2* Samsung PM1725 3.2TB - vorhanden (aus alten Server)

- Netzwerk: Aquantia ACQ107 10Gbit RJ45 - vorhanden (für ein NAS Projket gekauft)

- PCIe Riser/Bi-Furcation Splitter PCIe 16x -> 8x/m.2/m.2 von C-Payne

Ich bin froh um ein paar Inputs bezüglich CPU Kühler (keine Ahnung wie viel die Xeon CPU tatsächlich "heizt") und eventuell ein anderes Gehäuse, sofern es Platzprobleme beim Kühler gibt.

Folgende CPU Kühler habe ich in der engeren Auswahl (wobei keiner für den 2011 Narrow ILM Socke passt - hier hilft nur Basteln):

- Cryorig H7 (habe ich rumliegen)

- Noctua NH-C14S

- Corsair H80i v2 (habe ich auch rumliegen)

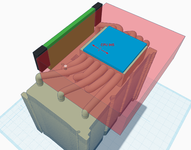

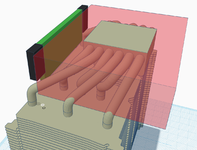

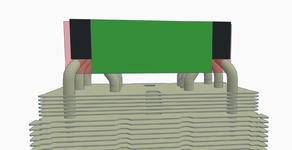

Leider ist das Motherboard eine echte Herausforderung, denn die RAM Slots sind sehr nahe bei der CPU:

Es gäbe von Nocuta zwei Kühler die explizit auf das Motherboard passen sollten:

https://noctua.at/de/nh-u12dx-i4/specification und https://noctua.at/de/nh-u9dx-i4

Leider sind sie etwas schwach bei der Kühlleistung oder blockieren die RAM Slots....

Zuletzt bearbeitet: