Guten Tag,

wie bereits in diversen Threads habe ich verschiedene Fragen zu Teilkomponenten gestellt gehabt und super Feedback und Tipps von euch erhalten, danke schonmal dafür

Das System soll 24/7 laufen, VMs die nicht gebraucht werden, werden dann heruntergefahren, auch um Stromsparen zu können, das ist auch eine wichtige Anforderung.

Kurz zu Proxmox, was soll darauf alles laufen?

Potentielle Hardware Komponenten:

CPU: ~260€

geizhals.de

geizhals.de

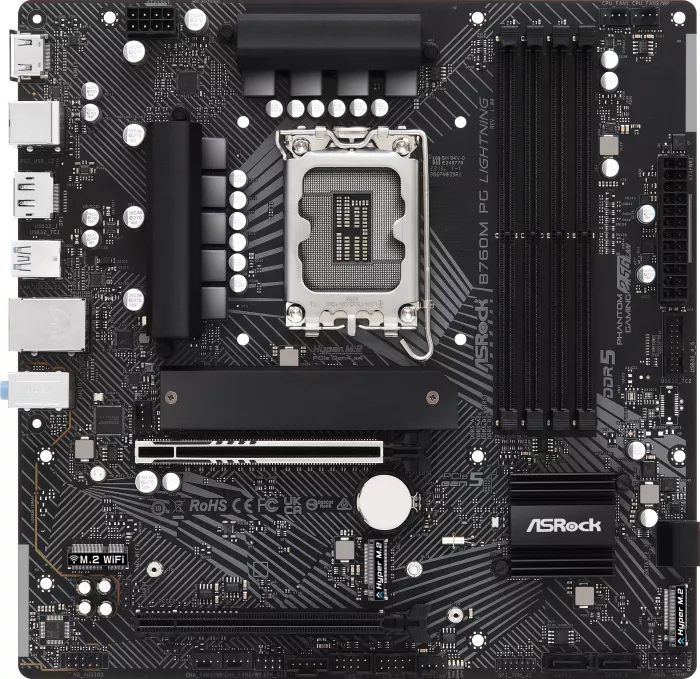

Mainboard: ~120€

geizhals.de

geizhals.de

RAM (Zertifiziert laut Mainboard Hersteller) ~370€

4x 32GB: https://geizhals.de/kingston-valueram-dimm-32gb-kvr48u40bd8-32-a2686427.html

Boot Drive (Redundant als RaidZ-Mirror) ~124€

2x1TB https://geizhals.de/samsung-ssd-870-evo-1tb-mz-77e1t0b-a2458826.html

NVMe VM Drives: (Redundant als RaidZ-Mirror) ~200€

2x2TB: https://geizhals.de/kingston-kc3000-pcie-4-0-nvme-ssd-2tb-skc3000s-2048g-a2621457.html

Netzteil: (80 Plus GOLD) ~55€

geizhals.de

geizhals.de

Das Mainboard hat ein B-Chipsatz somit auch eine geringeren Stromverbrauch, RAM will ich mit 128GB ausstatten, leider kein ECC, da ich sonst auf die teuren Boards mit W680 Chipsätze nehmen müsste.

Eigentlich wollte ich 3 der NVMes als RAID-Z1 Pool aufsetzen, aber preislich komme ich da an meine Grenzen, nehme erstmal 2 davon und spiegel diese, evtl. kann ich ein dritten nachkaufen.

-Eine Frage an euch, kann ich eine weitere Netzwerkkarte mit erstmal 2x 1GB einbauen, das Board hat eine limitierte Anzahl an PCI Slots, wäre so eine Intel Karte einbaufähig?

geizhals.de

geizhals.de

- Wäre ein Einbau mit maximaler Austattung der Netzwerkkarte und einer dedizierte Midsize Grafikkarte möglich?

- Das Netzteil, reicht es aus, oder würdet ihr was anderes raten?

wie bereits in diversen Threads habe ich verschiedene Fragen zu Teilkomponenten gestellt gehabt und super Feedback und Tipps von euch erhalten, danke schonmal dafür

Das System soll 24/7 laufen, VMs die nicht gebraucht werden, werden dann heruntergefahren, auch um Stromsparen zu können, das ist auch eine wichtige Anforderung.

Kurz zu Proxmox, was soll darauf alles laufen?

Es sind hauptsächlich Linux Systeme für Sowareentwicklung, Datenbanken auch könnte ich mir gerne self-hosted KI Modelle auf einer VM ausprobieren.Ich als Entwickler habe grob paar Ideen, einmal bestimmte Workloads lokal laufen zu lassen wie GitLab für Source Code Management mit CI/CD Pipelines (Docker Images bauen, deployen), passend dazu lokales Hosting der Dienste (Apache, Nginx). Entsprechend würden auch dann Datenbanken je nach Zweck/Situation laufen.

Im Themenbereich Reporting/Monitoring würden dann noch paar Dienste laufen wie Grafana, Prometheus, etc. Im Bereich Security könnte ich mir auch mal ein zentrale Userverwaltung/LDAP vorstellen, so dass die selbst gehosteten Services im Homelab per SSO sich einmalig authentifizieren, dass ist aber Zukunftsmusik. Im Bereich Infrastruktur nutze ich auf meinem RaspberryPi bereits den DNS/Werbeblocker PiHole, diesen würde ich erstmal dort weiterlaufen lassen, nur sollte dieser Ausfallen weil die SD-Karte schrott ist, müsste schnell Ersatz her.

Streaming würde entfallen, da ich im bestehenden TrueNAS Server näher an den Mediadaten Jellyfin bereits nutze.

Evtl. würde ich eine Windows VM für spezifische Software aufsetzen evtl. auch Videoschnitt (Da Vinci Resolve) und die bei Bedarf hochfahren und per RDP draufschalten.

Potentielle Hardware Komponenten:

CPU: ~260€

Intel Core i5-13500, 6C+8c/20T, 2.50-4.80GHz, boxed ab € 207,43 (2025) | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für Intel Core i5-13500, 6C+8c/20T, 2.50-4.80GHz, boxed ✔ Bewertungen ✔ Produktinfo ⇒ Kerne: 14 (6C+8c) • Threads: 20 (12+8) • Turbotakt: 4.80GHz (Turbo Boost 2.0), 4.80GHz (P-Core), 3.50GHz … ✔ Intel ✔ Testberichte ✔ Günstig kaufen

Mainboard: ~120€

ASRock B760M PG Lightning ab € 114,67 (2025) | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für ASRock B760M PG Lightning ✔ Bewertungen ✔ Produktinfo ⇒ Formfaktor: µATX • Sockel: Intel 1700 (LGA1700) • Chipsatz: Intel B760 • CPU-Kompatibilität: Celeron G600… ✔ Intel Sockel 1700 ✔ Testberichte ✔ Günstig kaufen

RAM (Zertifiziert laut Mainboard Hersteller) ~370€

4x 32GB: https://geizhals.de/kingston-valueram-dimm-32gb-kvr48u40bd8-32-a2686427.html

Boot Drive (Redundant als RaidZ-Mirror) ~124€

2x1TB https://geizhals.de/samsung-ssd-870-evo-1tb-mz-77e1t0b-a2458826.html

NVMe VM Drives: (Redundant als RaidZ-Mirror) ~200€

2x2TB: https://geizhals.de/kingston-kc3000-pcie-4-0-nvme-ssd-2tb-skc3000s-2048g-a2621457.html

Netzteil: (80 Plus GOLD) ~55€

be quiet! Pure Power 11 400W ATX 2.4 ab € 56,83 (2025) | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für be quiet! Pure Power 11 400W ATX 2.4 ✔ Bewertungen ✔ Produktinfo ⇒ Lüfter: 120mm, 1000rpm • Lautstärke: 10.50-14.90dB(A) (laut Hersteller) • Kabelmanagement: fest • Anschlü… ✔ Netzteile ✔ Testberichte ✔ Günstig kaufen

Das Mainboard hat ein B-Chipsatz somit auch eine geringeren Stromverbrauch, RAM will ich mit 128GB ausstatten, leider kein ECC, da ich sonst auf die teuren Boards mit W680 Chipsätze nehmen müsste.

Eigentlich wollte ich 3 der NVMes als RAID-Z1 Pool aufsetzen, aber preislich komme ich da an meine Grenzen, nehme erstmal 2 davon und spiegel diese, evtl. kann ich ein dritten nachkaufen.

-Eine Frage an euch, kann ich eine weitere Netzwerkkarte mit erstmal 2x 1GB einbauen, das Board hat eine limitierte Anzahl an PCI Slots, wäre so eine Intel Karte einbaufähig?

Intel I350-T2 V2 LAN-Adapter, 2x RJ-45, PCIe 2.1 x4, bulk ab € 84,90 (2023) | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für Intel I350-T2 V2 LAN-Adapter, 2x RJ-45, PCIe 2.1 x4, bulk ✔ Produktinfo ⇒ Typ: LAN-Adapter • Bauform: 1x PCIe-Karte (wechselbare Blende: full height und low profile Blende im Lief… ✔ Adapter & Hubs ✔ Testberichte ✔ Günstig kaufen

- Wäre ein Einbau mit maximaler Austattung der Netzwerkkarte und einer dedizierte Midsize Grafikkarte möglich?

- Das Netzteil, reicht es aus, oder würdet ihr was anderes raten?

Jetzt hab ich sie schon also... ja.

Jetzt hab ich sie schon also... ja.