Gurkengraeber

Legende

Thread Starter

- Mitglied seit

- 10.03.2005

- Beiträge

- 11.456

- Ort

- Düsseldorf

- Details zu meinem Desktop

- Prozessor

- Intel Core i7-12700K

- Mainboard

- Asus Prime Z690-A

- Kühler

- Alpenföhn Gletscherwasser White 280

- Speicher

- 48GB G.Skill Trident Z5 RGB white DDR5-7600 CL38 @ 6800MT/s

- Grafikprozessor

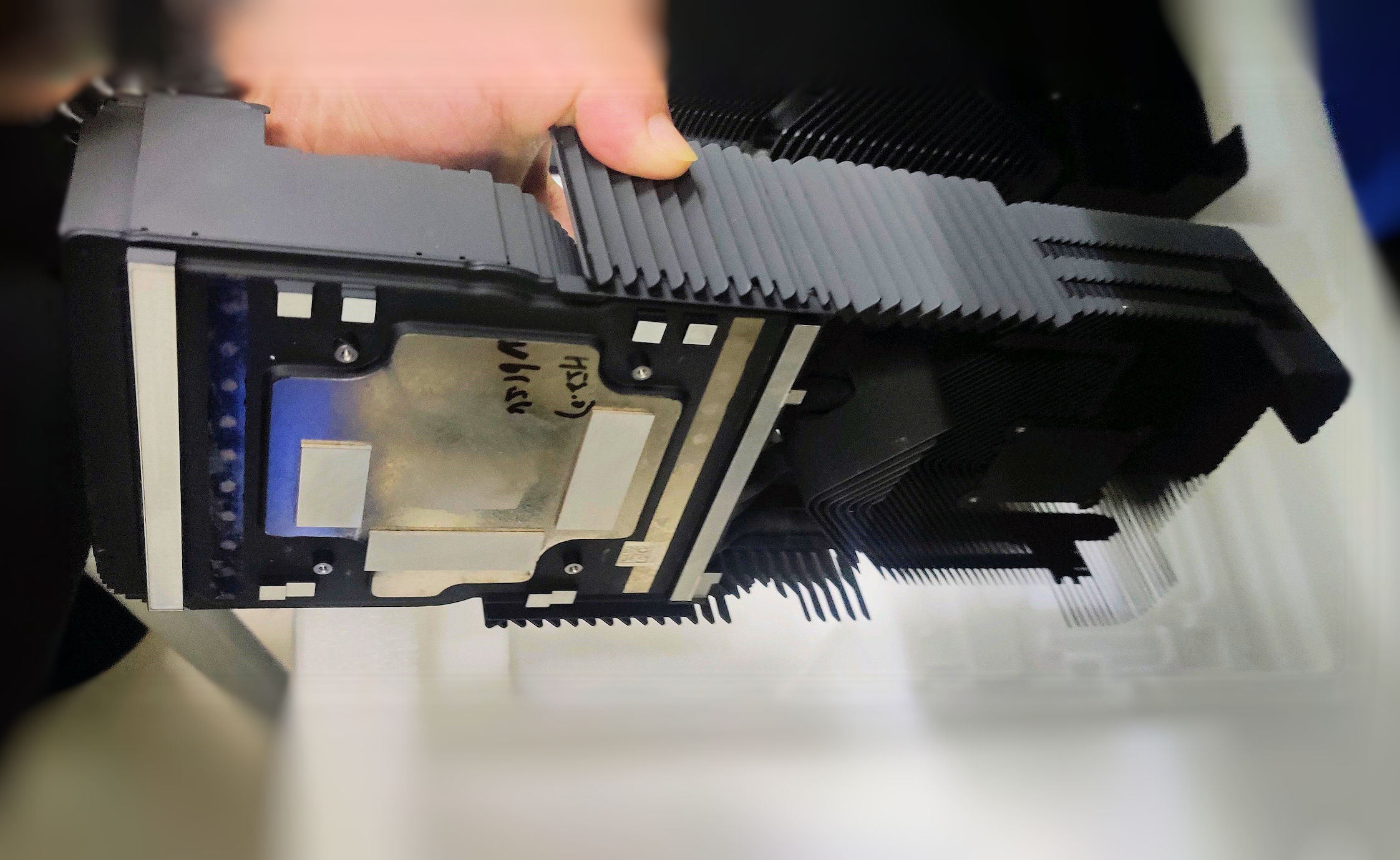

- Gigabyte GeForce RTX 4090 Aero OC

- Display

- Samsung Odyssey G7A LS28AG700NUXEN

- SSD

- M.2 1TB Crucial P5 & M.2 2TB Samsung Evo 970 Plus

- Gehäuse

- NZXT H7 Flow White

- Netzteil

- Seasonic Prime PX-850

- Betriebssystem

- Windows 11 Pro

Im Grunde stimme ich Dir zu. Dies gilt aber nur bei einer breiten Verfügbarkeit. Wenn uns die letzten zwei Jahre eines gelehrt haben, dann dass praktisch jede Karte an den Mann gebracht werden kann. Am Ende interessiert (im mittleren Bereich) nur die Leistung. Die 3070Ti mögen bei den Drops immer länger verfügbar gewesen sein als die anderen, aber am Ende waren sie alle weg.Der Effizienzgewinn durch den nodeshrink soll bei Team grün etwa 30-40% sein.

Aber:

Wenn die Chips geprügelt werden, also mehr Strom rein für mehr FPS, dann sinkt die Effizienz.

Stichwort untervolting. Stichwort OC.

Die Hersteller, grün wie rot, haben also Stellschrauben ihre Karten zu positionieren.

IMHO hast du in deinem Dreieck die Effizienz vergessen. Die 3070ti ist einfach schlechte Hardware. Zu wenig Leistung für zu viel Verbrauch, im direkten Vergleich in der gleichen Generation je ein Modell hoch und runter (3070, 3070ti, 3080).

Sollte sich das also geben, mache ich aus meinem Dreieck gerne ein Quadrat.

Jedenfalls würde ich mich für den Wohnzimmer PC über ne 2 Slotkarte mit der Leistung einer 3080Ti freuen, die dabei maximal 250W schluckt und deren zwei 90mm Lüfter auch unter Volllast nicht mehr als 1500RPM drehen müssen. Das wäre mal wieder was.

Zuletzt bearbeitet: