HWL News Bot

News

Thread Starter

- Mitglied seit

- 06.03.2017

- Beiträge

- 113.971

... weiterlesen

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Haha 4Ghz...das ist nur leeres Geschwatze eines AMD Fanboy "Leakers"...RDNA3 soll wohl Nahe 4 Ghz takten, was brachial wäre. RDNA2 ist dazu noch deutlich effizienter, wenn man ein FPS Limit stellt.

NiemalsRDNA3 soll wohl Nahe 4 Ghz takten

Absolute Zustimmung. Mehr gibts dazu auch eigentlich nicht zu sagen. Dieses ganze Vorgeplänkel geht mir mittlerweile nur noch auf den Zeiger. Alle 5 Tage irgendwelche Leaks. Lieber einmal richtig reinhaun anstatt 10 mal Appetithäppchen.Die können mir noch so viele Folien um die Ohren hauen. Wenn ich Tests auf HW oder CB sehe, wird entschieden.

Freue mich aber auf die neue Generation.

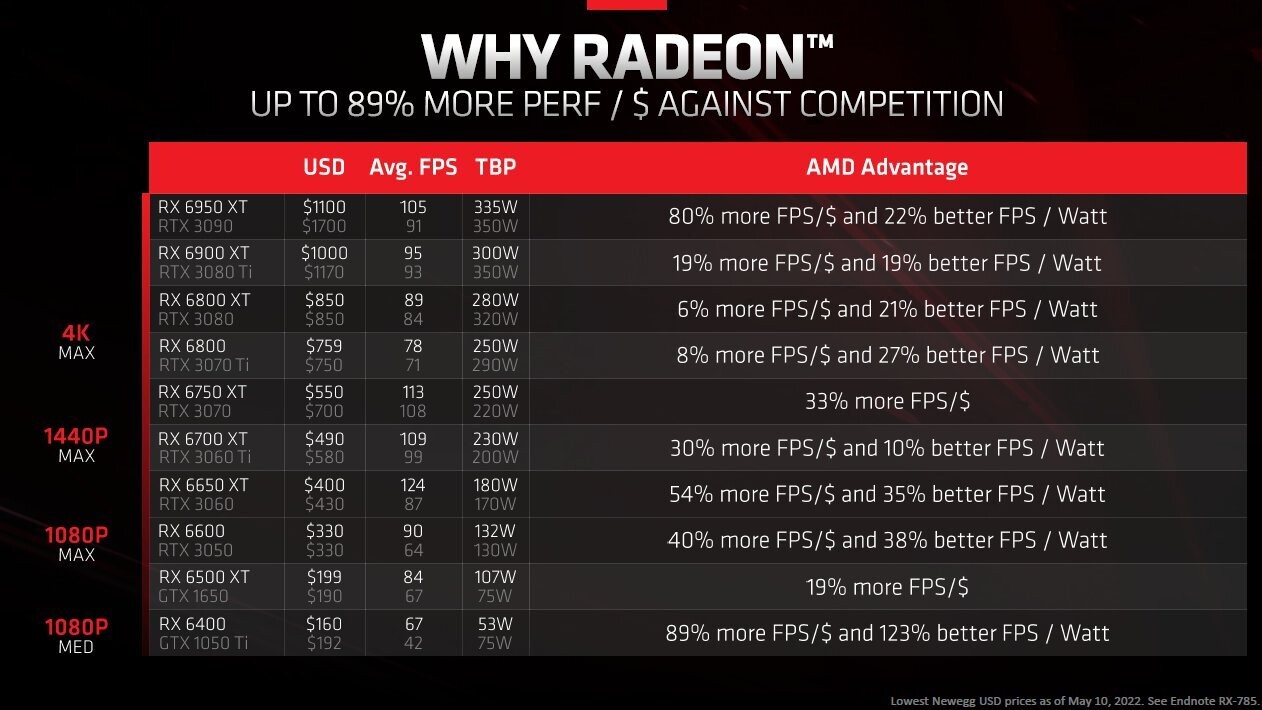

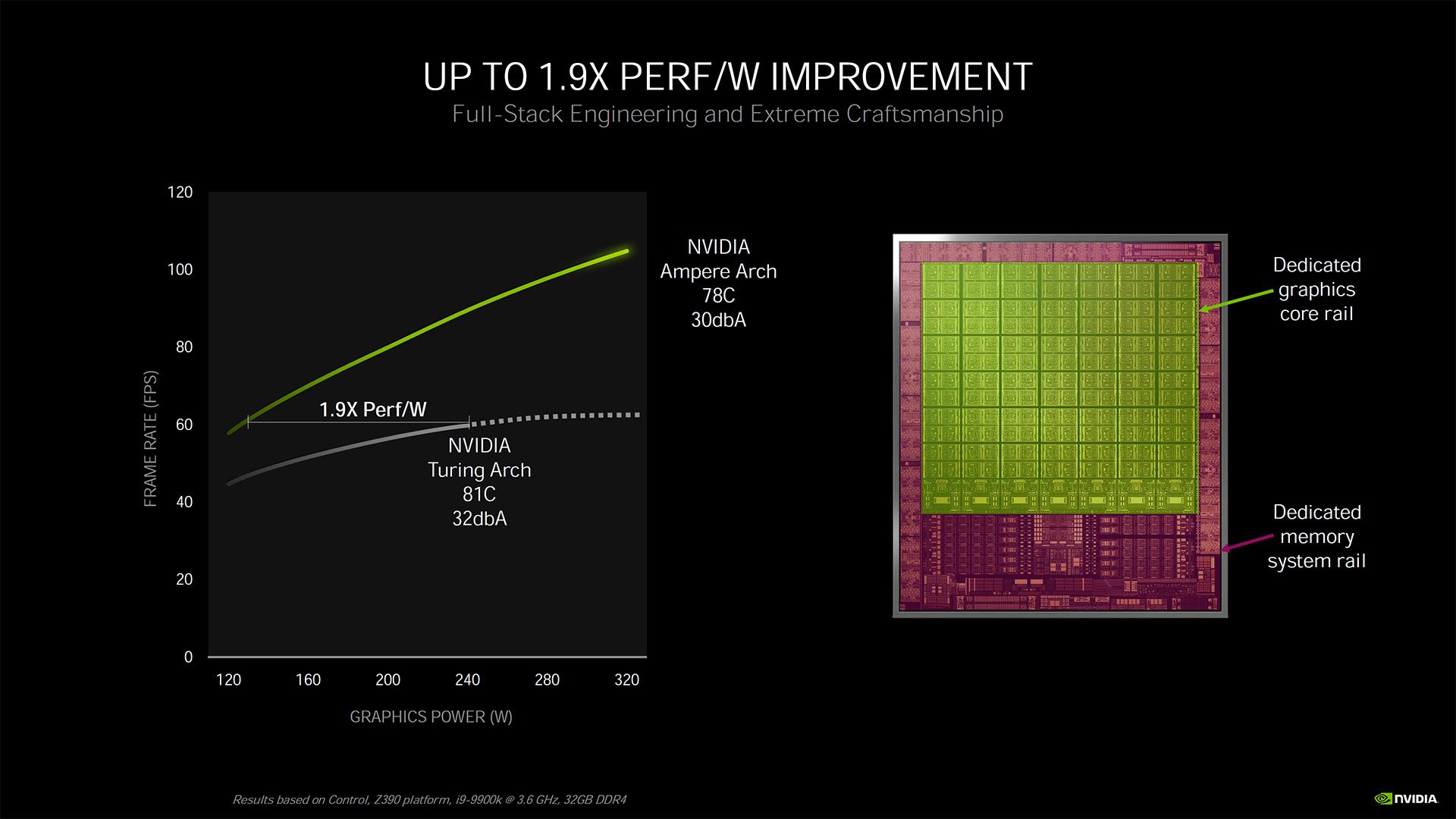

Och, du kannst deine Karte auch auf 150W undervolten und hast dann 200% mehr Perf/W oder du nutzt ne APU und hast dann 500% mehr Perf/W. Nvidia hat sich bei dieser Metrik genauso bekleckert als sie mit dieser Grafik hier aufschlugen:AMD wirbt mit >50% Perf/Watt gegenüber RDNA2...aber wenn die 4090 nur 450W hat und 80% schneller ist als eine 3090, dann kann man locker mit ein wenig Tuning locker +50% oder mehr Performance bei 350W rausholen. Das wäre also mindestens genauso gut wie bei AMD. Komisch nur das es keine Erwähnung findet und alle nur sagen BOAH ist AMD Effizient...

Das klingt für mich nach Geschichten aus dem Paulanergarten... 🍺RDNA3 soll wohl Nahe 4 Ghz takten, was brachial wäre. RDNA2 ist dazu noch deutlich effizienter, wenn man ein FPS Limit stellt.

Das klingt für mich nach Geschichten aus dem Paulanergarten... 🍺

(+ ein Wiesnmoos)

(+ ein Wiesnmoos)Das ist bitter, wahrscheinlich deutlich über UVP gekauft ...Schrecklich, ab morgen ist meine 3090 Altmetall...

Stell sie noch schnell auf E-Bay bevor morgen wieder die 500€ Modelle wie zu 2080Ti-Zeiten kommen.Schrecklich, ab morgen ist meine 3090 Altmetall...

Ist sie das nicht schon seit dem 3090 Ti Launch?Schrecklich, ab morgen ist meine 3090 Altmetall...

Nope, hatte die 3090 Strix OC für noch relativ normale 1700€ erwerben können.Das ist bitter, wahrscheinlich deutlich über UVP gekauft ...